摘要

Abstract

人形机器人技术正在迅速发展,制造商推出了针对特定场景量身定制的多样化异构视觉感知模块。在各种感知范式中,基于占用的表示已被广泛认为特别适合人形机器人,因为它提供了丰富的语义和三维几何信息,这对于全面理解环境至关重要。在这项工作中,我们提出了一种专为人形机器人量身定制的多模态占用感知系统,涵盖完整的硬件和软件堆栈,包括传感器配置、数据采集、数据标注和感知网络。

项目链接:https://humanoid-occupancy.github.io/#

我们的框架采用先进的多模态融合技术来生成基于网格的占用输出,对占用状态和语义标签进行编码,从而为任务规划和导航等下游任务提供整体环境理解。为了应对人形机器人的独特挑战,我们克服了运动学干扰和遮挡等问题,并建立了有效的传感器布局策略。

此外,我们还开发了第一个专门针对人形机器人的全景占用数据集,为该领域的未来研究和开发提供了宝贵的基准和资源。网络架构融合了多模态特征融合和时序信息集成,确保了鲁棒的感知。

总体而言,人形占用为人形机器人提供了有效的环境感知,并为标准化通用视觉模块奠定了技术基础,为人形机器人在复杂的现实场景中的广泛部署铺平了道路。

传感器布局和数据采集

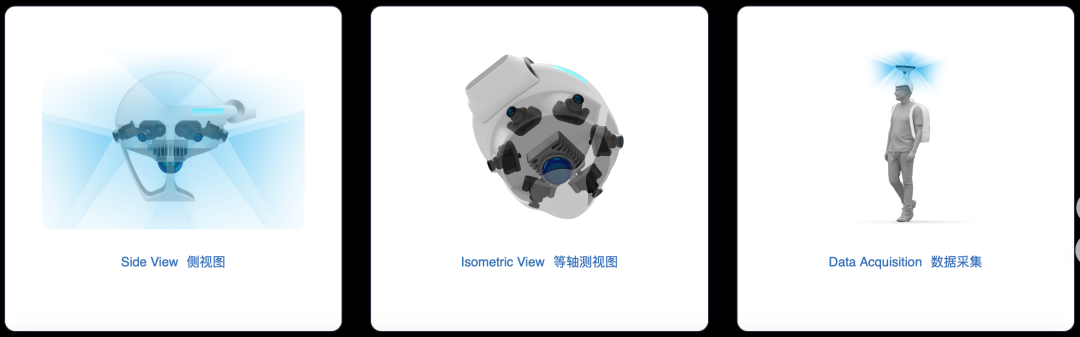

传感器布局:我们的传感器由 6 个摄像头和一个激光雷达组成。 6 个摄像头采用标准 RGB 传感器,前后各布一,两侧各布两。 相机的水平视场角为 118 度,垂直视场角为 92 度。 LiDAR 采用 40 线 360 度全向 LiDAR,垂直视场角为 59 度。

数据采集:我们使用与人形机器人具有相同传感器配置的可穿戴设备来收集数据。身高约 160 厘米的人类数据采集者将其直接戴在头上,以确保传感器的高度与机器人上最终安装的高度相匹配。增加了颈部稳定器,以防止收集时摇头,收集者的行走速度限制在不超过每秒1.2米,转弯角速度不超过每秒0.4弧度。

注释管线

占用生成管道

注释过程分为三个部分:

首先,静态和动态对象是分开处理的。动态对象直接使用边界框进行注释。对于静态对象处理,我们首先去除动态对象的点云,然后将剩余的静态点叠加到多帧点云上,并进行点级语义标注。

最后,将动态和静态场景及其注释进行合并:叠加的静态背景点与逐帧点云的自我坐标系对齐,而动态前景点则根据每帧动态物体的姿态拼接到点云中。该合并的点云直接体素化,无需泊松重建即可获得基本事实。

多模态融合网络

我们的占用感知模型接受多模态输入,包括 LiDAR 点云和 6 个针孔相机图像。我们使用在自动驾驶中得到广泛验证和采用的鸟瞰图(BEV)范式进行特征提取和特征融合。由于机器人传感器在运动过程中会发生俯仰和滚动运动,因此必须将传感器数据转换为重力对齐的以自我为中心的参考系,以符合纯电动汽车的假设。具体来说,我们通过两个模态特定的特征提取分支提取激光雷达和相机特征,然后通过 Transformer Decoder 进行多模态特征融合。最终的占用结果是根据融合的 BEV 特征进行预测的。

实验与结果

对我们收集的数据进行了实验,包括 180 个训练片段和 20 个验证片段。用于评估的指标是 mIoU 和 rayIoU。在自我坐标系中,X 轴和 Y 轴的感知范围设置为[-10m,10m],Z 轴的感知范围设置为[-1.5m,0.9m]。

基准

我们将我们的方法与多模态数据集上的代表性 BEV 感知模型进行基准测试。所有模型都采用相同的训练配置。我们的模型实现了卓越的指标,同时保持了轻量级架构,参数明显减少。

可视化结果

往期文章

全球首篇自动驾驶VLA模型综述重磅发布!麦吉尔&清华&小米团队解析VLA自驾模型的前世今生

字节跳动Seed实验室发布ByteDexter灵巧手:解锁人类级灵巧操作

具身专栏(三)| 具身智能中VLA、VLN、VA中常见训练(training)方法

具身专栏(二)| 具身智能中VLA、VLN分类与发展线梳理

具身专栏(一)| VLA、VA、VLN概述

π0.5:突破视觉语言模型边界,首个实现开放世界泛化的VLA诞生!

斯坦福&英伟达最新论文:CoT-VLA模型凭"视觉思维链"实现复杂任务精准操控

RoboTwin2.0全面开源!多模态大模型驱动的双臂操作Benchmark ,支持代码生成!

开源!Maniskill仿真器上LeRobot的sim2real的RL训练代码开源(附教程)

迈向机器人领域ImageNet,大牛PieterAbbeel领衔北大、通院、斯坦福发布RoboVerse大一统仿真平台

CVPR 北大、清华最新突破:机器人操作新范式,3.3万次仿真模拟构建最大灵巧手数据集

人形机器人四级分类:你的人形机器人到Level 4了吗?(附L1-L4技术全景图)建议收藏!

斯坦福最新论文:使用人类动作的视频数据,摆脱对机器人硬件的需求

爆发在即!养老机器人如何守护2.2亿老人?产业链+政策一览,建议收藏!

![2025年中国消防侦查机器人行业发展背景、市场规模及未来前景展望:市场规模达5.61亿元,智能化装备助力现代消防救援[图]](https://xtechcon-static.oss-cn-chengdu.aliyuncs.com/xtimes/xtimes/images/2025-11-25/69250027c5f64.jpeg)