为什么机器人在执行“按下按钮”这类简单操作时,常常会反复按压、无法判断是否成功?

这是因为机器人操作任务本质上是非马尔可夫的:当前观察并不足以决定接下来该做什么,过去的动作和上下文对未来决策至关重要。

这就导致了现有的视觉-语言-动作(VLA)模型,大多只依赖“当下的一帧观测”,缺乏对时间依赖的建模。这带来了几个显著问题:在长时序任务中表现不佳:

动作前后画面几乎相同,机器人难以自我反馈;

直接堆叠多帧图像又会拖慢推理、偏离预训练性能;

任务执行容易中断,连贯性差。

与此相对,人类操作任务高度依赖记忆系统,凭借情景记忆回溯经验,在操作中不断调取、整合、更新记忆。

本文介绍的由清华大学等团队提出的 MemoryVLA 模型,正在尝试为机器人植入这种“人类式的记忆系统”,让它们也能具备感知-认知联动记忆机制!

从短时反应到长期规划

受人类记忆系统的启发,研究者提出了MemoryVLA——一个融合“认知-记忆-动作”的新型框架。

其核心设计包括:

感知-认知记忆库(Perceptual–Cognitive Memory Bank, PCMB):既存储底层感知细节,也保留高层语义信息;

工作记忆机制:能根据当前任务需求,从记忆中检索关键上下文,并与新的观测自适应融合;

记忆更新与整合:当存储达到容量上限时,自动合并时间相邻、语义相似的条目,实现精炼存储;

记忆驱动的扩散动作专家:利用感知与认知 token 作为条件,生成考虑时间依赖的动作序列。

通过这一机制,MemoryVLA 不再是“短时反应的操作者”,而是具备“带记忆的推理者”。

实验显示,它在模拟环境(Bridge、Fractal、LIBERO)和真实机器人任务(Franka、WidowX)上均取得显著提升,尤其在长时序任务上,相比现有方法提升超过+26个点。

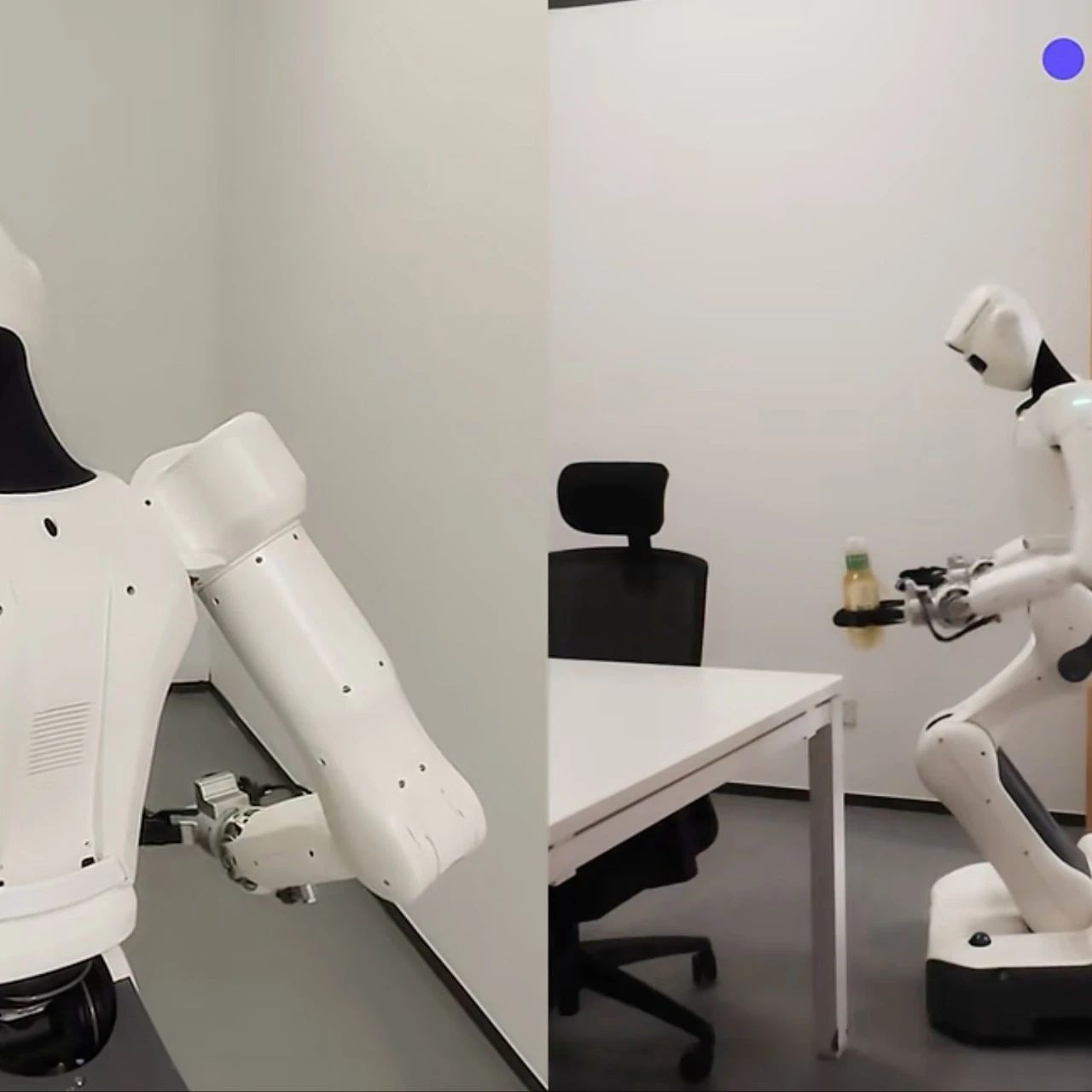

▲图1|机器人记忆的场景示例及本文研究动机:(a) 在推按钮(Push Buttons)任务中,按下前后的状态几乎完全相同,因此需要进行时间序列建模。(b) 人类在操作任务中依赖双重记忆系统:工作记忆(神经活动)负责短期控制,而情景记忆(海马体)则保留长期经验。(c) 受此启发,MemoryVLA 引入了一个“感知–认知记忆库”(Perceptual–Cognitive Memory Bank),用于整合低层次的感知细节与高层次的语义信息,从而实现对时间变化敏感的决策。(d) MemoryVLA 在性能上优于当前的多种先进基线方法©️【深蓝具身智能】编译

接下来,我们将解读 MemoryVLA 的核心方法设计:它是如何将记忆机制引入 VLA 模型、如何构建 PCMB,以及如何实现记忆驱动的动作生成。

MemoryVLA 的核心机制

总体框架

MemoryVLA 是一个端到端的机器人操作框架,它把视觉-语言-动作推理和记忆机制结合在一起(见图2)。

▲图2|MemoryVLA 的整体架构:RGB 观测图像和语言指令首先通过一个 7B 规模的视觉语言模型(VLM)编码为感知(perceptual)和认知(cognitive)两类 token,构成短期工作记忆(working memory)。工作记忆随后查询感知–认知记忆库(Perceptual-Cognitive Memory Bank,PCMB),从中检索与当前任务相关的历史上下文信息,包括高层语义和低层视觉细节。系统将检索到的历史信息与当前 token 自适应融合,并通过合并最相似的邻居样本不断更新和巩固 PCMB。最后,增强后的记忆驱动 token 用于条件化扩散式 Transformer(diffusion transformer),预测未来一系列动作序列©️【深蓝具身智能】编译

输入:当前的 RGB 图像和自然语言指令;

输出:未来一段时间的机器人动作序列(7 自由度:三维平移、三维旋转和抓取开关)。

流程:

(1)视觉-语言模块将图像和指令转化为感知 token(细节特征)和认知 token(高层语义);

(2)这些 token 构成工作记忆,类似人脑短期记忆;

(3)工作记忆会去感知-认知记忆库(PCMB) 检索历史上下文,再通过门控机制与当前信息融合;

(4)记忆库在容量过大时,会合并相邻且相似的条目,实现“记忆压缩”;

(5)最终,增强后的记忆表示被送入扩散式动作专家,生成长时序的动作轨迹。

视觉-语言认知模块

视觉编码:采用 DINOv2 和 SigLIP 两个并行骨干网络提取视觉特征,并经过压缩模块(SE-bottleneck)得到 256 个紧凑的感知 token。

语言整合:把原始视觉特征投射到语言空间,与文本指令拼接后送入 LLaMA-7B,大模型在句尾位置输出一个认知 token,作为高层语义总结。

结果:得到一组感知 token(p)和一个认知 token(c),共同构成当前的工作记忆

感知-认知记忆模块(PCMB)

单靠工作记忆只能反映“当前时刻”,缺乏时间连续性。

PCMB 的作用就是保留和管理长时序信息(见图3)。

▲图3|记忆模块的细节:(a) 检索(Retrieval):当前的感知(perceptual)和认知(cognitive)token 通过带有时间步位置编码(timestep positional encoding)的交叉注意力(cross-attention)机制,向感知–认知记忆库(PCMB)查询,以获取相关的历史特征。(b) 门控融合(Gate fusion):利用门控机制(gate mechanism),自适应地将当前 token 与检索到的历史 token 进行融合。(c) 巩固(Consolidation):融合后的 token 会被更新到 PCMB 中。当 PCMB 达到存储上限时,系统会计算相邻条目的相似度,并合并最相似的一对,以保持记忆库的紧凑性©️【深蓝具身智能】编译

(a)记忆检索

① 工作记忆会作为查询,去 PCMB 中取出历史的感知与认知条目;

② 每个存储条目都带有时间位置编码,用来保持顺序感;

③ 检索过程通过注意力机制完成,相当于“从记忆中翻找最相关的片段”。

(b)门控融合

① 当前 token 和检索到的历史 token 会通过门控机制(类似加权开关)融合;

② 模型会自动学习在什么情况下更依赖历史信息,什么情况下更多使用当下观测。

(c)记忆整合

① 当记忆条目数超过容量 L 时,模型会计算相邻条目的相似度;

② 找到最相似的一对并合并为一个平均表示;

③ 这样能去掉冗余,既保证信息完整,又维持存储紧凑。

最终得到的增强表示(感知 + 认知)既保留了过去的语义,也记录了细节。

记忆驱动的动作专家

有了增强记忆后,下一步是生成机器人动作。

模型形式:采用基于扩散的 Transformer(DiT),并用 DDIM 加速采样;

输出形式:预测 16 步未来动作轨迹,每步包含 7 自由度控制量;

过程细节:

(1)在每个去噪步骤中,动作 token 会结合认知 token(高层指导)和感知 token(细节补充);

(2)认知注意力层保证动作符合整体任务逻辑,感知注意力层补充局部环境细节;

(3)经过多步迭代去噪,得到平滑且精确的动作序列。

训练目标:用均方误差(MSE)损失约束预测动作与真实动作序列一

小结

MemoryVLA 的方法创新在于:引入了类人记忆机制。PCMB 像是“机器人版海马体”,不仅存储历史,还会检索、融合和压缩。结合扩散式动作专家,模型能在长时序任务中保持上下文一致性,避免遗忘或重复。

MemoryVLA 的验证

研究团队围绕五个核心问题展开实验:

1. 与现有最强方法相比,MemoryVLA 在SimplerEnv表现如何?

2. 在 LIBERO 这一更复杂的任务基准上,它能否保持优势?

3. 在真实机器人上,它是否既能胜任常规任务,又能处理长时序任务?

4. 记忆模块的各个组件分别带来多大提升?

5. 在多样化环境中,它是否具备鲁棒性与泛化能力?

实验覆盖 3 种机器人、10套任务基准、150+任务、500+变体,既有仿真环境,也有真实操作。

▲图4|实验设置概览:上半部分:在三个仿真基准环境中进行评估,分别是 SimpleEnv-Bridge(搭配 WidowX 机械臂)、SIMPLER-Fractal(搭配 Google Robot),以及 LIBERO(搭配 Franka 机械臂)。下半部分:在两个真实环境套件中进行评估,分别是 General 和 Long-horizon Temporal。总体来看,实验共覆盖 3 种机器人、10 个任务套件,涉及 150+ 项任务与 500+ 种变体©️【深蓝具身智能】编译

SimplerEnv:桥接与分形任务

Bridge 套件:MemoryVLA 成功率71.9%,相比 CogACT 提升+14.6 个点,全面超越 π0。

▲图5|在 SimplerEnv-Bridge环境中,使用 WidowX和Google机械臂的性能对比结果©️【深蓝具身智能】编译

Fractal 套件:在视觉匹配 (VM) 和视觉扰动 (VA) 两种场景下,MemoryVLA 平均成功率72.7%,比 CogACT 高+4.6 个点。

(1)VM 场景下(环境贴近现实),在“开关抽屉”任务上,成功率84.7%,提升+12.9。

(2)VA 场景下(背景、光照、干扰物不断变化),提升更显著:“开关抽屉”+24.9,“放入抽屉”+11.7。

▲图6|在 Fractal环境中,使用 WidowX和Google机械臂的性能对比结果©️【深蓝具身智能】编译

通过实验可得:MemoryVLA 的记忆机制不仅提升了整体成功率,还显著增强了鲁棒性。

LIBERO:跨套件的通用操作

在 LIBERO 基准上,MemoryVLA 覆盖Franka 机械臂的五大套件:Spatial、Object、Goal、Long、LIBERO-90。

总体成功率96.5%,比 CogACT 高+3.3 个点;

各分套件表现均超过 93%,其中Spatial和Object 达到 98.4%。

▲图7|在LIBERO环境中,使用 Franka机械臂的性能对比结果©️【深蓝具身智能】编译

值得注意的是,MemoryVLA 仅依赖第三人称 RGB 图像,没有用到手腕相机或机器人本体状态,却依旧领先。

这表明 MemoryVLA 对感知输入要求更低,却能保持极高性能。

真实机器人实验

在Franka和 WidowX上进行了12个任务:6 个常规操作,6 个长时序操作。

常规任务:平均成功率 85%,比 CogACT 提升+9;在“煎蛋”任务上提升+13,在“放蛋进烤箱”任务上提升+20。

长时序任务:平均成功率83%,比 CogACT 提升+26。典型任务包括:

① 顺序按按钮:提升+43

② 换食材:提升+38

③ 猜藏物位置:提升+32

④ 清理餐桌并计数:提升+17

▲图8|在真实世界实验中,使用 Franka 和 WidowX 机器人进行的性能对比结果©️【深蓝具身智能】编译

从这个实验可以看出:在需要持续记忆和上下文推理的任务上,MemoryVLA 的优势最为突出。

消融实验:记忆设计的作用

单独记忆类型:只有感知记忆→64.6%;只有认知记忆→63.5%;两者结合→71.9%。

记忆长度:16 步最优(71.9%),太短或太长都下降。

模块功能:

① 加入时间编码:69.8%→71.9%

② 简单相加融合 vs 门控融合:67.7%→71.9%

③ 先进的合并策略 vs FIFO:66.7%→71.9%

▲图9|左图:对于记忆类型类型和长度的消融;右图:对于模块功能的消融©️【深蓝具身智能】编译

通过消融实验可知:每个记忆机制(检索、融合、整合)都对性能有关键贡献。

总结

MemoryVLA 的价值在于,它真正把“记忆”引入了 VLA 模型,让机器人不再是“短时反应的操作者”,而是能像人类一样记住过去、理解现在、规划未来。

在实验中,它已经展现出跨环境、跨任务的强大泛化能力,尤其是在长时序任务上实现了质的飞跃。

未来,如果机器人能不断积累经验,把“常见套路”沉淀到长期记忆中,那它就可能像人类一样,越用越聪明。所以你觉得,当机器人真的拥有记忆,它会不会不仅仅成为一个帮助人类的工具,而是拥有许多共同回忆的“赛博伙伴”?

Ref:

论文题目:MEMORYVLA: PERCEPTUAL-COGNITIVE MEMORY IN VISION-LANGUAGE-ACTION MODELS FOR ROBOTIC MANIPULATION

论文地址:hhttps://arxiv.org/pdf/2508.19236

论文作者:Hao Shi, Bin Xie, Yingfei Liu, Lin Sun, Fengrong Liu, Tiancai Wang, Erjin Zhou, Haoqiang Fan, Xiangyu Zhang, Gao Huang

编辑|阿豹

审编|具身君

工作投稿|商务合作|转载

:SL13126828869(微信号)

>>>第三届自主机器人技术研讨会早鸟报名中<<<

ABOUT US|关于ARTS

为促进自主机器人领域一线青年学者和工程师的交流,推动学术界与企业界的深度交融与产学研合作,中国自动化学会主办了自主机器人技术研讨会(Autonomous Robotic Technology Seminar,简称ARTS)。

基于前两届大会的成功经验和广泛影响,第三届ARTS将继续深化技术交流与创新,定于2025年10月18日-19日在浙江大学(杭州)举办。我们诚挚邀请您参加,并欢迎您对大会组织提供宝贵意见和建议!

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

工作投稿|商务合作|转载:SL13126828869(微信号)

点击❤收藏并推荐本文