该论文的第一作者和通讯作者均来自北京大学王选计算机研究所,第一作者为博士生徐铸,通讯作者为博士生导师刘洋。团队近年来在 TPAMI、IJCV、CVPR、ICML 等顶会上有多项代表性成果发表,多次荣获国内外多模态理解预生成竞赛冠军,和国内外知名高校、科研机构广泛开展合作。

本文主要介绍来自该团队的最新论文:TRKT: Weakly Supervised Dynamic Scene Graph Generation with Temporal-enhanced Relation-aware Knowledge Transferring。该任务针对弱监督动态场景图任务展开研究,发现目前的性能瓶颈在场景中目标检测的质量,因为外部预训练的目标检测器在需要考虑关系信息和时序上下文的场景图视频数据上检测结果欠佳。

本文针对该问题提出了一种时序增强关系敏感知识迁移的方法,通过获取关系和时序信息感知的注意力图来优化外部目标检测器的检测结果,从而提升在场景图数据上目标检测质量,进而提升最终的生成场景图效果。

目前该研究已被 ICCV 2025 正式接收,相关代码与模型已全部开源。

论文标题:TRKT: Weakly Supervised Dynamic Scene Graph Generation with Temporal-enhanced Relation-aware Knowledge Transferring

论文链接:https://arxiv.org/abs/2508.04943

代码链接:https://github.com/XZPKU/TRKT.git

项目主页:https://sites.google.com/view/trkt-official

动态场景图生成任务旨在通过检测物体并预测它们之间的关系,为视频的每一帧生成对应场景图。 弱监督动态场景图生成要求模型在训练阶段只使用来自视频单帧的无物体位置信息的场景图标签作为监督进行训练,从而减少标注工作量。现有的弱监督动态场景图生成方法依赖于预训练的外部目标检测器生成物体标签,进而构造伪场景图标签用于后续场景图生成模型的训练。

然而,在动态、关系感知的动态场景图生成场景中,训练于静态、以物体为中心图像上的目标检测器可能出现物体定位不准确以及对部分物体置信度过低,从而导致物体漏检的问题。本文通过分析目标检测结果和关系预测结果对最终场景图质量的影响(如下图 1 所示),可以发现目标检测质量是目前弱监督动态场景图生成任务的主要瓶颈。

图 1:使用不同目标检测结果和关系预测结果的动态场景图性能对比

针对上述问题,该论文提出了一种时序增强且关系敏感的知识迁移方法 TRKT,该方法能够有效增强在关系感知的动态场景中的目标检测性能。

具体来讲,TRKT 首先通过物体和关系类别解码器生成类别特定的注意力图,以突出物体区域和交互区域,从而使注意力图具备关系感知能力,同时利用邻近帧和光流信息对注意力图进行时序增强,使它们具备运动感知能力,并对运动模糊具有较强的鲁棒性。进一步,TRKT 还设计了一个双流融合模块,综合利用类别特定的注意力图与外部检测结果,提升物体定位精度和部分物体的置信度分数。实验表明,TRKT 通过提升目标检测性能为弱监督动态场景图生成的训练提供了更准确和更高质量的伪标签,进而提升最终动态场景图的生成质量。

一、方法介绍

图 2:基于时序增强关系敏感知识迁移的弱监督动态场景图生成方法框架图

本文方法如图 2 所示,它主要由两个设计组成:关系敏感的知识挖掘(Relation-aware Knowledge Mining)和双流融合模块(Dual-stream Fusion Module)。在关系敏感的知识挖掘中,我们利用图像编码器将每帧输入图像处理成若干块,然后分别通过物体和关系类别解码器对这些块进行解码,生成注意力图,用于高亮物体及其交互关系的相关区域。编码器和解码器仅通过图像的物体和关系类别标签进行监督。这些注意力图包含物体语义和潜在的关系上下文,从而增强了模型在数据中识别和理解复杂关系的能力。进一步地,跨帧的光流被用来提供时序信息以进一步增强注意力图。通过这些方法,我们获得既具备关系感知又具备运动感知的注意力图,包含时序增强和关系敏感的知识。在双流融合模块中,我们设计了并行的定位优化模块(Localization Refinement Module,LRM)和置信度提升模块(Confidence Boosting Module,CBM)用于最大化注意力图在增强外部检测结果中的效果。LRM 通过利用注意力图来定位物体区域,从而提供外部检测的边界框坐标的准确度;CBM 则增强由类别解码器识别的物体类别的置信度分数。关系敏感的知识挖掘和双流融合模块有效地减轻了外部检测结果中存在的偏差,最终产生了更可靠的物体检测结果。最后我们使用和基线模型相同的方法,将检测结果组织为场景图伪标签,以全监督的方式训练动态场景图检测模型。

关系敏感的知识挖掘

在关系敏感的知识挖掘中,我们使用无物体位置信息的场景图标注训练物体和关系类别解码器,分别生成关注物体的类别敏感注意力图  和关注关系区域的注意力图

和关注关系区域的注意力图  ,并利用邻近帧和光流信息创建当前帧的伪注意力图

,并利用邻近帧和光流信息创建当前帧的伪注意力图  ,以缓解潜在的模糊和遮挡问题,增强注意力图的运动感知能力。我们首先将输入图像

,以缓解潜在的模糊和遮挡问题,增强注意力图的运动感知能力。我们首先将输入图像 编码为图像块特征

编码为图像块特征 ,其中 N 是图像块的数量,D 是特征维度。为了关注与每个物体类别高度相关的特定区域,我们为物体类别编码器配备物体查询

,其中 N 是图像块的数量,D 是特征维度。为了关注与每个物体类别高度相关的特定区域,我们为物体类别编码器配备物体查询 ,其中 Cobj是物体类别的数量,并在关系类别解码器中提供关系查询

,其中 Cobj是物体类别的数量,并在关系类别解码器中提供关系查询 ,用于关注包含关系信息的区域,其中 Crel 是关系类别的数量。然后,对于每个类别解码器中的注意力层,我们将注意力计算公式表示为:

,用于关注包含关系信息的区域,其中 Crel 是关系类别的数量。然后,对于每个类别解码器中的注意力层,我们将注意力计算公式表示为:

其中 tgt 可以是物体(obj)或关系(rel),CA 表示交叉注意力层, 表示拼接后的特征,

表示拼接后的特征, 分别是查询、键和值的投影层,

分别是查询、键和值的投影层, 表示注意力矩阵。

表示注意力矩阵。 用于定位特定类别的视觉线索,我们通过切片和重塑操作从

用于定位特定类别的视觉线索,我们通过切片和重塑操作从  推导出

推导出  ,其中 N=h×w,表示物体和关系标记与图像块特征之间的注意力。为了生成更准确的类别敏感注意力图,我们将注意力图

,其中 N=h×w,表示物体和关系标记与图像块特征之间的注意力。为了生成更准确的类别敏感注意力图,我们将注意力图  和

和  通过如下相似度的计算融合成类别敏感的注意力图,

通过如下相似度的计算融合成类别敏感的注意力图,

其中, ,

, ,而 norm 表示归一化操作。

,而 norm 表示归一化操作。

为了进一步应对视频中可能出现的运动模糊和遮挡问题,并使注意力图具备运动感知能力,我们提出帧间注意力增强策略,采用跨帧光流信息作为时序线索。对于视频序列 V 中的每一帧  ,我们采用邻近帧

,我们采用邻近帧  提供额外信息,以补救因 Ii 中的模糊和遮挡所导致的物体误检和漏检。具体而言,我们采用 RAFT [2] 来获得帧间光流

提供额外信息,以补救因 Ii 中的模糊和遮挡所导致的物体误检和漏检。具体而言,我们采用 RAFT [2] 来获得帧间光流  ,并使用相同的关系敏感的知识挖掘过程为

,并使用相同的关系敏感的知识挖掘过程为  获取类别感知的注意力图

获取类别感知的注意力图  。然后,我们根据光流场

。然后,我们根据光流场  对

对  进行变形,生成第 i 帧的伪注意力图

进行变形,生成第 i 帧的伪注意力图  ,包含关于动态物体的时序线索。

,包含关于动态物体的时序线索。

双流融合模块

双流融合模块(DFM)用于结合时序感知且关系敏感的知识,来提升外部检测器的结果质量。DFM 包含了定位修正模块和置信度提升模块。

图 3:定位修正模块示意图

定位修正过程如图 3 所示,外部检测结果和来自类别感知注意力图的物体候选被用来获取修正后的检测结果(即图 3 右下角的绿色框)。为了修正外部检测结果 De,我们利用类别感知注意力图  ,用基于阈值的算法 f (⋅) 获取内部物体候选

,用基于阈值的算法 f (⋅) 获取内部物体候选  ,其中

,其中  是检测到的边界框,

是检测到的边界框, 是置信度分数,通过对应注意力图内 bi 的平均注意力得分计算,

是置信度分数,通过对应注意力图内 bi 的平均注意力得分计算, 是物体的类别,n 表示检测到的物体数量。然后,我们将 Da 与 De 结合,通过加权框融合融合算法 F (⋅) 获取更精确的物体边界框。融合过程表示如下:

是物体的类别,n 表示检测到的物体数量。然后,我们将 Da 与 De 结合,通过加权框融合融合算法 F (⋅) 获取更精确的物体边界框。融合过程表示如下:

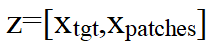

图 4:置信度提升模块示意图

另一方面,某些边界框中可能存在低置信度的问题,可能会导致物体漏检。因此我们提出了置信度提升模块(CBM)来补充潜在漏检的物体。如图 4 所示,我们以物体分类 logits 作为标准选择具有高概率的物体类别,将其注意力  与外部检测注意力图 Aext 结合,并进行归一化操作,生成增强的类别 ci 的注意力图,得到改进的物体检测结果 D2,从而缓解可能的漏检问题:

与外部检测注意力图 Aext 结合,并进行归一化操作,生成增强的类别 ci 的注意力图,得到改进的物体检测结果 D2,从而缓解可能的漏检问题:

接着,我们将物体检测结果 D1 和 D2 融合,得到修正后的物体检测结果 D=F (D1,D2) 同时提升了检测精度和置信度分数。此外,为了赋予检测结果时序线索并缓解模糊和遮挡问题,我们在 D 上通过伪注意力图  , 重复上述操作,最终获得进一步修正后的检测结果 D′。该结果用于依照基线模型 PLA 中的方法获取伪场景图标签,并以全监督的方式训练动态场景图检测模型。

, 重复上述操作,最终获得进一步修正后的检测结果 D′。该结果用于依照基线模型 PLA 中的方法获取伪场景图标签,并以全监督的方式训练动态场景图检测模型。

二、实验结果

①对比方法

我们对比了两大类方法,第一类是已有最优的弱监督动态场景图生成方法,包括 PLA [1] 和 NL-VSGG;第二类是擅长关系理解的视觉语言模型,包括 RLIP 和 RLIPv2 [4]。

②评价指标

评价指标分为两部分,第一部分是测评方法在 DSGG 数据中的目标检测性能,指标为 Average Precision (AP) 和 Average Recall (AR);第二部分是测评方法在动态场景图生成任务上的性能,我们通过场景图检测(SGDET)任务进行评估。SGDET 旨在检测物体对并预测它们之间的关系,并以 Recall@K 为指标进行评估。

③与现有方法的对比及分析

表 1:与基线模型在 Action Genome [3] 数据集上目标检测性能对比实验结果

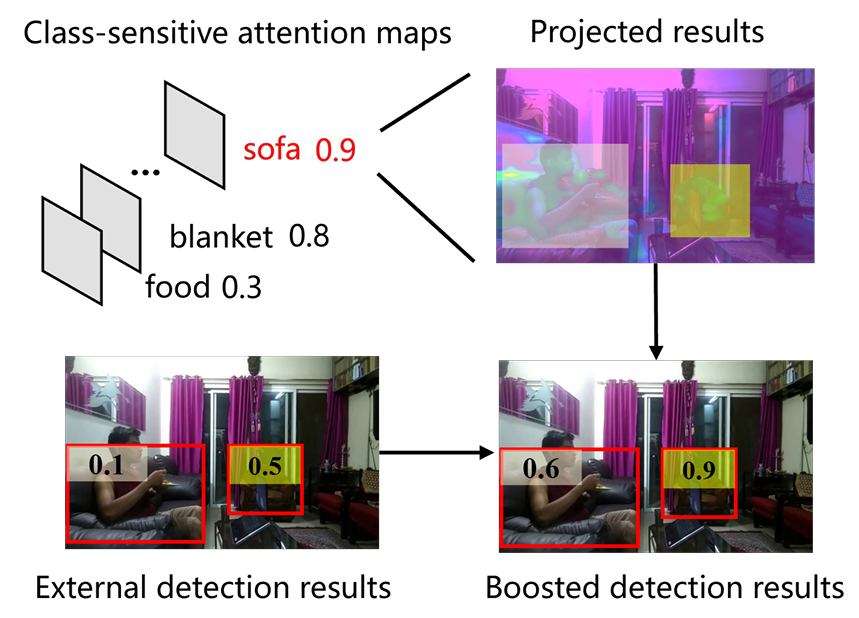

表 2:与对比方法在 Action Genome [3] 数据集上动态场景图生成性能对比实验结果

我们首先对比了目标检测的性能,结果如表 1 所示。我们提出的方法在 Average Precision 和 Average Recall 上分别提高了 13.0%/1.3%,验证了我们的方法能够有效提升动态和需要关系理解场景下的目标检测性能。

对于弱监督动态场景图生成任务,性能对比如表 2 所示。和我们的基线模型 PLA 相比,结果显示,我们在所有评估指标上都取得了性能提升(1.72%/2.42%),这表明,通过改进物体检测结果,生成的伪场景图标签质量得到了提高,从而在最终的 DSGG 性能上获得了性能提升。此外,我们还与 NL-VSGG 进行了比较,NL-VSGG 使用视频字幕来构建伪场景图进行模型训练,也使用外部物体检测器进行物体检测,但由于相同的物体检测质量问题,其 DSGG 性能低于我们的方法。我们还与 RLIP 和 RLIPv2 进行了比较,它们以零样本方式进行场景图预测,将每一帧视为静态图像。然而,它们的性能较差,进一步说明了时序和动态信息和时序增强且关系敏感的知识对于动态场景图任务的必要性。

④消融实验

表 3:不同模块的消融实验结果

为了验证本文所提出的各个模块的有效性,本文进行了消融实验。CBM, LRM 和 IAA 分别代表置信度提升模块,定位修正模块以及帧间注意力增强策略,消融结果如表 3 所示。我们可以得出以下结论:(1)分别采用 CBM 和 LRM 作为知识迁移策略,分别带来了 1.2% 和 2.0% 的平均精度提升,进而在 SGDET 任务上获得了性能提升,这表明物体检测质量在边界框置信度分数和定位精度方面得到了改善。(2)通过结合 CBM 和 LRM,物体检测的 AP 平均提升了 2.8%,在有约束 / 无约束场景下,DSGG 任务的表现分别提升了 1.48%/1.94%。这表明,边界框精度的提升和置信度分数的增强可以相互补充,生成质量更高的物体检测结果,从而带来更大的性能提升。(3)融入 IAA 策略后,物体检测性能进一步提升,AP 提升了 8.9%/10.6%,表明 IAA 有效缓解了模糊和遮挡问题,生成了更好的检测结果,从而进一步提升了最终场景图生成的表现。

⑤可视化结果

图 5:动态场景图生成结果可视化

如图 5 所示,我们给出了和基线模型 PLA [1] 生成动态场景图效果的对比,得益于我们引入的时序增强关系敏感的知识和我们设计的双流融合模块,我们的方法能够得到更完整的场景图,并且其中人和物体的定位更加准确,从而使得得到的场景图质量更高。

更多研究细节,可参考原论文。

参考文献

[1] Siqi Chen, Jun Xiao, and Long Chen. Video scene graph generation from single-frame weak supervision. In The Eleventh International Conference on Learning Representations,2023.

[2] Zachary Teed and Jia Deng. Raft: Recurrent all-pairs field transforms for optical flow, 2020.

[3] Jingwei Ji, Ranjay Krishna, Li Fei-Fei, and Juan Carlos Niebles. Action genome: Actions as compositions of spatio temporal scene graphs. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 10236–10247, 2020.

[4] Hangjie Yuan, Shiwei Zhang, Xiang Wang, Samuel Albanie, Yining Pan, Tao Feng, Jianwen Jiang, Dong Ni, Yingya Zhang, and Deli Zhao. Rlipv2: Fast scaling of relational language-image pre-training, 2023.

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com