高带宽存储器(HBM)再次成为人们关注的焦点。在加州圣何塞举办的GTC 2025大会上,SK海力士展示了用于人工智能(AI)服务器的12层(12Hi)HBM3E器件。这家韩国存储器制造商还展示了其目前正在开发的12Hi HBM4模型,并声称目前正在完成2025年下半年大规模生产的准备工作。

另一家领先的存储器供应商美光科技(Micron)表示,其HBM芯片在AI和高性能计算(HPC)应用领域需求强劲。美光公司首席商务官Sumit Sadana向路透社表示,美光公司2025年的所有HBM芯片都已售罄。

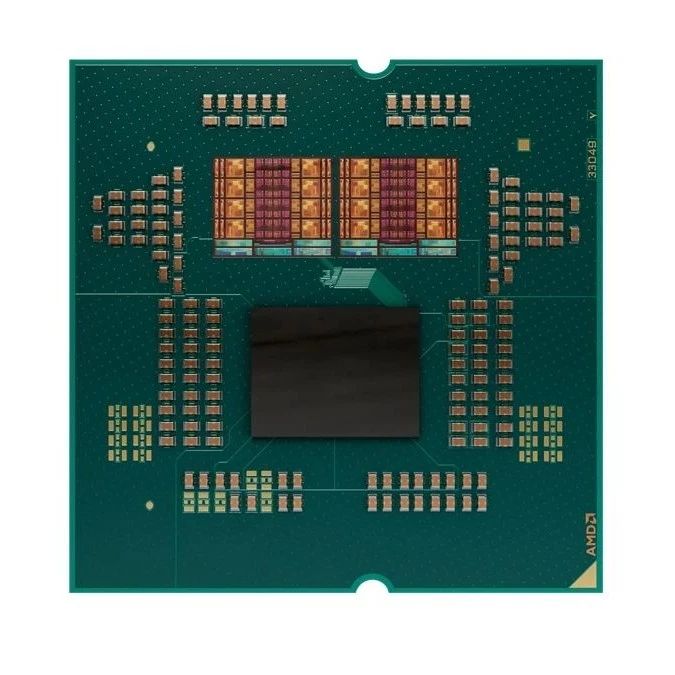

图1:HBM在缓存和主内存之间创建了一个新的“近内存”空间。(来源:IDTechEx)

HBM本质上是一种将多个DRAM裸片垂直堆叠在逻辑裸片上的3D结构,它依赖于硅通孔(TSV)等先进封装技术,同时使用硅中介层与处理器互连。事实证明,它非常适合HPC和AI工作负载等并行计算环境。

这是因为HBM可以同时处理来自GPU和AI加速器中不同内核的多个内存请求,从而促进并行工作负载处理。实际上,HBM已成为克服数据密集型HPC和AI工作负载中内存瓶颈的主要手段。否则,这些内存瓶颈会导致AI处理器利用率不足。

HBM器件的另一个关键优势在于其持续发展,以提升AI加速器的性能。例如,当前一代HBM3E器件采用热压技术,并结合微凸点和底部填充工艺来堆叠DRAM裸片。接下来,美光、三星和SK海力士等HBM制造商正向HBM4器件转型,该器件采用铜铜混合键合等先进封装技术,以提高I/O口数量、降低功耗、改善散热并减小电极尺寸。

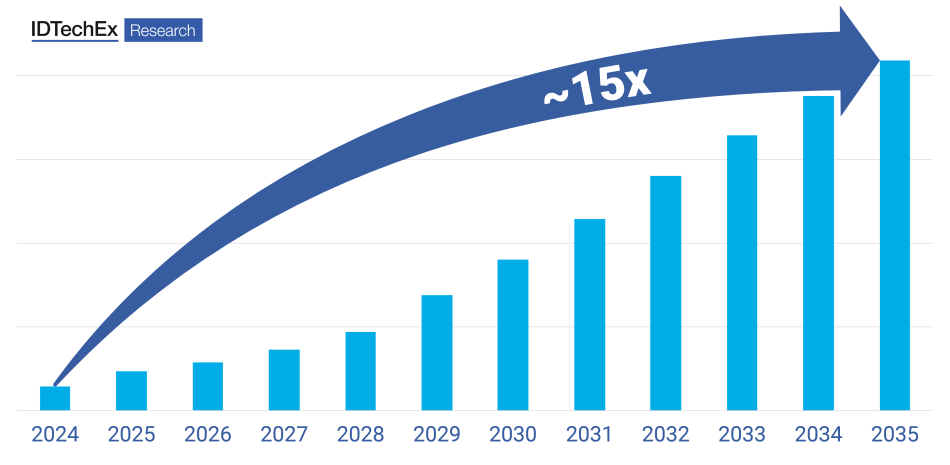

市场研究公司IDTechEx的报告“Hardware for HPC, Data Centers, and AI 2025-2035: Technologies, Markets, Forecasts”(2025-2035年HPC、数据中心和AI硬件:技术、市场与预测)评估了服务于AI和HPC工作负载的HBM器件的关键发展和趋势。报告还预测,到2035年时,与2024年相比,HBM的单位销量预计将增长15倍。

图2:蓬勃发展的AI和HPC硬件预计到2035年将使HBM销量增长15倍。(来源:IDTechEx)

HBM凭借其突破AI处理器内存瓶颈的能力,成为2024年的一大技术亮点。随着HBM4内存器件的出现,这一趋势很可能在2025年及以后持续下去。

THE END

2025-09-01

2025-08-30

2025-08-29

2025-08-29

2025-08-28