·聚焦:人工智能、芯片等行业

欢迎各位客官关注、转发

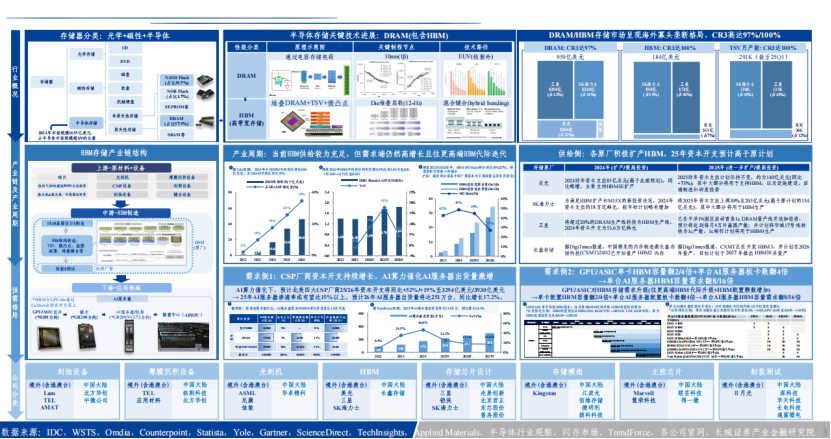

据Trendforce数据,2024年整体HBM消耗量达6.47B Gb、年增237.2%,其中NVIDIA、AMD的GPU分别占消耗量的62%、9%,其他业者(主要为CSP(云服务提供商)的ASIC所需)占29%,分产品看HBM2e、HBM3、HBM3e贡献的消耗量成三足鼎立,尤以HBM3e 8hi 及HBM2e 8hi最多。

2025年预估整体HBM消耗量将达16.97B Gb、年增162.2%,较上季预估的16.40B Gb小幅上修,因NVIDIA及AWS的AI芯片出货预估上修,其中NVIDIA、AMD、Google、AWS、其他业者分别占消耗量的70%、7%、10%、8%、5%,分产品而言HBM3e为消耗量大宗,尤以HBM3e 12hi最多。

定制AI芯片需求的激增正在重塑竞争格局,预计26年以Google TPU为代表的ASIC HBM位元需求量将大幅增长,测算同比增速或有望超50%。专用ASIC(专为运行特定AI模型而设计)已被证明比Nvidia或AMD日益昂贵的GPU更具成本效益和能效,包括亚马逊、谷歌和Meta在内的科技巨头纷纷加速自研专用ASIC。

HBM对于处理AI工作负载中的高速数据至关重要,随着ASIC的普及,对HBM的需求也日益增长:据2025年6月美光业绩发布会上提到,“ASIC平台”公司与英伟达和AMD并列为其HBM大批量出货的四大客户。

亚马逊、谷歌等企业自研ASIC平台正成为HBM采购新主力。随着全球科技企业掀起ASIC自研热潮,考虑到北美四大CSP(云服务提供商)均有ASIC规划且25/26年预期资本开支合计分别同比+52%/+19%,预计26年以Google TPU为代表的ASIC HBM位元需求量将大幅增长,测算同比增速或有望超50%。

国内HBM产业处于起步阶段,与国际巨头相比仍有差距,但部分企业(如长鑫存储等)已取得一定进展。

长鑫存储:据韩媒Financial News披露,长鑫存储计划于2025年底交付HBM3样品,2026年全面量产,并剑指2027年攻克HBM3E技术。

武汉新芯:发布《高带宽存储芯粒先进封装技术研发和产线建设》招标项目,将利用三维集成多晶圆堆叠技术,打造更高容量、更大带宽、更小功耗和更高生产效率的国产高带宽存储器(HBM)产品。

以下是《深度剖析HBM千亿蓝海,AI算力激战下供需新格局》报告部分内容:

公众号后台回复《深度剖析HBM千亿蓝海,AI算力激战下供需新格局》,即可获得完整报告。

本公众号所刊发稿件及图片来源于网络,仅用于交流使用,如有侵权请联系回复,我们收到信息后会在24小时内处理。

推荐阅读:

商务合作请加微信勾搭:

18948782064

请务必注明:

「姓名 + 公司 + 合作需求」