题目:Dynamic Clustering Convolutional Neural Network

论文地址:https://ojs.aaai.org/index.php/AAAI/article/view/34030

代码地址:https://github.com/ltzovo/DCCNeXt

创新点

与传统CNN中基于局部窗口的卷积操作不同,DCCNeXt采用全局聚类的方式,将图像块根据语义相似性动态聚类成多个簇,然后对每个簇使用共享的卷积核进行卷积。这种设计打破了局部卷积的限制,能够捕捉图像中更长距离的依赖关系,使模型在处理具有复杂全局结构的图像时更具优势。

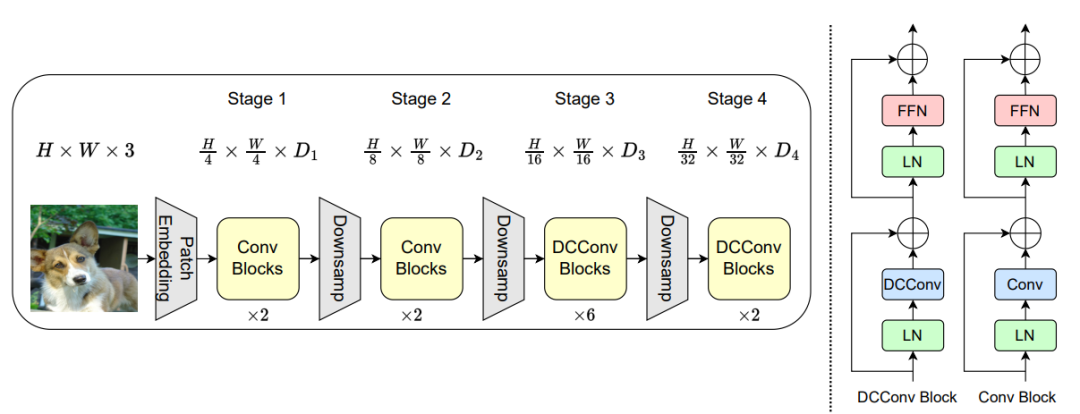

DCCNeXt的网络架构包含四个阶段,前两个阶段使用7×7深度可分离卷积提取局部特征,后两个阶段则利用动态聚类卷积提取全局重要特征。这种分阶段的设计充分利用了局部和全局信息,使模型在不同层次上都能有效捕捉到图像的特征,为后续的视觉任务提供了更丰富的特征表示。

针对全局聚类计算复杂度高的问题,提出从每个图像块的子空间中提取特征向量来进行聚类,有效降低了计算成本,使得模型能够适用于高分辨率图像的下游视觉任务,提高了模型在实际应用中的可行性。

方法

本文提出了一种新型的卷积神经网络架构——动态聚类卷积神经网络(Dynamic Clustering Convolutional Neural Network,简称DCCNeXt)。其核心研究方法是通过动态聚类卷积(Dynamic Clustering Convolution,简称DCConv)机制,将图像块根据语义相似性动态聚类成多个簇,然后对每个簇使用共享的卷积核进行卷积,从而捕捉图像中更长距离的依赖关系。为了降低全局聚类的计算复杂度,研究者从每个图像块的子空间中提取特征向量来进行聚类,有效减少了计算量。基于DCConv,研究者设计了一系列不同规模的视觉骨干网络(DCCNeXt-B0至DCCNeXt-B4),并采用分阶段特征提取策略:前两个阶段使用7×7深度可分离卷积提取局部特征,后两个阶段利用动态聚类卷积提取全局重要特征。

SAIL与模块化多模态大语言模型(MLLMs)的数据扩展曲线和性能对比

本图展示了动态聚类卷积(Dynamic Clustering Convolution,简称DCConv)的详细工作流程。图中还展示了特征向量的处理过程。首先,将每个图像块的特征向量沿着空间维度展平(Flatten),然后通过降采样操作提取子向量。接下来,利用Top-K算法获取每个聚类的索引(TopkIndex),并根据这些索引选择对应的特征向量(IndexSelect)。最终,对每个聚类中的图像块应用卷积操作,得到输出的特征图。通过这种动态聚类卷积的方式,DCCNeXt能够在全局范围内对图像块进行聚类,并在聚类的基础上进行卷积操作,从而有效地捕捉图像中长距离的依赖关系,同时保持了较低的计算复杂度。

DCCNeXt-B1架构

本图展示了DCCNeXt-B1版本的网络架构。该架构将输入的RGB图像首先通过一个7×7的卷积层进行分块处理,每个块被视为一个聚类中心,具有48维的特征维度。整个模型由四个阶段组成。前两个阶段使用7×7深度可分离卷积来提取局部特征,而后两个阶段则利用动态聚类卷积(DCConv)来提取全局重要特征。随着网络的深入,相邻的块会被合并成新的块,从而将特征图的尺寸缩小到原来的四分之一,并增加块的特征维度。整个网络架构的设计旨在结合局部和全局特征提取的优势,通过动态聚类卷积捕捉图像中长距离的依赖关系,同时保持计算效率和模型性能的平衡。

不同块深度下的动态聚类示例

本图展示了动态聚类卷积神经网络(DCCNeXt)中不同块深度下的动态聚类结果。图中以DCCNeXt-B2模型为例,展示了在第7块(第7个阶段)和第16块(第16个阶段)的聚类分布情况。每个聚类中的图像块根据其与聚类中心的语义相似性被聚集在一起,红色的块表示聚类中心,橙色的块表示属于同一聚类的其他图像块。可以看到随着网络深度的增加,聚类的分布和结构发生了变化。在较浅的阶段(如第7块),聚类可能更多地反映了图像的局部特征和结构,而在较深的阶段(如第16块),聚类则更多地捕捉了图像的全局语义信息。这种动态变化表明,DCCNeXt网络能够根据不同的深度层次自适应地调整聚类策略,从而更好地捕捉图像中的长距离依赖关系和全局结构。

实验

本表展示了DCCNeXt模型在ImageNet-1K数据集上的图像分类性能,并与其他多种类型的代表性骨干网络进行了比较。这些网络包括常见的CNN架构(如ConvNeXt、SLaK)、Vision Transformers(如Swin Transformer、Slide-PVT)、Vision MLPs(如CycleMLP)、Vision GNNs(如ViHGNN)以及Vision SSMs(如VMamba)等。DCCNeXt在不同模型规模下均展现出了卓越的性能,其不同版本(从DCCNeXt-B0到DCCNeXt-B4)在参数量和计算量(FLOPs)相近的情况下,top-1准确率均优于或至少可比于其他模型。DCCNeXt在模型规模扩大到50M和90M时,其DCCNeXt-B3和DCCNeXt-B4版本分别取得了84.3%和84.5%的top-1准确率,进一步证明了其强大的可扩展性和在图像分类任务中的优势。这些结果表明,DCCNeXt通过其独特的动态聚类卷积机制,在捕捉图像长距离依赖关系和语义信息方面具有显著优势,从而在图像分类任务中实现了优异的性能。

-- END --

关注“学姐带你玩AI”公众号,回复“CNN创新”

领取7大类CNN创新论文合集+开源代码