图片来源:AFP

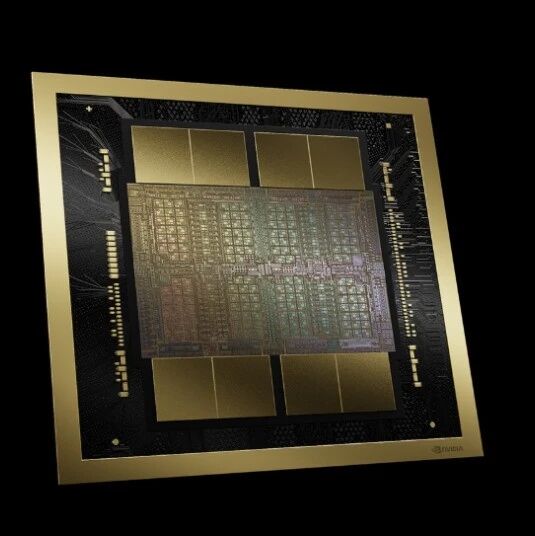

英伟达发布Rubin CPX——专为大上下文人工智能设计的下一代GPU,该产品可使系统以空前的速度与效率处理百万token级的软件编码和生成式视频任务。这款GPU隶属于全新的Vera Rubin NVL144 CPX平台,预计于2026年底上市。

企业AI的性能飞跃

根据英伟达的新闻稿,Rubin CPX在集成的Vera Rubin NVL144 CPX系统中与英伟达Vera CPU及Rubin GPU协同工作,可提供8 exaflops的AI计算能力——约为英伟达前代GB300 NVL72系统性能的7.5倍。该平台每机架还具备100TB的高速内存和1.7 PB/s的内存带宽。此外,将为希望扩展现有NVL144系统的客户提供独立的Rubin CPX计算托盘。

面向长上下文AI应用而构建

这款GPU专为长上下文AI任务设计,支持模型在软件开发和视频处理中对百万级token进行推理。Rubin CPX将视频解码器和编码器与长上下文推理集成,支持生成式视频、视频搜索和大规模代码优化等应用。其可提供高达30 petaflops的NVFP4计算能力,配备128GB GDDR7内存,注意力计算能力比GB300 NVL72快三倍。

早期采用者已准备部署

英伟达指出,多家AI公司已在探索将Rubin CPX用于企业级应用。软件开发AI公司Cursor旨在增强代码生成和开发者协作能力;专注于生成式视频的Runway期望实现更快且更逼真的内容创作;而Magic则计划利用该GPU训练具备1亿token上下文窗口的基础模型,以实现用于软件自动化的高级AI代理。

全面的生态系统支持

英伟达强调,Rubin CPX将获得英伟达全AI栈的支持,包括用于可扩展推理的Dynamo平台和用于企业AI推理的Nemotron多模态模型家族。企业可通过英伟达AI Enterprise软件、NIM微服务和CUDA-X库部署Rubin CPX,并接入英伟达拥有超600万用户和近6000个CUDA应用的开发者生态系统。

Rubin CPX预计于2026年底商业化上市,将为企业和AI创新者提供一个平台,以空前的速度和效率扩展大上下文AI工作负载。

原文标题:

Nvidia unveils Rubin CPX GPU for massive-context AI, available end 2026

原文媒体:digitimes asia

芯启未来,智创生态