·聚焦:人工智能、芯片等行业

欢迎各位客官关注、转发

大模型的[落地困境]与小模型的[刚刚好]

2023年是大模型的[狂飙元年],GPT-4、文心一言等模型凭借[写代码、写论文、做推理]的全能表现,让业界惊叹[通用AI来了]。

但到了2024年,当企业真正想把大模型装进业务流程时,却撞进了三重[落地墙]。

某互联网大厂做过一项测试:用GPT-4驱动客服Agent,一天10万次调用的API费用接近40万元,一个月就是上千万。

这对中小商家来说,相当于[用直升机送快递]。

反观小模型,阿里发布的Qwen2.5-Coder-7B在代码生成场景中,推理成本比上一代大模型下降70%。

7B左右的小模型驱动客服,成本直接砍去90%,月均支出可控制在10万元以内。

更关键的是隐性成本,2024年全球LLM托管的云基础设施投资激增至570亿美元,是同期LLM API服务市场规模的10倍。

服务器、GPU集群、配套工具链的投入,一旦转向小模型,前期投入就可能变成沉没成本。

但即便如此,仍有越来越多企业选择[换轨],因为小模型的长期运维成本,实在太香了。

在金融交易场景中,2秒的延迟可能错过最佳交易时机;在客服对话中,2秒的等待会让用户满意度下降30%。

而大模型一次推理往往需要2-3秒,甚至更久;小模型却能轻松实现毫秒级响应。

医疗记录、财务数据、用户身份信息等企业核心数据,一旦上传云端大模型,就面临外泄风险。

而小模型的本地化部署能力,恰好击中了这一痛点。

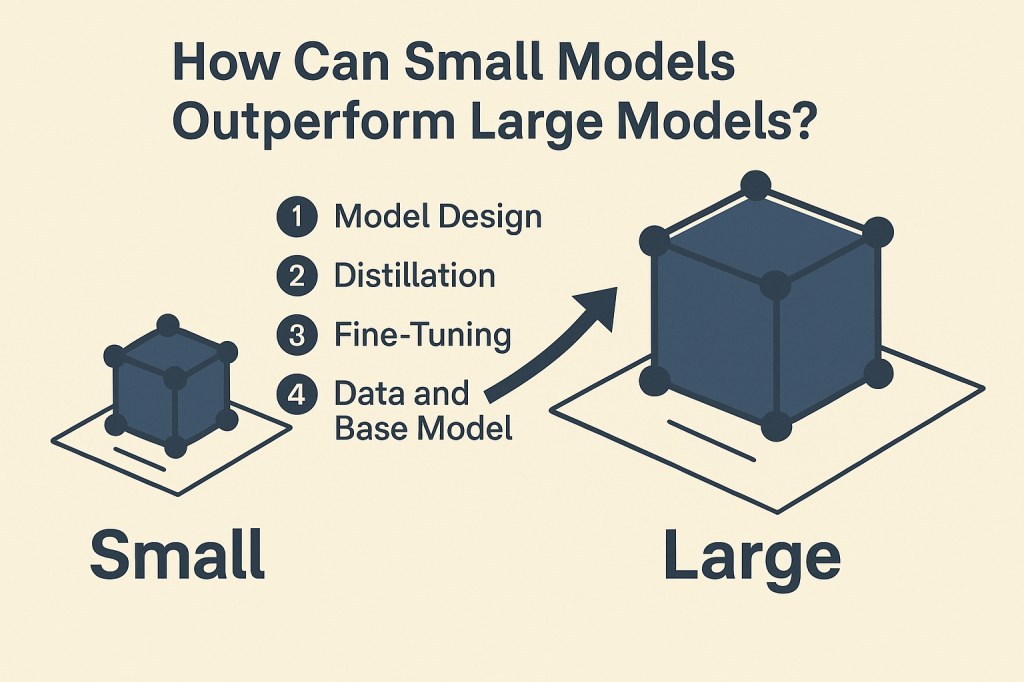

英伟达与佐治亚理工学院联合发布的论文《Small Language Models are the Future of Agentic AI》,更是用数据佐证了小模型的价值。

在MetaGPT、Open Operator等开源Agent项目中,40%-70%的调用任务,其实只需要小模型就能完成。

大模型像[超级大脑],适合解决开放性复杂问题;而Agent更多是[执行型角色],需要的是小模型这种[记得住流程、干活稳]的[小脑]。

这就是小模型崛起的底层逻辑:不是因为它比大模型[更先进],而是因为AI落地的主要形态(Agent),恰好需要[刚刚好的智能]。

小模型的落地,从来不是[一刀切]的。它的核心优势,在于对[流程清晰、重复性强、隐私敏感]场景的精准适配。

从客服到金融,从边缘设备到医疗,小模型正在用[小身材]撬动[大价值]。

①标准化流程任务:客服、文档处理的[效率加速器]。这类场景的关键,是不需要创造力,只需要稳定性。

客服Agent只需回答[账单在哪、怎么退货],文档Agent只需[提取重点、整理结构],小模型经过针对性微调后,完全能达到比大模型更靠谱的效果。

Gartner调研显示,45%部署小模型的企业,在文档处理、客服等场景中实现了[成本下降+准确率提升]的双重收益。

②高合规领域:金融、医疗的[精准解读者]。McKinsey报告指出,小模型在法律、金融、医疗等行业更受青睐,不是因为它更全能,而是因为它更可控。

在法律领域,小模型可基于判例库做条款匹配,输出的法律建议解释性更强,避免大模型模糊泛化导致的风险;

在医疗领域,2.5B参数的小模型可辅助病理切片分析,在本地设备上快速标注疑似病灶,既不泄露患者数据,又能为医生节省30%的阅片时间。

③边缘与端侧:从工厂设备到手机,小模型[无处不在]。

在智能制造场景中,英伟达部署在工厂端的小模型,推理延迟低、带宽消耗少,可实时分析设备传感器数据,预测故障风险;

在手机端,三星Galaxy S24搭载的SlimLM系列,能离线完成文档摘要、问答,运行流畅还不耗电;

在汽车智能座舱中,面壁智能的MiniCPM-V 4.0(4B参数)可实现[语音指令+图像识别]双模态交互,断网时也能识别障碍物、调取导航数据。

让人惊喜的是边缘设备的突破,石化行业的设备检修系统,用2.5B模型实现[语音识别+常规故障排查],工程师在现场用手机就能调用;

农业领域的[AI病虫害识别设备],搭载1.7B小模型,在田间地头就能分析叶片图像,无需联网上传数据,小模型让AI从[云端黑盒],变成了[嵌在机器里的芯片]。

国内产业AI的[大+小]协同,不是替代而是补位

[小模型会取代大模型吗?]这是行业最常问的问题。答案很明确:不会。

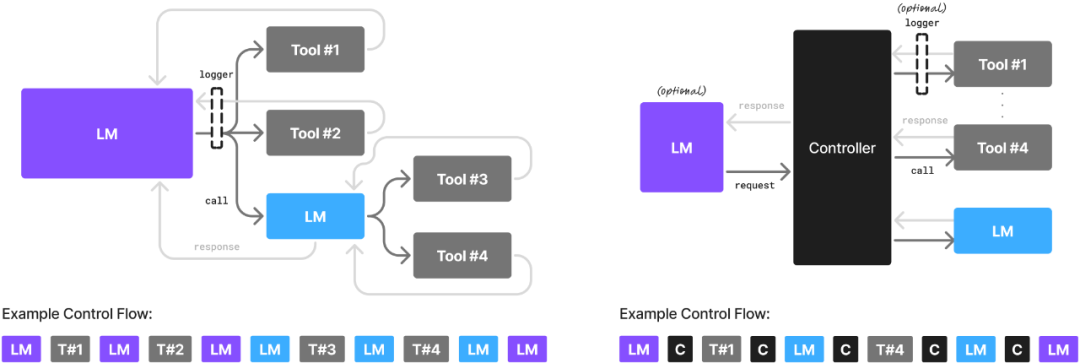

2025年的中国产业AI,正在走向[大模型+小模型]的混合架构,大模型做战略规划,小模型做战术执行,两者协同才能最大化价值。

这种模式正在普及,中大型企业用7B-9B小模型做私有化部署,集成到CRM、ERP等核心系统;遇到战略报告撰写、跨业务推理等复杂任务,再[求助]大模型;

1B-3B小模型则部署在移动端、边缘设备,处理文档总结、现场问询等轻量任务。

比如石化行业的设备检修系统,用2.5B模型实现[语音识别+常规故障排查],复杂故障再上传大模型分析。

据不完全统计,过去三年,国内厂商[≤10B参数]小模型的发布占比,从2023年的23%飙升至2025年的56%,成为大模型版图中增长最快的赛道。

阿里、腾讯、百度、DeepSeek等厂商,不仅推出小模型,还把[推理框架、量化压缩、微调流程]打包成[解决方案],降低企业部署门槛。

阿里Qwen-Agent提供文档问答、财报解析的模块化插件,企业按需即插即用;

腾讯混元Lite+私有部署SaaS中台,中型B端企业无需MLOps团队就能部署;

百度ERNIELite政务套件,针对本地合规需求优化权限与日志审计功能;

DeepSeek开源医疗问答小模型,在私立医院试点中,诊断建议准确率达88%。

海外厂商也在跟进,微软Phi-3提供完整推理工具,英伟达TensorRT-LLM+NIM服务实现[模型压缩-微调-部署]一条龙,Hugging Face把小模型变成任务组件。

但中国厂商的优势在于本土化适配,比如对中文语境的理解、对政务/金融等行业合规要求的熟悉,这是海外厂商短期内难以超越的。

2025年,国内开源社区涌现出一批垂直领域小模型。

MiniCPM在教育领域内测,集成至作业点评系统;中文RAG框架Langboat和LaWGPT专注政法场景;

DeepSeek开源的代码小模型,成为中小企业的编程助手。

这些开源模型,让企业无需从零构建,只需做场景化微调就能落地。

更重要的是技术平权,过去只有巨头能玩得起大模型;现在,5人团队用开源小模型,就能开发出行业专用Agent。

小模型是中国AI的破局点和超车机会

美国在高端芯片上的限制,让中国大模型发展面临算力瓶颈;而小模型对算力的低需求,恰好绕开了这一痛点。

零一万物在低端芯片上实现小模型高效训练,百川AI与高通合作开发手机端小模型,百度、字节跳动在智能终端预装小模型,这些实践都证明:没有顶级GPU,中国企业照样能做出好用的小模型。

清华大学五道口金融学院的报告指出,中国发展小模型具有优势:

①在特定场景中,小模型的优化能力可超越国外通用模型。

②小模型的成本效率更高,适合中小企业普及。

③中国有丰富的落地场景和用户数据,能快速迭代小模型。

这些优势,让中国在全球AI竞赛中,找到了一条不依赖高端芯片的差异化路径。

以医疗领域为例,国外大模型虽能回答通用医疗问题,但对中国的医保政策、常见病诊疗规范理解不足。

而国内医疗小模型基于本地病历、行业标准训练,能给出更贴合实际的建议。

当国外大模型还在争夺[云端霸权]时,中国企业已在端侧小模型上[抢跑]。

面壁智能的MiniCPM-V 4.0可在手机上稳定运行,支持图文交互;

腾讯混元0.5B-7B模型适配笔记本、智能座舱;华为云与车企合作,把小模型装进智能座舱,实现[离线语音控制]。

端侧是AI落地的[最后一公里],也是未来最大的增量市场。

中国有全球最大的智能手机、智能家居、智能汽车市场,这些设备都需要轻量级AI。

小模型的普及,不仅能让AI[飞入寻常百姓家],还能为中国产业AI构建端侧生态壁垒,这是国外大模型难以复制的优势。

2025年的产业AI,已经告别了[比参数、比算力]的粗放阶段,进入[比落地、比价值]的精耕时代。

小模型的崛起,不是对大模型的否定,而是对AI产业化的[补位]。

它让AI从高高在上的技术,变成触手可及的工具;从巨头的游戏,变成中小企业的机遇。

当AI能嵌进工厂的传感器、医院的诊断设备、家里的路由器、汽车的智能座舱,当每一个机器都有[刚刚好的智能],我们才能说:AI真正叩响了产业落地的大门。

部分资料参考:自然系列:《2025AI指数报告:没有一家独大,[小而美]模型大有可为》,产业家:《2025中国产业AI以小模型破局,欲叩响真落地之门》,清华五道口:《LLM时代小模型的应用潜力与挑战》,AI智研工坊:《小型语言模型(SLM)的崛起:未来趋势、生态系统与应用实践深度解析》,小黑魔法:《轻量化AI革命!三大中文小模型巅峰对决:谁将重新定义NLP未来?》,AI人工智能D1net:《小模型:传统行业智能化转型的[轻量级引擎]》,安邦智库:《成本考量下的[小AI]才是方向》,工业AI专家:《AI小模型:人工智能的[轻骑兵]》,AI科技评论:《AI的下一个战场:端侧模型崛起》,CPSE安博会:《小模型和大模型,谁离市场更近?》,头部科技:《[SLM优先]才是智能体的未来?英伟达力推小模型,比Qwen3-8B快6倍》

本公众号所刊发稿件及图片来源于网络,仅用于交流使用,如有侵权请联系回复,我们收到信息后会在24小时内处理。

推荐阅读:

商务合作请加微信勾搭:

18948782064

请务必注明:

「姓名 + 公司 + 合作需求」