点击下方卡片,关注“具身智能之心”公众号

作者丨Jiacheng Liu等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

想象一下:双足人形机器人在客厅里灵活深蹲取物,在厨房中跨高度整理餐具,全程无需大量人工演示数据——这一看似遥远的场景,正被 TrajBooster 框架推向现实。

近年来,视觉 - 语言 - 动作(VLA)模型让机器人自主执行家庭任务成为可能,轮式人形机器人已能完成深蹲、跨高抓取等复杂动作,AgibotWorld Beta 数据集显示其末端执行器轨迹覆盖 0.2-1.2 米范围,足以应对日常家庭场景。但双足人形机器人的研发却陷入瓶颈:它需要在保持下半身动态平衡的同时,用上身完成操控,实现大范围全身动作难度极高。更关键的是,训练这类机器人需要大规模高质量演示数据,而传统遥操作流程依赖昂贵设备和专家操作,生成的数据集规模小、场景单一,导致 VLA 模型难以适配新机器人的动作空间。

为解决这一痛点,来自浙江大学、西湖大学、上海交通大学等机构的团队提出了 TrajBooster 框架。它以末端执行器轨迹为 “通用语言”,打破轮式与双足人形机器人的形态壁垒,将轮式机器人的海量数据转化为双足机器人的有效训练资源。通过 “真实轨迹提取 - 仿真重定向 - 双阶段微调” 的流程,仅需 10 分钟双足机器人遥操作数据,就能让 Unitree G1 完成深蹲、跨高度操控等桌面级以上任务,大幅提升鲁棒性与泛化性。

这一突破不仅降低了双足人形机器人对昂贵同形态数据的依赖,更让 VLA 模型的零样本技能迁移成为可能。接下来,我们将深入解析 TrajBooster 的技术细节,看看它如何为双足人形机器人的实用化按下 “加速键”。

论文题目:TrajBooster: Boosting Humanoid Whole-Body Manipulation via Trajectory-Centric Learning

论文链接:https://arxiv.org/abs/2509.11839

项目链接:https://jiachengliu3.github.io/TrajBooster/

作者单位:Zhejiang University, Westlake University, Shanghai Jiao Tong University, Shanghai Innovation Institute

研究背景与问题

近年来,视觉-语言-动作(VLA)模型在人形机器人领域展现出跨形态泛化潜力,推动机器人自主执行家庭任务的可靠性与泛化性提升。其中,轮式人形机器人在需要全身协调运动(如深蹲、跨高度抓取)的家庭任务中表现突出,AgibotWorld Beta数据集显示其末端执行器轨迹集中在0.2-1.2米范围,覆盖了远超桌面场景的日常任务需求。 但仍存在两大核心挑战:

双足人形机器人的独特难题:双足人形机器人需在保持下半身动态平衡的同时,用上半身完成操控,实现大范围全身操控难度极高,而现有VLA研究多聚焦于复杂环境中的运动或桌面级操控,存在关键技术缺口。

数据稀缺瓶颈:训练双足人形机器人的全身操控VLA模型需要大规模演示数据,但现有遥操作流程依赖昂贵设备与专家操作员,生成的数据集规模小、场景与任务多样性有限,导致VLA模型难以与新机器人的动作空间对齐。尽管在异构机器人语料库上预训练有一定帮助,却无法替代高质量、与人形机器人相关的全身演示数据。

主要贡献

首次实现真实场景应用:据作者所知,这是首个利用大量重定向动作数据进行微调,在真实场景中实现双足人形机器人基于VLA模型的全身操控的研究。

提出跨形态框架:设计TrajBooster框架,以末端执行器轨迹作为形态无关信号,将丰富的轮式人形机器人演示数据转化为有效的双足人形机器人训练数据,仅需有限目标域数据即可实现VLA适配,缓解双足人形机器人数据稀缺问题。

实现高效任务执行:在Unitree G1机器人上仅需10分钟遥操作数据采集,就能完成桌面级以上家庭任务(如深蹲、跨高度操控、协调全身运动),显著提升鲁棒性与泛化性,同时减少对高成本同形态数据的依赖,增强零样本技能迁移能力。

具体方法(TrajBooster框架)

TrajBooster是“真实-仿真-真实”的跨形态 pipeline,核心流程分为三步,整体框架如图1所示。

真实轨迹提取(Real Trajectory Extraction)

数据来源:采用Agibot-World Beta数据集(含超100万条真实机器人轨迹,包含多视角视觉信息、语言指令与6D末端执行器位姿)作为源数据。

轨迹映射处理:由于Agibot与Unitree G1工作空间存在差异(如Agibot臂展1.8米,Unitree G1仅1.2米),需将Agibot数据映射到Unitree G1官方操控数据集(含7项桌面级任务、2093个片段):

基于Unitree G1数据集进行z-分数归一化,对齐x轴;

按臂长比例(β=0.6667)缩放y轴;

将z轴限制在[0.15,1.25]米安全范围内。

仿真中重定向(Retargeting in Simulation)

模型架构:分层复合模型

为实现全身操控重定向,将控制解耦为上、下半身系统,架构如图3所示:

手臂策略(Arm Policy):通过Pinocchio库的闭环逆运动学(CLIK)计算目标关节角度,输入为相对于基座坐标系的腕部位姿(),输出为手臂关节指令,公式为:

工人策略(Worker Policy):目标条件强化学习策略,输入为基座速度指令()与躯干高度(h),输出12自由度下半身的目标关节位置,公式为:

管理者策略(Manager Policy):从腕部位姿生成下半身指令,公式为:

复合模型整合:输入为,输出为Unitree G1关节指令(通过PD控制器执行),公式为:

分层模型训练:启发式增强的协调在线DAgger

训练分为“工人策略训练→管理者策略训练”两步,管理者策略训练关键流程(对应算法1)如下:

数据准备:在MuJoCo中初始化Unitree G1站立状态,回放上肢运动数据集获取种子轨迹;通过PCHIP插值生成[0.15,1.25]米高度变化的增强轨迹;基于插值高度生成启发式高度目标(),基于1秒规划时域内基座位移生成启发式速度指令(),并裁剪速度范围(、、)。

在线学习:在Isaac Gym的N个并行环境中,每次迭代让管理者策略()执行T步(T=50)滚动;通过以下损失函数优化:

滚动损失:

协调DAgger策略:每M=10次迭代聚合数据(),通过聚合数据集损失优化:

优势:利用仿真中的特权信息(如目标轨迹对应的躯干高度、基座位移)生成启发式指令,提升训练效率,同时避免持续学习中的灾难性遗忘。

真实人形机器人微调(Finetuning for Real Humanoid)

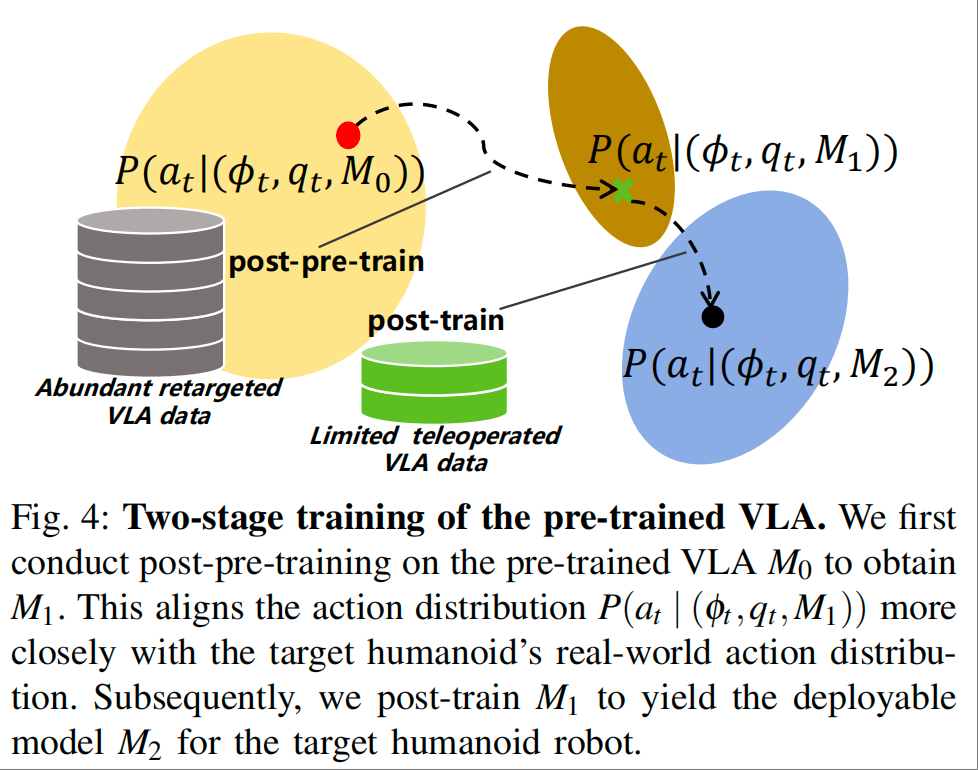

采用“后预训练(Post-Pre-Train)→后训练(Post-Train)”两步流程,如图4所示:

基于重定向数据的后预训练

数据构建:将重定向动作数据与Agibot-World数据集的语言指令、视觉观测整合,形成多模态三元组(<源视觉,源语言,目标动作>)。

训练目标:以预训练GR00T N1.5模型为基础,通过流匹配损失优化,让模型预测去噪向量场(),损失函数为: . 其中,为视觉-语言token嵌入,为Unitree G1全身关节状态,为高斯噪声(),为流匹配时间步,为带噪动作块。

推理细节:20Hz频率下生成16时间步的动作块,包含手臂/手部关节位置指令与下半身控制指令。

基于遥操作数据的后训练

数据采集:下半身运动采用与Worker Policy一致的训练方法,控制指令来自人类遥操作杆;上半身运动通过Apple Vision Pro遥操作框架实现运动学映射;视觉数据由2个腕部RGB相机与1个头部RGB相机采集,最终获取约10分钟、覆盖4种高度配置的真实数据。

训练方式:用采集的遥操作数据(<目标视觉,目标语言,目标动作>)微调后预训练模型,优化目标同后预训练阶段的流匹配损失。

实验结果

实验围绕4个核心问题展开,验证TrajBooster的有效性。

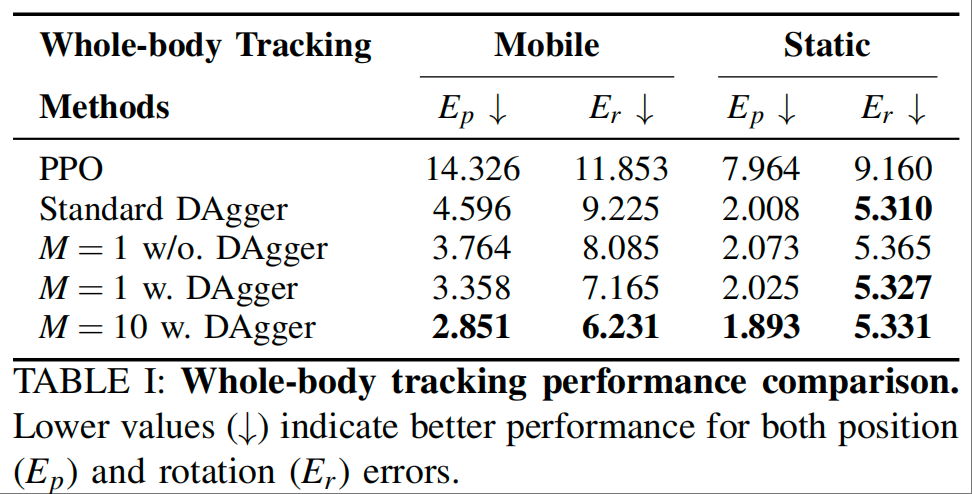

重定向模型评估(Q1)

实验设置

基线方法:基于奖励的PPO、标准DAgger、无DAgger的在线学习(M=1)、带DAgger的标准在线学习(M=1)。

实验环境:512个并行环境,200次训练迭代(PPO为800次),硬件为RTX 4090 GPU + Intel Core i9-14900K CPU。

评估指标:腕部轨迹与目标轨迹的位置MAE(,单位:cm)、旋转MAE(,单位:度),数值越低性能越好。

结果分析(表1)

TrajBooster(M=10带DAgger)在移动场景中实现最低的位置误差(2.851cm)与旋转误差(6.231度),静态场景位置误差也最优(1.893cm),同时兼顾存储效率与学习效率,验证了分层训练与协调在线DAgger的优势。

VLA模型评估(Q2-Q4)

实验设置

数据集:后预训练用176项任务、1960个片段(约35小时仿真交互)的重定向数据;后训练用4项任务、约10分钟的真实遥操作数据(图6)。

基线方法:无后预训练的VLA模型(仅用真实数据训练3K步、10K步)。

硬件配置:后预训练用双A100 80GB GPU(批大小128,60K步);后训练用单A100 GPU(批大小16,3K步)。

加速动作空间适配(Q2,表2)

带后预训练的模型(3K步)在多数任务中成功率超过无后预训练的10K步模型,且无后预训练的3K步模型完全无法学习任务(仅在目标附近振荡,无抓取意图),证明后预训练可加速VLA模型对双足人形机器人动作空间的适配。

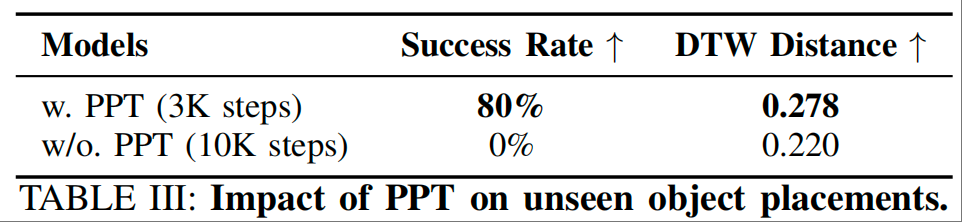

提升轨迹泛化性(Q3,表3+图7)

当目标物体放置在遥操作未覆盖的位置时,带后预训练的模型成功率达80%,而无后预训练的模型成功率为0%。

DTW距离分析显示,无后预训练的模型轨迹与遥操作数据更相似(DTW=0.220),存在过拟合;带后预训练的模型能自适应调整轨迹(如从下方抓取,图7右),泛化性更强。

解锁零样本技能(Q4,图8)

评估“传递水”任务(仅包含在后预训练数据中,未出现在遥操作数据中),带后预训练的模型可在Unitree G1上零样本完成该任务,证明后预训练提升了模型对未见过任务的泛化能力。

总结与局限性

总结

TrajBooster针对双足人形机器人VLA模型训练的数据稀缺问题,提出以末端执行器轨迹为核心的跨形态框架。通过“真实轨迹提取→仿真重定向→双阶段微调”流程,将轮式人形机器人的海量数据转化为双足机器人的有效训练数据,仅需10分钟遥操作数据即可实现桌面级以上全身操控,同时提升动作空间理解与零样本迁移能力,为双足人形机器人的实用化提供新方案。

局限性与未来方向

末端执行器限制:Unitree Dex-3手精度有限,仅支持简单抓取,未来将采用带触觉感知的灵巧手实现复杂操控。

动作-视觉一致性:当前方法仅替换动作空间,未处理视觉输入差异,未来需探索视觉观测的形态对齐,提升感知-动作一致性。

移动操控数据稀缺:缺乏大规模移动操控数据,研究局限于静态任务,未来将扩展框架至移动场景。

扩展性不足:实验依赖Agibot G1机器人与Agibot-World数据集,未来需整合更多异构数据以提升扩展性。