本文来自社区投稿,单位:中国电信人工智能研究院

研究方向:表格理解和大语言模型

论文标题: T2R-bench: A Benchmark for Generating Article-Level Reports from Real World Industrial Tables

收录会议: EMNLP 2025 Main Conference

论文链接:https://www.arxiv.org/pdf/2508.19813

Huggingface地址链接:https://huggingface.co/datasets/Tele-AI/TeleTableBench

Github地址链接:https://github.com/Tele-AI/TeleTableBench

动机

尽管已有大量研究探索大语言模型(LLM)在表格推理方面的能力,但将表格信息转化为报告这一关键任务在工业场景中仍是重大挑战。该任务面临两大核心难题:1. 表格的复杂性与多样性导致推理效果欠佳;2. 现有表格基准缺乏对此任务实际应用价值的充分评估。 为填补这一空白,我们提出“表格到报告”(table-to-report)任务,并构建了一个双语基准 T2R-bench。

T2R-bench是业内首个面向真实工业场景的“表格生成报告”基准。该数据集共收录457个真实业务表格,类别包括:汽车、能源、金融、政务、财务、科技、教育、银行等垂域,还开源了910个高质量的问题和4320个经过人工高质量标注的报告关键点(金标准)。此外, 如表1所示,相比于各类开源表格数据集,T2R-bench是业内目前覆盖工业级表格类别最全的数据集,包括:单表多sheet、多表多sheet、复杂结构表、超大宽表等。 我们还设计了一套评价指标体系,以公平衡量生成报告的质量。在25个主流LLM上的实验表明,当前几乎所有的大模型在T2R-bench上仍有显著提升空间。

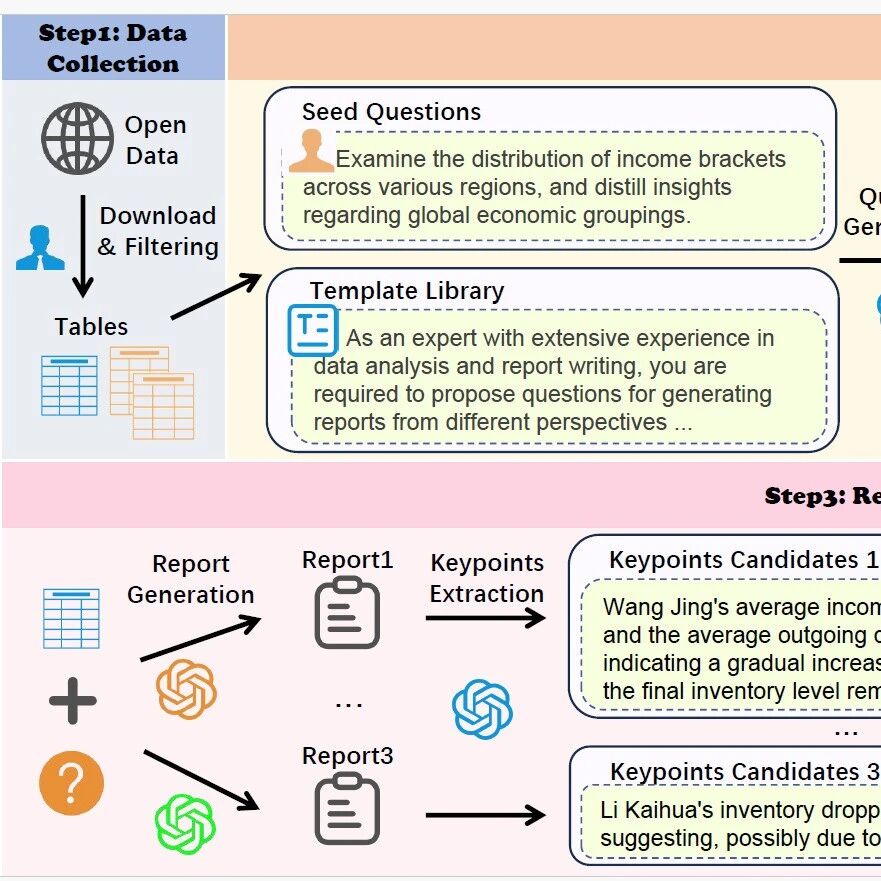

T2R-bench构建

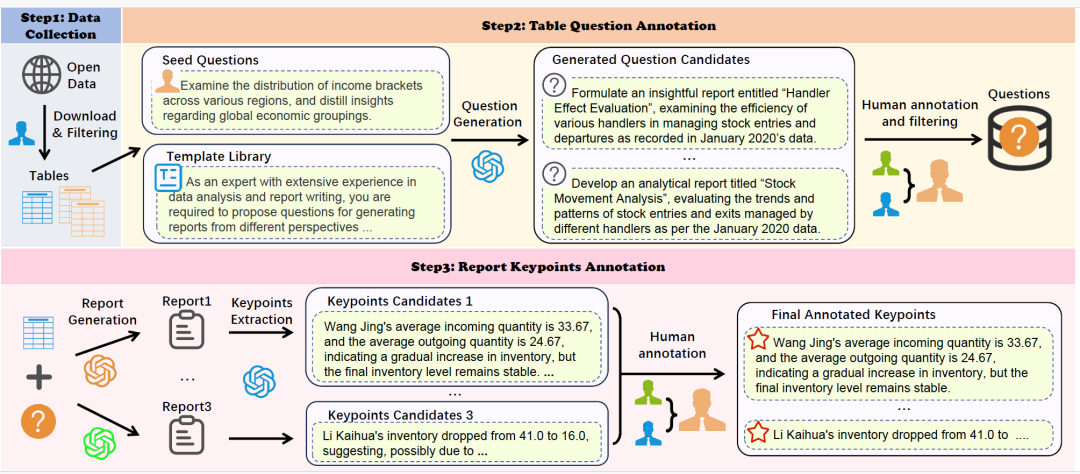

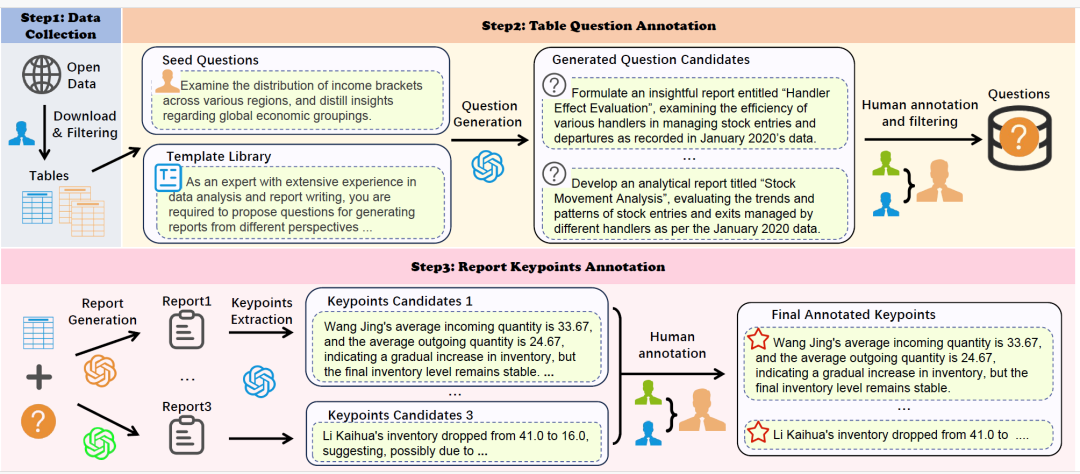

为确保实验数据集T2R-bench的质量,研究团队采用了严格的数据集构造流程,如图2所示。

数据集采集

收集互联网公开的工业级表格数据,主要来源包括国家统计局、数据平台、行业协会以及已开源的表格数据集。收集的表格尽可能涵盖多种真实场景,包括:单表多sheet、多表多sheet、超大型表格,以及具有简单和复杂表头结构的工业表格。

表格问题标注

种子问题和提示准备:由标注人员精心设计了10个种子问题和一个包含5种不同提示模板的模板库。 自我指导生成问题:针对每一张表格,基于self-instruct和GPT-4o随机选取两个模板(每个模板包含2到5个种子问题示例),共生成3个相关问题。 人工标注和筛选:由两名标注人员独立评估每个问题,依据三个标准:是否可仅用表格数据回答(无需外部知识)、是否聚焦单一分析维度以得出明确结论、以及是否与其他问题互补无重叠。不一致结果由资深标注人员仲裁。

报告参考点(金标准)标注

表格到报告的任务因标注人员的认知差异和表格数据的复杂性而存在显著多样性,将整个报告作为参考标准不切实际。然而,专业撰写的报告在中心观点、分析结论、关键数据、建议总结往往具有一致性,因此,研究人员引入了报告关键点(Report Reference),将其作为评估生成报告的金标准。

报告生成:采用三种不同的LLM(Qwen-3-32B、Moonshot-V1-32K和Deepseek-R1)为每个<table, 报告问题>对生成3份不同的报告。 关键点提取:使用GPT-4o从每份报告中提炼出最关键的信息,并提炼为5-10个关键点。 人工标注:进行人工验证,双标注者审核关键点是否忠实于表格、相关且非冗余,分歧由专家裁决。

数据统计

T2R-bench数据集的整体情况分别如图3和表2所示。T2R-bench数据集具有以下优点:

涵盖丰富的工业领域:包含457个真实业务表格,共6个一级大类和19个二级小类,包括,汽车、能源、金融、政务、财务、科技、教育、银行等垂域。 涵盖多种表格类型:复杂结构表(28.9%的表格包含复杂表头和合并单元格)、超大规模表(8.3%的表格超过5万个单元格)和多表(23.6%的表格为多表多sheet或多表单sheet)。 问题和报告参考点:包含910个高质量人工标注表格问题和4320个人工标注报告参考点,通过严格的标注与验证流程,显著提升和保障了T2R-bench数据集的质量。

数据样例

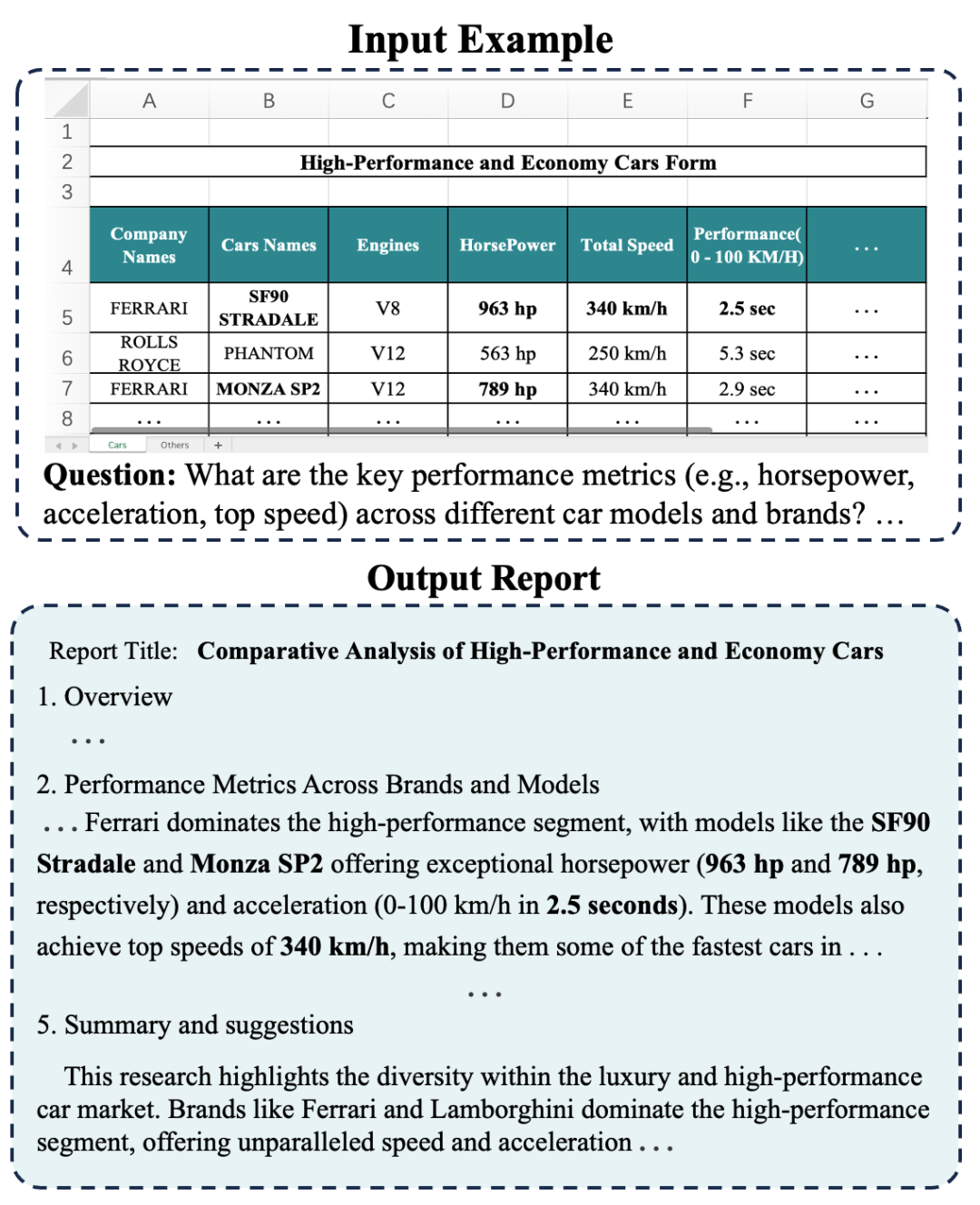

图4展示了2个完整的数据样例,其中包括表格、问题、报告参考点和参考报告。

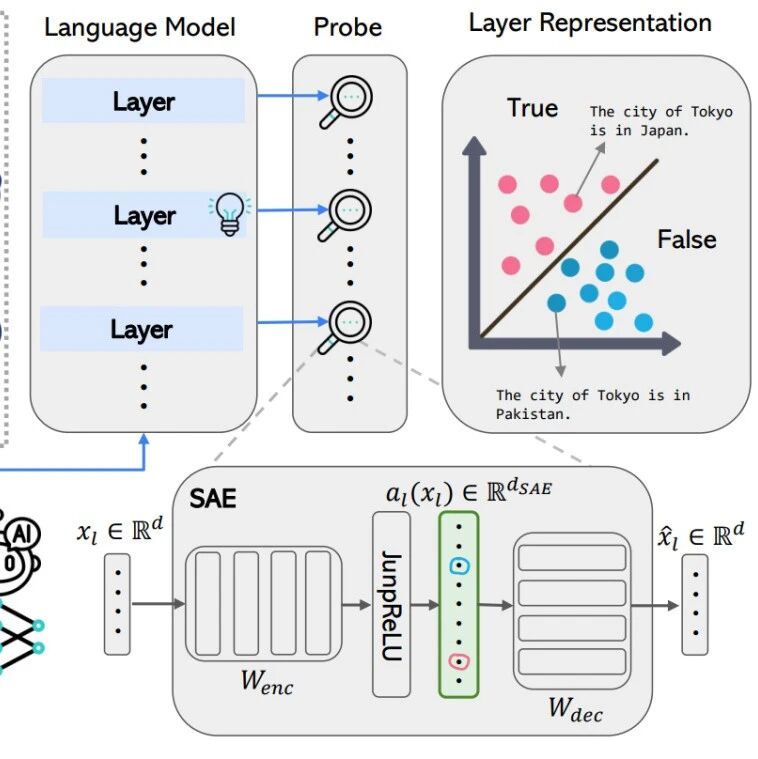

T2R-bench评价体系

传统表格任务评估基准(如BLEU/ROUGE)存在两大缺陷:无法验证报告中的数值与表格的一致性,无法避免机械式的文本对照匹配。为此,基于T2R-bench数据集,研究人员设计了互补的3个评估标准,覆盖数值准确性(NAC)、信息完整性(ICC)和总体报告质量(GEC)三大准则。

准则1:数值准确性(NAC)

采用NLTK和Jieba对目标报告进行分句,再通过正则表达式提取包含数值陈述(整数或浮点数)的句子簇(如“:库存量增加15%”)。 将提取到的数值语句转化为对应的验证问题(例:若报告写“总销售额为¥24,892”,则生成“总销售量是多少?”)。 使用Qwen2.5-32B-Coder、Deepseek-Coder、CodeLlama-70三类代码模型解析问题,生成Python代码并从原表提取数据执行计算。 采用多数投票机制:仅当至少两个模型输出一致时,该结果方被认定为正确;否则,否则标记为“无法验证”。

准则2:信息完整性(ICC)

先用NLTK/Jieba对目标报告进行分句,得句子簇S。 用BERTScore计算目标报告参考要点和生成报告的句子相似度矩阵S。 将矩阵S归一化得到联合与边缘概率,并通过计算得到归一化互信息ICC值,其中ICC∈[0,1]。 对所有报告的ICC取平均值,得分越高,说明整体生成报告对关键信息的保留越完整。

准则3:总体报告质量(GEC)

GEC评估包含:推理深度、类人风格、实用性、内容完整性、逻辑连贯性这五个维度,并用LLM-as-Judge范式,通过输入生成的报告和评分规则(10分制),输出各维度单独分数及打分理由。最终GEC评估得分为五个维度的平均值。

实验

基线模型和实验结果

基于T2R-bench数据集,如表4所示,研究人员评测了包含DeepSeek系列、LLaMA系列、Qwen系列、Doubao系列、GPT系列、Claude、Mistral、Telechat和表格理解类大模型(如:TableGPT2-7b)在内的25个开源和闭源LLM。这些评测充分涵盖了单表、多表、复杂样式/表头表格及超大规模表格这4种表格数据类型。

实验结果

表4、表5和表6分别展示了25个大模型在T2R-bench上的实验结果,主要的实验发现如下:

表格输入格式影响:即使是相同的表格数据,以Markdown格式输入模型相较于HTML或JSON格式,有显著的表现提升。 表格复杂性影响:随着表格单元格数量的增加,及表格结构样式的复杂性提升,模型整体性能出现显著下降,这一现象在多表关联、复杂结构表格及超大宽表上更为明显。 语言差异影响:大多数模型在中文和英文环境下的表现相似,但仍有一些模型(例如Llama系列模型)显示出较大性能差异,从侧面刻画了不同模型在表格生报告任务上的本质差异。 幻觉及关键信息缺失影响:数值事实错误、生成错误、表格结构理解错误及生成的报告未能全面覆盖要点导致的信息缺失,都会不同程度的影响模型整体推理能力,进而显著降低生成报告的最终质量。

通过实验观察到,即使表现最优的Deepseek-R1,也仅取得62.71的平均综合得分。这凸显了在真实的工业场景下,大语言模型尚未具备稳健可靠的表格理解、信息转换与深度分析能力,报告生成任务上仍有很大改进空间。同时,T2R-bench也为大语言模型在工业场景中的落地应用提供了重要的评估基准,并通过大量的评测实验展示了评估的严谨性与可解释性。

局限性和未来方向

虽然本文对表格生报告任务进行了首个系统性的数据集构建和实验探索,但是也存在一些局限性:

未来需要扩充覆盖更多表格类型与领域的数据集,进一步提升评测的数据多样性。 目前最佳开源模型(Deepseek-R1)的数值准确性(NAC)与信息覆盖度(ICC)均未达65%, 未来提出表格生报告任务的专用模型,从而缩小现有能力与实际应用间的差距值得进一步探索。

主要作者简介

张劼,中国电信人工智能研究院(TeleAI)资深算法专家,具备多年NLP和大模型算法技术研发经历,参与中国电信自研Telechat大模型的研发和落地工作,包括:全国首个国产化万卡万参语义大模型 、大模型应用(智慧办公、智能客服、BI分析等)和前沿技术探索(Agentic RL、表格推理)等。发表国际期刊/会议论文10余篇(ACL、EMNLP、AAAI、ICLR等),并担任多个国际/国内期刊审稿人。荣获省部级奖项和行业奖项各1项。曾供职中科院、微软和头部互联网公司,从事智能语音助手和对话系统的研发工作。

潘长在,博士与本科均毕业于清华大学,现就职于中国电信人工智能研究院(TeleAI),担任语义算法工程师。曾在ACL、EMNLP、AOAS等国际顶级会议与期刊发表多篇学术论文。主要研究方向包括大模型推理、表格理解与强化学习等。

宋双永,博士毕业于中科院自动化所,中国电信人工智能研究院(TeleAI)高级算法总监、语义技术研发中心主任、星辰语义大模型TeleChat技术负责人,在各类国际期刊会议中担任副主编、PC member及Session Chair等,发表各类学术论文超百篇。 曾先后就职于富士通研发中心、阿里巴巴、京东科技,长期从事自然语言处理算法研发工作。目前作为技术负责人全面主导中国电信星辰语义大模型TeleChat从基础数据构建、通用模型训练、行业项目交付的相关工作,已经全面开源从1B到115B参数的十多款模型,获得中国通信学会-年度信息通信领域十大科技进展、Gitee-MVP最有价值开源项目等诸多奖项。个人主页:https://sites.google.com/view/samuelsong/

杨健,北京航空航天大学计算机学院副教授,在ICLR、NeurIPS、ICML、ACL等国际期刊/会议发表第一作者/通讯作者20余篇,谷歌学术引用万余次,并担任NeurIPS、ACL等国际会议的领域主席。曾作为阿里星入职通义千问(Qwen)及QwenCoder系列的核心贡献者,积极推动大模型开源工作。长期招收科研实习生,联系邮箱jiayang@buaa.edu.cn

-- 完 --

机智流推荐阅读:

1. 万字长文解答为何LLM同问不同答?OpenAI前CTO团队最新研究让大模型结果可复现

2. VLA-Adapter:北邮等团队以0.5B参数实现机器人智能新高度,还无需预训练

3. 理解和生成让任务真的能相互受益吗,还是仅仅共存?北大&百度UAE框架,统一视觉理解与生成,实现多模态模型新突破

4. 聊聊大模型推理系统之Q-Infer技术突破:GPU-CPU协同推理提速3倍背后的三大创新

关注机智流并加入 AI 技术交流群,不仅能和来自大厂名校的 AI 开发者、爱好者一起进行技术交流,同时还有HuggingFace每日精选论文与顶会论文解读、Talk分享、通俗易懂的Agent知识与项目、前沿AI科技资讯、大模型实战教学活动等。

cc | 大模型技术交流群 hf | HuggingFace 高赞论文分享群 具身 | 具身智能交流群 硬件 | AI 硬件交流群 智能体 | Agent 技术交流群