想象你在和朋友看一部电影,朋友突然问你:"这个人为什么突然笑了?"你不仅要看懂画面中人物的表情,还要结合剧情背景、人物关系来推理原因。这就是人类天生具备的多模态推理能力。

一、多模态推理

简单说就是让AI像人类一样,能够同时理解图片、文字、声音,并且能够推理它们之间的关系。

想象这个场景:你看到朋友在咖啡厅里皱着眉头看手机,你的大脑会自动进行如下分析。

视觉信息:皱眉表情 + 专注看手机 背景知识:咖啡厅环境 + 朋友平时性格 推理过程:皱眉通常表示困扰 → 可能收到了麻烦消息 结论:朋友可能遇到工作上的急事

这就是人类天生的多模态推理能力!

为什么多模态推理这么重要?

(1)单模态的局限性

纯视觉AI:只能识别"看到什么"

输入:一张图片(人在看手机)输出:检测到"一个人"、"一部手机"局限:无法理解为什么看手机,也无法回答意图相关问题

纯语言AI:只能处理"文字描述"

输入:文字问题"这个人为什么皱眉?"输出:理解了问题的语法和含义局限:没有视觉信息,无法看到具体表情和环境

(2)多模态的优势

信息互补:视觉+语言=完整理解

视觉提供:具体的场景细节(表情、动作、环境)语言提供:抽象的概念和问题("为什么"、"怎么样")结合效果:既能看懂画面,又能回答抽象问题

推理深度:从"是什么"到"为什么"

Level 1:识别 → "看到一个人在看手机"Level 2:理解 → "这个人正在专注地查看信息"Level 3:推理 → "从表情判断可能收到了重要/麻烦的消息"

多模态推理的三个难度等级是什么?

Level 1:信息融合

任务:把不同模态的信息组合起来

输入:图片(一只橙猫) + 文字("这是什么动物?")处理:图像识别 + 文字理解 + 信息匹配输出:"猫"本质:信息检索和匹配

Level 2:关系推理

任务:理解不同信息之间的关系

输入:图片(猫在沙发上) + 文字("猫在哪里?")处理:空间关系理解 + 位置定位输出:"在沙发上"本质:空间/时间/逻辑关系分析

Level 3:逻辑推理

任务:基于观察进行逻辑推导

输入:图片(人穿厚外套,地面有雪) + 文字("现在是什么季节?")处理:观察线索 + 常识知识 + 因果推理输出:"冬天"本质:综合分析和逻辑推导

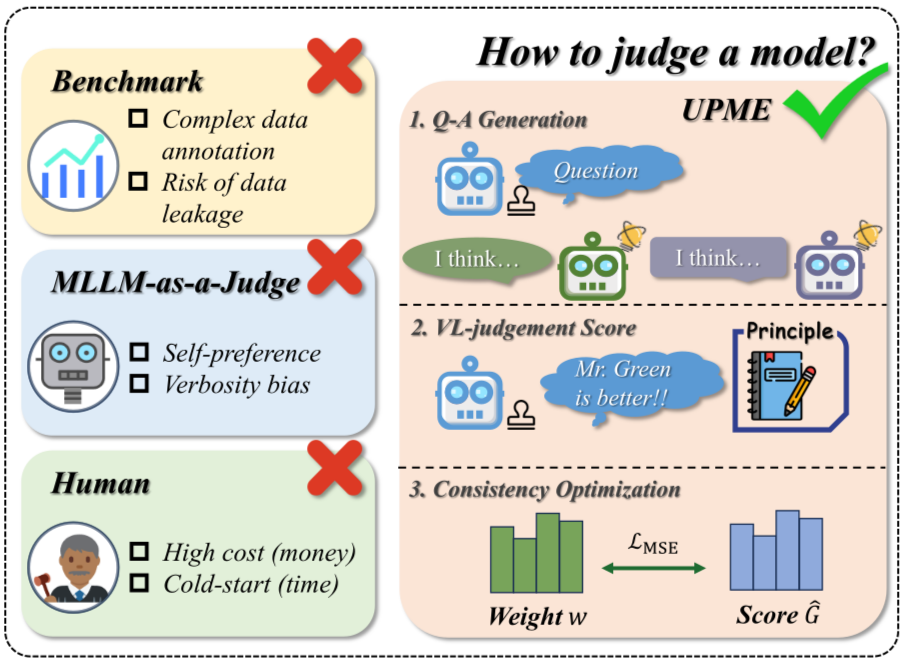

二、视觉问答(VQA)

什么是视觉问答(Visual Question Answering,VQA)?

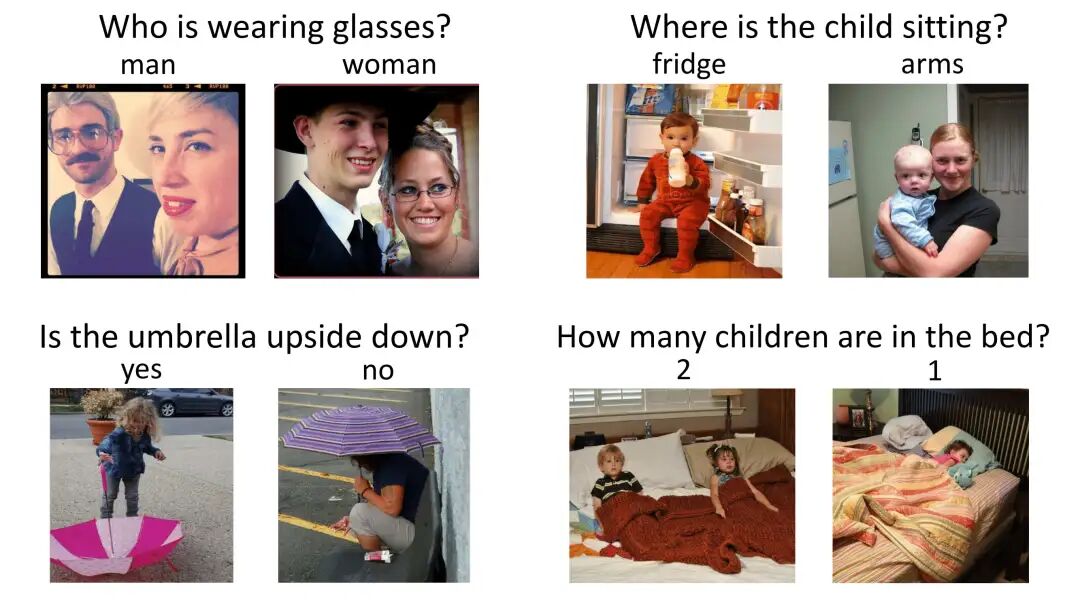

想象一下,你拿着一张照片问朋友:"这张图里有几只狗?"朋友看了看,很自然地回答:"两只。"

VQA(Visual Question Answering)就是要让AI也能做到这一点——给它一张图片和一个问题,它能像人类一样给出准确答案。

听起来很简单?其实不然。最大的挑战是:AI需要真正"看懂"图片内容,而不是通过记忆训练数据中的常见答案来"蒙"对。

比如,如果训练数据中"香蕉是什么颜色"这个问题99%的答案都是"黄色",那AI很可能会记住这个模式。当你给它一张绿色香蕉的图片时,它仍然会回答"黄色"——这就是记忆答题,而不是真正的理解。

要解决这个问题,我们需要了解VQA任务的复杂程度。根据推理难度,VQA问题可以分成四个等级。

Level 1:感知型问题(看得见就能答)

图片:一个红色苹果在桌子上问题:这是什么水果?答案:苹果难度:★☆☆☆☆技术要求:- 基础物体识别- 颜色形状检测

Level 2:计数型问题(需要仔细数)

图片:三只猫在沙发上问题:图片中有几只猫?答案:三只难度:★★★☆☆技术要求:- 目标检测和分割- 重复计数避免- 遮挡情况处理

Level 3:空间推理型问题(需要分析位置关系)

图片:桌子上有书,书旁边有杯子问题:杯子在书的什么位置?答案:旁边难度:★★★★☆技术要求:- 空间关系理解- 相对位置推理- 几何关系分析

Level 4:知识推理型问题(需要结合常识)

图片:一个人穿厚外套,呼出的气体可见问题:现在可能是什么季节?答案:冬天难度:★★★★★技术要求:- 常识知识运用- 因果关系推理- 多线索综合分析

VQA技术如何演进突破?

第一代:简单特征拼接(2015-2017)

把图片特征和文字特征直接"拼"在一起,只能简单融合,无法处理多步推理。

图片处理:图片 → CNN → 全局特征向量 [2048维]问题处理:文本 → 词嵌入 → LSTM → 问题特征向量 [512维]特征融合:方法1:简单拼接 [图片特征 + 问题特征] → [2560维]方法2:元素相乘 图片特征 ⊙ 问题特征 → [2048维]答案预测:融合特征 → 全连接层 → Softmax → 答案概率分布

第二代:注意力机制登场(2017-2019)

让AI能够"专注"于图片的相关区域,能定位问题相关的视觉区域,显著提升复杂问题准确率,具有一定程度的可解释性。

问题:"这个人穿什么颜色的衣服?"Step 1:问题编码"穿什么颜色衣服" → LSTM → 问题表示 qStep 2:图像区域特征图片 → 目标检测器 → 候选区域特征 {v1, v2, ..., vn}Step 3:注意力计算for each 区域 vi:注意力分数 = 计算(q, vi) # 问题与区域的相关性Step 4:加权融合attended_feature = Σ(注意力分数[i] × vi)

第三代:Transformer统一建模(2019-至今)

将视觉和语言统一为序列建模问题

Step 1:统一Token化处理图片处理:输入图片 → 切分patch → 线性投影 → 图像tokens[img_token1, img_token2, ..., img_token196]问题处理:输入文本 → 分词 → 词嵌入 → 文本tokens[这个, 人, 穿, 什么, 颜色, 的, 衣服, ?]Step 2:序列拼接[CLS] + 图像tokens + [SEP] + 文本tokens + [SEP]Step 3:三分支Transformer处理- Object-Relationship Encoder:处理图像目标和关系- Language Encoder:处理文本序列- Cross-Modality Encoder:跨模态交互Step 4:交互机制- Self-Attention:模态内部信息整合- Cross-Attention:模态间信息交换- 多层堆叠:逐步深化理解

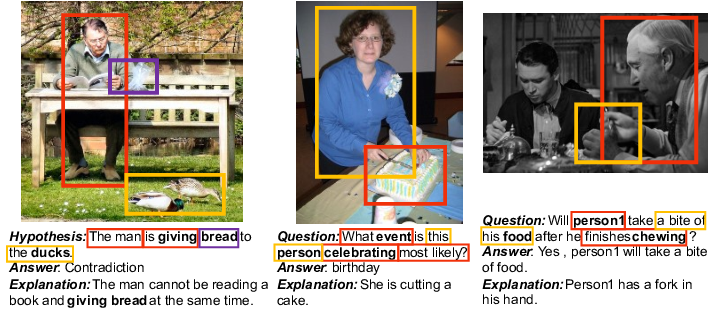

三、视觉常识推理(VCR)

什么是视觉常识推理(Visual Commonsense Reasoning,VCR)?

VCR不仅要求AI回答问题,更要求AI能够解释为什么这样回答,展现出类似人类的推理过程。

(1)VQA任务:只要答案对就行

输入:图片 + 问题输出:答案评估:答案正确性示例:图片:一个人拿着雨伞问题:这个人手里拿着什么?答案:雨伞

(2)VCR任务:答案对了还要解释为什么

输入:图片 + 问题输出:答案 + 推理解释评估:答案正确性 + 推理合理性示例:图片:一个人拿着雨伞,地面湿润问题:为什么这个人拿着雨伞?答案:因为在下雨解释:可以看到地面是湿的,而且天空灰暗,这些都表明正在下雨,所以这个人拿雨伞是为了避免被雨淋湿。

VCR的三个递进任务是什么?

任务1:Q→A(问题到答案)

给定:图片 + 问题要求:从4个选项中选择正确答案图片:办公室场景,一个人在电脑前打哈欠问题:这个人为什么打哈欠?选项:A. 因为很困B. 因为很饿C. 因为在表演D. 因为在运动正确答案:A

任务2:QA→R(问题+答案到推理)

给定:图片 + 问题 + 正确答案要求:从4个解释中选择最合理的承接上例,给定正确答案A后:问题:为什么选择"因为很困"?解释选项:R1. 可以看出他在办公室环境中,时间应该是工作时间,打哈欠通常表示困倦,可能是睡眠不足导致的。R2. 他看起来很放松,应该是在休息。R3. 办公室的灯光很亮,会让人感到困倦。R4. 打哈欠是因为空气不好。正确解释:R1

任务3:Q→AR(问题到答案和推理)

端到端任务:给定:图片 + 问题要求:同时预测答案和解释,两者都必须正确这是最困难的任务,因为需要:- 正确理解图像内容- 准确回答问题- 生成合理的解释- 保证答案和解释的一致性

VCR需要构建多步推理链、运用常识知识并生成可解释答案,核心挑战是让机器推理过程符合人类逻辑。主流解决方案是基于知识图谱的增强推理。

外部知识集成:ConceptNet:概念关系图谱"疲惫" → "打哈欠" → "需要休息"知识检索:给定图像和问题 → 提取关键概念 → 检索相关知识"办公室" + "打哈欠" → 检索工作相关的疲惫知识知识融合:视觉推理 + 知识推理 → 综合判断图像证据:观察到打哈欠动作知识证据:工作时间打哈欠通常因为困倦结合推理:因为工作疲劳所以打哈欠

多模态推理代表了AI从简单的"看图识物"向复杂的"看图思考"的关键跃升。VQA让AI学会了准确回答图像相关问题,而VCR更进一步要求AI提供推理解释,真正模拟人类的思维过程。

从早期的特征拼接到注意力机制,再到Transformer统一建模,技术演进的每一步都在缩小AI与人类认知能力的差距。

当前基于知识图谱的增强推理方案虽然取得了显著进展,但要实现真正的机器常识推理,仍需要在多步推理链构建、大规模常识知识获取和可解释性生成等方面持续突破。未来的多模态AI将不仅能看懂世界,更能像人类一样理解和解释世界。

日拱一卒,让大脑不断构建深度学习和大模型的神经网络连接。

☟☟☟

☞人工智能产业链联盟筹备组征集公告☜

☝

精选报告推荐:

11份清华大学的DeepSeek教程,全都给你打包好了,直接领取:

【清华第四版】DeepSeek+DeepResearch让科研像聊天一样简单?

【清华第七版】文科生零基础AI编程:快速提升想象力和实操能力

【清华第十一版】2025AI赋能教育:高考志愿填报工具使用指南

10份北京大学的DeepSeek教程

【北京大学第五版】Deepseek应用场景中需要关注的十个安全问题和防范措施

【北京大学第九版】AI+Agent与Agentic+AI的原理和应用洞察与未来展望

【北京大学第十版】DeepSeek在教育和学术领域的应用场景与案例(上中下合集)

8份浙江大学的DeepSeek专题系列教程

浙江大学DeepSeek专题系列一--吴飞:DeepSeek-回望AI三大主义与加强通识教育

浙江大学DeepSeek专题系列二--陈文智:Chatting or Acting-DeepSeek的突破边界与浙大先生的未来图景

浙江大学DeepSeek专题系列三--孙凌云:DeepSeek:智能时代的全面到来和人机协作的新常态

浙江大学DeepSeek专题系列四--王则可:DeepSeek模型优势:算力、成本角度解读

浙江大学DeepSeek专题系列五--陈静远:语言解码双生花:人类经验与AI算法的镜像之旅

浙江大学DeepSeek专题系列六--吴超:走向数字社会:从Deepseek到群体智慧

浙江大学DeepSeek专题系列七--朱朝阳:DeepSeek之火,可以燎原

浙江大学DeepSeek专题系列八--陈建海:DeepSeek的本地化部署与AI通识教育之未来

4份51CTO的《DeepSeek入门宝典》

51CTO:《DeepSeek入门宝典》:第1册-技术解析篇

51CTO:《DeepSeek入门宝典》:第2册-开发实战篇

51CTO:《DeepSeek入门宝典》:第3册-行业应用篇

51CTO:《DeepSeek入门宝典》:第4册-个人使用篇

5份厦门大学的DeepSeek教程

【厦门大学第一版】DeepSeek大模型概念、技术与应用实践

【厦门大学第五版】DeepSeek等大模型工具使用手册-实战篇

10份浙江大学的DeepSeek公开课第二季专题系列教程

【精选报告】浙江大学公开课第二季:《DeepSeek技术溯源及前沿探索》(附PDF下载)

【精选报告】浙江大学公开课第二季:2025从大模型、智能体到复杂AI应用系统的构建——以产业大脑为例(附PDF下载)

【精选报告】浙江大学公开课第二季:智能金融——AI驱动的金融变革(附PDF下载)

【精选报告】浙江大学公开课第二季:人工智能重塑科学与工程研究(附PDF下载)

【精选报告】浙江大学公开课第二季:生成式人工智能赋能智慧司法及相关思考(附PDF下载)

【精选报告】浙江大学公开课第二季:AI大模型如何破局传统医疗(附PDF下载)

【精选报告】浙江大学公开课第二季:2025年大模型:从单词接龙到行业落地报告(附PDF下载)

【精选报告】浙江大学公开课第二季:2025大小模型端云协同赋能人机交互报告(附PDF下载)

【精选报告】浙江大学公开课第二季:DeepSeek时代:让AI更懂中国文化的美与善(附PDF下载)

【精选报告】浙江大学公开课第二季:智能音乐生成:理解·反馈·融合(附PDF下载)

6份浙江大学的DeepSeek公开课第三季专题系列教程

【精选报告】浙江大学公开课第三季:走进海洋人工智能的未来(附PDF下载)

【精选报告】浙江大学公开课第三季:当艺术遇见AI:科艺融合的新探索(附PDF下载)

【精选报告】浙江大学公开课第三季:AI+BME,迈向智慧医疗健康——浙大的探索与实践(附PDF下载)

【精选报告】浙江大学公开课第三季:心理学与人工智能(附PDF下载)

【AI加油站】第八部:《模式识别(第四版)-模式识别与机器学习》(附下载)

人工智能产业链联盟高端社区

一次性说清楚DeepSeek,史上最全(建议收藏)

DeepSeek一分钟做一份PPT

用DeepSeek写爆款文章?自媒体人必看指南

【5分钟解锁DeepSeek王炸攻略】顶级AI玩法,解锁办公+创作新境界!

【中国风动漫】《雾山五行》大火,却很少人知道它的前身《岁城璃心》一个拿着十米大刀的男主夭折!

免责声明:部分文章和信息来源于互联网,不代表本订阅号赞同其观点和对其真实性负责。如转载内容涉及版权等问题,请立即与小编联系(微信号:913572853),我们将迅速采取适当的措施。本订阅号原创内容,转载需授权,并注明作者和出处。如需投稿请与小助理联系(微信号:AI480908961)

编辑:Zero