本文由 Intern-S1 等 AI 生成,机智流编辑部校对

(1) SciReasoner: Laying the Scientific Reasoning Ground Across Disciplines

论文简介:

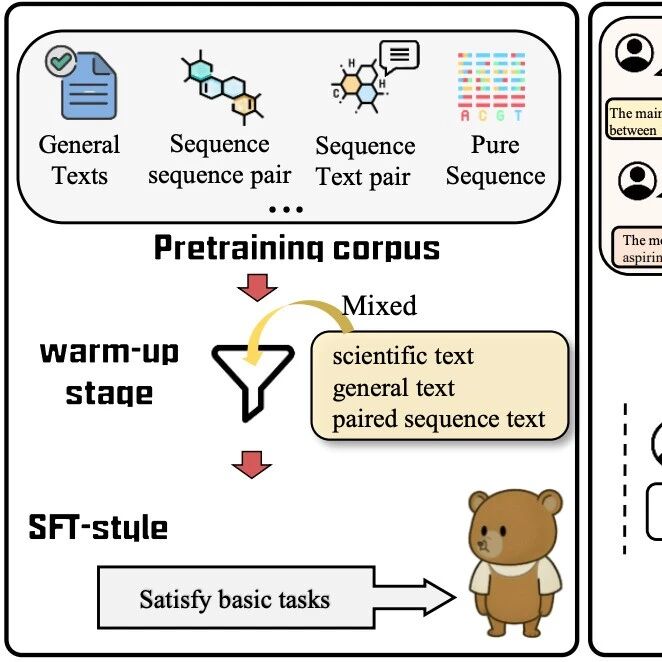

由上海人工智能实验室等机构提出的SciReasoner是一种科学推理基础模型,该工作通过将自然语言与异构科学表示对齐,构建了覆盖103个跨学科任务的统一框架。模型基于2060亿token的多模态语料库预训练,包含科学文本、纯序列及序列-文本对,并通过指令微调和强化学习优化,支持科学翻译、文本提取、属性预测、属性分类及序列生成五大能力家族。其核心贡献包括:自适应推理机制,通过区分"即时"与"思考"任务动态分配推理资源;创新的任务分组奖励策略,将科学奖励分为距离、匹配和工具验证三类以提升学习效率;以及科学奖励软化技术,将二元信号转换为连续值以稳定训练。实验表明,SciReasoner-8B在分子描述、蛋白质功能翻译等任务中ROUGE-L得分达0.98,在材料属性预测中MAE较基线降低40%,并在101个任务中位列前二,显著提升了跨领域泛化能力和科学推理的保真度。该模型通过任务感知的tokenization和强化学习框架,实现了从科学数据到可解释推理的端到端建模,为多学科研究提供了统一的AI基础设施。

论文来源:hf

Hugging Face 投票数:63

论文链接:

https://hf.co/papers/2509.21320

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21320

(2) MMR1: Enhancing Multimodal Reasoning with Variance-Aware Sampling and Open Resources

论文简介:

由新加坡南洋理工大学、阿里巴巴达摩院和新加坡科技设计大学等机构提出了MMR1,该工作通过方差感知采样(VAS)和开放资源增强多模态推理能力。研究指出当前多模态推理模型面临两个核心挑战:缺乏高质量长链式推理数据以及强化学习(RL)后训练的梯度消失问题。针对GRPO框架在低奖励方差下优势坍塌的缺陷,提出VAS方法通过方差促进得分(VPS)动态选择数据,该得分结合结果方差得分(OVS)和轨迹多样性得分(TDS)双维度评估,前者平衡正确/错误响应比例以最大化期望方差,后者通过序列多样性确保方差下界。理论证明奖励方差是策略梯度幅度的下界,VAS通过提升方差实现更稳定的优化。

研究团队构建了160万条多领域长链式推理数据集(涵盖数学、科学、图表等5大类)和1.5万条RL训练数据(包含数学与逻辑推理任务),所有数据经过GPT-4o验证确保质量。实验显示MMR1-7B模型在MathVerse、MathVista等基准上平均得分达58.4%,超越同规模通用模型(如Qwen2.5-VL-7B的55.0%)和推理专用模型(如VL-Cogito-7B的58.2%)。消融实验表明VAS在混合比例λ=0.5时效果最佳,相比纯随机采样梯度范数提升23%,验证集准确率提升15%。研究还开源了从3B到7B的多模态推理模型系列,提供可复现的训练代码库,为社区建立标准化基准。

论文来源:hf

Hugging Face 投票数:61

论文链接:

https://hf.co/papers/2509.21268

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21268

(3) VCRL: Variance-based Curriculum Reinforcement Learning for Large Language Models

论文简介:

由阿里巴巴团队提出的VCRL(Variance-based Curriculum Reinforcement Learning)针对大语言模型(LLM)在数学推理任务中的强化学习训练问题,提出了一种基于组奖励方差的动态课程学习框架。该方法通过分析现有基于rollout的强化学习方法(如GRPO、DAPO、GSPO)未考虑样本难度与模型能力匹配的问题,发现组奖励方差能够有效反映样本对当前模型的难度水平:样本过易或过难时方差较低,而中等难度样本(模型处于关键学习阶段)的方差最高。VCRL通过方差动态采样筛选高价值样本,并结合记忆库回放机制提升训练效率和稳定性。实验在AIME-2024/2025、MATH500等五个数学基准上验证了VCRL的优势,结果显示其在Qwen3-4B和Qwen3-8B模型上分别将平均性能从基线的26.68和32.96提升至49.43和57.76,显著优于现有方法。理论分析表明VCRL的梯度更新更稳定,训练动态曲线也显示其在早期收敛速度和最终性能上的双重优势。该方法通过动态控制训练难度,为LLM的高效强化学习提供了新思路。

论文来源:hf

Hugging Face 投票数:55

论文链接:

https://hf.co/papers/2509.19803

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.19803

(4) Tree Search for LLM Agent Reinforcement Learning

论文简介:

由厦门大学、阿里巴巴和南方科技大学等机构提出了Tree-GRPO,该工作提出了一种基于树搜索的分组代理强化学习方法,通过将每个树节点设计为完整的代理交互步骤,实现共享前缀的rollout采样,在固定token/工具调用预算下提升采样效率。该方法利用树结构构建基于结果奖励的逐步骤过程监督信号,通过树内和树间分组相对优势估计,将轨迹级奖励转化为细粒度的过程级偏好学习目标。理论分析表明树内分组相对优势优化等价于逐步骤直接偏好学习。实验在11个数据集和3类QA任务中验证了树基RL在多轮代理任务中的有效性,相比链式RL方法在同等预算下提升显著,尤其在低资源模型(如Qwen2.5-1.5b)上实现69%的性能提升,同时仅需四分之一的rollout预算即可超越链式方法。

论文来源:hf

Hugging Face 投票数:50

论文链接:

https://hf.co/papers/2509.21240

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21240

(5) Seedream 4.0: Toward Next-generation Multimodal Image Generation

论文简介:

由字节跳动等机构提出了Seedream 4.0,该工作构建了一个高效且高性能的多模态图像生成系统,首次在单一框架内统一实现文本到图像合成、图像编辑和多图像组合功能。研究团队开发了具有高压缩比的扩散Transformer与VAE架构,通过减少图像token数量实现训练与推理效率的大幅提升,支持原生高分辨率(1K-4K)图像的快速生成。模型基于数十亿文本-图像对进行预训练,覆盖多样化的分类体系与知识型概念,并通过优化数据收集策略和训练方法确保大规模稳定训练。创新性地引入多模态后训练机制,将文本生成与图像编辑任务通过因果扩散框架联合优化,结合持续训练、监督微调、人类反馈强化学习及提示工程等多阶段策略。推理加速方面采用对抗蒸馏、分布匹配、量化技术及推测性解码,实现2K图像生成仅需1.4秒(无LLM/VLM作为PE模型)。综合评估显示Seedream 4.0在文本到图像和多模态图像编辑任务中均达到SOTA水平,在精确图像编辑、上下文推理、多图像参考与输出等复杂任务中表现尤为突出,可生成结构化专业内容(如图表公式),成功将传统生成系统拓展为交互式创意工具。该模型已集成于火山引擎等平台,提供4K分辨率支持和自适应画幅调整功能,为内容创作与专业应用提供高效解决方案。

论文来源:hf

Hugging Face 投票数:37

论文链接:

https://hf.co/papers/2509.20427

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.20427

(6) Hunyuan3D-Omni: A Unified Framework for Controllable Generation of 3D Assets

论文简介:

由腾讯Hunyuan3D团队提出了Hunyuan3D-Omni,该工作构建了一个统一的3D资产可控生成框架,在Hunyuan3D 2.1基础上实现了点云、体素、边界框和骨骼姿态等多模态条件的融合控制。该框架通过设计统一的控制编码器,将不同条件统一转换为点云表示并提取特征,与图像特征联合输入扩散模型,实现几何、拓扑和姿态的精细控制。创新性地采用渐进式训练策略,动态调整不同条件的采样权重,优先学习高难度的骨骼姿态条件,提升模型对多模态信号的融合能力。实验表明,该方法有效解决单图像生成中的几何失真问题,支持姿态标准化、比例调节、细节增强等控制功能,生成结果在几何准确性、细节丰富度和姿态对齐度上显著优于基线模型,为3D内容生产提供了更灵活的可控生成方案。

论文来源:hf

Hugging Face 投票数:22

论文链接:

https://hf.co/papers/2509.21245

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21245

(7) AutoIntent: AutoML for Text Classification

论文简介:

由莫斯科高等研究院、莫斯科国立大学等机构提出了AutoIntent,该工作设计了一种面向文本分类任务的自动化机器学习工具。AutoIntent通过端到端自动化流程实现了嵌入模型选择、分类器优化和决策阈值调整的全栈式优化,采用模块化设计并提供类似sklearn的接口,支持多标签分类和离群检测功能。框架创新性地采用分层优化策略,通过模块级(嵌入-评分-决策)和模型级(超参数搜索)的双重优化机制,在保持高性能的同时显著降低资源消耗。实验表明,其在banking77等5个基准数据集上超越H2O、AutoGluon等主流工具,尤其在离群检测任务中F1值达到76.79%(对比AutoGluon的48.53%),在少样本场景下通过邻域分类方法展现出更强鲁棒性。框架支持从零样本到深度学习的多样化模型选择,并通过预计算嵌入实现CPU部署可行性,其模块化架构允许独立优化各组件,为NLP开发者提供了兼顾效果与效率的AutoML解决方案。

论文来源:hf

Hugging Face 投票数:21

论文链接:

https://hf.co/papers/2509.21138

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21138

(8) TrustJudge: Inconsistencies of LLM-as-a-Judge and How to Alleviate Them

论文简介:

由北京大学、新加坡国立大学、东京理科大学、南京大学、谷歌DeepMind、西湖大学、东南大学等机构提出了TrustJudge,该工作提出了TrustJudge,一种概率评估框架,通过分布敏感评分和可能性感知聚合解决LLM作为评估者时的评分比较和成对传递性不一致问题,显著降低不一致性并保持评估准确性。研究发现,现有LLM评估框架存在两类根本性不一致:评分比较不一致(低分响应在成对比较中反超高分响应)和成对传递性不一致(出现循环偏好链或等价矛盾)。这些问题源于离散评分系统的信息损失和成对比较中模糊平局判断。TrustJudge通过两项创新解决:分布敏感评分将离散评分概率转化为连续期望值,保留判断熵实现更精确评分;可能性感知聚合通过双向偏好概率或困惑度解决传递性违反。理论分析证明离散评分存在信息损失,而TrustJudge的期望评分能区分不同熵分布。实验显示,使用Llama-3.1-70B-Instruct作为评估模型时,TrustJudge将评分比较不一致率从23.32%降至14.89%(降幅8.43%),成对传递性不一致率从15.22%降至4.40%(降幅10.82%),同时评估准确率提升1.19-6.85%。该框架在Llama、GPT、Qwen、Gemma等多架构模型(3B-70B参数)上均有效,且无需额外训练或人工标注。通过增加评分粒度(5→100分)和概率归一化,TrustJudge显著降低冲突率,其双向聚合策略使中等规模模型超越大型基线模型的传递性表现。研究还发现数学强化训练可能导致判断能力灾难性遗忘,但TrustJudge仍能有效提升评估质量。该工作为LLM评估框架提供了首个系统性分析和实用解决方案,推动更可靠的自动化评估范式发展。

论文来源:hf

Hugging Face 投票数:15

论文链接:

https://hf.co/papers/2509.21117

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21117

(9) CE-GPPO: Controlling Entropy via Gradient-Preserving Clipping Policy Optimization in Reinforcement Learning

论文简介:

由快手团队提出的CE-GPPO方法,通过梯度保留剪裁策略优化强化学习中的策略熵控制问题。该工作发现传统PPO算法因剪裁低概率token梯度导致熵不稳定现象,表现为熵崩溃或爆炸,核心在于剪裁区间外的低概率token(PA&LP和NA&LP)对探索-利用平衡的关键作用。CE-GPPO创新性地引入停止梯度操作和可调系数β₁/β₂,在保留PPO训练稳定性的同时,有控制地回传剪裁区间外token的梯度:β₁放大NA&LP梯度促进利用,β₂放大PA&LP梯度增强探索。理论证明显示该方法在保持策略更新稳定性的同时,通过协方差调控实现熵动态控制。实验在数学推理任务上验证了CE-GPPO的有效性,相比GRPO、DAPO等基线方法,在1.5B和7B参数模型上分别提升2.5和3.0个平均分,尤其在AIME25等复杂任务上表现突出。分析表明,该方法通过动态调节β参数,在训练早期维持高熵促进探索,后期适度收敛提升性能,解决了传统熵正则化敏感性和DAPO过探索等问题,为大语言模型的强化学习优化提供了新的理论视角和实践方案。

论文来源:hf

Hugging Face 投票数:13

论文链接:

https://hf.co/papers/2509.20712

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.20712

(10) Does FLUX Already Know How to Perform Physically Plausible Image Composition?

论文简介:

由南洋理工大学和南京大学等机构提出了SHINE框架,该工作针对图像合成任务中复杂光照和高分辨率场景下的物理一致性问题,提出了一种无需训练的解决方案。现有方法在处理阴影、反射等复杂光照条件时存在局限,且受限于固定分辨率输入,而SHINE通过挖掘预训练文本生成图像模型(如FLUX)中的物理和分辨率先验,实现了高质量图像合成。核心创新包括:1)流形引导锚点损失(MSA),利用预训练适配器引导噪声潜变量忠实表征目标主体,同时保持背景结构完整性;2)降级抑制引导(DSG),通过模糊注意力机制中的查询矩阵构建负向速度场,避免低质量生成;3)自适应背景融合(ABB),结合跨注意力掩码优化边界过渡。研究团队还构建了包含300组多分辨率、复杂光照场景的基准数据集ComplexCompo。实验表明,SHINE在DreamEditBench和ComplexCompo上均超越现有方法,在身份一致性(如DreamSim↑2.7%)、图像质量(ImageReward↑3.6%)等指标表现突出,尤其在低光、反射等复杂场景中优势显著。该方法通过非训练范式有效释放了基础模型的物理先验能力,为图像合成提供了新思路。

论文来源:hf

Hugging Face 投票数:8

论文链接:

https://hf.co/papers/2509.21278

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21278

(11) Recon-Act: A Self-Evolving Multi-Agent Browser-Use System via Web Reconnaissance, Tool Generation, and Task Execution

论文简介:

由Inclusion AI等机构提出了Recon-Act,该工作针对多轮长轨迹网页任务中动作序列混乱和过度试错问题,构建了基于侦察-行动双团队协作的自我演化多智能体系统。系统包含侦察团队(分析师和编码器)与行动团队(主控、工具管理器和执行器),通过对比正误轨迹提炼通用工具(提示或规则代码),建立数据-工具-行动-反馈的闭环进化流程。侦察团队在训练阶段分析失败案例生成工具,行动团队在推理阶段调用工具提升任务完成效率。在VisualWebArena数据集上实现36.48%的成功率,其中购物领域达39.27%,超越现有方法2.74-6.97个百分点。该框架通过工具注册机制实现跨任务泛化,工具管理器采用条件逻辑合并功能分支,主控代理基于上下文选择工具模式(提示/决策),形成可扩展的浏览器交互解决方案。目前系统处于第三阶段(Level 3),分析师与工具管理器仍需人工介入,其余组件由VLM驱动,为复杂网页任务的自主解决提供了新范式。

论文来源:hf

Hugging Face 投票数:7

论文链接:

https://hf.co/papers/2509.21072

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21072

(12) CHARM: Control-point-based 3D Anime Hairstyle Auto-Regressive Modeling

论文简介:

由清华大学和腾讯AI平台部等机构提出了CHARM,该工作提出了一种基于控制点的3D动漫发型参数化表示方法及自回归生成框架。传统发型建模方法多针对真实感发型,而动漫发型具有高度风格化、分段结构化的几何特征,现有技术难以有效处理。CHARM通过引入紧凑的可逆控制点参数化表示,用序列控制点(每个点仅含三维位置、宽度、厚度五个参数)表达发型结构,既支持艺术家友好设计又适配数据驱动生成。在此基础上构建的自回归生成框架将动漫发型视为"发型语言",通过变压器网络捕捉局部几何与全局拓扑关系,实现从输入图像或点云生成高保真动漫发型。研究团队还构建了包含37K个高质量动漫发型的AnimeHair数据集,每个发型包含分离的发片和处理后的网格数据。实验表明CHARM在重建精度和生成质量上均超越现有方法,其参数化表示在保留原始数据模式的同时将网格token压缩至原规模的2%,为动漫发型建模提供了兼具表现力与可扩展性的解决方案。

论文来源:hf

Hugging Face 投票数:7

论文链接:

https://hf.co/papers/2509.21114

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21114

(13) V-GameGym: Visual Game Generation for Code Large Language Models

论文简介:

由上海人工智能实验室等机构提出了V-GameGym,该工作构建了一个面向代码大语言模型(code LLMs)的视觉游戏生成基准测试框架,旨在解决当前代码生成任务与实际游戏开发需求之间的能力断层问题。研究团队通过从开源代码库中筛选出2,219个高质量Pygame项目,采用基于聚类的筛选方法确保数据集的多样性和结构完整性,形成涵盖100个主题簇的测试集。核心创新点包括:1)提出多模态评估体系,通过LLM驱动的自动化流水线实现代码意图分析、交互程序转换为自包含演示、沙箱环境执行验证及需求生成;2)构建包含代码、静态截图和动态视频的三维度评分机制,量化评估模型在视觉美学、交互流畅性等游戏开发关键指标上的表现;3)基于8名研究生的人工验证和UI沙箱测试,确保数据集的执行可靠性和质量基准。实验部分对70个主流模型(含GPT-5、Claude-4等闭源模型及Qwen3、DeepSeek等开源模型)进行系统评测,发现当前模型在代码生成(平均得分70-97)与视觉评估(图像/视频得分普遍低于25)间存在显著能力失衡,且模型规模与任务解决数量呈现对数增长规律(M=A*log(N)+B)。研究揭示了多模态游戏开发对模型推理能力的更高要求,为推动AI辅助游戏开发提供了可量化的评估基准和改进方向。

论文来源:hf

Hugging Face 投票数:6

论文链接:

https://hf.co/papers/2509.20136

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.20136

(14) BESPOKE: Benchmark for Search-Augmented Large Language Model Personalization via Diagnostic Feedback

论文简介:

由延世大学等机构提出的BESPOKE基准,通过收集真实用户历史记录和诊断反馈,系统评估搜索增强型大语言模型的个性化能力。该工作构建了包含2,870个用户会话的多模态数据集,涵盖搜索历史和聊天记录,并通过三周深度标注获得150个用户查询及其对应的黄金信息需求。BESPOKE的核心创新在于引入细粒度评估框架,通过四维指标(需求对齐、内容深度、语调、解释风格)结合评分与自然语言反馈,实现对个性化质量的诊断性评估。实验表明,用户上下文构建方式显著影响个性化效果,查询感知的动态上下文比静态档案提升平均得分5.8分,而选择性历史检索比全历史检索提升3.9分。研究还发现,当前模型在需求推断和信息深度方面仍存在显著不足,平均召回率仅23.5%,远低于语调(82.3%)和风格(68.2%)指标。该基准为个性化搜索增强系统提供了可解释的评估范式,揭示了用户历史建模与信息检索质量对个性化效果的双重影响,为后续研究指明了方向。

论文来源:hf

Hugging Face 投票数:5

论文链接:

https://hf.co/papers/2509.21106

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21106

(15) Residual Off-Policy RL for Finetuning Behavior Cloning Policies

论文简介:

由 Amazon FAR、斯坦福大学、卡内基梅隆大学和 UC 伯克利的研究人员提出了 ResFiT(Residual Fine-Tuning),该工作通过残差学习框架结合行为克隆(BC)与强化学习(RL)的优势,利用离线策略RL在冻结的BC策略基础上学习轻量级残差修正,显著提升了高自由度机器人系统在稀疏奖励和长时任务中的操作性能。方法核心在于将BC策略作为固定基策略,通过离线策略RL学习每一步的动作残差,既保留了BC策略的长时推理能力,又通过残差修正解决RL直接优化大规模策略的不稳定性问题。研究者通过关键设计(如高更新数据比、n步回报、层归一化等)实现样本高效学习,并在模拟和真实世界任务中验证了方法有效性。在模拟实验中,ResFiT在单臂和双臂协调任务中均表现出近完美成功率,且样本效率较传统残差RL提升200倍。在真实世界实验中,该方法首次成功实现了在具有29自由度轮式人形机器人上的双五指机械手RL训练,通过稀疏二值奖励在15-76分钟内将操作成功率从14%-23%提升至64%。研究指出,该方法的局限性在于行为受限于基策略的约束,未来可通过动态调整基策略约束或任务特定残差蒸馏进一步优化。该工作为高自由度机器人在真实环境中的高效策略优化提供了重要实践路径。

论文来源:hf

Hugging Face 投票数:5

论文链接:

https://hf.co/papers/2509.19301

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.19301

(16) Interactive Recommendation Agent with Active User Commands

论文简介:

由中国人民大学、中国科学院大学和阿里巴巴提出了Interactive Recommendation Feed(IRF)范式,该工作通过引入自然语言命令实现用户对推荐系统的主动控制,解决了传统推荐系统依赖被动反馈导致的意图误判问题。研究团队开发了RecBot双代理框架,其中Parser Agent将用户指令解析为结构化偏好,Planner Agent通过动态工具链调整推荐策略,结合模拟增强的知识蒸馏实现高效部署。实验表明该方法在离线测试中显著提升Recall@10等指标,在电商平台三个月的AB测试中,系统使用户负反馈率降低0.71%,商品类目多样性提升1.44%,同时带动加购率和GMV分别增长1.28%和1.40%。该框架创新性地将大语言模型的语义理解能力与推荐系统结合,通过动态记忆整合机制处理多轮交互,工具链架构支持硬约束过滤、语义匹配、负反馈衰减等模块灵活组合,成功实现从用户自然语言到推荐策略的实时映射,为交互式推荐系统提供了可扩展的技术方案。

论文来源:hf

Hugging Face 投票数:5

论文链接:

https://hf.co/papers/2509.21317

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21317

(17) Thinking Augmented Pre-training

论文简介:

由微软研究院等机构提出了Thinking Augmented Pre-Training(TPT),该工作通过自动生成思考轨迹来增强预训练数据,显著提升大语言模型的数据效率和推理能力。研究发现,某些高价值token因涉及复杂推理难以被模型直接学习,TPT通过将原始文本与由开源大模型生成的深度思考过程拼接,将单步预测转化为多步推理学习。实验表明,该方法使预训练数据效率提升3倍,3B参数模型在数学推理基准上性能提升超10%。在100B tokens的训练规模下,TPT-8B模型在数学推理任务中超越了训练数据量150倍的LLaMA-3.1-8B模型,且在代码生成、科学推理等任务中均表现优异。分析显示,思考轨迹会自然延长高价值数据的训练时长,形成动态计算资源分配机制,这种数据增强方式与人工标注相比成本更低且更易扩展。在从头预训练、数据受限训练及中段训练等不同场景下,TPT均展现出显著优势,为提升大模型学习效率提供了新范式。

论文来源:hf

Hugging Face 投票数:5

论文链接:

https://hf.co/papers/2509.20186

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.20186

(18) Understanding the Thinking Process of Reasoning Models: A Perspective from Schoenfeld's Episode Theory

论文简介:

由马里兰大学等机构提出了基于Schoenfeld剧集理论的推理模型思维过程分析框架,该工作首次将人类数学问题解决的认知理论应用于大型推理模型(LRMs)的推理轨迹解析。研究者通过7个认知标签(如计划、执行、验证)对模型生成的数学解题过程进行细粒度标注,构建了首个包含38个数学问题、915个段落和3087个句子的公开标注数据集,并开发了详细的标注指南。实验表明模型推理状态转换与人类认知模式高度吻合,如计划-执行、探索-分析等状态间存在强关联性。研究还对比了GPT-4.1、Gemini等模型在零样本标注任务中的表现,发现结合标注指南的提示方法可使GPT-4.1达到80.5%的准确率。该工作为理解机器推理提供了认知科学视角的分析工具,通过公开的标注协议和数据集推动可解释AI研究,同时揭示了当前自动标注方法在验证-执行等状态区分上的局限性,为后续开发更精准的推理过程分析方法奠定了基础。

论文来源:hf

Hugging Face 投票数:4

论文链接:

https://hf.co/papers/2509.14662

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.14662

(19) SD3.5-Flash: Distribution-Guided Distillation of Generative Flows

论文简介:

由 Stability AI 等机构提出了 SD3.5-Flash,该工作通过分布引导的生成式流模型蒸馏技术实现消费级设备上的高质量图像生成。研究团队针对现有扩散模型计算成本高、部署困难的问题,提出两项核心创新:通过"时间步共享"(timestep sharing)减少梯度噪声,以及"分步微调"(split-timestep fine-tuning)提升提示词对齐能力。在方法层面,该框架采用轨迹引导预训练与分布匹配蒸馏结合的两阶段训练策略,通过共享学生模型轨迹的时间步信息稳定梯度更新,并设计分支训练后合并的策略平衡语义保真与生成质量。系统优化方面,通过文本编码器结构重组(移除T5-XXL)、量化(8-bit/6-bit)及CoreML加速,在保证生成质量的同时将显存占用从18GiB降至8GiB以下,实现从手机到高端显卡的全场景部署。实验显示,4步生成模型在保持0.58秒/1024px推理速度的同时,用户研究评分超越50步教师模型(SD3.5M),在Aesthetic Score和ImageReward等指标上提升10%-15%。特别在复杂提示词处理中,该方法在人体结构、多物体组合等场景的生成一致性显著优于SDXL-Lightning、NitroFusion等现有方案,验证了其在资源受限设备上实现高质量生成的有效性。

论文来源:hf

Hugging Face 投票数:4

论文链接:

https://hf.co/papers/2509.21318

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21318

(20) Quantized Visual Geometry Grounded Transformer

论文简介:

由中科院计算技术研究所、国科大、ETH Zurich、上海交大等机构提出了Quantized Visual Geometry Grounded Transformer(QuantVGGT),该工作针对Visual Geometry Grounded Transformer(VGGT)的量化难题,首次提出专用的后训练量化框架。研究发现VGGT存在两大量化瓶颈:数据无关的特殊标记(相机标记和注册标记)导致激活分布呈现重尾特性,多视角3D数据特性引发校准样本选择的不稳定性。为解决这些问题,团队创新性地提出双阶段平滑量化方案(Dual-Smoothed Fine-Grained Quantization),通过全局Hadamard旋转分散离群值、局部通道平滑均衡方差,并结合动态令牌粒度量化策略,有效降低量化误差。同时设计噪声过滤的多样化采样策略(Noise-Filtered Diverse Sampling),利用深层特征统计过滤异常值,并基于VGGT的帧间关系先验构建语义聚类,确保校准集的代表性和稳定性。实验表明,QuantVGGT在4位量化下实现3.7倍模型压缩和2.5倍推理加速,同时保持98%以上的原始精度,在Co3Dv2和DTU基准测试中均大幅超越现有量化方法,为资源受限场景下的3D重建模型部署提供了高效解决方案。

论文来源:hf

Hugging Face 投票数:4

论文链接:

https://hf.co/papers/2509.21302

PaperScope.ai 解读:

https://paperscope.ai/hf/2509.21302

-- 完 --