撰文:Marilyn

编辑:liuxjerry

据传,谷歌将要发布的大杀器Gemini 3,要把全模态,包括图像、视频、语言、声音,以及最夸张的,机器人控制,都集成在一个大模型里。

今天,谷歌公布了一个开胃小菜,Gemini Robotics 1.5,是这个方向上迈出的第一步。

他是两个机器人模型,并组成了一个具身Agent的架构

Gemini Robotics-ER 1.5:VLM模型,作为Agent高级大脑,具备具身推理能力,能理解环境,与人交互,制定动作执行计划。

Gemini Robotics 1.5:VLA模型,是一个Agent,动作执行者,负责把指令转化为精准的动作控制。

至于Gemini 3将来能把哪部分包含进去,目前尚未可知。

以下就是对这一最新进展的详细解读,包含架构概览、亮点分析以及两个模型实际效果,并分析了Google“降维打击式”的优势。

技术报告链接:https://storage.googleapis.com/deepmind-media/gemini-robotics/Gemini-Robotics-1-5-Tech-Report.pdf

具身Agent架构概览

Google推进了Gemini Robotics,它构建了一个“智能体”系统架构,由一个“指挥官”(Gemini Robotics-ER 1.5)和一个“行动者”(Gemini Robotics 1.5)组成。

顶层的Gemini Robotics-ER 1.5是指挥官,负责处理用户指令,制定高层次的规划,并将其分解成一个个简单的子任务,展现出较强的长思考和工具调用的能力。

VLA模型是行动者,接受指挥官的指令,但它在行动之前会先进行“思考”,并展示出它的思考过程,从而让机器人在执行和完成复杂任务时更加透明、可解释

在一个实验室里,桌子上放着三个垃圾桶:绿色、蓝色和黑色。旁边站着一位研究人员,身边的双臂机器人正等待指令。

研究人员开口对机器人说:“Hey ALOHA,你能根据我的位置,把这些东西分到正确的垃圾桶里吗?” 这时候,背后的“大脑”——Gemini Robotics-ER 1.5(具身推理模型)开始工作。它先调用思考功能(Thinking),再利用工具查询旧金山的垃圾分类规则(Tool use),最后生成一个清晰的行动计划(Planning):绿色桶放厨余,蓝色桶放可回收,黑色桶放垃圾。

接着,它把这些高层次的指令交给 Gemini Robotics 1.5(VLA模型)去执行。VLA 把“放进绿色桶”的抽象命令一步步拆解成动作:“伸出机械臂 → 抓住苹果皮 → 抬起 → 移向绿色桶 → 松开夹爪”。

最终,机器人就像一个懂规则、会思考的助手,把桌上的废物妥妥地放进了正确的桶里。

值得强调的是Google提出的是个Agent的框架,而不是单纯的VLA。技术报告还对比了仅仅用Gemini Robotics 1.5 Thinking,和用一个通用的语言模型 Gemini 2.5 Flash 做“大脑”,VLA 做手脚的Agent(Gemini 2.5 Flash + GR 1.5)与GR-ER 1.5 + GR 1.5的Agent模式的在八个非常有挑战的任务上的效果,GR-ER 1.5 + VLA表现出了较稳定的高分。Gemini 2.5 Flash + VLA表现时好时坏,因为 Flash 并不是为“具身推理”优化的。

在训练数据上,论文使用了多实体机器人数据,包括 ALOHA、双臂 Franka 和 Apollo 人形机器人上的数千个任务数据,以及公开可用的文本、图像和视频数据集。

在评估方法上,所有对比实验均通过 真实机器人上的 A/B/n 测试完成。这意味着在同一个机器人工作单元上交替测试所有模型,从而减少因不同机器人或环境条件差异带来的评估偏差。

团队在MuJoCo 仿真环境中进行了大规模实验。90% 以上的评测任务首先在仿真环境中完成,之后一部分关键性任务会被迁移到真实机器人中进行测试。这确保了实验结果的可靠性和可复现性。

在技术报告的附录中,Google也将完整的模型评价标准和方法呈现出来

核心亮点

这次进展的更新有三大亮点:

最先进的具身推理模型

现有VLM/LLM往往被诟病为不理解真实物理世界。为了解决这个问题,学界也想了许多权宜之计

但Google专门优化了VLM的具身推理能力。 顶层指挥官是一个专门用于“高阶思考”的 Gemini Robotics-ER 1.5 模型。它在视觉和空间理解、任务规划、进度评估等具身推理任务上,达到了新的SOTA(State-of-the-Art)。

跨形态学习能力

机器人有各种不同的形态:大小各异、感知能力不同、自由度也不一样,多数VLA模型的验证都在单一本体上完成论文中的 Gemini Robotics 1.5 模型,能够同时从 ALOHA 2、双臂 Franka 和 Apollo 人形机器人等多种不同形态的机器人数据中学习,让机器人能实现“零样本”技能迁移,也就是说,一个只在 ALOHA 机器人上训练过的技能,可以直接在 Apollo 人形机器人上使用,无需任何额外训练。

具身思考能力

传统的视觉-语言-行动(VLA)模型,通常是把指令或语言计划直接翻译成机器人的动作。Gemini Robotics 1.5 将“思考”机制引入到 VLA 模型中。机器人不再是“看到-行动”的简单模式,而是“看到-思考-行动”。在执行任务前,它会生成一段“内心独白”或“思考轨迹”,将复杂指令分解为一系列更简单、更具体的步骤。这种方式让机器人的行为变得可解释,也更容易调试和纠错。

当执行“按照颜色帮我分类衣物”这样的任务时,机器人会在不同层次上进行思考。

首先,它理解“按颜色分类”意味着要把白色衣物放进白色的桶里,把其他颜色放进黑色的桶里。

接着,它会推理出具体的步骤,比如“拿起那件红色毛衣并放进黑色桶”。

最后,它甚至会思考更细节的动作过程,比如“把毛衣移动到手边更近的位置,以便更容易抓起”。

这两个模型效果究竟如何?

Gemini Robotics ER 1.5

就像我们在视频数据学习的文章中说的,随着VLM对真实世界的理解加深,会非常有助于具身的发展。因为,在真实世界中,要让机器人真正具备智能,仅仅能“看懂”是不够的。它们必须掌握空间与时间推理、物理直觉、因果关系以及可供性等深层次知识。这种能力被称为具身推理(Embodied Reasoning, ER)。

Gemini Robotics的具身推理能力令人欣喜。

与其他前沿大模型相比,GR-ER 1.5 在“泛化能力”与“具身推理”两条维度上实现了突破。在15 个具身推理学术基准(如 BLINK、CV-Bench、RoboSpatial 等)上,它达到了当前最优水平;在通用性基准(如 MMMU、GPQA、Aider Polyglot)上,它依然保持与顶尖模型相当的综合表现。

复杂指向

“点”或者“指”,其实是人类在日常交流中一种极其高效而简洁的表达方式。相比于冗长的语言描述,一个手指的动作往往就能直观传达复杂的信息——比如“这个杯子左边的位置”、“桌上最小的那个螺丝”或者“把那本红色封面的书拿给我”。这种“指”的能力,本质上是把语义和空间直觉结合在一起,用最小的动作传递最大的理解。

GR-ER 1.5在复杂指向上做的很好

给定一张厨房场景图像,Gemini Robotics-ER 1.5 可以提供每个物体(或物体的一部分)的位置。这些信息可以与机器人的 3D 传感器相结合,确定物体在空间中的精确位置

请在图像中指向以下物品:洗洁精、碗架、水龙头、电饭煲、独角兽。

不仅如此,模型还可以告诉你不同点的状态,比如模型告诉你“绿色记号笔、棕色托盘、绿色笔记本、笔记本电脑(打开)、笔记本电脑(关闭)、眼镜盒(打开)、眼镜盒(关闭)”,这是一个结合了空间理解和状态估计的查询。

更进一步,模型还可以告诉你可供性的点或者目标位置以及机器人的运动轨迹应该是什么样的

Where should I put the coffee pod?

现在,我需要关闭咖啡机。

请绘制一条由 8 个点组成的轨迹,用来表示咖啡机盖子手柄的移动路径。

起始点为手柄位置。

坐标点采用 [Y, X] 格式,并归一化到 [0 - 1000] 的范围。

请输出所有点,包括轨迹点,格式如下:

[

{"point": [Y, X], "label": },

{"point": [Y, X], "label": },

...

]

在复杂指向的任务上,GR-ER 1.5超越了市面上的模型

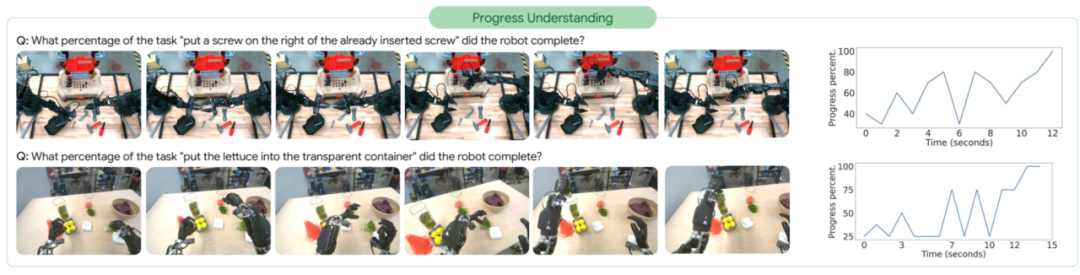

进度理解与成功检测

在真实世界的物理交互场景中,理解任务的时间进展对多种机器人应用至关重要。甚至某种程度上,GR-ER 1.5可以做得比人更好

比如它可以描述下面这个视频每个任务进度的详细情况和起止时间

请详细描述完成该任务的每一个步骤。按照时间戳拆解,并以 JSON 格式输出,包含以下键:

> start_timestamp":开始时间戳

> end_timestamp":结束时间戳

> description":步骤描述

模型回答如下:[

{

> start_timestamp": "00:02",

> end_timestamp": "00:13",

> description": "左机械臂从桌子上拿起绿色马克笔,并将其放入木制托盘中。"

},

{

> start_timestamp": "00:15",

> end_timestamp": "00:22",

> description": "左机械臂从桌子上拿起蓝色圆珠笔,并将其放入黑色金属网状笔筒中。"

},

{

> start_timestamp": "00:23",

> end_timestamp": "00:28",

> description": "右机械臂从桌子上拿起红色圆珠笔,并将其放入黑色金属网状笔筒中,完成整理书写工具的任务。"

}

]

ER 1.5模型还能实现一定理解和结果判断。比如可以问它拧螺丝/放蔬菜的任务的进度,模型可以输出随时间变化的完成百分比。

模型还可以通过多视角摄像头判断任务是否成功完成,比如问它“机器人是否成功将橙色饼干包从篮子移到蓝色碗旁边的货架上?” GR-ER 1.5 可以在多视角融合下更准确地检测任务是否成功。

在图中“折叠衣服”的例子中。视频帧被打乱顺序后,模型需要恢复正确的时间逻辑,并估计任务完成的百分比。结果表明,GR-ER 1.5 能够准确地将“乱序帧”重新排列成“正确顺序”。这类能力对于长时任务尤其关键,因为它让机器人不仅能看见动作,还能真正理解动作的前后因果关系。

为了看看模型在真实环境中表现如何,研究团队让一些早期用户把 GR-ER 1.5 用在他们自己的应用里,并收集了这些数据来做测试。这些任务比实验室里的更复杂

比如在实际场景里,货架管理往往杂乱无章:不同的包装、大小不一的物品、甚至部分遮挡。GR-ER 1.5 能够直接把这样的货架照片解析为一个结构化的 5×5 表格,再以 HTML 形式呈现,让原本混乱的场景瞬间条理清晰。这种能力对于仓储、零售和制造等行业的自动化巡检和库存管理,意味着机器人不仅能“看见”,还能“理解”和“输出”。

思考能力

就像长推理是LLM的buff一样,开放世界具身推理也如是

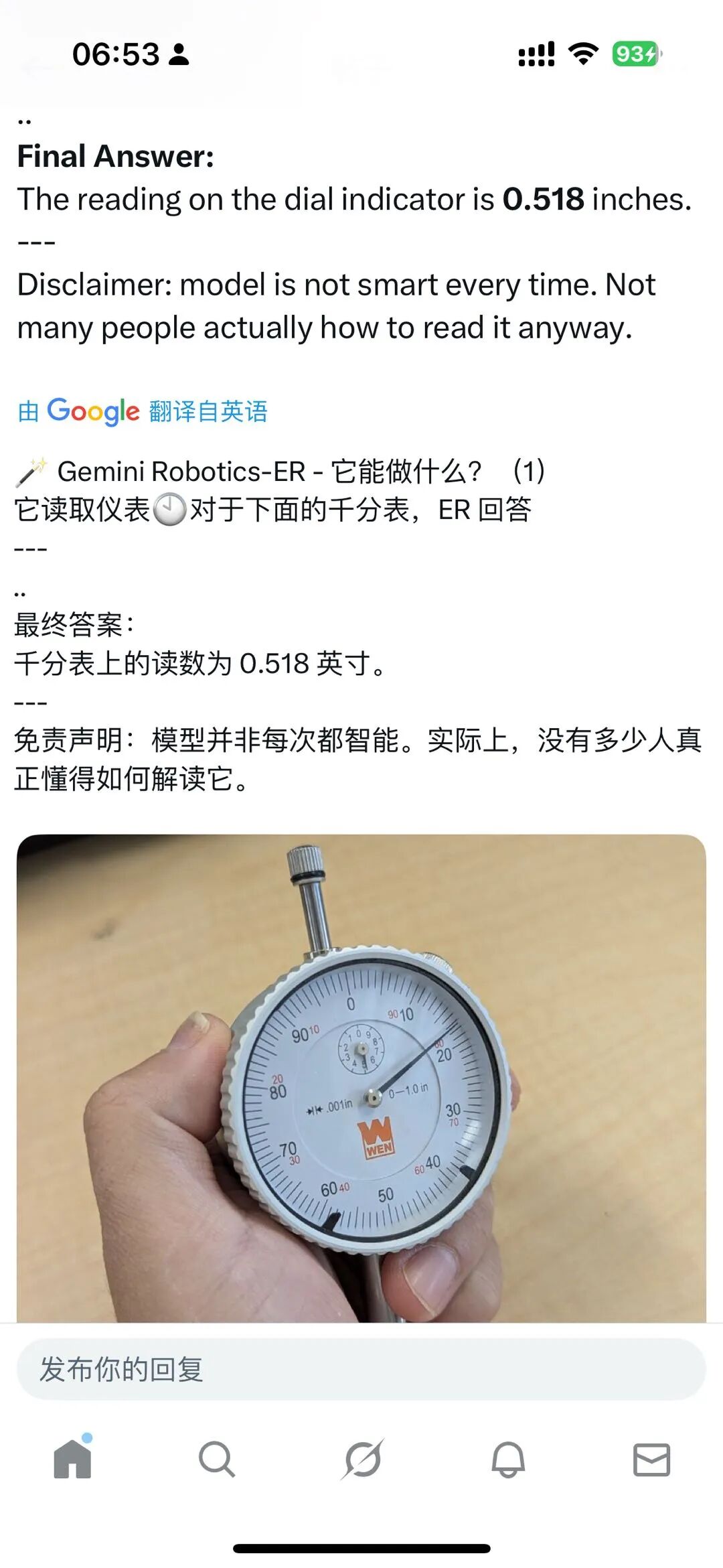

Google 的研究员 Peng Xu给了一个读表的例子,我们平常看到的“千分表”,其实并不是那么好读。表盘上有主刻度、副刻度、指针位置,稍有不慎就可能读错。甚至很多工厂里的新手工人,也需要经过专门培训才能准确使用。而在这个例子里,GR-ER 1.5 只需看一张图片,就能直接给出读数:0.518 英寸

怎么样让这个回复更精准,就是把思维链加上:模型不是一眼就报数,而是先识别量程与单位(表盘是华氏 °F),再锁定粗范围(指针在 50 与 80 之间),随后解析刻度结构(50→80 是 30°,被两条细刻度分成三等份,每份 10°),最后做精细插值与校验(指针正对 50 后的第一条细刻度=60°F,并与刻度标注、自洽规则相互印证)。这种逐层分解→量纲确认→区间细化→一致性检查的长思考流程,能系统地避免“看错单位”“数错刻度”“差一格”的常见错误,比起直接模式匹配式的快答更稳、更可靠,因此读出的数值的结果更可信。

团队发现,随着思维 token 预算的增加,GR-ER 1.5 的性能不断提升。不同任务所需的最佳思维长度取决于任务本身的类型和所需的推理深度,GR-ER 1.5 能够 自动调节思维 token 的数量,根据任务所需的推理深度动态分配。

同时,GR-ER 1.5 在具身推理任务上的推理时计算扩展性明显优于 Gemini 2.5 Flash,Gemini 2.5 Flash 的性能扩展曲线就相对平缓。而 GR-ER 1.5 随着“思维”增加而显著提升

Gemini Robotics 1.5

Gemini Robotics 1.5的模型架构在技术报告中并没有详细披露。如果通过Gemini Robotics的报告推测,大概率也是蒸馏了GR-ER 1.5的部分。它有以下几点惊艳的效果:

跨形态迁移的能力

一个最令人惊艳的突破是零样本技能迁移。在实验中,研究者只在 ALOHA 上提供了某些任务的数据,但GR 1.5 却能在 Apollo 拟人形机器人上直接执行这些任务,反之亦然。这意味着,机器人之间的“经验”可以被共享,不再需要为每一台新机器人重复从零开始训练

这项能力的核心在于Motion Transfer (MT) 机制。它像是一种“动作翻译器”,让不同形态的机器人在同一个“动作语义空间”中对齐,从而实现技能迁移。可惜谷歌对MT部分吝啬笔墨,没有详细展开

适应各种环境和任务

研究团队设计了一个覆盖 230 个任务的评测基准,涵盖了指令泛化、动作泛化、视觉泛化和任务泛化四大维度。结果显示,GR 1.5 在不同机器人上都显著超越了以往版本,不仅能应对背景、光照、物体变化等视觉干扰,还能理解不同语言风格的指令,甚至能把学到的动作迁移到新场景中去。

在不同机器人上的 GR 1.5 泛化能力拆解结果:GR 1.5 在表现上始终优于基线模型,并且在应对四种类型的变化时都更加高效。

团队还做了消融实验,证明这种泛化性一方面是来源于多本体数据,另外一方面是Motion Transfer(MT)训练方法显著放大了泛化的效果

思考再行动

另一大亮点是Thinking VLA。与传统模型直接把指令翻译成动作不同,GR 1.5 学会了在不同层次上“先思考,再行动”

比如他要把网球、水瓶放到白色的袋子里,便会有:把黄色网球用左手抓起的高层的意图,以及更低维度的左手向前,向右,轻微向上等更低维度的拆解。

当机器人成功抓起黄色网球后,它会自动将目标从“拾起黄色网球”切换为“把黄色网球放入白色袋子”。这说明模型对前一个子任务是否完成具备隐性认知,不需要额外的状态检测器来判断。

此外,Thinking VLA 还能从失败中再次尝试。例如,当水瓶从右手滑落并落到左手附近时,接下来的“思考轨迹”会立刻变为“用左手捡起水瓶”,从而有效地启动了一种自我修正的恢复机制。

这种 “思维链” 的引入,不仅显著提升了多步骤、长链条任务的成功率,还让机器人的行为变得更加透明和可解释

Google的优势:从VLM到VLA的全面能力

如果要说 Google 在具身智能领域区别于其他厂商的最大优势,那就是它同时具备 顶尖的 LLM/VLM 研发能力,又是 最早一批探索具身模型的团队。这种“双重积累”意味着它能够把语言-视觉模型(VLM)的进步,直接转化为对具身推理(Embodied Reasoning)的整体提升。

Gemini Robotics 1.5 模型家族由两部分组成:Gemini Robotics 1.5:一个视觉-语言-动作模型(VLA); Gemini Robotics 1.5-ER:一个具备最先进具身推理能力的视觉-语言模型(VLM)。 这两者可以结合在一起,形成一个强大的 智能体框架(agentic framework)。

对比来看,目前市面上大多数VLA模型仍然依赖于已有的开源方案,缺乏对VLM在具身推理本身的深度打磨。这在很大程度上限制了具身智能模型在空间推理、物体理解、多模态融合等核心环节的突破。而Google不仅优化了VLA的思考能力,还设计Agent框架让GR ER-1.5作为更上层的大脑。可以说,Google 是少数能够从底层 VLM 架构到具身智能整体系统全面打通的厂商

从整体来看,Gemini Robotics-ER 1.5 + Gemini Robotics 1.5 代表了 Google 在具身智能上的最新答案:一个 “会思考的大脑” 和一个 “能执行的身体”。通过 ER 1.5 的长思考、进度理解、复杂指向、多视角成功检测等能力,机器人不再只是“看见+执行”,而是进入了“理解+规划+行动”的新阶段。而 VLA 1.5 则让机器人在执行层面拥有跨形态迁移和思考能力

本次披露,还是一个Agent框架下的大脑与执行的联动。如果Gemini 3真的如传言所说,将不同模态融合到一个模型中,将机器人和大模型两个问题合二为一一起解决,那将一定会掀起不小的波澜。让我们拭目以待Gemini 3在这方面的进展和实际表现!!

碎碎念:我们最近开始建立读者群啦!如果您对具身智能感兴趣,欢迎添加好友(xingxing-lxy),备注“姓名+公司/机构/学校+入群”。

欢迎关注我们

欢迎与我们交流,加好友请注明来意,xingxing-lxy:)