本论文第一作者曹子昂,南洋理工大学博士二年级,研究方向是计算机视觉、3D AIGC 和具身智能。主要合作者为来自南洋理工大学陈昭熹和来自上海人工智能实验室的潘亮,通讯作者为南洋理工大学刘子纬教授。

论文链接:https://arxiv.org/abs/2507.12465

项目主页:hthttps://physx-3d.github.io/

GitHub 代码:https://github.com/ziangcao0312/PhysX

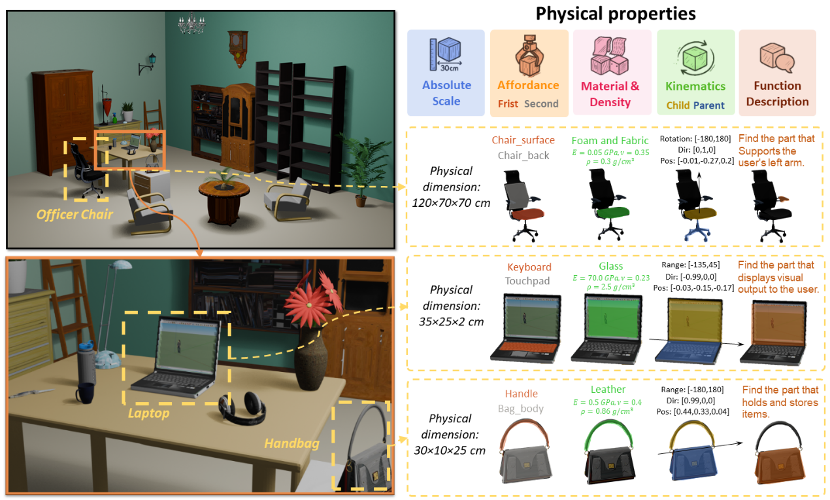

3D 生成正从纯虚拟走向物理真实,现有的 3D 生成方法主要侧重于几何结构与纹理信息,而忽略了基于物理属性的建模。为了填补当前包含物理属性 3D 数据集的关键空白,由南洋理工大学 - 商汤联合研究中心 S-Lab,及上海人工智能实验室合作提出了 PhysXNet —— 首个系统性标注的物理基础 3D 数据集,涵盖五个核心维度:物理尺度、材料、可供性、运动学信息、以及文本描述信息。此外,我们还提出了 PhysXGen,一个面向真实物理世界的 3D 生成框架,以实现从图像到真实 3D 资产的生成。

引言

近年来,随着 3D 资产在游戏、机器人技术和具身模拟等领域的广泛应用,其多样性与高质量生成受到了越来越多的关注。大量研究工作集中在外观与几何结构上:包括高质量的 3D 数据集 (Objaverse [1]、ShapeNet [2])、高效的 3D 表示方法以及生成模型等方面。

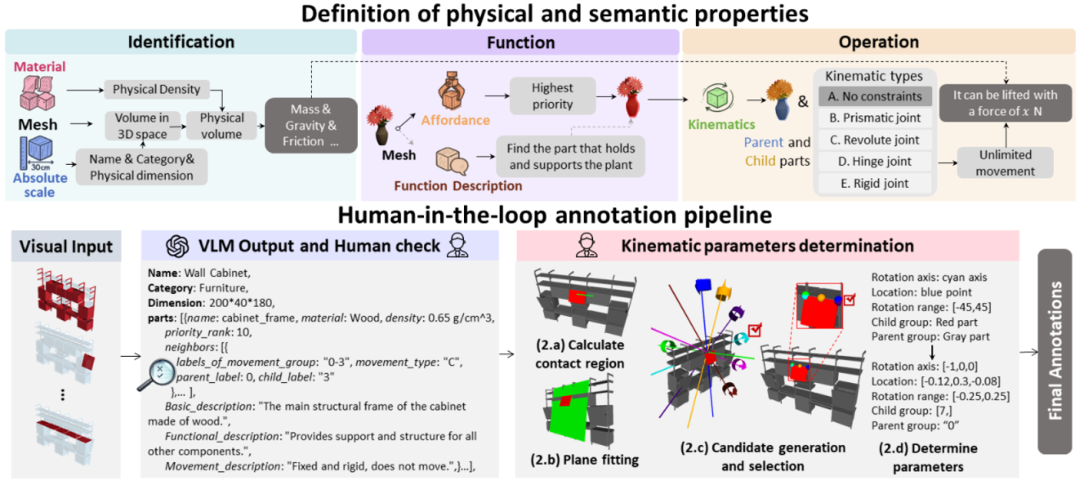

然而,这些研究大多仅关注结构特征,忽视了现实世界物体所固有的物理属性。鉴于 3D 空间中对物理建模、理解与推理的需求不断增长,我们认为,从上游的数据标注流程到下游的生成建模,构建一个完整的基于物理的 3D 对象建模体系变得尤为重要。考虑到除了几何和外观等纯粹的结构属性之外,现实世界中的物体还内在地具有丰富的物理和语义特性,包括:物理尺度、材料 (密度、杨氏模量、泊松比)、可供性、运动学(运动模式、运动方向、运动范围),以及文本描述(整体、功能、可供性信息)。通过将这些基础属性与经典物理原理相结合,我们便可以推导出关键的动态指标,如重力效应、摩擦力、接触区域、运动轨迹与交互关系等。

基于以上分析,我们提出了 PhysXNet — 首个全面的物理属性 3D 数据集,包含超过 26K 带有丰富注释的 3D 物体。除了在物体层级上的注释外,我们还对每个零部件进行了物理属性的标注。包括我们为所有部件提供了可供性排名以及运动学约束的详细参数,包括运动范围、运动方向、子部件和父部件等信息。

除此之外,我们还引入了扩展版本 PhysXNet-XL,其中包含超过 600 万个通过程序化生成并带有物理注释的 3D 对象。进一步,我们提出了 PhysXGen —— 一个用于物理 3D 生成的前馈模型。鉴于物理属性在空间上与几何结构和外观密切相关,我们利用预训练的 3D 先验,以生成具备物理属性的 3D 资产,从而实现高效训练并具备良好的泛化能力。

数据介绍

由于物理属性难以测量且标注极其耗时,导致现存相关数据集数据量难以扩展。为解决此挑战,我们通过设计一个人在回路的标注流程以实现高效的物理信息采集标注。通过与相关数据对比我们的数据集是首个包含多种丰富物理属性的 3D 数据集,并且包括物体整体信息及各部分的物理信息。

标注流程

正如前文所述,在确定标注信息后,我们提出了人在回路的标注框架,分为两个明确的操作阶段 1)初步数据采集和 2)运动学参数确定。

具体而言,我们利用 GPT-4o 获取基础信息。为了保证原始数据质量,由人工审核员将对视觉 - 语言模型(VLM)的输出结果进行检查。而第二阶段细分为四个子任务:(2.a)接触区域计算,(2.b)平面拟合,(2.c)候选项生成与筛选,(2.d)运动学参数确定。

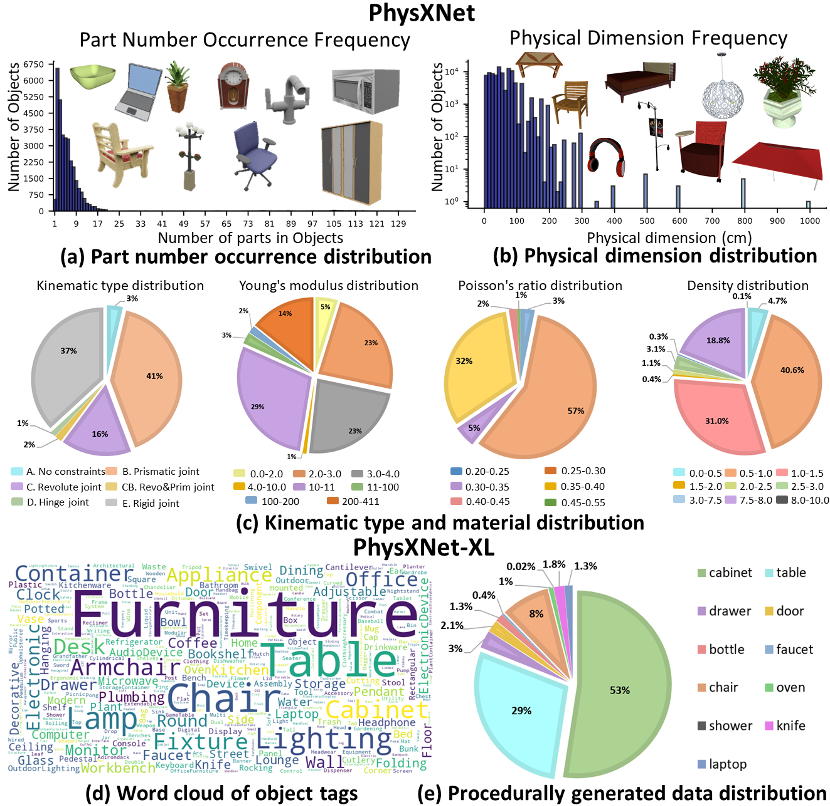

数据分布

PhysXNet 数据集包含超过 26K 个带物理属性的 3D 对象,图中展示了对象中部件数量的长尾分布,其中每个对象平均包含约 5 个组成部件。此外,我们在图 (b) 中记录了对象的长、宽、高分布情况。由于 PhysXNet 涵盖了从相对小型的室内物体到大型室外结构,物理尺寸在对象之间表现出显著差异。关于 PhysXNet 中的运动学类型和材料,我们展示了详细的比例组成。最后,我们还统计了 PhysXNet-XL 中程序化生成的 6M 个 3D 数据的类别,涵盖:a) 类内组合及 b) 跨类别组合。

生成方法介绍

为实现高效的包含物理属性的 3D 资产生成,我们基于预训练的 3D 表示空间,提出了 PhysXGen,一个新颖且简洁的框架,将物理属性与几何结构和外观相结合,如图所示。我们的方法通过在生成过程中同步融合基础物理属性,同时通过有针对性的微调优化结构分支,达到这一双重目标。这种联合优化使得生成的 3D 资产在保持出色几何和外观逼真度的同时,实现了物理上的自洽性。

实验

定性及定量分析

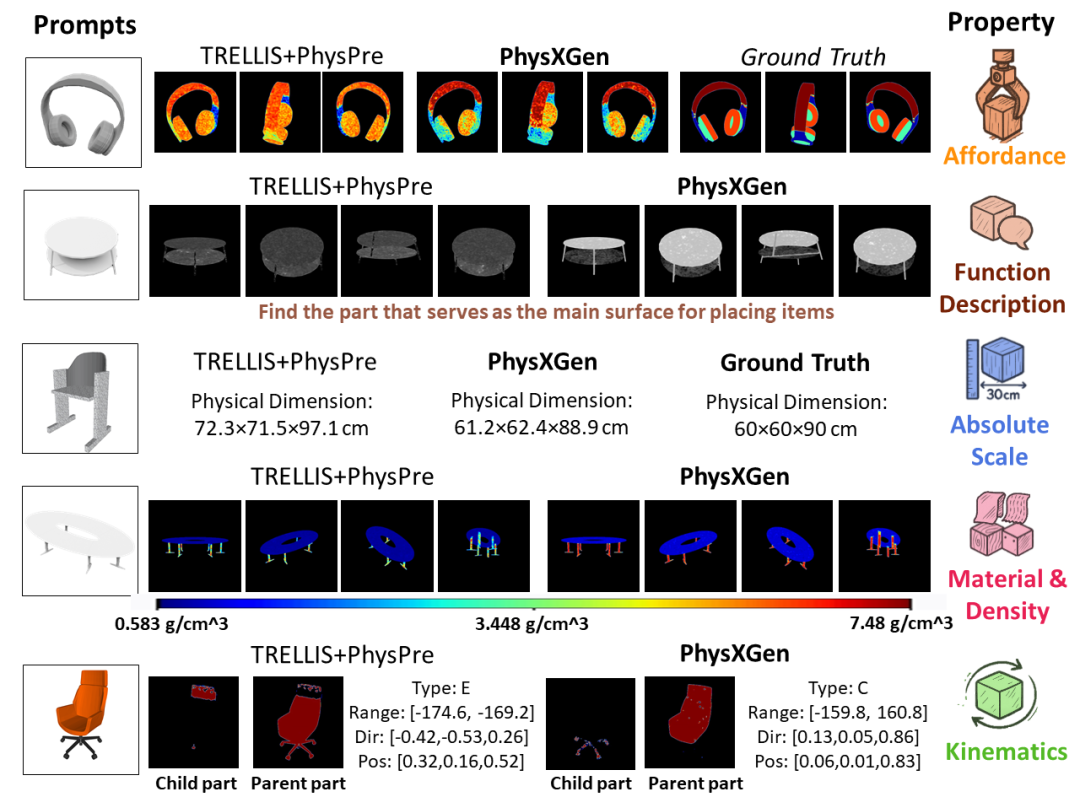

如表所示,我们从两个维度对模型进行了定量评估:1)几何结构与外观质量评估;2)物理属性评估。

需要说明的是,TRELLIS+PhysPre 是我们的 Baseline,其采用独立结构来预测物理属性。相比于这种分离式的物理属性预测器,我们的 PhysXGen 利用了物理属性与预定义 3D 结构空间之间的相关性,不仅在物理属性生成方面取得了显著提升,同时也增强了外观质量如图所示。

与现有方法对比

为了评估我们所提出的方法 PhysXGen 在生成具物理基础的 3D 资产方面的能力,我们与一个基于 GPT 的基线流程进行了全面的定性与定量比较。该基线流程由 Trellis [3]、PartField [4] 和 GPT-4o 组成。在该评估框架下,给定一张图像提示,Trellis 首先生成具备完整几何结构和外观纹理的 3D 网格;随后,这些资产经由 PartField 进行细粒度的部件分割;最后,GPT 模型对每个部件赋予材料参数和动态属性等物理属性。在四个评估维度上:物理尺度、材料、运动学和可供性,PhysXGen 分别取得了 24%、64%、28% 和 72% 的相对性能提升,表现出显著优势。

总结

本文旨在填补现有 3D 资产与真实世界之间的差距,提出了一种端到端的物理基础 3D 资产生成范式,包括首个具物理属性注释的 3D 数据集(PhysXNet、PhysXNet-XL)以及新颖的物理属性生成器(PhysXGen)。具体而言,我们构建了一个人机协同的数据标注流程,可将现有 3D 资源库转化为具备物理信息的数据集。与此同时,我们提出的新型端到端生成框架 PhysXGen,能够将物理先验融入以结构为中心的架构中,从而实现稳健的 3D 生成效果。通过在 PhysXNet 上的实验,我们揭示了物理 3D 生成任务中的关键挑战与未来方向。我们相信,该数据集将吸引来自嵌入式人工智能、机器人学以及 3D 视觉等多个研究领域的广泛关注。

参考文献

[1] Deitke M, Schwenk D, Salvador J, et al. Objaverse: A universe of annotated 3d objects [C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2023: 13142-13153.

[2] Chang A X, Funkhouser T, Guibas L, et al. Shapenet: An information-rich 3d model repository [J]. arXiv preprint arXiv:1512.03012, 2015.

[3] Xiang J, Lv Z, Xu S, et al. Structured 3d latents for scalable and versatile 3d generation [C]//Proceedings of the Computer Vision and Pattern Recognition Conference. 2025: 21469-21480.

[4] Liu M, Uy M A, Xiang D, et al. Partfield: Learning 3d feature fields for part segmentation and beyond [J]. arXiv preprint arXiv:2504.11451, 2025.

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com