今年以来,业界已形成共识:强化学习(RL)正成为迈向通用人工智能(AGI)的关键技术。从基于人类反馈的强化学习(RLHF)到可验证奖励的强化学习(RLVR),RL 不断推动大语言模型从单纯的指令遵循迈向深度推理,即演进为大型推理模型(LRMs)。该领域进展迅速,系统梳理当前成果、展望通向超级智能的未来路径显得尤为重要。

本报告将围绕我们最新发布的大模型推理能力强化学习综述,详细阐述 RL for LRMs 的基础框架、前沿问题、训练资源与应用场景,以及未来面临的挑战。我们特别关注大模型与环境在长期进化过程中的交互与学习机制,希望为“如何将算力更高效地转化为推理智能”这一本质问题,带来新的思考与启发。

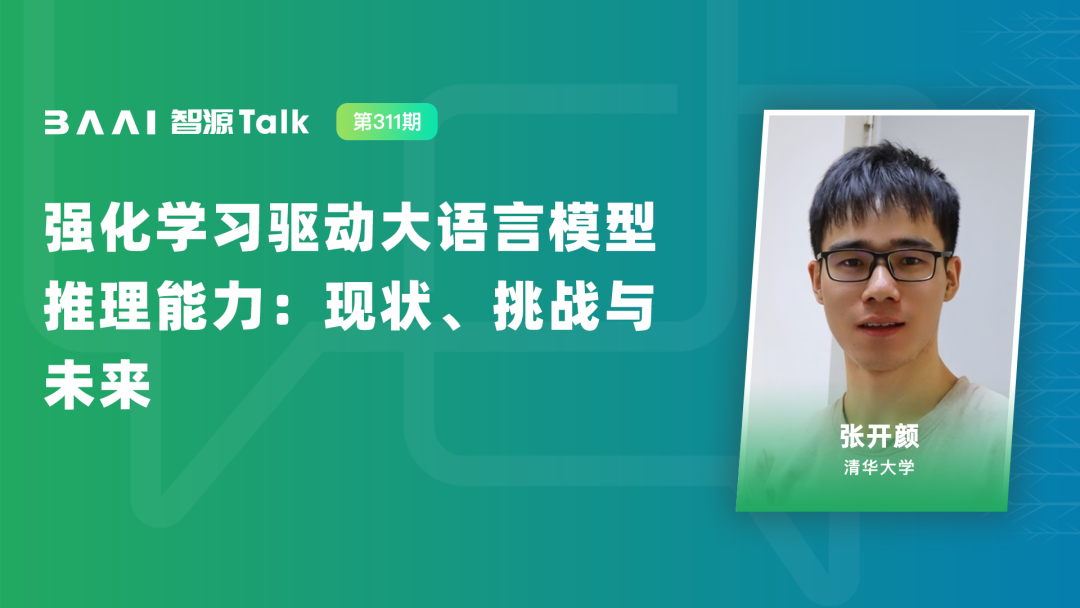

报告嘉宾:

张开颜,清华大学四年级博士生,师从周伯文教授。主要研究方向包括大语言模型、推理强化学习与多智能体等。在 NeurIPS、ICLR、ICML、ACL、EMNLP、COLM 等国际顶级会议发表论文十余篇。主导提出 TTRL、SSRL、MARTI 等大模型强化学习算法与框架,发起并维护 “Awesome-RL-for-LRMs” 开源项目(GitHub 1400+ Stars),Google Scholar 论文引用量累计超过 1000 次。曾获清华大学研究生国家奖学金、校级综合优秀一等奖学金等。个人主页:https://iseesaw.github.io/

👆扫码报名👆或者点击「阅读原文」报名