点击蓝字 关注我们

欢迎各位专家学者在公众号平台报道最新研究工作,荐稿请联系小编Robert(微信ID:BrainX007); 或将稿件发送至lgl010@vip.163.com。

近期,浙江大学温州研究院脑机智能融合研发中心主任孙煜教授团队在IEEE Transactions on Affective Computing(TAFFC,Q1/1区)在线发表题为“STRFLNet: Spatio-Temporal Representation Fusion Learning Network for EEG-Based Emotion Recognition”的研究成果。浙江大学副研究员胡佛为第一作者,研发中心主任孙煜教授为通讯作者。

成果简介

基于脑电(EEG)的情绪识别对于医疗辅助和人机交互至关重要。尽管基于深度学习的情感识别方法表现出了显著的性能,但仍有一些挑战: 1)如何有效地利用情感相关EEG信号固有的复杂动态静态空间模式。2)如何分层学习多域特征之间的潜在相关性。为了应对这些挑战,本研究提出了一种时空表示学习网络(STRFLNet),以提高基于 EEG 的情绪识别的准确性和鲁棒性。具体来说,构建了动态静态图拓扑来捕获全面的脑功能连接,并引入连续动态静态图常微分方程来揭示脑电信号中的连续空间模式。此外,开发了一个分层Transformer融合模块,以充分利用多域特征之间的潜在相关性来获得融合的时空表示。

在公共脑电图情绪数据集SEED、SEED-IV和DREAMER上,STRFLNet在被试依赖设置下的分类准确率分别为96.42%、92.23%和94.57%(效价)/96.03%(唤醒),在被试独立设置下的分类准确率分别为89.64%、76.52%和63.25%(效价)/ 65.76%(唤醒)。实验结果表明,STRFLNet在基于脑电的情绪识别中始终优于现有的最先进的方法。此外,本文通过全面的可解释性分析来验证模型的有效性,这揭示了激活的大脑区域和对应的情绪状态之间的明显关联。本文强调了连续空间模式建模和时空特征融合在情感识别中的重要性,为基于EEG的情感计算提供了新的见解。

主要贡献

本文提出了一种动态-静态图构建策略,以全面分析大脑功能连接的稳定模式和与情绪状态相关的动态变化。此外,通过利用CDSGODEM捕获EEG信号中连续的空间动态,聚合大脑节点之间的远程空间模式,有效地解决了过平滑问题。

本文引入了一个名为HTFM的多层特征融合模块,该模块利用交叉Transformer和自注意力Transformer组件对脑电信号的互补时空表示进行分层集成,显著提高了模型的情感识别性能。

STRFLNet展示了高鲁棒的情感识别性能和有效的多域特征融合能力。实验结果表明,STRFLNet在公共SEED、SEED-IV和DREAMER数据集上的性能优于最先进的方法。

方法

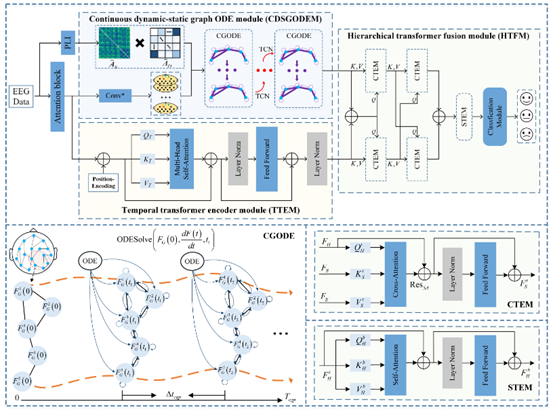

图1:STRFLNet的总体框架。

为了全面捕捉与情感相关的多通道脑电信号的时间和空间依赖关系,本研究设计了一种新的双分支深度学习网络STRFLNet,如图1所示。STRFLNet由以下模块组成:时域Transformer编码器模块(TTEM)、连续图ODE模块(CGODE)、分层Transformer融合模块(HTFM)和分类模块(CM)。

1) TTEM:TTEM主要包括位置编码、多头自注意力、前馈层和归一化层。首先,将相对位置编码 (PE) 引入特征FA,帮助模型学习序列中各个时间点的依赖关系。然后,TTEM 通过对位置编码的特征图应用线性变换来计算查询 (Q)、键 (K) 和值 (V) 矩阵。TTEM 的最终输出是通过连接所有注意力头的输出获得的,然后是与权重矩阵 WT 的线性变换

2) CGODE:为了捕捉潜在的远程空间动态,缓解深度图传播中常见的过平滑问题,本文提出CGODE利用连续图传播(CGP)从多通道脑电信号中提取丰富的情感相关空间模式。在离散图传播中,EEG通道之间的空间依赖性可以通过特定的图快照和特征传播来表示。

3) HTFM:为了深入探索多域特征之间的互补信息,本文提出了一种基于transformer架构的分层融合策略,通过交叉transformer编码器模块(CTEM)和自transformer编码器模块(STEM)逐步实现,如图1所示。HTFM由三部分组成:顶层、中间层和底层。顶层作为基本融合层,由两个CTEMs组成,负责初始整合空间和时间特征,为后续层提供输入。中间层建立在顶层之上,进一步细化了特征表示,也由两个CTEMs组成,以深入探索特征之间复杂的相互作用。底层由单个STEM组成,综合来自前面各层的所有信息以执行最终的特征融合,捕获跨多个特征域最全面和最不变的表示。

总结来说,对EEG数据进行注意块产生初始特征。然后引入TTEM来捕获FA中嵌入的时态依赖。连续动态静态图ODE采用动-静态图结构同时建模脑功能连接的稳定模式和动态变化。此外,利用CGODE对动态静态图数据的全面连续空间表示进行编码。连续动态静态图ODE为情感识别量身定制,将连续图传播与双尺度连接建模相结合,在保持神经生理可解释性的同时增强了空间表示。随后,将时间和空间特征输入到HTFM中,旨在发现跨多个特征域的稳定、不变的表示,从而细化更具判别性的融合特征。

数据来源

SEED数据集:共有15名受试者(包括7名男性和8名女性)在观看15部电影片段时参与了EEG记录,每个受试者都试图诱导一个不同的情绪类别:积极、中性或消极。每个视频片段持续约240秒。每个受试者参与三个阶段,每个阶段之间有一段间隔,每个阶段观看15个不同的视频片段。在整个实验过程中,使用ESI NeuroScan系统记录62个电极的脑电信号,并下采样至200 Hz的采样率。

SEED-IV数据集:实验过程与SEED类似,但扩展了电影片段和情感诱导的选择。SEED-IV实验包括72个电影片段,旨在诱导四种不同的情绪状态:快乐、悲伤、恐惧和中性。每个视频片段持续大约240秒。每个受试者参与了三个阶段,每个阶段之间有间隔,每个阶段他们观看24个视频剪辑。同样,SEED-IV实验中的脑电信号使用ESI NeuroScan系统记录62个电极,随后下采样到200 Hz的采样率。

DREAMER数据集:包含23名志愿者(14名男性和9名女性)的EEG记录,这些记录是在他们经历18个情感诱发的电影片段时收集的。采集14通道脑电信号,采样频率为128 Hz。与SEED和SEED-IV数据集不同的是,DREAMER从两个维度评估情感:效价和唤醒度,每一个维度都有一个5分的自我评估量表。根据之前的研究,本文将情绪状态分为两个水平,即唤醒和效价,低和高。在后续分析中,只使用每个试验最后60秒的EEG数据。

结果

研究结论

本研究提出了一种新的时空表示融合学习模型STRFLNet,通过融合时空动态信息实现基于脑电信号的情感识别。在SEED、SEEDIV和DREAMER数据集上的综合评估表明,与多种SOTA情感识别方法相比,STRFLNet始终取得了优越的性能。特别地,所提出的动静态图结构使STRFLNet模型能够全面分析与情感状态相关的稳定和动态的脑功能连接模式,而CDSGODEM捕捉了连续的空间特征,缓解了过平滑问题。提出的融合策略HTFM更准确地关注了时空特征之间的潜在依赖关系,实现了多域特征信息的有效融合。通过可解释性分析进一步验证了模型的有效性,揭示了不同激活脑区与情绪之间的关联。总之,本文的工作强调了潜在空间模式学习和时空特征融合在情感识别中的重要性,从而为该领域的未来研究铺平了道路。

尽管这些结果很有希望,但仍需解决几个限制,以进一步提高STRFLNet模型的泛化能力和可解释性。虽然所提出方法有效地捕捉了脑电信号中的潜在空间和时间模式,但主要对通道级关系进行了建模,而没有显式地纳入区域级的脑动力学,这可能提供更全面的神经生理学视角。此外,STRFLNet模型没有考虑情感标签中潜在的噪声,这些噪声可能来自主观的自我报告或注释的不一致。在未来的工作中,将计划探索解剖先验指导的基于区域的表示学习,并结合不确定性建模或标签去噪策略,以增强模型的鲁棒性。

免责声明:原创仅代表原创编译,水平有限,仅供学术交流,如有侵权,请联系删除,文献解读如有疏漏之处,我们深表歉意。

公众号丨智能传感与脑机接口