简介&提出背景

思维链 (Chain-of-Thought, CoT) 是一种通过中间思考步骤增强大语言模型推理能力的方法。视觉思维链 (Visual Chain-of-Thought, VCoT) 将思维链从文本模态扩展到图像模态,以图像作为中间思考步骤,被用来提升多模态大模型的思考能力。

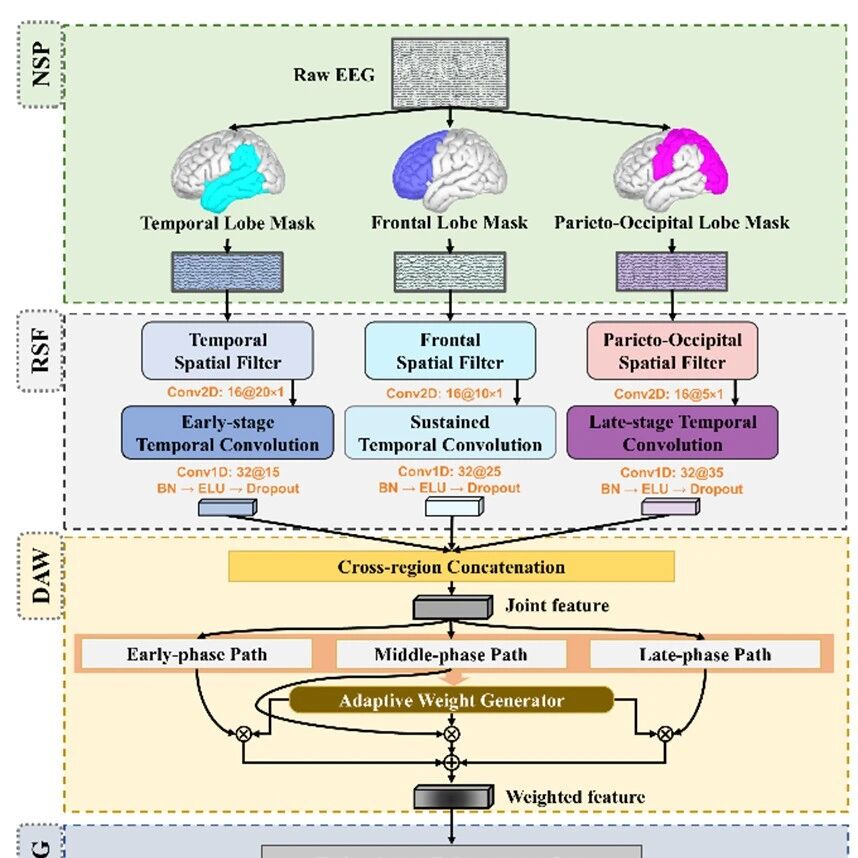

VCoT-Grasp以多模态大模型为基础,将视觉思维链引入机器人抓取任务中来提升抓取质量。与已有语言驱动抓取方法对比如图所示:

(a)基于多模态融合的方法, (b)使用LLM/VLM提供指引的模块化方法, (c)带有语言推理能力的端到端多模态大模型方法, (d)我们的方法,引入视觉推理能力,以目标的bounding box图像作为思考步骤。

已有的语言驱动的抓取检测模型通常将语言作为额外的输入模态与视觉特征进行融合,并从多模态特征中生成动作,或者利用LLM和MLLM提供指引来对生成的抓取进行过滤或排序。前者缺少对推理能力的利用,而后者虽然能够利用大模型的推理能力,但让系统变得庞大复杂。RT-Grasp构建了一个端到端的模型,并通过在文本层面推理物品形状和抓取位置来提升动作质量。但RT-Grasp局限于单个物品的场景,并且性能难以超过传统方法。

VCoT-Grasp构建了一个端到端的基础模型,并引入视觉思维链来增强视觉理解能力。实际运行中,模型以目标物品的bounding box图像作为中间思考步骤,首先预测目标的bounding box作为粗粒度位置,之后目标区域的图像被裁剪并输入模型用以提供细粒度信息,最终输出动作。

论文标题: VCoT-Grasp: Grasp Foundation Models with Visual Chain-of-Thought Reasoning for Language-driven Grasp Generation

arXiv链接: https://arxiv.org/abs/2510.05827

主页链接: https://zhanghr2001.github.io/VCoT-Grasp.github.io/

代码和模型权重链接: https://github.com/zhanghr2001/VCoT-Grasp

主要作者单位: 西安交通大学

工作创新点与贡献

提出了VCoT-Grasp模型,一个端到端的语言驱动抓取基础模型,并具有视觉Chain-of-Thought推理能力。

精华了一个高质量抓取数据集VCoT-GraspSet,包含167K张合成图像和1.36M抓取标签,以及400张实机采集的数据和1200个手动标注的抓取标签。

大量实验证明VCoT-Grasp模型具有强大的性能和优秀的泛化能力。

VCoT-Grasp模型与方法

模型架构基于PaliGemma-3B视觉语言模型。并采用两阶段推理:1. 模型根据输入图像和检测指令("detect something)先预测目标物品的bounding box,之后bounding box区域的图像被裁剪、缩放为原本大小后重新输入给模型。2. 编码后的原本图像、bounding box图像和抓取指令(“grasp something“)被输入给大模型,其最后一层特征由动作头解码出最终动作。

在包含多个物品的场景中,模型本身在抓取前需要有一个定位的过程,视觉思维链将这一定位步骤显式化。在第一步预测bounding box的过程中,模型将目标物品与背景和无关物品区分,得到物品的大致位置。之后bounding box区域的图像被裁剪并缩放为原本的大小,使得模型可以更加近距离地观察物品。在第二步抓取预测过程中,模型同时接受原本图像、bounding box图像和指令作为输入,因此既能够获知物品在图像上的位置,又能在此基础上进行细粒度的调整,最终得到高质量抓取动作。

预测bounding box时,遵循了PaliGemma本身实现目标检测的方法,将位置离散化并以token的形式预测。在预测动作时,按照动作头的架构,可以采用不同的方式。当以离散化token的形式预测时,动作头复用大模型的输出头(LM head)。当采用连续的预测方式时,动作头可以使用MLP或Diffusion架构,此时会在文本输入中添加dummy token,并将其最后一层特征作为动作头的输入。

消融实验显示,以token形式预测动作时模型的性能表现最优。另外,直接复用MLLM预训练时用于做目标检测的位置token来做抓取生成,效果会优于使用新添加的、专门用于抓取的token。说明MLLM的预训练位置特征具有良好的迁移和泛化能力。

数据集

目前大部分的大规模抓取数据集采用合成的方式构建,例如Grasp Anything使用图像生成模型生成图片,再基于形状分析标注出可行的抓取标签。这样构建的数据集有足够的数据量和多样性,但有着质量低的问题。

我们为了训练模型,在Grasp Anything基础上构建了一个高质量数据集VCoT-GraspSet,通过开集检测模型YOLO-World对图像生成bounding box,并与数据集中的bounding box对比,保留IoU较大的数据。最终得到了一个高质量数据集,包含190K图像和1.36M抓取标签。

实验分析

数据集上测试结果

实机性能表现

模型消融

动作头消融实验。token形式的动作预测达到最高性能。并且预训练的用于目标检测的位置token效果好于新添加的token。

不经过实机数据微调的zero-shot表现

面对背景变化和distractor的鲁棒性

一些总结

我们提出VCoT-Grasp,一个端到端的抓取生成模型,并通过引入视觉思维链推理来强化视觉理解能力。此外,该模型通过验证机器人模型中的多轮处理范式,填补了重要技术空白。为支持训练,我们构建并发布了大规模高质量数据集VCoT-GraspSet。在VCoT-GraspSet数据集和真实机器人环境上的大量实验表明,VCoT-Grasp在分布内场景中表现优异,在包含未见物体、跨域场景、干扰物及背景变化等多种分布外场景下均有优秀的性能表现。