点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:3D视觉工坊

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

在医学影像识别任务中,数据标注始终是一项高成本、高门槛的工程。尤其面对突发性疾病、罕见病变或新型异常,医生往往无法及时提供足够的标注样本,这使得传统深度学习模型面临“训练集缺席”的窘境。零样本检测(Zero-shot Detection)因而成为当前医学AI领域的重要突破方向,它允许模型在未见过目标样本的前提下,依托语言提示进行病灶识别,大幅拓宽了模型的适应能力。 在过去的几年中,像 GLIP 这类视觉-语言联合预训练模型逐渐崭露头角,它们通过将图像内容与文本提示对齐,实现在泛化场景下的多类别目标检测。理论上,医生只需要输入一段关于疾病的描述,模型即可尝试在影像中定位相关病灶。但现实远比想象复杂:简单的“病名+症状”难以涵盖真实病灶的复杂形态,模型很难精准捕捉描述背后的语义细节,导致图文对齐效果有限,检测准确率也随之受限。

现有方法为何“对不上”?

虽然视觉-语言模型的出现让零样本检测变得可行,但现实中,这类模型的表现常常“对不上号”。很多方法仍采用“把提示词当标签”的策略,也就是说,它们将目标的名称、描述等信息直接拼接进模型,作为检测的上下文。但这种方式其实并不精细——它混合了太多与目标无关的语言噪声,不仅打乱了语义分布,还削弱了模型对关键视觉特征的关注能力。

更棘手的是,医学语言的多义性让类别级提示词变得模糊。例如,“粉红色或红色组织”、“不规则或圆形边缘”这些表达虽然符合医生的描述习惯,但并不总能在图像中对应到明确的病灶边界。这意味着,模型很难在多种形态间建立清晰的映射,最终只能给出模糊甚至错误的检测结果。

与此同时,临床场景本身是高度动态的——医生可能随时想识别新的征象或变异类型,而当前一些方法要求每次都重新构建实例级提示,效率低、成本高,远无法满足诊疗场景中对“实时响应”的需求。 简而言之:现有零样本检测方案,既无法充分利用语言中蕴含的医学知识,又难以跟上临床变化的节奏。

从粗到细:结构化知识库的解法

面对图文对齐粗糙、语言提示模糊、响应效率低下等难题,StructuralGLIP 提出了一种全新的双分支架构,试图从根源上重塑图文关系的建构方式。它将提示词从“上下文噪声”中解放出来,转而注入一个“潜在知识库”(latent knowledge bank),使得文本信息不再与图像硬拼,而是作为结构化语义,被系统化地存储、检索和匹配。

模型架构上,StructuralGLIP 分为主干路径和辅助路径两条线:主分支聚焦于图从本质上看,这像是构建了一个“动态记忆系统”:每次推理,模型都能从知识库中自动召回最相关的信息,动态调整检测逻辑,从而提升模型的表达能力与泛化能力。

像特征与目标类别对齐,处理传统视觉输入;辅助分支则负责编码提示词,构建一个语义丰富的知识表示集合,覆盖颜色、形态、纹理等多个维度的描述信息。这一设计,使得语言提示不再是静态文本,而变成了一套可被模型“调用”的动态知识体。

更关键的是,StructuralGLIP 在每一层引入了一种“互选机制(Mutual Selection)”。通过这个机制,模型能够自动在图像特征和知识库中挑选最具相关性的 token——既找到关键的视觉区域,也精准锁定对应的语义片段。最终,两者通过多头跨模态注意力机制深度融合,构建出一种细粒度的结构化表示(structural representation),实现语义与图像的逐层耦合。

从本质上看,这像是构建了一个“动态记忆系统”:每次推理,模型都能从知识库中自动召回最相关的信息,动态调整检测逻辑,从而提升模型的表达能力与泛化能力。

实验验证

理论机制固然重要,但能否落地,最终还要看实验表现。StructuralGLIP 在四大医学影像类型(内镜、显微、医学摄影、放射影像)上进行了系统测试,涵盖八个主流数据集。结果显示,它在完全零样本的设定下,平均 AP 提升超过 +4%,相较于 GLIP、MIU-VL、AutoPrompter 等现有方法,表现出了跨模态理解上的明显优势。

其中一个关键的加分项,是它引入的类别级提示机制(Category-level Prompts)。通过结合 VQA 与 GPT-4 自动生成的属性模板,StructuralGLIP 构建出包含颜色、纹理、边缘形态等细节信息的“类别知识库”。这一机制让模型在同一疾病类别下具备统一的描述风格,又能借助互选机制对冗余信息进行动态裁剪。

实验证明,仅引入这套类别级提示,模型的平均检测精度又提升了约 +7%。更有意思的是,即便在已经微调过的 GLIP 模型上,StructuralGLIP 的结构机制依然可以带来额外约 +3% 的增益,这说明它不仅适用于“从零开始”的场景,也具备增强既有模型的能力——某些任务上,甚至已超越传统的全监督检测器如 RetinaNet。 从速度到精度、从泛化能力到适配性,StructuralGLIP 用一套结构化语义机制,在医学AI这条难走的路上,走出了实用且具推广性的下一步。

持续进化的医学AI,正在发生

StructuralGLIP 的意义不仅仅在于性能提升,更在于它为医学AI提出了一种“结构化演化”的思路。传统模型依赖静态的标签和有限的训练样本,一旦面对未知类别或描述方式,常常陷入“无法理解”的瓶颈。而 StructuralGLIP 构建出的知识库,就像是一个可不断扩容的记忆系统:医生只需输入新的疾病描述,模型便可实时吸收、动态匹配,从而实现持续学习与快速响应。

这一机制的潜力也远不止医学。论文作者已开始探索将其泛化应用于自然图像、开放域检测等任务中,借助结构化语义与互选机制,让视觉-语言模型具备更强的理解能力和通用性。对AI开发者而言,它提供了一个关于“如何让模型更灵活、更可控、更知识化”的范式样本。

可以预见的是,随着结构化知识库机制的不断成熟,我们距离“医生只需一句话,模型即可理解并行动”的智能诊疗,正在从理想走向现实。

3D视觉1V1论文辅导来啦!

3D视觉学习圈子

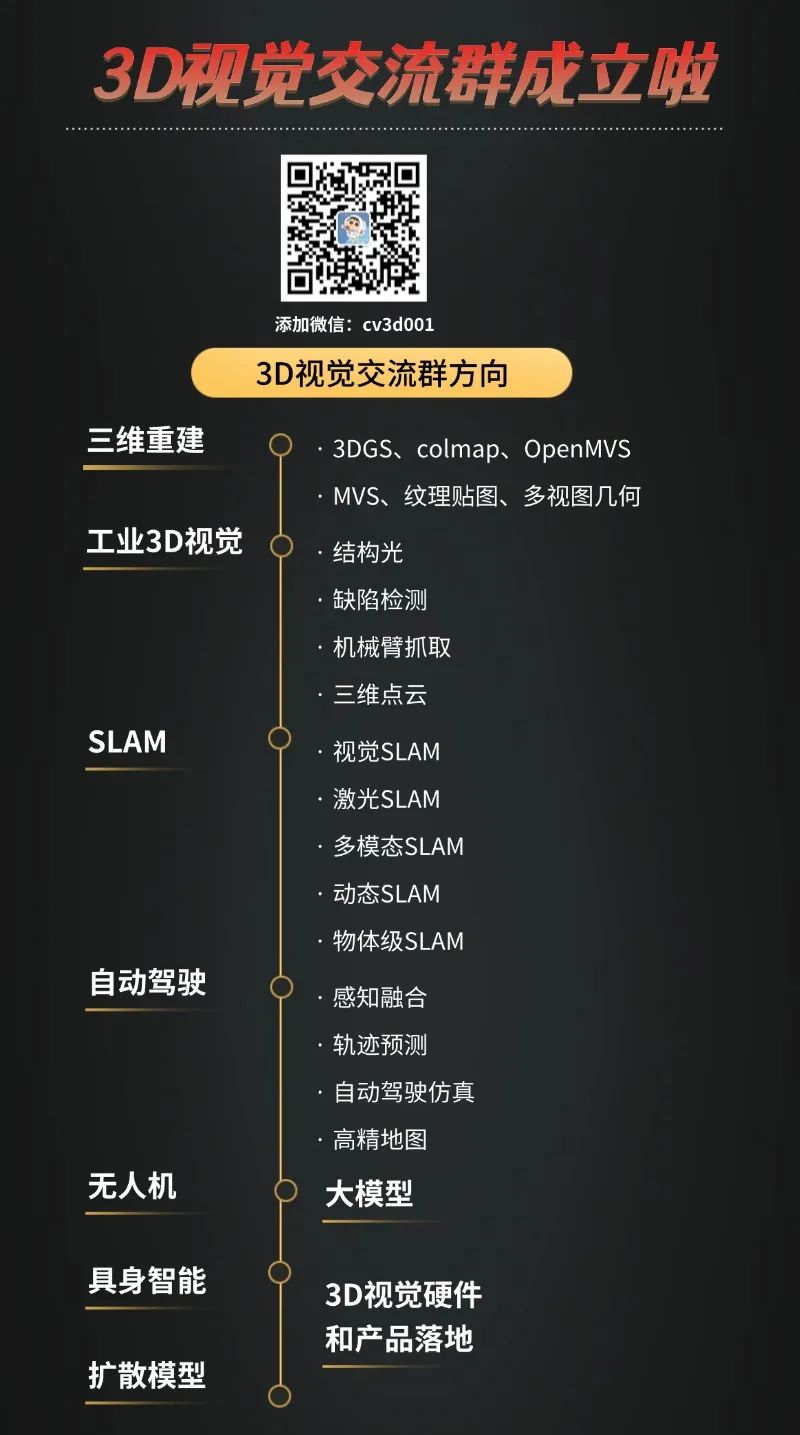

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群成立啦,微信:cv3d001