显著提升GPU利用率!

2025年10月18日,在韩国首尔举办的第31届操作系统原理研讨会(SOSP)上,阿里云发布的“Aegaeon”计算池化解决方案研究成果成功入选。

该方案创新性地解决了AI模型服务中普遍存在的GPU资源浪费问题,在阿里云模型市场测试中,实现了英伟达GPU用量大幅削减82%的显著成效。

SOSP(操作系统原理研讨会)由ACM SIGOPS主办,是计算机系统领域顶级学术会议,平均每年收录的论文数量仅有数十篇,被誉为计算机操作系统界的“奥斯卡”,本届SOSP大会仅收录66篇论文。

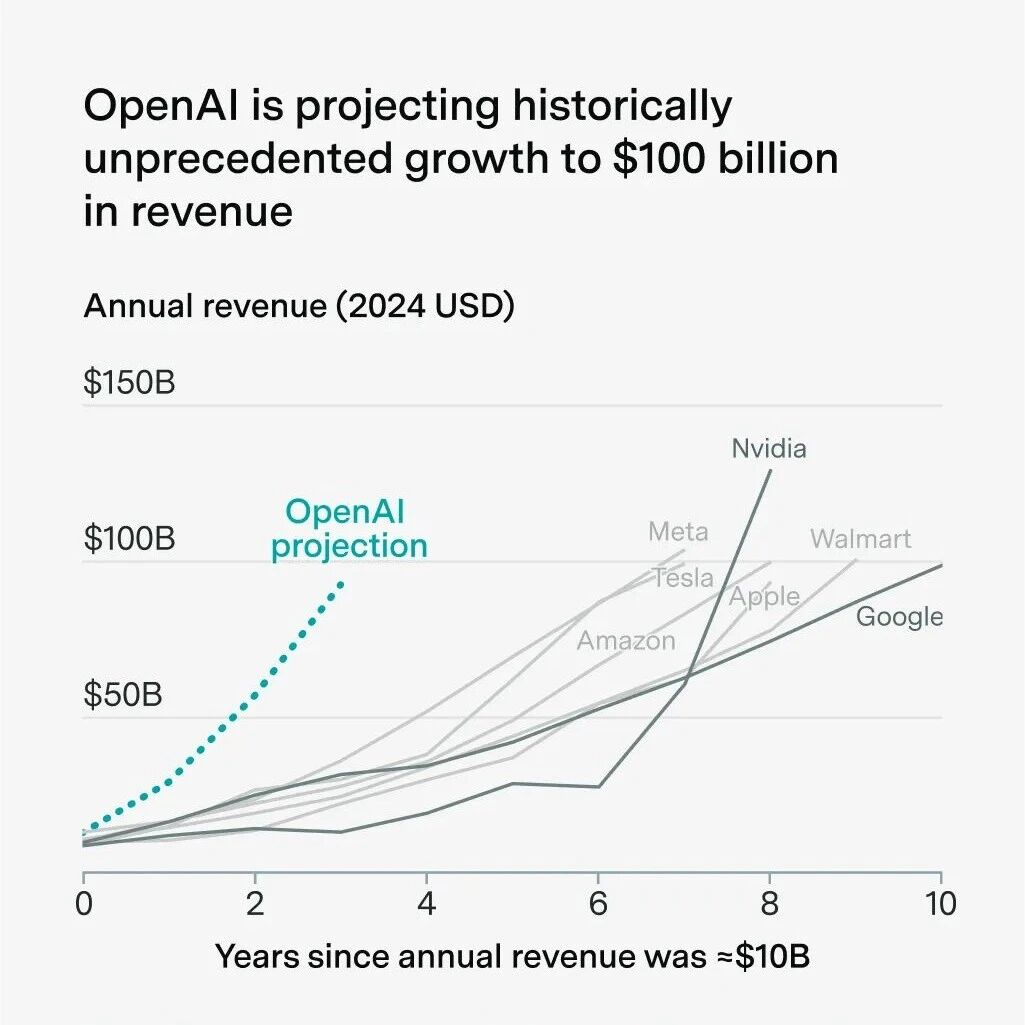

目前,云服务商在提供AI模型服务时,资源效率低下问题突出。平台需托管数千个AI模型以应对海量并发API调用,但用户请求常集中于少数热门模型,如阿里巴巴的Qwen系列模型。这种“长尾效应”致使大量资源闲置,在阿里云模型市场中,高达17.7%的GPU算力仅用于处理1.35%的请求,造成了高昂的成本浪费。

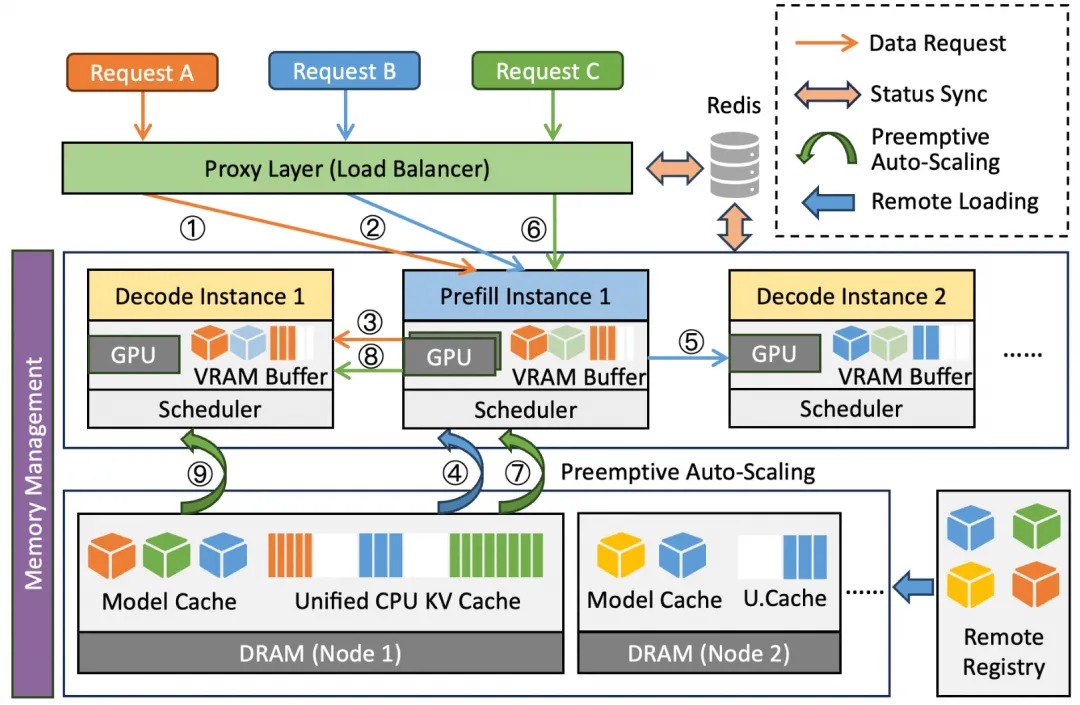

图|研究框架图

为解决这一痛点,阿里云推出Aegaeon系统。该系统运用创新的GPU资源池化技术,打破了以往GPU与特定模型绑定的低效模式,允许单个GPU动态服务于多个不同的AI模型。在阿里云模型市场进行的为期超三个月的Beta测试中,Aegaeon系统展现出卓越效能。测试数据显示,在服务数十个参数量高达720亿的大模型时,所需的英伟达H20 GPU数量从1192个成功减少至213个,用量削减82%。这意味着仅用213张卡就完成了原本1192张卡才能完成的工作,极大地提高了资源利用率,降低了成本。

此次由北京大学与阿里云合作的研究成果,被认为是“首个揭示并解决市场上并发大语言模型服务存在过高成本”的公开工作,为行业提供了全新的优化思路。SOSP作为计算机操作系统领域的顶尖会议,录取率控制严格,平均每年收录论文仅数十篇,入选论文代表了操作系统和软件领域最具代表性的研究成果,Aegaeon系统研究成果的入选,无疑是对阿里云在该领域创新能力的高度认可。

阿里云Aegaeon计算池化解决方案的推出,不仅为自身解决了AI模型服务中的资源浪费问题,也为整个云服务和AI产业提供了可借鉴的模式,有望推动行业在提升资源效率、降低成本方面迈出重要一步。

来源:信创头条

END

点击参与:(2025年10月22-24日)

点击报名:!(11月5日-7日)