鹭羽 发自 凹非寺

量子位 | 公众号 QbitAI

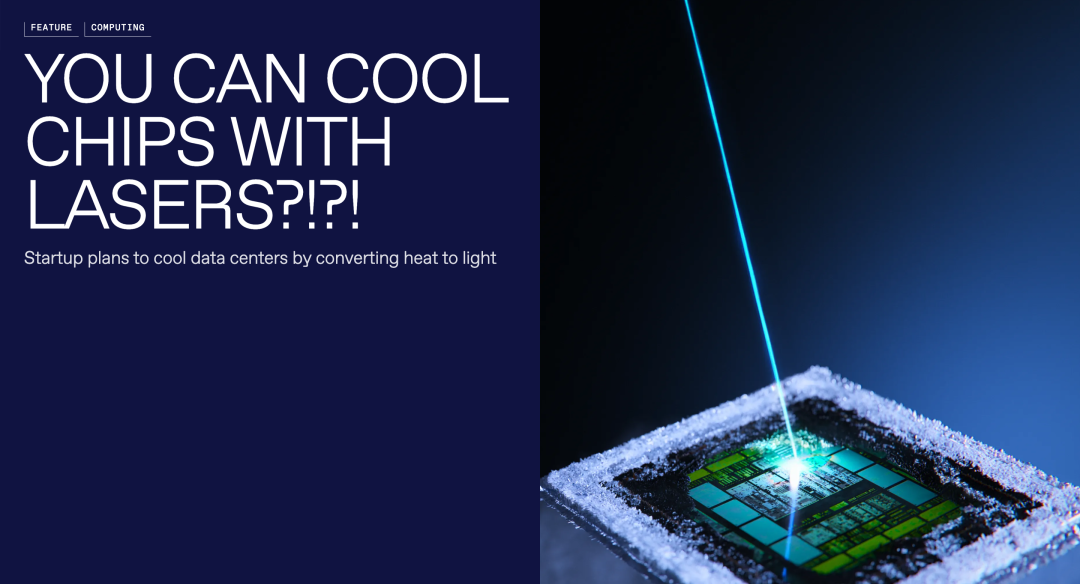

风冷、液冷OUT!芯片散热有了新方法——用激光。

现在热量不仅仅可以“移动”,还能直接“消失”。

嘶,听起来是不是有点反物理学常识?却正在成为可能。

初创公司Maxwell Labs最新提出的光子冷却方法,可以直接将热量转化成光,并在芯片内部去除。

无需再像传统方法一样整块芯片降温,光子冷却精确瞄准芯片热点,效率提升好几个level。

而且该技术一旦彻底成熟,不仅单颗芯片的可用功率实现大幅提升、3D芯片堆叠散热问题得以解决,甚至也将有利于建立大规模数据中心。

言归正传,具体细节如下:

光子冷板让热能变成光

通常情况下,激光可以被视作是热源的一种,被广泛应用于切割材料或传输数据,但之所以说激光可以诱导冷却,原因在于荧光过程。

荧光想必大家都不陌生,荧光笔、珊瑚礁……诸如此类的荧光现象,都是将紫外线中吸取的高能光转换成可见的低能光。

其中由于吸收的能量远高于发射能量,能量的差异往往导致材料升温,但换言之,如果采取一定手段,吸收的是低能光、发射的变成高能光,那么材料就会降温。

而这种现象在物理学中被称为反斯托克斯冷却:对于照射在特殊材料上的窄范围激光,离子可以有效地吸收入射光,并结合材料晶格振动(声子)触发发射更高能量的光。

不过期间需要注意尽快让发射光逸出,否则会被再次吸收,导致温度回升。

借助该原理,Maxwell Labs将其集成到薄膜芯片级光子冷板上,从而实现芯片的光子冷却。

具体来说,就是利用光子冷板检测功率密度新增区域,然后将光精准耦合到附近,将局部热点降至目标温度。

光子冷板需要满足两个条件,一是小型化,因为要对热点进行更为聚集的空间定位,二是层次较薄,防止发射光被重新吸收。另外还要按照光的波长尺度设计对应材料,增加对入射光的吸收。

其主要包含以下几个组件:

- 耦合器:

一种将入射激光聚焦到微制冷区域的透镜,同时也将入射的载热荧光灯引导出芯片。 - 微制冷区域:

实际发生反斯托克斯冷却的地方。 - 背反射器:

防止入射激光和荧光灯直接照射到CPU或GPU。 - 传感器:

检测热点的形成,协助将激光引导到热点上。

然后将一系列尺寸为一平方毫米的光子冷板平铺放置在芯片基板顶部,利用外部热像仪感应芯片热点,当热点出现时,激光照射热点旁边的光子冷板,刺激光子过程并提取其热量,最终实现降温目的。

另外,研究人员还建立了一个多物理场仿真模型和逆向设计工具,来搜索更多可调节的参数,希望将冷却功率密度再提高两个数量级。

比风冷液冷更高效

那么回到最根本的问题,为什么芯片需要散热?

原因无他,芯片在运行过程中会不可避免地持续产生热量,过热又会严重影响性能、可靠性甚至导致损坏。

而随着现代高性能CPU/GPU中的晶体管密度增加、功率密度急剧上升,传统散热方式(如风冷、液冷)在热点区域就显得不够用了。

近几年各芯片厂商也围绕着热限制,找了很多解决方案,主要集中在两个方向:加快热量导出和减少热量产生。

比如说为了加快热量从芯片中导出的速度,采用单晶SiC、金刚石等热导率更高的材料,或者是内部设计热通道结构增加热散面积,也可以通过动态电压频率调节(DVFS)、功率门控(Power Gating)、低功耗设计等技术从源头减少热输出。

英特尔在六月最新提出的芯片封装技术中,就将传统的EMIB技术升级为带有垂直通道 (through-silicon vias) 的连接,以降低功率路径中的热产出。

同时在封装中设计带有分段的集成热扩散器 (integrated heat spreader) 结构,解决较大面积硅片带来的弯曲问题,从而改善热通道导出效果。

AMD也在同月专门针对嵌入式器件提出了新的散热设计方案,采用优化的TIM(热界面材料)改善热接触,并建议器件封装中尽量选择无金属封盖,可最大化减少内部TIM的热阻。

另外,英伟达近几年来也更强调MLCP、系统级液体冷却(包括Direct-to-Chip和Direct-to-Silicon冷却方案)、散热和封装架构的设计,反观台积电则将重心放在TIM、 硅集成微流控等材料封装解决方案上。

微软近期也表示,已经成功测试了一种使用微流体技术的新型芯片冷却系统,可以将微小的液体通道直接蚀刻到硅上。

该系统在测试结果中可以将GPU升温情况降低65%,有助于实现功率密度更高的芯片设计。

……

但总结来看,这些方法还是在已有的液冷风冷方法上继续迭代,而现在新提出的光子冷却给出了另外一种解法,对比下来效果显著。

通过热力学分析,即使是实验用的初代激光冷却装置,也能比空气及液态冷却系统的散热功率高两倍还多,具体体现在:

1、消除暗硅问题。

在多核或超大规模集成电路中,由于功耗和散热限制,不是所有芯片单元都可以同时以最大频率工作,其中80%都必须在给定时间内处于未激活状态。

而光子冷却可以在热点刚刚形成时就充分去除热量影响,允许芯片上的更多晶体管同时运行,充分发挥芯片效能。

2、实现更高的时钟频率。

该技术可将芯片温度始终保持在50°C以下,而传统散热方式下的芯片温度普遍在90至120°C,在集成扩大后温度还将进一步上升。

低温环境将帮助芯片实现更高的时钟频率,可以在不增加晶体管密度的情况下提高芯片性能,突破摩尔定律上限。

3、3D集成在热管理上实现可控。

由于激光辅助冷却可以更为精准地定位热点,可以更容易地从3D堆栈中去除热量,比如在每一层添加一个光子冷板控温,相比传统热管理方案,3D芯片设计会更加简约。

4、激光冷却更高效。

激光冷却可以在让芯片保持恒温的同时,大大降低对流冷却系统的整体功耗。实验结果表明,当激光冷却与空气冷却结合时,芯片的总体能耗可以降低50%甚至更多。

5、循环回收更多废能。

激光冷却也能回收比风冷和液冷更多的废能,可以通过将光重新收集到光缆中,然后再利用热光伏,将其转化为电能,从而实现高达60%的能量回收。

因此,研究团队预计该技术带来的突破将会在2027年得以落地实用,届时高性能计算和人工智能集群将会借助光子冷却方法让每瓦的冷却性再提高一个数量级。

到2028年至2030年,或将完成主流计算中心部署,将IT能耗降低40%,同时计算能力翻倍,并在2030年后推广至边缘计算。

光子冷却重构了性能、计算和能力之间的关系,将困扰半导体行业良久的热管理问题转换为可再生资源重复利用,这一全新范式的提出正如作者所说:

计算的未来是光子的、高效的和非常酷的。

参考链接:

[1]https://spectrum.ieee.org/laser-cooling-chips?utm_source=homepage&utm_medium=hero&utm_campaign=hero-2025-10-19&utm_content=hero1

[2]https://x.com/wallstengine/status/1970553554269053027

[3]https://spectrum.ieee.org/intel-advanced-packaging-for-ai

[4]https://docs.amd.com/r/en-US/xapp1377-heatsinks-thermal/Summary

[5]https://tspasemiconductor.substack.com/p/tsmc-x-nvidia-breaking-the-thermal