在传统方案中,模仿学习依赖人工标注的专家示范数据,让智能体无法从自身行为后果中学习;强化学习虽能通过试错优化,但需环境提供可验证的奖励信号,要么缺失要么延迟,训练效率极低。

Meta等团队提出的 “Early Experience(早期经验学习)”,正为语言智能体训练破局——

让智能体在无外部奖励的情况下,主动提出替代动作并收集对应的未来状态。通过 “隐性世界建模”(学习环境动态规律)与 “自我反思”(对比专家行为提炼决策教训),将自身经历转化为监督信号。

这一范式既摆脱了对海量人工数据或依赖奖励的桎梏,还能让智能体像人类一样从实践中成长,在 8 类主流环境中均实现性能突破,更能为后续强化学习提供优质初始化,推动语言智能体从 “人类数据驱动” 迈向 “自主经验驱动”。

关键点梳理

这套框架的关键在于:让语言模型具备“内在世界感”。

研究者设计了两个核心机制:

隐式世界建模(Implicit World Modeling)

让模型在执行动作后,自己去预测“接下来会发生什么”。比如执行一条指令后,它会用自然语言描述环境的变化——

“文件已移动”“目标目录存在”“该命令会删除文件”。

这就像模型在脑海里建立了一个“世界模拟器”。

自我反思(Self-Reflection)

模型会比较自己和专家行为的差异,然后用语言总结出“为什么专家更优”,这些反思再反过来指导下一轮学习。

整个过程不需要额外奖励信号,监督信息全部来自智能体自己的行为与反思。

技术亮点

隐式世界建模:从行为中“感知世界”

这部分是 Early Experience 框架的基础。

模型通过对「状态–动作–结果」三元组的语言化建模,学习环境的内在规律。

具体过程是:智能体在执行动作后,不是直接等待奖励,而是生成一句自然语言描述——预测接下来世界会发生什么。

比如:

“执行 ‘mv log.txt → archive/’ 后,文件将从根目录消失并出现在 archive 文件夹中。”

论文指出,这种方式本质上让模型在语言空间中学会了因果关系建模:

动作与后果的配对成为一种隐式动力学学习。

它不依赖显式的奖励函数或强化信号,而是通过语言描述形成“内生的世界理解”。

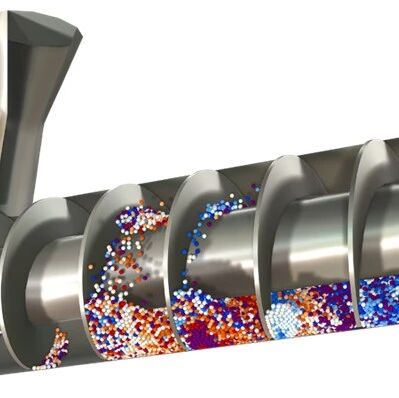

▲图1|这张图展示了论文提出的两种早期经验学习方式。左侧是隐式世界建模(Implicit World Modeling):研究者在专家轨迹中加入替代动作,并让模型预测这些动作会导致的下一个状态。通过这种方式,模型在部署前就能内化环境的转移规律,学会“行动—后果”的因果关系。右侧是 自我反思(Self-Reflection):模型同样在专家行为基础上,加入自己生成的解释句(如 “因为X条件不满足,所以选择Y更优”),通过语言化推理学会理解并修正自己的决策©️【深蓝具身智能】编译

自我反思:从差异中“理解正确”

这是 Early Experience 的第二个核心模块。

它建立在隐式世界建模之上,负责让模型从「失败经验」中提炼规律。

流程上,模型会比较自己生成的行为与专家行为之间的结果差异,并用自然语言进行解释。例如:

“在选择交通出行方式时,专家会告诉模型需要额外考虑旅行时间上的问题,因此模型会学习考虑时间约束,从而选择速度最快的乘飞机方案”

这些语言化反思被重新注入模型输入,成为新的监督信号。

从结构上看,反思模块并不额外引入新网络,而是通过语言反馈回路实现:

模型生成行动预测 → 执行动作并观察结果 → 与专家轨迹对比 → 用语言总结差异 → 将反思文本再输入模型更新参数。

▲图2|自我反思的提示词模板:作者巧妙地利用模板化的提示词来适配不同的语境场景;从末班中可以看到,模型首先会被要求根据当前的情况作出一系列行动的决策,随后接受专家给出的行动建议,并将自己的行动决策与专家的建议作对比,主动分析差异,从而在过程中“反思”才去的行动决策,最终提升思维的能力©️【深蓝具身智能】编译

这种循环训练相当于让模型在学习“如何调整思维过程”。

Early Experience 框架:无奖励的自我成长机制

隐式建模和自我反思共同组成完整的 Early Experience 框架。

整体流程如下:

收集早期经验数据:从少量专家示范中抽取关键状态,并让模型在这些点生成不同动作的未来推演(branching)。

生成隐式世界建模样本:预测每个动作后的可能状态,得到语言形式的状态转移数据。

反思学习:对比预测与专家行为的结果,生成自然语言解释。

联合训练:使用预测文本和反思文本共同监督模型,使其在语言层面同时学习“如何理解世界”和“如何修正策略”。

这种机制不依赖奖励函数,也不需要环境交互模拟器,可直接在语言模型框架中实现。

它相当于在大模型中内嵌了“微型认知循环”——观察 → 预测 → 比较 → 反思 → 调整。

▲图3|Early Experience 的“语言认知循环”在行动;这张图展示了 Early Experience 框架在 TravelPlanner 任务中的一个完整训练示例。©️【深蓝具身智能】编译

研究者指出,这种模式在多个任务中展现出显著泛化力,因为模型不仅学到了任务本身,还形成了对任务逻辑的可迁移理解。

实验与表现

研究团队在 WebShop、ALFWorld 等8个环境中验证了 Early Experience 的效果。

实验结果

只用 1/8 的专家数据,模型的成功率就能超过传统模仿学习,用 一半数据甚至能追平完整监督训练。

▲图4|这张图展示了 Early Experience 方法在八个标准测试环境上的表现。©️【深蓝具身智能】编译

这说明智能体不再依赖海量演示,也能从自己的行动结果中提取有效监督,以更少的成本学得更深。

新的机制

此外,论文提出的“分支因子 K”机制,让模型在每个状态生成多个替代动作进行推演。

随着 K 的增加,模型对环境的理解更完整,世界建模能力持续增强。同时,自我反思(Self-Reflection) 模块在中等分支下效果最佳,平衡了探索与稳定性。

▲图5|这张图展示了在 WebArena-Lite 基准环境 中,不同规模的 Llama 模型(从小型到大型)在采用模仿学习与早期经验方法下的性能对比。©️【深蓝具身智能】编译

最后,研究者在从 3B 到 70B 参数的多种模型上测试发现,Early Experience 的优势在所有规模中都保持显著——即使只用 LoRA 微调,仍能稳定提升表现。

这证明该方法具有良好的可扩展性和迁移性:模型越大,收获越多;经验越早,智能越强。

总结

Early Experience 提供了一种全新的学习方式:智能体不再依赖外部奖励,也不再单纯模仿人类,而是通过观察自己的行动后果来理解世界。

隐式世界建模让它学会预见变化,自我反思让它学会修正错误。它让语言模型第一次具备了“主动学习”的特征,能在没有奖励信号、没有外部标注的情况下不断完善自己。在具身智能与通用智能的演化路线上,EarlyExperience 代表着一种更接近人类的学习方式——

从经验出发,从失败中成长,从世界中理解自己。

编辑|阿豹

审编|具身君

Ref

论文题目:Agent Learning via Early Experience

论文地址:https://arxiv.org/pdf/2510.08558

>>>现在成为星友,特享99元/年<<<

【具身宝典】||||

【技术深度】|||||||

【先锋观点】|||

【非开源代码复现】||

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

投稿|商务合作|转载:SL13126828869(微信)

点击❤收藏并推荐本文