作者为北京航空航天大学的肖宜松,刘艾杉,应宗浩,刘祥龙,新加坡国立大学的梁思源,新加坡南洋理工大学的陶大程。本文已被 NeurIPS 2025 录用。

LLM 已在智能创作、企业服务等领域广泛应用,但其内容安全问题仍是落地过程中的关键挑战。仇恨、歧视、威胁性言论等潜在风险,使得 LLM 的安全部署与可信使用面临困难,而现有的内容过滤或对齐方案在效果、效率与成本之间往往难以兼顾。

近期,来自北航等机构的研究提出了一种新的解决思路:自回归奖励引导表征编辑(ARGRE)框架。该方法首次在 LLM 的潜在表征空间中可视化了毒性从高到低的连续变化路径,实现了在测试阶段进行高效「解毒」。

论文标题:Detoxifying Large Language Models via Autoregressive Reward Guided Representation Editing

论文地址:https://arxiv.org/abs/2510.01243

实验结果显示,ARGRE 在降低模型毒性(62.21%)、缩短推理时间(47.58%)的同时,几乎不影响模型原有能力,为提升大模型内容安全提供了新的方向。

在 8 个主流 LLM(参数覆盖 355M 的 GPT-2 Medium 到 30B 的 LLaMA-30B)上的测试显示,其性能全面碾压当前所有基线方法,为 LLM 安全落地提供了「又快又准又轻」的全新方法。

图1 ARGRE 框架图

研究背景

当前大语言模型解毒技术虽已形成两大主流路径,但均存在难以突破的核心瓶颈,严重制约其在实际场景中的落地效果:

其一,以直接偏好优化(DPO)为代表的训练时解毒方法,虽能通过偏好数据微调模型参数实现毒性抑制,却高度依赖大规模高质量标注数据与巨额算力支撑,在低数据、低算力的资源受限场景中难以适用;

其二,以表征编辑为代表的测试时解毒方法,无需修改模型参数,在推理阶段实施静态或动态干预。尽管具备灵活轻量的优势,但这类方法普遍未能充分探索大模型生成过程中毒性输出与非毒性输出之间的过渡空间,仅依赖稀疏的毒性标注数据无法捕捉到精细修复信号,导致干预精度不足,最终解毒效果远未达最优。

ARGRE 针对上述瓶颈,提出在潜在表征空间中显式建模毒性转变轨迹,形成可学习的“导航系统”。该系统将稀疏标注转化为密集信号,指导自回归奖励模型学习更稳定、精确的干预策略,从而在推理阶段高效降低毒性输出。

方法概述

ARGRE 的总体流程包括三部分:毒性轨迹探索、奖励模型学习与自适应表征编辑。其核心思想是通过表征插值刻画毒性连续变化,并以自回归奖励信号引导模型在推理阶段进行动态修正。

毒性轨迹探索

依据线性表征假设,毒性等语义概念在大语言模型的表征空间中以线性方向编码。

给定提示 ,毒性延续

,毒性延续 和良性延续

和良性延续 ,提取二者最后一个令牌上的表征差异,再通过 PCA 提取主导的无毒方向

,提取二者最后一个令牌上的表征差异,再通过 PCA 提取主导的无毒方向 。

。 为探索高维语义表征空间中无毒与有毒配对转换提供了清晰路径。沿着

为探索高维语义表征空间中无毒与有毒配对转换提供了清晰路径。沿着 在良性延续和毒性延续表征上进行插值,生成细粒度的毒性转换轨迹,并进一步组合成成对偏好数据集

在良性延续和毒性延续表征上进行插值,生成细粒度的毒性转换轨迹,并进一步组合成成对偏好数据集 。

。

这些轨迹能将原本稀疏的毒性注释,转化为连续的细粒度毒性表征变化信号,形成密集的监督信息,最终让后续学习的自回归奖励模型具备更稳定、准确的编辑指导能力。

自回归奖励模型

轨迹级奖励模型基于完整轨迹训练,仅在结尾处分配最终奖励,导致生成过程中编辑信号不够精准。

相比之下,ARGRE在令牌表征层面构建轻量的自回归奖励模型,对整体奖励 进行分解,为每个令牌表征提供标量化奖励

进行分解,为每个令牌表征提供标量化奖励 。

。

自回归奖励模型 由应用在最终解码层之上的感知机实现,旨在为良性响应分配比毒性响应更高的奖励信号,其训练目标如下所示:

由应用在最终解码层之上的感知机实现,旨在为良性响应分配比毒性响应更高的奖励信号,其训练目标如下所示:

自适应表征编辑

依托自回归奖励模型,推理阶段通过引导每个令牌表征最大化预期奖励,实现大语言模型输出毒性的降低。

具体分为两步:首先沿预设无毒方向 调整表征,利用当前表征与平均无毒奖励的预期差距,将其快速导向非毒性安全区域;随后通过轻量级梯度上升进一步优化表征,以提升奖励分数、强化解毒效果。

调整表征,利用当前表征与平均无毒奖励的预期差距,将其快速导向非毒性安全区域;随后通过轻量级梯度上升进一步优化表征,以提升奖励分数、强化解毒效果。

相较于现有方法依赖启发式静态干预或繁琐的梯度动态干预,该策略在效果与效率上优势显著:定向引导可降低表征陷入局部最优的风险,而有限的梯度迭代则确保自回归生成的额外开销微乎其微。

实验评估

在实验评估环节,为验证解毒效果,研究团队以 RealToxicityPrompts 的挑战子集为测试基准。

通过向大语言模型输入该子集的提示以触发潜在毒性输出,再借助 Detoxify 工具对生成结果进行毒性评分(分数越高毒性越强),同时以生成文本的困惑度衡量语言流畅性保留情况。

评估覆盖 8 个主流 LLM,参数规模跨度从 355M(如 GPT-2 Medium)到 30B(如 LLaMA-30B)。

在有效性评估中,ARGRE 展现出卓越的解毒性能:不仅显著超越各类基线方法,更在 8 个主流大语言模型上实现了高效毒性抑制,相比原始模型毒性降低率高达 62.21%。即便仅保留初始定向引导步骤、去除迭代优化的简化版本,也能实现 59.63% 的毒性降低。

同时,ARGRE 在不同参数规模模型中均表现稳定,从 355M 到 30B 参数的大模型均能有效适配,且仅造成最小程度的流畅性损耗,成功平衡了毒性抑制效果与模型核心生成能力。

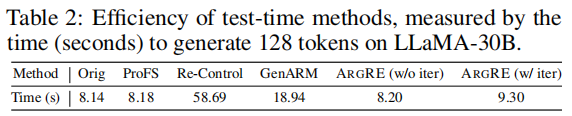

在效率表现上,ARGRE 同样展现出显著优势。以 LLaMA-30B 为测试对象,在生成 128 个 token 的任务中,ARGRE 能有效降低计算开销,相比当前表现最佳的基线方法,推理时间减少 47.58%。

ARGRE 的效率优势源于两点核心设计:一方面,其自回归奖励模型采用轻量两层 MLP 结构,无需额外复杂模块,避免引入多余计算负担;另一方面,自适应两步编辑中的梯度优化步骤仅需少量迭代,进一步控制了推理阶段的开销。

而实现可比解毒表现的简化版本,推理速度与原始模型近乎持平,表明定向引导步骤的开销极小。

理想的大语言模型解毒方法,需在降低毒性的同时完整保留模型现有核心能力,ARGRE 较好的满足了这一目标。在语言性能保留层面,以 WikiText-2 数据集的困惑度为衡量指标,ARGRE 仅导致困惑度平均上升 0.52,这一微小增幅意味着其对语言生成能力的影响极低,且该增幅在所有测试时基线方法中处于最低水平。

在零样本任务能力层面,ARGRE 能够稳定保留原始模型的准确率,未出现能力退化;而其他测试时基线方法在这一维度均表现出不同程度的性能下降。

总结

本文提出的 ARGRE,是一种能显式建模 LLM 表征空间中毒性转变的新型测试时解毒方法。其核心突破在于通过将稀疏的毒性标注转化为密集训练信号,高效学习出可提供稳定、精准指导的自回归奖励模型,为后续表征编辑提供关键支撑。

在覆盖 355M 至 30B 参数的 8 种主流 LLM 上的广泛评估显示,ARGRE 不仅在解毒性能上全面优于基线方法,推理效率也显著高于其他主流基线,更能以近乎零损耗的方式保留模型原有的核心能力。

ARGRE 当前存在两点局限:其一,作为白盒方法,它需获取 LLM 的内部表征才能实施干预,限制了其在无法接触模型内部信息场景中的应用范围;其二,当前对毒性转变的探索仅围绕第一主成分方向展开,未来工作将尝试探索更多样化的方向,以便更好地捕捉毒性转变的细微特征。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com