在机器人操控领域,“精准响应指令、预判环境变化、稳定执行动作” 始终是核心挑战——现有视觉 - 语言 - 动作(VLA)模型缺乏对物理规律的理解与未来场景的想象,而世界模型虽能预测环境动态,却无法直接生成执行动作。

阿里巴巴达摩院、湖畔实验室等团队联合提出的RynnVLA-002,以 “VLA 模型与世界模型双向增强” 为核心思路,通过统一多模态编码、创新动作生成机制,在模拟与真实场景中均实现性能突破:无预训练状态下,LIBERO 模拟基准成功率达 97.4%;真实机器人实验中,世界模型的融入使整体成功率提升 50%,彻底打通 “感知 - 理解 - 行动 - 预测” 的全链路。

RynnVLA-002 官方代码库:https://github.com/alibaba-damo-academy/RynnVLA-002

为什么需要统一 VLA 与世界模型?

现有机器人决策方案陷入 “单向能力瓶颈”,核心问题可归结为 “无法同时兼顾动作生成、环境理解与未来预测”,两类主流方案的缺陷尤为突出:

|

|

|

|

|---|---|---|

|

|

|

|

|

|

|

|

RynnVLA-002 的创新在于发现 “双向增强” 逻辑:世界模型通过学习物理动态,可优化 VLA 模型的动作生成精度;而 VLA 模型的视觉理解能力,能提升世界模型的场景预测保真度。两者的统一框架,恰好弥补了各自的核心短板,如图 1 所示,传统 VLA 模型仅能实现图像理解与动作生成,世界模型仅能完成图像理解与图像生成,而 RynnVLA-002 的动作世界模型实现了图像与动作的双向理解和生成。

RynnVLA-002:如何实现 “感知 - 行动 - 预测” 三位一体?

RynnVLA-002 的核心设计可概括为 “统一多模态编码 + 双向增强架构 + 混合动作生成”,既通过共享词汇表打破模态壁垒,又借助双模型协同实现能力互补,具体分为三大核心组件与关键技术:

核心组件 1:多模态统一编码——打破视觉、语言、动作的信息壁垒

RynnVLA-002 采用四类 Tokenizer(图像、文本、状态、动作),将所有模态信息编码为统一词汇表(规模 65536),实现单 LLM 架构下的跨模态理解与生成:

-

图像 Tokenizer:基于 VQ-GAN 模型,为 256×256 图像生成 256 个令牌,512×512 图像生成 1024 个令牌,通过感知损失优化特定区域识别; -

文本 Tokenizer:采用训练后的 BPE 分词器,处理任务指令(如 “将草莓放入杯子”); -

状态 / 动作 Tokenizer:将机器人本体状态与连续动作离散化为 256 个区间,同时保留连续动作的原始生成路径。

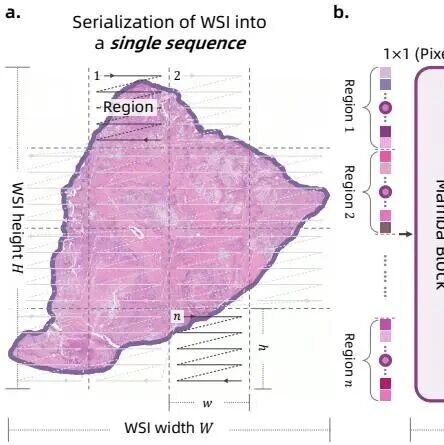

这种设计使模型能同时处理 “视觉观测(图像)- 任务指令(文本)- 执行动作(动作令牌)- 设备状态(状态令牌)”,为双向增强提供数据基础,模型整体架构如图 2 所示。

核心组件 2:双向增强架构 ——VLA 与世界模型的协同闭环

架构通过双模型互促,实现 “动作生成更精准、场景预测更可靠”,核心逻辑如下:

-

VLA 模型:基于语言目标、历史观测与本体状态,生成连续或离散动作序列,公式定义为:,其中l为任务指令,为前一状态,为历史观测; -

世界模型:基于过往观测与动作,预测下一帧视觉场景,公式定义为:; -

双向增强机制:VLA 模型的视觉理解能力提升世界模型的场景预测精度,世界模型学到的物理动态规律优化 VLA 模型的动作规划逻辑,训练时通过混合两类模型数据,实现参数共享与能力协同。

核心组件 3:混合动作生成——兼顾离散精度与连续泛化

针对传统动作生成的 “误差累积” 与 “泛化不足” 问题,RynnVLA-002 设计双轨生成机制:

离散动作生成(模拟场景优化)

引入动作注意力掩码策略,使当前动作仅依赖视觉 - 文本输入,不依赖前序动作,避免误差传播:

-

传统掩码:动作生成依赖前序动作,易导致错误累积;

-

创新掩码:屏蔽前序动作干扰,每个动作独立基于原始输入生成,大幅提升长序列动作的连贯性,三种模型的注意力掩码对比如图 3 所示。

连续动作生成(真实场景优化)

新增Action Transformer 头,解决离散模型的泛化与速度问题:

-

优势 1:并行解码机制,推理速度远超串行 autoregressive 生成; -

优势 2:架构更紧凑,在有限真实数据上不易过拟合,泛化能力更强; -

优势 3:生成轨迹更平滑,避免机器人动作抖动,提升真实场景成功率。

训练时通过混合损失函数优化:,其中为离散动作交叉熵损失,为图像生成损失,为连续动作 L1 回归损失。

实验结果:模拟与真实场景的双重突破

RynnVLA-002 在 “模拟基准 + 真实机器人” 双场景中验证了有效性,核心表现可概括为 “无预训练也能打、真实场景泛化强、双向增强显成效”:

模拟场景:LIBERO 基准的极致性能

在 LIBERO 四大任务 suite(空间关系、物体操控、目标达成、长序列任务)中,无预训练状态下:

-

连续动作版本(RynnVLA-002-Continuous)平均成功率达 97.4%,其中空间任务 99.0%、物体任务 99.8%,远超各类有预训练的基线模型;

-

离散动作版本平均成功率 93.3%,长序列任务成功率 87.6%,显著优于传统 VLA 模型,具体数据如表 1 所示。

真实场景:LeRobot 机器人的实战验证

在 SO100 机械臂的两项真实任务中,RynnVLA-002 无预训练状态下表现亮眼,实验场景如图 4 所示:

-

“将方块放入圆圈” 任务:多目标场景成功率 90%,含干扰物场景成功率 80%,超越 GR00T N1.5、等有预训练的基线模型;

-

“将草莓放入杯子” 任务:单目标场景成功率 80%,多目标场景成功率 80%,在精细操控场景中展现出强鲁棒性,具体对比数据如表 2 所示。

关键消融验证:双向增强的核心价值

-

世界模型提升 VLA 性能:模拟场景中,加入世界模型数据后,离散动作平均成功率从 62.8% 提升至 67.2%,连续动作从 91.6% 提升至 94.6%,如表 3 和表 4 所示;

真实场景中,无世界模型时成功率不足 30%,加入后突破 80%,如表 5 所示。

如图 5 所示,无世界模型的模型无法成功抓取奶酪或瓶子,而联合训练的模型会在失败时反复尝试抓取目标物体。

-

VLA 增强世界模型生成:融合 VLA 数据后,世界模型的视频预测指标全面优化,例如物体任务的 FVD 从 1141.6 降至 877.2,SSIM 从 59.59 提升至 65.03,如表 6 所示;

如图 7 所示,基线世界模型无法预测到成功抓取碗的场景,且存在不同视角预测不一致的问题,而 RynnVLA-002 的动作世界模型能生成正确的抓取视频。

-

动作注意力掩码的作用:长序列动作生成中,掩码策略使成功率提升显著,尤其在 chunk 长度为 10 时,性能优势达 30% 以上,如图 6 所示。

关键结论与未来方向

核心结论

-

统一框架是关键:VLA 与世界模型的双向增强,解决了单一模型 “能做不能想” 或 “能想不能做” 的痛点,为机器人决策提供了更全面的能力支撑; -

动作生成机制适配场景:离散动作适合模拟场景的高精度需求,连续动作更适配真实场景的泛化与速度要求,混合设计实现 “场景全覆盖”; -

无预训练也能高效落地:不依赖大规模机器人预训练数据,降低了真实场景应用的门槛,为产业化落地提供便利。

未来方向

-

多模态增强:引入触觉、声音等模态,提升复杂环境(如黑暗、柔性物体操控)的适应性; -

效率优化:进一步轻量化模型,降低实时性延迟,适配高动态场景; -

长序列任务深化:优化长 horizon 任务的记忆更新机制,减少噪声累积导致的性能下降。

总结

RynnVLA-002 的创新不在于单一模块的突破,而在于构建了 “感知 - 理解 - 行动 - 预测” 的闭环生态——通过统一编码打破模态壁垒,用双向增强激活双模型潜力,以混合动作生成适配不同场景。这种设计既实现了模拟场景的极致性能,又解决了真实场景的泛化难题,为机器人操控技术从 “实验室” 走向 “产业化” 提供了极具参考价值的范本。