来源:3D视觉工坊

0.这篇文章干了啥?

这篇文章提出了一种适用于小型无人机在可控室内环境下的仅依赖视觉的自主飞行系统,通过语义分割和单目深度估计实现可靠导航。主要创新在于自适应比例因子算法,能将非度量单目深度预测转换为度量测量,平均误差14.4厘米,解决了仅视觉导航系统中的关键挑战。文中还采用知识蒸馏框架,将复杂系统转换为参数为160万的U - Net学生网络,可在资源受限平台上实现高效语义分割。研究创建了包含39648帧的定制室内数据集,用于训练和评估视觉无人机任务,并通过真实世界和数字孪生环境的广泛测试确保系统的可靠性和鲁棒性。实验结果表明,结合度量深度估计和语义分割的方法在导航距离、执行速度和任务成功率上均优于仅使用语义分割的方法。轻量级学生控制网络在边缘部署方面有一定潜力,任务成功率达87.5%,但端到端学习方法仍存在局限性,未来需改进以处理动态障碍物和实现更复杂的路径规划。

下面一起来阅读一下这项工作~

1. 论文信息

-

论文题目:Self - Supervised Learning to Fly using Efficient Semantic Segmentation and Metric Depth Estimation for Low - Cost Autonomous UAVs -

作者:Sebastian Mocanu, Emil Slusanschi, Marius Leordeanu -

作者机构: -

1National University of Science and Technology Politehnica Bucharest, 060042 Bucharest, Romania -

2Institute of Mathematics ”Simion Stoilow” of the Romanian Academy, 010702 Bucharest, Romania -

3NORCE Norwegian Research Center, Norway -

论文链接:https://arxiv.org/pdf/2510.16624

2. 摘要

本文为在可控室内环境中运行的小型无人机提出了一种仅依赖视觉的自主飞行系统。该系统将语义分割与单目深度估计相结合,无需全球定位系统(GPS)或激光雷达(LiDAR)等昂贵传感器,即可实现避障、场景探索和自主安全着陆操作。

一项关键创新是自适应比例因子算法,该算法通过利用语义地面平面检测和相机内参,将非度量单目深度预测转换为精确的度量距离测量,实现了14.4厘米的平均距离误差。该方法采用知识蒸馏框架,其中基于颜色的支持向量机(SVM)教师网络为轻量级U - Net学生网络(160万个参数)生成训练数据,该学生网络能够进行实时语义分割。对于更复杂的环境,SVM教师网络可以替换为最先进的分割模型。

测试在一个5×4米的可控实验室环境中进行,其中有八个模拟城市结构的纸板障碍物。在现实环境中进行的30次飞行测试和数字孪生环境中进行的100次飞行测试的广泛验证表明,结合分割和深度的方法增加了监视期间的飞行距离,减少了任务时间,同时保持了100%的成功率。

该系统通过端到端学习进一步优化,其中一个紧凑的学生神经网络从我们表现最佳的方法生成的演示数据中学习完整的飞行策略,实现了87.5%的自主任务成功率。这项工作推动了结构化环境中基于视觉的实用无人机导航技术的发展,展示了解决度量深度估计和计算效率挑战的方案,使该系统能够部署在资源受限的平台上。

3. 效果展示

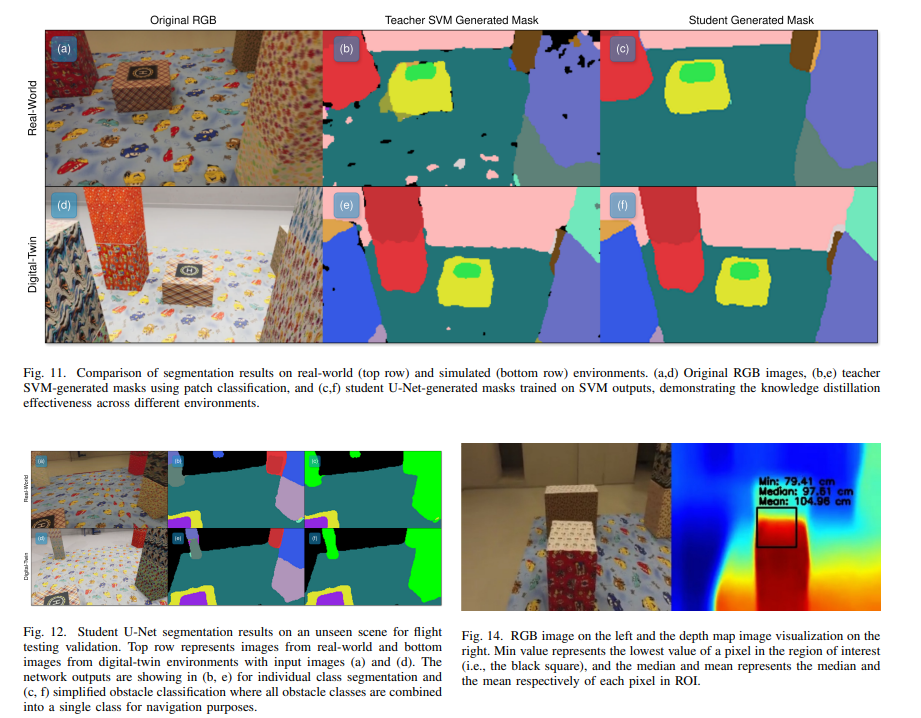

图7:无人机任务连续帧,展示自主停机坪检测、居中和降落过程。语义分割算法识别停机坪(紫/洋红色)及其外框(黄色),无人机自主调整位姿,使停机坪位于相机视野中心。序列中,停机坪由左侧的偏心位置逐步移至中心,无人机同时调整云台姿态,最终获得着陆表面的正射视角。 图8:实时自主飞行演示,展示多任务并行的避障与场景边界保持策略。每块面板同步显示四路视角:无人机原始相机画面(中左)、外部观测视角(右)、语义分割输出(底左)以及深度估计可视化(顶左)。左侧面板展示对高盒障碍的规避过程;右侧面板展示为防止飞出场景边界而进行的主动转向。

图8:实时自主飞行演示,展示多任务并行的避障与场景边界保持策略。每块面板同步显示四路视角:无人机原始相机画面(中左)、外部观测视角(右)、语义分割输出(底左)以及深度估计可视化(顶左)。左侧面板展示对高盒障碍的规避过程;右侧面板展示为防止飞出场景边界而进行的主动转向。

图9:降落全过程示例,包含所有经处理的场景画面以及第三方视角的观察点。

图9:降落全过程示例,包含所有经处理的场景画面以及第三方视角的观察点。

图10:基于SVM的颜色分割性能随训练数据递增的可视化。

(a) 仅用场景1的图像块训练;

(b) 用场景1–2的图像块训练;

(c) 用场景1–3的图像块训练;

(d) 用全部四个场景的图像块训练。

随着场景多样性增加,分割质量逐步提升。

4. 主要贡献

本文的主要贡献总结如下:

-

仅视觉导航:一个多任务系统,结合语义分割、单目相对深度预测以及自适应比例因子,用于自主无人机导航。 -

具有度量深度的3D虚拟安全走廊:一个实时避障系统,使用五平面安全几何结构,实现动态飞行路径优化。 -

可控室内数据集:一个全面的数据集,在自定义的5×4米室内环境数据集中,包含跨多个场景配置的39648帧,用于在可重现的条件下训练和评估基于视觉的无人机任务。 -

真实世界和模拟验证:在真实和数字孪生环境中进行广泛测试,以确保可靠性和鲁棒性,在总共130次飞行测试中,证明了真实环境和模拟环境之间的强相关性。 -

用于嵌入式实现的端到端控制学习:一个轻量级(160万个参数)的自监督网络,用于在小型无人机上进行机载执行,该网络从演示数据中学习完整的飞行策略,实现自主操作,任务成功率达到87.5%。训练采用自监督学习,以提高适应性并减少对标记数据的依赖。

5. 基本原理是啥?

-

结合语义分割与单目深度估计的多任务系统该系统将语义分割与单目相对深度预测相结合,并采用自适应比例因子实现无人机自主导航。语义分割方面,在已知重要物体纹理的情况下,可创建支持向量机(SVM)教师模型生成掩码,用于训练小型学生神经网络进行分割;在更复杂环境中,可使用最先进的网络作为教师模型。深度估计方面,主要聚焦于无监督的SC - Depth变体模型,利用相机内参补偿镜头畸变影响,提高深度测量精度。 -

基于自适应比例因子的度量深度转换由于单目网络提供的相对深度无法通过单一常数比例因子可靠地转换为度量深度,提出了自适应比例因子算法。该算法利用相机内参和外参以及分割出的地毯(已知平行于无人机的平面),实时计算从相机到地毯上随机点的距离,从而得到自适应比例因子,将非度量的单目深度预测转换为准确的度量距离测量。推荐课程:。 -

3D虚拟安全走廊与度量深度的实时避障构建了一个实时避障系统,使用五平面安全几何结构形成3D虚拟安全走廊,实现动态飞行路径优化。通过计算无人机与障碍物的度量距离,结合自适应比例因子和深度估计算法,系统能够预测无人机在一次动作中可安全移动的最大距离,避免碰撞,同时根据场景边界和障碍物情况进行自适应避障。 -

知识蒸馏的语义分割模型加速为实现实时语义分割性能,采用知识蒸馏方法。使用SVM模型为数据集中每第5帧生成分割掩码,然后将这些掩码与原始RGB帧一起用于训练U - Net架构作为更快的学生模型,提高语义分割的速度,使系统能够在实时应用中高效运行。 -

轻量级学生控制网络的自主飞行开发了一个轻量级(160万个参数)的自监督学生控制网络,该网络从结合语义分割和度量深度的自主飞行算法中学习飞行控制策略。网络以RGB帧及其前两帧作为输入,通过全连接层直接预测运动,实现无人机的自主飞行,且能在嵌入式设备上运行,具有一定的自主性和较高的任务成功率。

6. 实验结果

文章针对提出的视觉自主飞行系统开展了实验测试,验证了算法的有效性。相关实验结果如下:

-

语义分割实验结果

-

推理优化:基于网格的采样方法显著降低了计算强度,但导致分类对象呈点状。通过形态学膨胀填充缺失区域,虽在对象边缘引入额外像素,但计算效率提升明显。 -

错误处理:采用连通组件分析,保留每个类段的最大组件,有效避免基于HSV的分割中的误分类,对小对象效果显著。 -

模型改进:使用基于U - Net架构的神经网络进行实时类分割,作为知识转移算法,比原方法更快、更准确、更一致。 -

数据增强与损失函数:对数据集进行特定的HSV和几何变换增强,采用分类交叉熵损失在17 - 掩码分割上取得最佳结果。 -

深度估计实验结果

-

模型评估:使用未参与训练的视频序列和实时飞行测试评估单目深度估计算法,模型在应用比例因子到较近测量值(50厘米内)时表现良好,但在检测较远特征时误差较大(可达100厘米)。 -

数据集适用性:在Nyu Depth V2数据集上训练的模型在实验室环境中深度估计不一致,不适合该特定应用。 -

自适应比例因子:提出使用相机内参和分割地毯计算自适应比例因子,实现轻量级和快速的度量深度缩放。 -

自适应比例因子实验结果

-

实验设计:设计控制实验,利用相机内外参和地面真实距离评估自适应比例因子。通过均匀随机分布在分割地毯区域采样50个点,计算中值比例因子以减少异常值影响。 -

性能对比:与Depth Pro和MoGe等先进模型相比,该方法在均值和中值误差指标上表现良好,标准差低,尤其在处理图像中距离较远的点对时优势明显。 -

推理时间:推理速度达48.54 FPS,远快于MoGe(3.43 FPS)和Depth Pro(0.33 FPS),虽需相机校准参数和地面平面信息,但适合实时无人机应用。 -

误差分析:计算的比例因子在测量数据集上的最大误差为0.3714米,主要出现在纹理较差的区域。 -

视觉自主飞行实验结果

-

实验设置:使用分割结合和不结合度量深度的两种算法进行系统评估,每次试验包括90秒自主探索和返回基地序列。 -

成功标准:成功完成任务(自主起飞、避障、检测降落点并安全降落);任务失败(碰撞、飞出指定区域或未在300秒内完成);坠毁事件(与障碍物物理接触)。 -

实验次数:每种方法在现实世界进行30次实验,在模拟环境进行100次实验。 -

性能提升:结合度量深度估计和分割的方法在多个操作指标上显著优于仅使用分割的方法,包括更快的降落点检测和着陆时间,以及更广泛的搜索范围。 -

环境相关性:现实世界和模拟环境结果高度相关,验证了数字双胞胎方法的有效性。 -

学生控制网络实验结果

-

模型设计:开发轻量级神经网络(160万参数),从视觉自主飞行教师算法学习飞行控制策略,架构受U - Net启发,修改用于回归任务。 -

初始性能:初始40次试验中,30次成功飞行,10次坠毁,主要原因是碰撞障碍物。 -

改进尝试:降低无人机运行速度未显著降低坠毁率,通过增加靠近障碍物飞行段的数据增强训练集,成功飞行次数增至35次。

7. 总结 & 未来工作

总结

本文展示了一种适用于小型无人机在可控室内环境下的仅依赖视觉的自主飞行系统,通过集成语义分割和度量深度估计实现了可靠导航。通过130次飞行测试的实验验证,确定了可衡量的性能提升,并明确了当前基于视觉方法的能力和局限性。

-

核心技术创新:自适应比例因子算法是主要技术贡献,能将非度量单目深度预测转换为度量测量,平均误差为14.4厘米,解决了仅视觉导航系统中的一个基本挑战,实现安全自主飞行所需的实时距离计算。知识蒸馏框架从具有控制算法和两个神经网络的复杂系统过渡到U - Net学生网络(160万个参数),表明在资源受限的平台上也能实现高效的语义分割,同时保持实时性能。 -

数据集与仿真环境:在可控室内环境中创建了模拟城市景观的自定义数据集,为训练和评估自主飞行能力提供了资源。此外,在虚幻引擎和Parrot Sphinx模拟器中创建数字孪生体,确保在现实世界中应用算法之前进行安全测试,显著降低了开发过程中硬件损坏的风险。 -

模型训练与性能:在特定领域数据上训练深度估计和语义分割模型可显著提高性能。语义分割方法通过从支持向量机(SVM)教师到U - Net学生网络的知识蒸馏过程实现,在对无人机导航至关重要的元素进行语义分割时,实现了实时性能、高精度和低标注成本。 -

轻量级网络的局限性:轻量级学生控制网络虽然在边缘部署方面显示出潜力,任务成功率达到87.5%,但也揭示了端到端学习方法的当前局限性。12.5%的失败率主要是由于碰撞事件,这表明直接从演示数据中学习策略需要更强大的训练策略或额外的安全机制,以达到模块化双网络方法的可靠性。 -

系统应用局限性:当前系统在可控环境中运行高效,但在更复杂的动态环境中可能面临挑战。不过,通过用先进技术替换语义分割模型,有望在更复杂环境中取得类似效果。

未来展望

未来,研究团队将着重改进以下几个方面:

-

优化学生控制网络:提高学生控制网络的性能,使其在保持计算效率的同时,达到双模型方法的可靠性水平。 -

拓展系统功能:扩展系统能力,以应对动态障碍物,并实施更复杂的路径规划算法,这些算法不仅要考虑即时避障,还要考虑全局任务目标。

3D视觉1V1论文辅导来啦!

3D视觉学习圈子

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群成立啦!