摘要

Abstract

EgoVLA:一个视觉-语言-动作模型,通过明确地建模手腕和手部动作,在以自我为中心的人类视频上进行训练。

该模型的关键突破在于:

1)用人类视频解决了机器人训练数据瓶颈;

2)提出了统一的手腕-手部动作表示;

3)在仿真环境中验证了优越性。

项目地址:

https://rchalyang.github.io/EgoVLA/

用于模仿学习的真实机器人数据收集带动了机器人的重大进步。然而,过程中对机器人硬件的要求从根本上制约了数据的规模。在本文中,我们探索了使用以自我为中心的人类视频训练视觉-语言-行动(VLA)模型。使用人类视频的好处不仅在于其规模,更重要的是场景和任务的丰富性。

通过在人类视频上训练的 VLA 可以预测人类手腕和手部动作,我们可以执行反向运动学和重定向,将人类动作转换为机器人动作。我们使用一些机器人纵演示来微调模型,以获得机器人策略,即 EgoVLA。我们提出了一个名为 Ego Humanoid Manipulation Benchmark 的模拟基准测试,我们在其中设计了各种双手作任务并进行了演示。我们使用 Ego Humanoid Manipulation Benchmark 对 EgoVLA 进行微调和评估,并显示出比基线的显着改进,并消除了人类数据的重要性。

EgoVLA 是一种视觉-语言-动作 (VLA) 模型,它将人类自我中心视频的广泛多样性与机器人演示的精确性相结合。它首先在大规模人类纵数据上进行预训练,学习从视觉观察、语言指令和本体感觉信号中预测未来的手和手腕运动。通过基于手腕姿势和 MANO 手部参数的统一表示来对齐人和机器人的动作空间,EgoVLA 可以对域内机器人演示进行高效的微调。人类视频预训练不是取代机器人数据,而是通过提高跨不同任务、视觉场景和空间配置的泛化性来补充它,从而减少对特定任务的机器人数据的需求,并实现更灵活和可扩展的作功能。

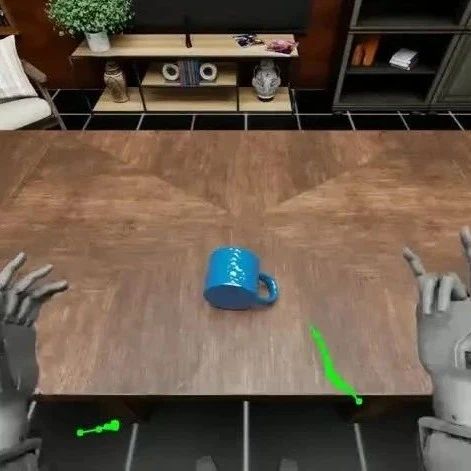

EgoVLA 将视觉历史记录、语言指令和作查询令牌作为输入。潜在特征通过动作头转换为人体动作。我们使用手腕姿势和 MANO 手部参数作为人/机器人统一动作空间。

统一行动空间:MANO 手部参数用作人类和机器人的共享动作空间。对于机器人手,在训练过程中,优化的 mano 参数会产生与机器人手指尖相同的指尖位置。一个小型 MLP 在部署期间将预测的指尖位置映射到联合命令。

人类预测

红线表示地面实况, 而绿线表示 EgoVLA 预测的人类手腕运动。

基准测试

除了数据稀缺之外,基于学习的机器人技术的一个关键挑战是缺乏可扩展和可重复的评估。实际测试成本高昂、耗时且通常不安全,特别是对于学术实验室等资源有限的环境。最近的研究表明,仿真结果通常与实际性能非常吻合,使其成为可靠的评估代理。为了支持人形作的一致基准测试,我们推出了与 NVIDIA Isaac 实验室构建的 Ego 人形作基准测试。我们的基准测试(在精神上类似于 LIBERO 和 SIMPLER)不是实现直接的模拟到真实传输,而是作为评估作策略的可重复测试平台。它采用 Unitree H1 人形机器人和两只灵巧的 Inspire 手,包括 12 项任务,从短视野原子动作到长视野、多阶段技能。

人类预测指令遵循

在人类数据集中使用原始语言指令进行预测

定量结果

对以自我为中心的人类视频进行预训练可显着提高域内性能和域外泛化。EgoVLA 在所有任务中都优于无预训练基线,在长视野和细粒度作任务中尤其具有强劲的收益。它还能更好地泛化到看不见的视觉背景,保持高成功率和进步率,而仅根据机器人数据训练的模型性能急剧下降。

消融研究和空间分析

左:数据混合消融。EgoVLA 在以自我为中心的数据集的不同混合物上进行预训练,在看不见的视觉背景上评估短视程任务。更大的多样性会持续提高泛化性能。

右:空间分布。EgoVLA 在看不见的视觉背景下的成功率和进度,在物体生成位置可视化。该模型在大范围内保持强大的性能,在通常与有效双手作相关的区域取得了更高的成功率。

往期文章

全球首篇自动驾驶VLA模型综述重磅发布!麦吉尔&清华&小米团队解析VLA自驾模型的前世今生

字节跳动Seed实验室发布ByteDexter灵巧手:解锁人类级灵巧操作

具身专栏(三)| 具身智能中VLA、VLN、VA中常见训练(training)方法

具身专栏(二)| 具身智能中VLA、VLN分类与发展线梳理

具身专栏(一)| VLA、VA、VLN概述

π0.5:突破视觉语言模型边界,首个实现开放世界泛化的VLA诞生!

斯坦福&英伟达最新论文:CoT-VLA模型凭"视觉思维链"实现复杂任务精准操控

RoboTwin2.0全面开源!多模态大模型驱动的双臂操作Benchmark ,支持代码生成!

开源!Maniskill仿真器上LeRobot的sim2real的RL训练代码开源(附教程)

迈向机器人领域ImageNet,大牛PieterAbbeel领衔北大、通院、斯坦福发布RoboVerse大一统仿真平台

CVPR 北大、清华最新突破:机器人操作新范式,3.3万次仿真模拟构建最大灵巧手数据集

人形机器人四级分类:你的人形机器人到Level 4了吗?(附L1-L4技术全景图)建议收藏!

斯坦福最新论文:使用人类动作的视频数据,摆脱对机器人硬件的需求

爆发在即!养老机器人如何守护2.2亿老人?产业链+政策一览,建议收藏!