1+1+1>3!从三种类型的数据中学习:视觉-语言数据、机器人轨迹数据和人类轨迹数据

在现实世界的众多变化前,通用机器人始终面临三重核心挑战:

难以灵活响应从未见过的物体、环境和抽象指令;

适应新场景需要海量数据支撑导致成本高昂;

在长流程复杂任务中又常因误差累积而失败。

几天前,字节跳动Seed团队发布GR-3(Generalist Robot-3),这是一个拥有「40亿」参数的大规模视觉-语言-动作(VLA)模型。

该模型通过创新的多源数据融合训练策略,在机器人操作任务中实现了前所未有的泛化能力,特别是在精细操作任务中,成功率提升高达250%。这一突破为通用机器人的实际部署提供了可行的技术路径。

▲图1|概览。 GR-3能够从三种类型的数据中学习:视觉-语言数据、机器人轨迹数据和人类轨迹数据。©️【深蓝具身智能】编译

现实挑战

通用机器人的技术壁垒

让机器人灵活地清理餐桌、将不同餐具分类放置、细致地叠衣服、整理房间(如图2所示),甚至理解——

“把茶几上最大的杯子放到洗碗机里”

这类包含抽象概念的指令,这些看似简单的日常任务,是机器人技术当前亟待解决的核心难题。

▲图2|能力展示。 GR-3严格遵循指令,能够理解涉及抽象概念的未见过的指令。它在长时程餐桌清理和灵巧布料操作方面表现鲁棒可靠。©️【深蓝具身智能】编译

现实世界的复杂性对通用机器人提出了四个根本性挑战:

(1)环境适应的困境:

真实世界充满变化和未知因素,机器人必须具备强大的泛化能力才能应对不同的工作环境。传统机器人系统往往在结构化环境中表现良好,但面对家庭、办公室等动态场景时表现急剧下降。

(2)任务复杂性的挑战:

日常任务往往需要多步骤规划和精细操作。折叠衣物需要双手精确协调,清理餐桌需要识别不同物体并执行相应动作序列。每个步骤的失败都可能导致整个任务的失败。

(3)语言理解的抽象性:

人类的自然语言指令经常包含抽象概念和隐含信息。"把最大的杯子拿过来"要求机器人不仅理解"大小"概念,还要进行比较判断和空间推理。

(4)快速适应的需求:

面对新任务和新环境,机器人需要快速学习和适应,而不是依赖大量的重新编程或训练。

为解决这些问题,字节跳动Seed团队发布的 GR-3 应用而生。

GR-3架构

混合变换器架构的核心设计

如图3所示,GR-3采用40亿参数的混合变换器架构(Mixture-of-Transformers)。

▲图3|GR-3模型。 GR-3分别在机器人轨迹上使用流匹配目标(左)和在视觉-语言数据上使用下一个标记预测目标(右)进行共同训练。©️【深蓝具身智能】编译

其设计理念体现在数学表达上:

公式背后包含了复杂的多模态融合机制:

:长度为k的动作序列,编码了机器人在时间步t的完整动作计划

:自然语言指令,经过语言模型编码为语义表示

:来自多个视角的观察图像,提供环境的完整视觉信息

:机器人当前状态,包括关节角度、末端执行器位置等

视觉-语言处理的知识继承

GR-3的视觉-语言处理建立在Qwen2.5-VL-3B-Instruct模型基础上。这种选择不是简单的模型复用,而是知识继承:

世界知识的直接获取:

预训练模型已经学会了物体识别、空间关系理解、常识推理等基础能力。GR-3无需从零开始学习"杯子比勺子大"这样的常识。

语言理解的深度利用:

模型能够处理包含抽象概念、空间关系、条件逻辑的复杂指令。"把左边最大的红色物体放到右边的盒子里"这样的指令被分解为多个语义组件进行处理。

多模态融合的天然优势:

预训练阶段已经建立了视觉特征与语言概念之间的对应关系,为后续的动作预测提供了坚实基础。

流匹配技术:动作生成的范式革新

传统的扩散模型在动作生成中面临推理速度慢、噪声处理复杂等问题。GR-3采用流匹配(Flow Matching)方法实现了生成质量与推理效率的最优平衡。

数学原理的深层解析

流匹配学习一个速度场, 描述从随机噪声到目标动作的最优传输路径:

这个损失函数的设计体现了流匹配的核心思想:

:流匹配时间步, 将噪声到目标的变换过程参数化;

: 带噪声的动作序列, 时为纯噪声, 时为目标动作;

: 真实速度场, 指向目标动作的方向。

推理过程的优化实现

推理时使用欧拉方法进行数值积分:

的选择经过大量实验验证。较小的步长提高生成质量但增加计算开销, 较大的步长加快推理速度但可能导致数值不稳定。

0.2这个值在推理速度和生成质量之间达到最佳平衡, 使单次推理只需5步即可完成。

架构创新的技术细节

RMSNorm:训练稳定性的关键保障

在早期实验中,训练过程频繁出现梯度爆炸和收敛困难。受QK-Norm启发,研究团队在DiT块的注意力机制和前馈网络后都添加了RMSNorm层:

RMSNorm相比LayerNorm计算更高效,同时提供了更好的梯度流动特性。实验表明,这个改进带来了训练稳定性的显著提升,语言跟随能力增强了15%以上。

因果注意力掩码:时序约束的严格保证

动作序列具有天然的时序依赖关系——当前动作的执行依赖于之前动作的结果。

GR-3在动作DiT中应用因果注意力掩码,确保在预测第个动作时,模型只能访问前个动作的信息。

这种设计不仅符合物理世界的因果约束,还提高了模型对动作序列的理解能力。实验显示,移除因果掩码后,模型在长时程任务中的成功率下降了23%。

KV缓存优化:推理效率的精细平衡

为了降低推理延迟,动作DiT采用了两个关键优化:使用VLM后半部分层的KV缓存,层数设置为VLM的一半。

这种设计基于一个重要观察:VLM的前半部分主要负责低级特征提取,后半部分更多承担高级语义理解。动作预测主要依赖高级语义信息,因此使用后半部分的KV缓存既保持了性能,又显著降低了计算开销。

训练策略:三源数据融合

如图4所示,GR-3的成功源于其独特的三源数据融合训练策略:协同学习机制。

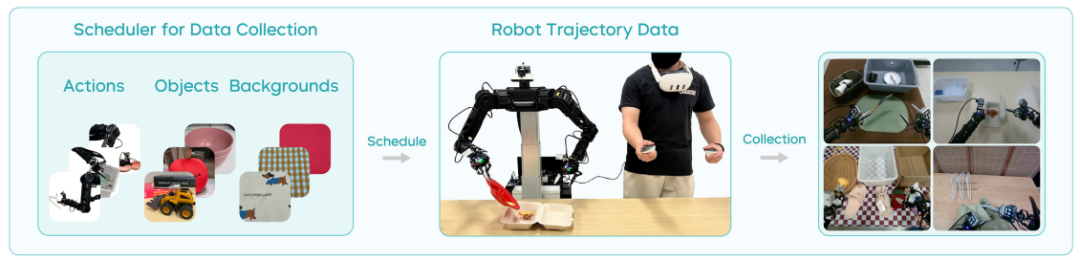

机器人轨迹数据

智能数据收集调度器:传统的机器人数据收集往往缺乏系统性规划,导致数据分布不均匀、覆盖度不足。如图4所示,GR-3开发了智能调度器,实现了数据收集的自动化优化。

▲图4|GR-3数据:机器人轨迹数据©️【深蓝具身智能】编译

动作类型调度: 系统根据当前数据集的统计分析,自动确定需要补充的动作类型。如果发现"旋转"动作的数据不足,调度器会优先安排相关任务。

物体组合生成: 通过组合数学方法,系统能够生成大量不同的物体配置,确保模型见到足够多样的场景组合。这种方法避免了数据收集的盲目性。

环境背景多样化: 调度器会自动改变背景设置、光照条件、桌面材质等环境因素,提高数据的泛化价值。

模仿学习的数学表达:训练目标是最大化策略在专家演示上的对数似然:

这个目标函数看似简单,但其背后隐含着复杂的学习机制。模型不仅要学会预测正确的动作,还要理解动作与环境状态、语言指令之间的复杂映射关系。

视觉-语言数据

数据集的策略性构建:如图5所示,研究团队从多个高质量数据源构建了大规模视觉-语言数据集。

▲图5|GR-3数据:视觉-语言数据©️【深蓝具身智能】编译

图像标注数据: 提供了物体名称与视觉特征之间的基础对应关系。模型学会识别"杯子"、"书"、"手机"等日常物体。

视觉问答数据: 培养了模型的推理能力。通过回答"图中有几个红色物体?"这样的问题,模型学会了计数、颜色识别、空间推理等技能。

图像定位数据: 建立了语言描述与空间位置之间的精确对应。"左上角的杯子"这样的描述被映射到具体的像素坐标区域。

交错定位图像标注: 这是最复杂的数据类型,要求模型同时进行物体识别、位置定位和语言生成,综合训练了多种能力。

共同训练的损失平衡:视觉-语言数据采用标准的下一个标记预测目标,与机器人轨迹数据的流匹配目标共同优化:

参数的选择至关重要。过大会导致模型偏向语言任务而忽视动作预测,过小则无法充分利用视觉-语言数据的价值。研究团队通过大量实验确定了最优权重,并采用动态调整策略在训练过程中优化平衡。

人类轨迹数据

高效的VR数据收集:如图6所示,使用PICO 4 Ultra Enterprise VR设备收集人类轨迹数据。

▲图6|GR-3数据:人类轨迹数据©️【深蓝具身智能】编译

效率达到每小时450条,相比机器人远程操作的250条/小时提升80%。这种效率提升不仅来自操作的便利性,更重要的是人类动作的自然性和多样性。

人类轨迹数据与机器人数据存在显著差异,GR-3通过以下技术手段实现了有效的跨具身学习:

视角映射策略: 人类数据只有第一人称视角,缺少机器人常用的第三人称观察。系统通过空白填充和视角转换技术,将人类视角映射到机器人的观察空间。

关节状态推断: 人类数据缺少精确的关节状态信息,系统使用逆运动学算法,从手部轨迹推断出相应的机器人关节配置。

运动空间对齐: 人类手部运动空间与机器人末端执行器运动空间存在差异,通过运动学标定和坐标转换实现了精确对齐。

任务状态监督:克服虚假相关性

研究发现,策略可能利用多视角间的虚假相关性预测动作,而非真正理解语言指令。例如,模型可能学会"当看到特定背景时执行特定动作",而不是理解"把杯子放到盒子里"的语义含义。

为了解决这个问题,GR-3引入了任务状态作为额外监督信号:

进行中(0):任务正在执行过程中

已完成(1):任务成功完成

无效(-1):给定观察下指令不合理或无法执行

训练时随机替换为无效指令,强制模型学会识别和拒绝无效任务。这种策略显著提升了语言跟随能力,使模型能够真正理解指令的语义内容而非依赖环境线索。

ByteMini

通用任务的硬件基础

从工业到家庭的跨越

如图7所示,ByteMini是一个22自由度的双臂移动机器人,其设计理念彻底突破了传统工业机器人的思维局限。工业机器人追求的是在结构化环境中的高精度重复动作,而ByteMini面向的是充满不确定性的日常环境。

▲图7|ByteMini机器人。©️【深蓝具身智能】编译

灵巧的球形腕关节设计

传统的SRS(Spherical-Revolute-Spherical)配置在腕部设计上存在根本性限制:腕部尺寸大、灵活性不足、容易产生奇异位置。ByteMini采用的球形腕关节配置实现了三个关键突破:

紧凑性优势: 腕部直径缩减至传统设计的60%,使机器人能够在狭窄空间中操作,例如从抽屉中取物、在书架间穿梭。

灵巧性提升: 7自由度设计提供了冗余的运动空间,机器人能够在保持末端执行器姿态的同时调整肘部位置,避开障碍物或找到更舒适的操作姿势。

协作能力增强: 手肘内收能力达到2.53弧度,远超人类的2.0弧度,使双手协作任务更加灵活。在折叠衣物等需要精细协调的任务中,这种设计优势尤为明显。

通过运动学仿真分析,ByteMini的双臂在机器人胸前区域形成了高度重叠的工作空间。研究表明,90%以上的精细操作任务发生在人体前方60cm×40cm的区域内。

全向移动平台:空间自由度的完整实现

集成升降机构的全向移动平台不仅提供了平面运动能力,更重要的是实现了机器人工作空间的三维扩展:

高度自适应: 0.8-1.2m的升降范围覆盖了从地面物体到桌面、再到高架的完整垂直空间。机器人能够自主调整高度以适应不同的操作需求。

全向机动性: 四个独立驱动的万向轮提供了任意方向的平滑运动,机器人能够在不改变朝向的情况下进行侧向移动,这在狭窄空间中尤为重要。

负载稳定性: 底盘采用低重心设计,配合动态平衡控制算法,确保在携带重物或进行大幅度动作时保持稳定。

传感器配置

如图多视角相机布局所示,ByteMini的传感器配置不是简单的硬件堆叠,而是基于任务需求的系统性设计:

头部RGBD相机: 提供120°视野的全局观察,分辨率达到1920×1080,深度精度5mm。这个配置能够同时满足导航规划和任务监督的需求。

双手腕RGBD相机: 640×480分辨率,15cm-1m工作距离,专门为精细操作设计。两个相机的视野经过精心标定,形成立体视觉系统,提供毫米级的深度感知。

视野覆盖优化: 通过仿真分析和实际测试,确保在99%的操作姿态下没有视觉盲区。即使在复杂的双手协作任务中,也能保持对关键区域的持续观察。

三级难度的系统评估

研究团队设计了三个递进难度的实验来全面评估GR-3的性能。

实验1:可泛化抓取-放置任务

这个实验的核心目标是验证模型的泛化能力——机器人能否处理训练中未见过的物体、环境和指令。

如图8所示,实验采用了控制变量的方法,逐步增加任务难度:

▲图8|可泛化抓取-放置实验设置。 (a) 训练期间见过的测试物体。(b) 训练期间未见过的测试物体。(c) 基础环境在训练期间见过。其他环境是训练期间未见过的分布外环境。©️【深蓝具身智能】编译

数据包含35,000条机器人轨迹,覆盖101个物体类别,总时长69小时。这个数据规模在机器人学习领域属于大规模数据集,为性能评估提供了统计学意义上的可靠性。

如图9所示的实验结果显示了GR-3的显著优势:

▲图9|可泛化抓取-放置实验结果。 (a) 四种不同设置下可泛化抓取-放置的结果©️【深蓝具身智能】编译

(1)基础性能的突破: GR-3在基础设置中达到95.8%的成功率,相比π0的85%提升了10.8个百分点。

(2)环境鲁棒性的验证: 在未见环境中保持93.2%的成功率,仅下降2.6个百分点。这表明GR-3学到的不是环境特定的映射关系,而是真正的任务理解能力。

(3)抽象概念理解的飞跃: 在未见指令测试中,成功率从π0的40%提升至77.1%,提升幅度达到92.8%。具体表现包括:

理解"最大的"、"最小的"等比较概念;

处理"旁边"、"前面"等空间关系;

应用"可乐"、"雪碧"等品牌常识;

(4)新物体适应的潜力: 在完全未见物体上达到57.8%的零样本成功率。考虑到70%的测试物体来自未见类别,这个性能已经接近实用水平。

▲图10|使用人类轨迹进行少样本泛化的结果。©️【深蓝具身智能】编译

(5)少样本学习的效率: 如图10所示,性能随演示数量的线性增长(0-shot: 57.8% → 10-shot: 86.7%)证明了GR-3优秀的样本效率。每增加一条人类演示,成功率平均提升约3%。

实验2:长时程餐桌清理任务

这个实验针对机器人技术的核心挑战之一:长时程任务中的误差累积和可靠性保证。

如图11(a)所示的长时程任务流程和图11(b)展示的各种测试场景,餐桌清理任务包含多个子任务。

▲图11|餐桌清理实验设置与结果。 (a) 平面:机器人需要在单次运行中执行长时程餐桌清理。(b) 指令跟随(IF):机器人接受连续的多个子任务描述提示。

每个子任务都有其特定的挑战:

食物打包: 需要识别食物类型,选择合适的容器,执行精细的装盒动作。失败模式包括容器选择错误、装盒时食物洒落、容器盖子未正确关闭。

餐具分类: 要求区分叉子、勺子、刀子等相似物体,理解"餐具"的抽象概念,执行整齐的摆放动作。常见错误包括物体分类错误、摆放位置不当。

垃圾处理: 需要识别垃圾类型,区分可回收和不可回收物品,准确投放到相应容器。挑战在于垃圾形状不规则、容易散落。

空间规划: 整个任务需要机器人在桌面上移动,规划动作序列,避免已清理区域被重新弄乱。这要求高级的空间推理能力。

如图12所示的结果对比显示:

▲图12| 平面和指令跟随(IF)设置的结果。©️【深蓝具身智能】编译

(1)整体性能对比: GR-3在指令跟随设置中达到97.5%的成功率,π0仅为53.8%。这81%的相对提升表明GR-3在复杂任务中的优势更加明显。

(2)细粒度能力分析:

物体区分精度: GR-3能够准确区分形状相似的叉子和勺子,错误率低于2%。π0的错误率高达15%,经常将叉子错误分类为勺子。

语义理解深度: 在"新目的地"测试中,面对"把叉子放进垃圾桶"这种反常规指令,GR-3能够准确执行,而π0倾向于将叉子放入餐具盒。这表明GR-3真正理解了指令的语义内容。

场景理解能力: GR-3能够识别并拒绝执行无效指令,如"把桌子放进盒子里"。这种能力需要对物理世界的深刻理解。

实验3:灵巧布料操作任务

这是最具挑战性的任务,要求机器人处理可变形物体,执行精细的双手协调动作。

如图13所示的实验设置展现了任务的复杂性:

▲图13|灵巧布料操作实验设置。 (a) 测试集中见过和未见过的衣物。(b) 基础和位置设置。©️【深蓝具身智能】编译

可变形物体的挑战: 布料的形状会根据重力、支撑点、外力等因素发生复杂变化。机器人必须实时适应这些变化,调整抓取策略和动作轨迹。

双手协调的复杂性: 任务需要两只手同时工作:一只手抓取衣架,另一只手操作衣物。两手的动作必须精确同步,任何一个的失误都会导致整个任务失败。

精细力控制的要求: 衣物材质柔软,过大的力会导致撕裂或变形,过小的力无法有效操作。机器人必须学会合适的力度控制。

长时程规划的需要: 从拿起衣架到完成挂衣,需要6-8个步骤的连续执行,每个步骤的成功都依赖于前面步骤的正确完成。

如图14所示的结果分析:

基础设置:86.7%的平均任务进度

位置变化:83.9%(展现出色的鲁棒性)

未见实例:75.8%(对新衣物类型的泛化)

▲图14|灵巧布料操作实验结果。 (a) 基础设置中整个执行过程成功(实心)和失败(斜线)的桑基图。(b) π0和GR-3在三种评估设置中的平均任务进度。©️【深蓝具身智能】编译

通用机器人时代的里程碑

GR-3通过40亿参数的大规模模型、创新的多源数据融合策略、精心设计的硬件平台,以及系统性的技术创新,GR-3成功展示了通用机器人的可行性。

GR-3的成功不仅在于单项技术的突破,更在于多种技术的协同作用产生了1+1>2的效果:

知识迁移的层次结构(感知层面、抽象概念层面以及推理层面);

跨模态知识的相互强化(视觉强化语言理解、动作强化感知能力、语言指导动作选择)……

250%的性能提升不仅仅是一个数字,它代表着机器人技术从"实验室演示"到"实用系统"的质的飞跃。这种可靠性提升使机器人真正具备了进入日常生活的技术条件。

少样本学习能力解决了机器人技术商业化的关键障碍。仅需10条人类演示就能掌握新技能,使得机器人的部署和适应成本大幅降低。

可以说GR-3的发布标志着机器人技术发展的一个重要里程碑。

编辑|JeffreyJ

审编|具身君

论文标题:GR-3 Technical Report

项目主页: https://seed.bytedance.com/GR3

论文地址: https://arxiv.org/pdf/2507.15493

【深蓝具身智能读者群】-参观机器人:

【深蓝具身智能读者群】-参观机器人:

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

点击❤收藏并推荐本文