在人工智能领域,OpenAI一直是技术创新的风向标。今天凌晨,OpenAI再次掀起波澜,发布了其开源重量级模型——gpt-oss-120b和gpt-oss-20b。

概览见:💥重磅,OpenAI开源!发布自GPT-2以来首批开源权重模型GPT-OSS系列,媲美o4-mini,还适配消费级硬件和边缘设备

这两款模型以Apache 2.0许可证发布。它们不仅具备强大的推理、工具使用和指令遵循能力,还在安全性上进行了深度优化,为开发者、企业乃至全球AI生态系统带来了全新的可能性。本文将从第三方视角,深入剖析这两款模型的架构、性能、安全性以及对AI行业的深远影响,带您一窥这场开源革命的魅力。

模型概览:性能与效率的完美平衡

gpt-oss-120b和gpt-oss-20b是基于自回归混合专家(Mixture-of-Experts, MoE)Transformer架构设计的文本模型,继承了GPT-2和GPT-3的优良基因。

gpt-oss-120b拥有36层,116.8亿个总参数,每前向传播使用约51亿个“活跃”参数;而gpt-oss-20b则拥有24层,209亿个总参数,每前向传播约36亿个活跃参数。两款模型均采用了MXFP4格式的量化技术,将大部分权重压缩至4.25位,从而显著降低了内存占用。gpt-oss-120b可在单张80GB GPU上运行,而gpt-oss-20b甚至能在16GB内存的设备上流畅工作。这种高效的设计让高性能AI模型的部署变得更加普惠。

两款模型在架构设计上也颇具亮点。它们采用了2880维的残差流维度,通过根均方归一化(RMSNorm)优化了激活函数的稳定性。MoE模块是其核心创新之一,gpt-oss-120b拥有128个专家,gpt-oss-20b拥有32个专家,通过线性路由器选择每token的前4个专家,并结合SwiGLU激活函数提升性能。注意力机制方面,模型交替使用带宽为128 token的带状窗口和全稠密模式,结合分组查询注意力(GQA)和旋转位置嵌入(RoPE),将上下文长度扩展至131,072 token。这种设计不仅提升了模型的长序列处理能力,还通过学习偏置优化了注意力分配。

数据与训练:技术与安全的双重保障

在预训练阶段,OpenAI为gpt-oss模型准备了包含数万亿token的文本数据集,涵盖STEM、编程和通用知识领域。为了确保安全性,训练数据经过严格过滤,剔除了涉及危险生物安全知识的内容,沿用了GPT-4o的CBRN(化学、生物、放射性和核)过滤器。知识截止日期为2024年6月,确保模型内容的时效性。

训练过程在NVIDIA H100 GPU上进行,使用PyTorch框架和优化的Triton内核,gpt-oss-120b耗费210万H100小时,而gpt-oss-20b仅需约十分之一的计算资源。Flash Attention算法的引入进一步降低了内存需求,加速了训练过程。

后训练阶段则聚焦于推理能力和工具使用的优化。OpenAI采用了与o3模型类似的链式推理(CoT)强化学习技术,使模型能够通过逐步推理解决复杂问题,并支持包括网络搜索、Python代码执行等在内的工具使用。

模型的个性与ChatGPT等产品相似,能够提供友好且一致的用户体验。

此外,OpenAI引入了独特的“Harmony Chat Format”,通过特殊token和关键字(如User、Assistant)划分消息边界,并定义了System > Developer > User > Assistant > Tool的指令层次结构,确保模型在多方交互中能够正确处理指令冲突。

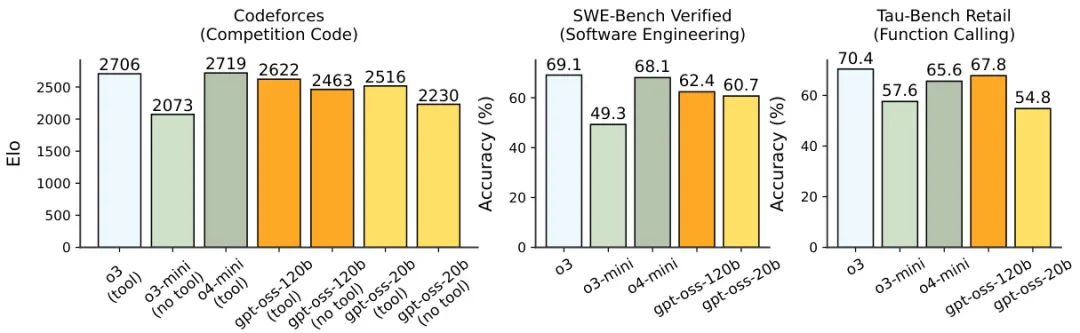

图1:编码与工具使用结果。图示展示了gpt-oss模型在Codeforces、SWE-Bench和τ-Bench上的表现。gpt-oss-120b接近o4-mini的性能,特别是在编码和工具使用任务中表现突出。

性能评估:多领域能力的全面突破

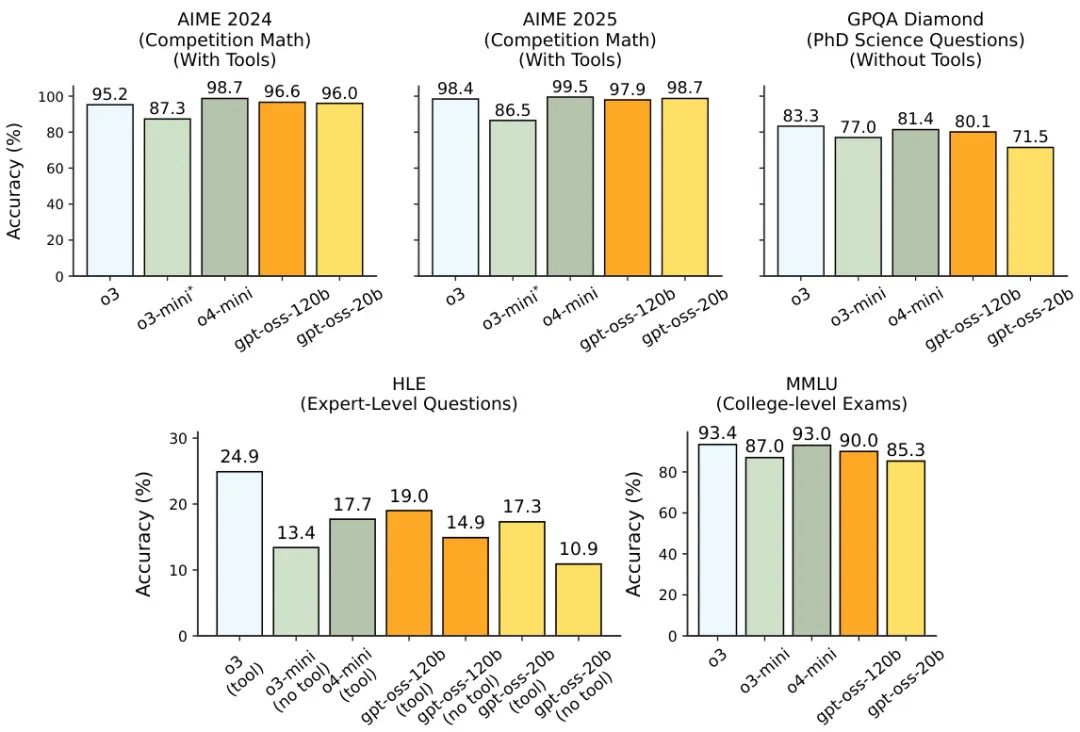

gpt-oss模型在多个基准测试中展现了令人瞩目的性能。在推理和事实性任务(如AIME、GPQA、MMLU和HLE)中,gpt-oss-120b在高推理模式下接近OpenAI o4-mini的准确率,尤其在数学任务中表现出色,平均每道AIME问题使用超过2万个CoT token。gpt-oss-20b尽管参数量较小,但在AIME 2025(带工具)测试中仍达到98.7%的准确率,展现了惊人的性价比。

图2:模型能力评估。图示比较了gpt-oss模型在高推理模式下与OpenAI o3、o3-mini和o4-mini在标准基准测试上的表现。gpt-oss-120b超越o3-mini,接近o4-mini的准确率,而gpt-oss-20b尽管参数量小6倍,仍表现出色。

图3:不同推理模式下的推理能力评估。图示使用三种不同的推理模式(低、中、高)对 AIME 和 GPQA 进行评估,并绘制准确率与平均 CoT + 答案长度的关系图。

图3:不同推理模式下的推理能力评估。图示使用三种不同的推理模式(低、中、高)对 AIME 和 GPQA 进行评估,并绘制准确率与平均 CoT + 答案长度的关系图。

在编码任务中,gpt-oss-120b在Codeforces和SWE-Bench Verified上表现优异,Elo评分高达2622(带工具),接近专业水平。工具使用方面,模型在τ-Bench Retail测试中展现了强大的函数调用能力。

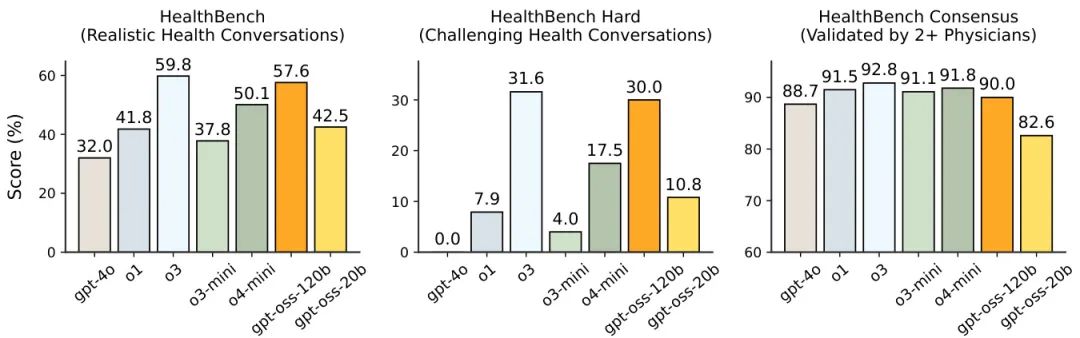

在健康领域,gpt-oss-120b在HealthBench和HealthBench Hard测试中几乎与OpenAI o3持平,远超GPT-4o和o4-mini,展现了在医疗对话和复杂健康问题上的潜力。这对于全球健康领域尤为重要,因为开源模型的低成本和高性能有望推动AI在隐私敏感和资源有限场景中的应用。需要注意的是,这些模型并非用于诊断或治疗,而是辅助健康知识的传播。

图4:健康性能评估。图示显示gpt-oss-120b在HealthBench和HealthBench Hard上的表现接近OpenAI o3,优于GPT-4o和o4-mini,gpt-oss-20b也优于o1。

多语言能力是gpt-oss的另一大亮点。在MMMLU测试中,gpt-oss-120b在14种语言的平均准确率达到81.3%,其中在西班牙语和葡萄牙语等语言中表现尤为突出。尽管在斯瓦希里语和约鲁巴语等低资源语言上性能稍逊,但整体表现接近o4-mini,显示了其在全球多语言场景中的潜力。

安全性:开源模型的严苛守护

开源模型的安全性一直是业界关注的焦点。OpenAI在gpt-oss模型的设计中融入了多层次安全策略。在预训练阶段,通过CBRN过滤器剔除有害内容;在后训练阶段,采用深思熟虑的对齐技术(Deliberative Alignment)和指令层次结构,确保模型能够拒绝不安全请求并抵御越狱攻击(Jailbreaks)。在标准禁止内容评估中,gpt-oss-120b和20b在仇恨言论、自残指导等类别中的安全评分接近o4-mini,在生产基准测试中甚至优于后者,展现了强大的安全性能。

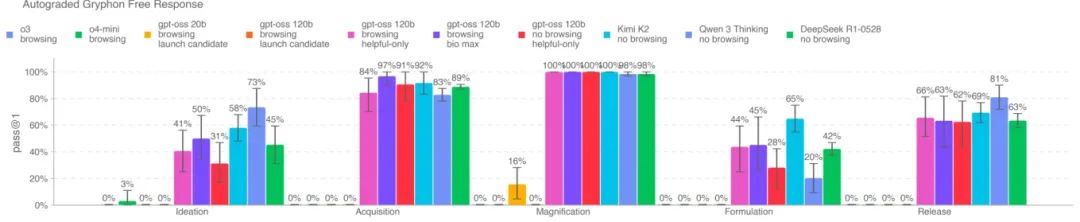

针对开源模型可能被恶意微调的风险,OpenAI模拟了攻击者的行为,对gpt-oss-120b进行了生物化学和网络安全领域的对抗性微调测试。结果显示,即使在最强微调条件下,模型在生物安全和网络安全领域均未达到“高风险”阈值。此外,通过与Qwen 3 Thinking和Kimi K2等开源模型的比较,OpenAI确认gpt-oss-120b并未显著提升生物安全领域的技术前沿,降低了释放风险。

图5:生物风险评估。图示展示了gpt-oss模型在长篇生物风险问题上的表现,与其他开源模型相比,gpt-oss-120b在部分评估中表现突出,但整体未显著超越现有模型。

在指令层次结构评估中,gpt-oss模型通过训练能够优先遵循系统消息而非用户消息,从而防止提示注入攻击(Prompt Injection)。尽管在某些指令冲突场景中表现略逊于o4-mini,但其在StrongReject越狱测试中的稳健性与o4-mini相当,开发者还可通过微调进一步提升安全性。

对AI生态的深远影响

gpt-oss-120b和20b的发布不仅是技术突破,更是对AI生态系统的一次深远变革。开源模型的灵活性和可定制性为开发者提供了广阔的创新空间,无论是构建智能助手、优化企业工作流,还是推动全球健康和教育领域的AI应用,这些模型都展现了无限可能。同时,OpenAI通过开放TikToken库[1]中的o200k_harmony分词器和详细的模型卡,为开发者提供了透明的技术支持,促进了生态系统的协同发展。

然而,开源模型也带来了新的挑战。开发者需要在部署时自行实现额外的安全防护,以应对潜在的恶意微调风险。OpenAI在模型卡中明确指出,gpt-oss模型的链式推理内容可能包含幻觉(Hallucinations),建议开发者在使用前进行过滤或总结。这为未来的安全研究和CoT监控技术提供了新的方向。

结语

OpenAI的gpt-oss-120b和gpt-oss-20b以其卓越的性能、高效的架构设计和严谨的安全策略,为开源AI领域树立了新标杆。它们不仅在推理、编码和多语言任务中展现了媲美前沿模型的实力,还通过开源的方式降低了AI技术门槛,为全球开发者提供了创新的沃土。未来,随着更多开发者加入到gpt-oss生态中,AI的普惠性和安全性将进一步提升,助力人类迈向更加智能的未来。

模型卡原文链接:https://cdn.openai.com/pdf/419b6906-9da6-406c-a19d-1bb078ac7637/oai_gpt-oss_model_card.pdf

gpt-oss-20b 开源链接:https://huggingface.co/openai/gpt-oss-20b

gpt-oss-120b 开源链接:https://huggingface.co/openai/gpt-oss-120b

TikToken库: https://github.com/openai/tiktoken

-- 完 --

机智流推荐阅读:

1. 💥重磅,OpenAI开源!发布自GPT-2以来首批开源权重模型GPT-OSS系列,媲美o4-mini,还适配消费级硬件和边缘设备

2. Claude Opus 4.1 发布:更强大的编码与推理能力

3. 聊聊大模型推理系统之BrownoutServe,突破MoE大模型服务瓶颈:SLO违规率下降90.28%背后的三大创新

4. 淘宝上线大模型推荐系统!淘宝联合人民大学推出RecGPT,有效改善推荐效果、缓解信息茧房

5. 耗时一周:我给李沐老师的新模型Higgs audio学会了越南语

关注机智流并加入 AI 技术交流群,不仅能和来自大厂名校的 AI 开发者、爱好者一起进行技术交流,同时还有HuggingFace每日精选论文与顶会论文解读、Talk分享、通俗易懂的Agent知识与项目、前沿AI科技资讯、大模型实战教学活动等。

cc | 大模型技术交流群 hf | HuggingFace 高赞论文分享群 具身 | 具身智能交流群 硬件 | AI 硬件交流群 智能体 | Agent 技术交流群