本章围绕“让大模型像人一样思考与行动”展开,系统介绍了7种认知框架,帮助模型提升复杂任务的表现力与可靠性。

情景学习(In-context Learning)

通过提供代表性、清晰简洁、多样化且高度相关的少样本示例,引导模型在上下文中“照葫芦画瓢”,快速适应新任务。典型应用是客服场景:给模型几个“用户问题—温情回复”示例后,它就能学会用简洁、共情的语言回应客户。思维链(Chain-of-Thought)

把复杂问题拆成一步步可验证的子问题,让模型把推理过程显式写出来。例如算术题“玛丽有多少苹果”:先复述已知量,再列出乘法步骤,最后给出结论。该方法同样适用于常识推理与符号推理,显著降低“跳步”导致的错误。自我一致性(Self-Consistency)

模仿人类“多角度验算”的习惯:对同一问题采样多条推理链,然后投票选出最一致的答案。实验表明,多条链都指向同一结果时,准确率大幅提升,可广泛用于数学、翻译、代码生成等需要高可靠性的场景。计划与执行(Plan-and-Solve)

先让模型一次性生成完整计划,再按部就班执行。优点是结构清晰;缺点是计划一旦有误,执行阶段无法自我修复,容易导致“一步错、步步错”。ReAct框架

打破“先计划后执行”的僵化流程,让模型像人一样“边想边干”:先推理,再行动,根据环境反馈实时调整下一步。典型流程为“思考→行动→观察→再思考”。多智能体协作项目MetaGPT已落地该框架,实现编码-测试-修复的闭环。反思(Reflexion)

在ReAct基础上加入“复盘”机制:

行动者(Actor)提出解决方案;

评估者(Evaluator)打分;

反思模块(Self-reflection)用自然语言总结失败原因并写入记忆;

下一轮Actor带着“教训”重新尝试,直至评估通过。

实验场景中,Agent首次找杯子顺序错误,经反思后第二次先取台灯再检查杯子,任务成功完成。

思维树 / 思维图(Tree/Graph of Thoughts)

把思考过程可视化为树或图:每个节点代表一个推理步骤,边表示逻辑关系。模型可在生成过程中回溯、剪枝、聚合不同分支,进一步提高复杂推理的系统性。

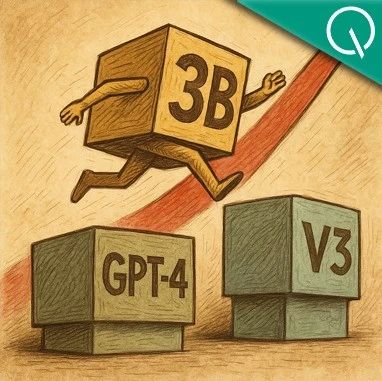

总结:从“示例模仿”到“逐步推理”,再到“多角度验证”“动态行动”“反思迭代”,这些框架层层递进,使大模型具备了类人的计划、执行、纠错、成长能力,为数学推理、代码生成、智能客服、自主Agent等场景提供了可靠的方法论。

本书免费下载地址

关注微信公众号“人工智能产业链union”回复关键字“AI大模型06”获取下载地址。