前几天小编在 HuggingFace 上摸鱼的时候,发现我们的老朋友,腾讯BAC团队(PCG内服基础算法中心)新开源了一款小尺寸多模态大模型 — TBAC-UniImage-3B[1]。 在 TIIF-Bench 测试中,UniImage 文生图长指令的理解和跟随得分达到了 65.03,大幅领先自家的 Hunyuan-DiT,甚至还超过了知名的 SD3、MidJourney v7 和 DeepSeek 的 Janus-Pro-7B。

回想起这几天机智流同事们对小编的抱怨:“在线生图要么慢,要么残,又快又好的不是带水印,就是贵的肉疼,你赶紧想办法部署个机智流专属的小而快的生图算法,否则就你去给我们画图😡!”

看到 UniImage Github[2] 上公布的成绩,小编瞬间燃起了希望!既然 TBAC-UniImage 宣称自己是个统一图像生成和理解的多模态模型,还只有3B大小,那还不赶紧评测一下咱国产模型的实力(水一篇稿),要是真材实料,还能省下设备和资金给编辑们加鸡腿!

一个生图算法首先要看的就是图生的怎么样,这里选择了几个编辑部同事们常用的场景进行评测;评测后再浅浅解读一下技术细节,和小编本地部署(踩坑)的经验分享。

重要提示:以下所有配图均由机智流部署的 UniImage-3B 生成。

场景测试

小编选取了图像生成、风格迁移、图文理解和图片编辑这四个主流的应用场景来进行测试。

场景一:图像生成

1. 杂志配图

下面是用一个官方长提示词一次生成文摘杂志配图:

再来一张时尚杂志配图 :

2. 科学场景

除了杂志的写实风,一些科学文章的配图也是文生图的常用场景:

提示词:High-resolution scene of artificial intelligence and big data visualization, dominated by blue and white tones, featuring data streams, neural network nodes, and a digital matrix background, strong technological feel, soft lighting, suitable for scientific journal cover

翻译:高分辨率的人工智能与大数据可视化场景,蓝色与白色为主色调,包含数据流、神经网络节点和数字矩阵背景,科技感强,光影柔和,适合科研杂志封面

提示词:Visualization of particle collisions inside a quantum particle accelerator, with brilliant particle trails and energy fluctuations, dark background highlighting light effects, combining futuristic and academic aesthetics

翻译:量子粒子加速器内部的粒子碰撞可视化,绚丽的粒子轨迹和能量波动,深色背景突出光效,未来感与学术感兼具

3. IP设计与表情包

IP形象设计和表情包也是生图的重要应用,可以是可爱小猫:

提示词:generate a poster of a cute kitten(生成一张可爱小猫的海报)

也可以是暴躁三花猫表情包:

提示词:Goofy cartoon-style calico cat, white with orange and black patches, eyes blazing with fire, furrowed brows, ears pinned back, tail puffed like a brush, mouth wide open as if shouting

翻译:搞怪卡通风三花猫,白底橙黑花纹,双眼冒火,皱着眉毛,耳朵向后压,尾巴像刷子一样蓬起,嘴巴张开像在大吼

4. 绘本插画

当然,如此快速又优质的生图算法怎么能不用来给小孩们生成一个可爱的故事绘本?下面请欣赏由 UniImage 带来的儿童故事《小月亮找朋友》

在一片宁静的夜空里,小月亮每天都挂在天上,看着地上的世界。

它总是笑眯眯地望着森林、湖泊和小镇,但却觉得有点孤单。

一天,小月亮看见一只小猫在草地上追萤火虫,发出的光闪闪的。小月亮忍不住轻声问:“你愿意做我的朋友吗?”

小猫抬起头,眯起眼睛笑了:“当然!我每晚都会抬头找你。”

从那天起,小月亮和小猫成了最好的朋友。

小猫会在夜晚和小月亮说悄悄话,而小月亮会用柔和的光照亮小猫回家的路。

它们明白,有些朋友,即使隔着很远的距离,也能互相陪伴。

5. 艺术创作

通过测试各种艺术风格的作品,可见 UniImage 对文字内容、各种画风和细节的掌握:

提示词:An autumn lakeside scene, golden and red maple leaves reflecting on the water, a small boat quietly moored(湖畔的秋日景色,金黄与红色的枫叶倒映在湖面,小船静静停泊)

这里水面的镜面反射处理得很到位。

提示词:Paris at dusk in oil painting style(油画风格的巴黎黄昏)

AI 创作最神奇的之处就是突破人类的想象力,测试中小编发现,UniImage 特别擅长创作超现实的科幻作品:

提示词:A giant steampunk airship floating above the clouds, copper and wood structure, exposed gears and pipes, Victorian style (巨型蒸汽飞艇漂浮在云层之上,铜质与木质结构,齿轮与管道外露,维多利亚风格)

提示词:A giant whale swimming above a sea of clouds, tail fin creating waves of mist, Dreamlike Illustration Style(一只巨鲸在云海上方游动,尾鳍掀起云浪, 梦幻插画)

提示词: The starry sky refracted into kaleidoscope patterns, colors constantly shifting, Optical Art Style(星空被折射成万花筒图案,色彩不断变化, 光学艺术)

6. 诗歌意境生成配图

我们还挑战了根据古诗词改编的提示词进行生图:

表达孤帆远影碧空尽,唯见长江天际流的景象

几个简单的测试能看出 UniImage 对于提示词的理解很到位,可以按照提示词生成包含各种元素和各种风格的画作。虽然暂时对文字的部分有所缺陷,但胜任编辑部同事们日常生图的需求是完全没问题的(小编不用被抓去画图了✌🏻)!

看Github介绍,UniImage 似乎还有不错的 Image-Text-Image (图文生图) 的能力。既然你都这么说了,那敬业(找茬)的小编肯定要来挑战一下~😈

场景二:风格迁移

首先我们来测试的是风格迁移,这个功能要求模型能够同时理解图像的内容和提示词内容,进而对原始图像风格进行更改。

1. 赛博朋克风格

下面这张图同样是 UniImage 生成的,我们拿他改造成赛博朋克风格:

提示词:Astronauts walking on the moon, cyberpunk style, neon colors, glitch art effects, futuristic mechanical texture, dark background with glowing details(宇航员走在月球,赛博朋克样式,氖颜色,小故障艺术效果,未来派机械纹理,与发光细节的黑暗背景)

2. 水墨画风

我们再尝试将油画风格的《巴黎黄昏》改成齐白石风格的水墨画:

提示词:style of Qi Baishi's ink wash painting, traditional Chinese painting aesthetic (齐白石风格的水墨画,中国传统绘画审美)

3. 3D剪纸风格

再给杂志插图生成的布偶插图换个风格:

提示词:transformed into 3D paper cut style, layered structure, colorful cardboard texture, transparent lighting, intricate details (转换为3D剪纸风格,分层结构,彩色纸板纹理,透明照明,错综复杂的细节)

可以看到不仅 UniImage 理解了提示词中的风格描述,二次生成的图片还能与原图保持很强的一致性。

场景三:图文理解

风格迁移的测试证明了 UniImage 基本的多模态图文理解能力。为了进一步测试这个小模型是否对图像和提示词中文字的内容理解到位,小编我又专门进行了几个测试。

1. 图像中的前景元素

我们继续使用前文生成生成的那只布偶猫,测试 UniImage 是否能准确识别图中的前景元素,并理解提示词中“灰色的猫的具体意思”:

提示词:Replace the cat in the picture with a grey cat and keep the other elements unchanged.(把图中的猫换成灰色的猫,其他元素保持不变。)

完成的很好,新生成的图像将布偶变成了英短,准确理解了原图中白猫的发色和提示词中的对颜色的描述,同时与风格迁移场景中相比,更多的保留了背景不变。充分说明 UniImage 能够深度理解图像的元素和提示词内容。

2. 图像中的背景元素

还是最开头的猫猫😄(没错,小编是猫猫爱好者)再来改个背景:

提示词:Change the background to indoor(将背景改到室内)

从效果来看,UniImage 通过起图文理解的强大能力,可以准确识别修改的元素,并在保证主体的姿态颜色不变的情况下完成对图像的修改。

3. 细节理解

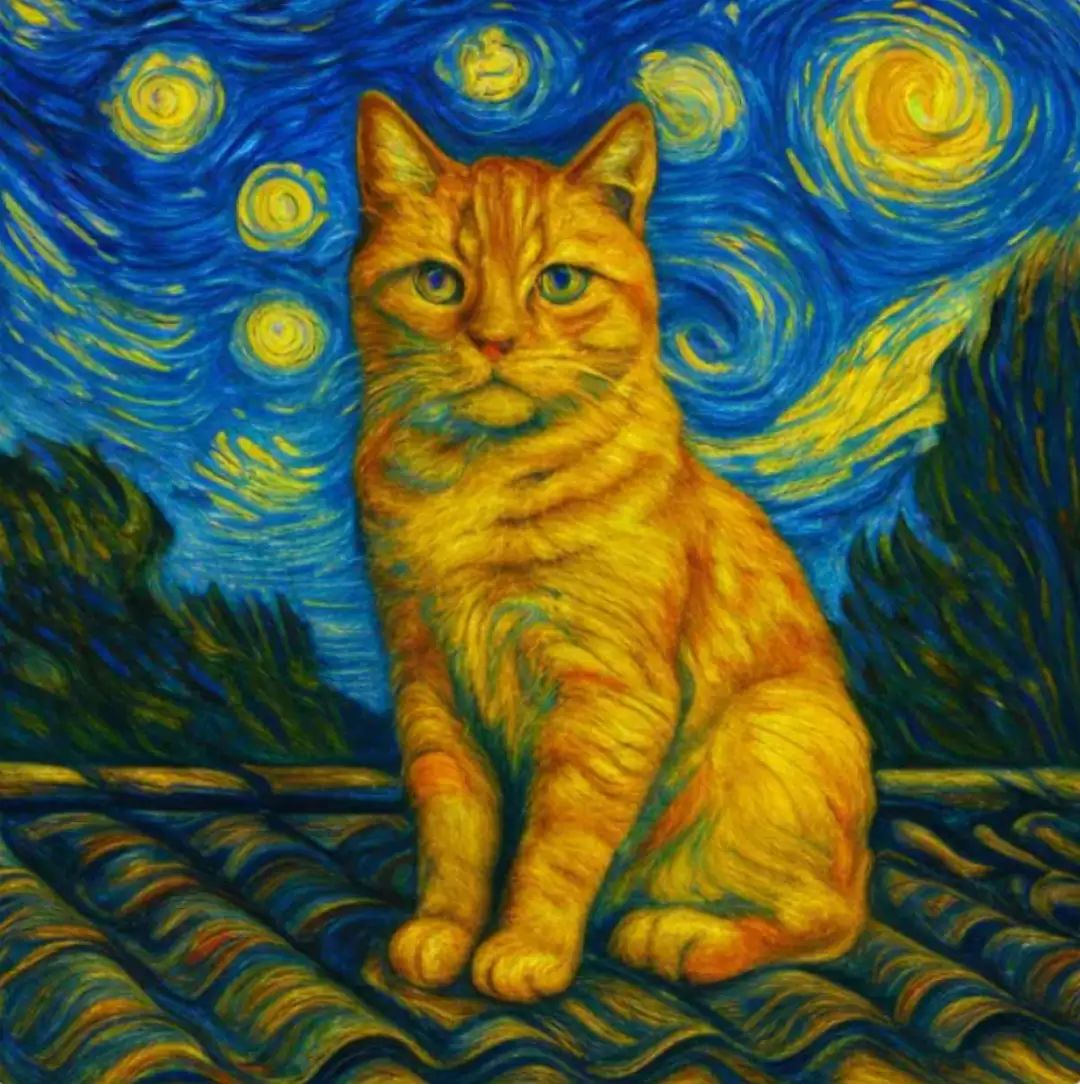

我们再进一步挑战,测试不同的两幅猫猫图像,在相同的提示词下,UniImage 的表现如何。

提示词:A cat sitting on a rooftop, in the style of Vincent van Gogh's 'The Starry Night', swirling night sky, thick impasto oil painting texture, vibrant blue and yellow tones(一只猫坐在屋顶上,风格借鉴文森特・梵高的《星月夜》,有着旋转的夜空、厚重的厚涂油画质感、鲜明的蓝色和黄色色调)

先用布偶猫的侧身猫图片做参考:

这是以之前生成的另一张正脸大橘做参考图:

从这两张梵高风格的生成图像可以看出,UniImage在多模态图文理解方面不仅可以识别出猫这种比较大的概念,还能很好的把握坐姿不同,背景差异等细节,根据提示词相应的生图。

场景四:图片编辑

从图文理解的测试结果来看,作者还是低估了UniImage 的潜力。以小编的视角看,尽管只有3B大小,但其现有的多模态图文理解能力完全能够胜任通用的图文生图任务。

接下来,小编就以两个例子来测试它实际的图像编辑能力:

1. 艺术风格图片的编辑

在更高难度的测试中,小编想测试 UniImage 是否能够在比较抽象的艺术画作中理解某个元素符号,并进行针对性修改。这里我们把官方提供的一张样例图从猫猫剪影改成狗子剪影⬇️

提示词:Change the cat to be a dog(把猫转变为一只狗)

这效果真的很惊艳小编,UniImage 不仅可以从艺术画作中准确定位具体元素进行制定修改,还能在修改的同时保留原图结构和其余要素基本不变(甚至是装饰花纹),可见这个3B小模型的多模态图文理解能力是完全胜任图像编辑的任务的。

2.人像编辑

作为图像编辑中任务重的大头,小编也尝试了通过提示词更改人物头发的颜色和衣服的颜色:

提示词:Change the hair to be blond; Change the clothes to be red.

总体来说,UniImage 有着相当出色的图像生成能力和图文理解能力,这次测试的评价基本是满分通过!

那么这模型到底牛在哪?

TBAC-UniImage-3B 的最大特点是小尺寸、统一图片生成和理解,并通过创新的 “阶梯侧扩散调优” 机制打破了传统模型中 “理解” 与 “生成” 的割裂问题。

以前也有模型实现了图片生成和图片理解的统一,但要么是“浅层合作”——多模态大模型(MLLM)理解文字后,只把最后一层结果甩给扩散模型(DiT)生成图片——就像老师批改作业只看最后答案,不管中间的解题思路,很容易漏掉细节;要么是“从头硬肝”——为了统一“理解”和“生成”,直接从零训练超大模型,参数堆到几十B,成本拉满。

而 TBAC-UniImage 玩了个巧思:

深层绑定,细节不丢:它让扩散模型像“爬梯子”一样,接住大语言模型多层的“理解结果”。比如 MLLM 的第5层、8层、10层输出都给 DiT 当参考——相当于生成过程全程盯着“文字的深层逻辑”,连“氛围感”“朦胧感”这种抽象描述都能拆解成具体画面元素;

省钱又能打:大语言模型的参数直接“冻结”不用动,只训练少量“可学习查询”和扩散模型,成本砍半还不影响效果。在 GenEval 测试(考“文字描述与图像细节匹配度”)拿了0.87分,和顶尖大模型Qwen-Image持平;在 DPG-Bench(考“复杂指令理解”)飙到 80.97 分,超过 BLIP3-o-8B 等同行。

部署实战:3步搞定,普通电脑也能跑

对了,UniImage的部署也是非常简单(测试完机智流的同事们就用起来了)。作者为大家提供了快速部署的Demo:

第一步:准备环境

1. 克隆项目仓库

在本地终端中先切换到自己想要保存项目的文件夹地址,然后执行以下指令,进行项目仓库克隆:

git clone https://github.com/DruryXu/TBAC-UniImage

克隆完成后,进入该项目文件夹

cd TBAC-UniImage/

打开该文件夹中的 requirements.txt 文件,在末尾添加 transformers==4.51.3。然后进行环境配置(为了避免环境冲突,建议在执行下方指令前先用 conda 或者 venv 创建一个虚拟环境,这里不做过多赘述):

pip install -r requirements.txt

2. 下载模型权重文件

从 Huging Face 官网[3] 或者 HF镜像[4] 先把模型文件(整个文件夹)下载到前面克隆的项目文件夹内。

这里推荐用 hfd.sh[5] 脚本进行脚本下载

国内记得设置镜像环境变量

export HF_ENDPOINT="https://hf-mirror.com"

3. 设置本地加速配置

在模型文件下载完成后,在 TBAC-UniImage 的项目文件夹中找到app.py文件第91行,

pipeline = pipeline.to(device="npu", dtype=torch.bfloat16)

如果你的本地设备具备 NVIDIA 显卡,修改device='cuda';如果你是 M 系列芯片的 Mac 用户,修改device='mps';如果你既没有 NPU,也没有 N 卡和 M 卡,那么修改device='cpu'。

注意:由于实测 TBAC-UniImage-3B 的显存占用大概在 12-18GB(同时生成1-4张图),因此在配置 N 卡和 M 卡进行本地推理加速时候,需确保显卡显存/Mac 内存至少有 13GB(单张生图)。

第二步:模型推理生成

开发者很贴心的提供了一个 Gradio 的推理界面,运行以下指令即可启动推理界面(初次启动需要等待一段时间)

export HF_ENDPOINT="https://hf-mirror.com"

python app.py --checkpoint_path TBAC-UniImage-3B/

此处TBAC-UniImage-3B/就是我们刚刚下载的模型文件夹相对于项目文件夹的路径,根据自己下载地址的不同更改。

成功运行后浏览器打开 127.0.0.1:12345 即可进入 Gradio 界面。

当然 BAC 团队也秉持着非常好的开源传统,提供完整的开发工具链。不仅提供使用Demo帮助开发者快速测试部署,还有一件训练脚本,真正帮助开发者快速落地:

sh train.sh

结语

以前总说“好模型要么贵,要么重”,但这个国产3B模型打破了偏见:它同时满足了“文字与图片理解+生成高质量图片+普通设备能部署”这个不可能三角,加速了落地。

当然,测试过程中也遇到了一些小编觉得未来可以改善的地方,比如现在模型的“中文理解能力较弱,用英文提示词生成效果更好”;和“写实风格的素材在短提示词上的训练好像不太充分导致图像理解失误”等等问题。

不过正如机智流编辑部一位同事的评价:“3B就能统一图文生成和理解,你还要什么自行车?!”

(话说的虽然合情合理,但小编是真的想要自行车啊~ )

)

不可否认的是,UniImage 的出现不仅为端侧 AI 图像应用提供了新选择,也体现了国产端侧智能模型在平衡性能、成本与隐私方面的进步。假如你有端侧和轻量化部署图像应用的需求,相信腾讯这款统一图片生成与理解的 TBAC-UniImage-3B 是个不错的选择,也相信未来随着模型迭代优化,其在风格迁移的细腻度、复杂场景和多语言理解的深度等方面提供更强大的性能。

编辑:北辰、羰汤羰、洛

TBAC-UniImage-3B: https://huggingface.co/TencentBAC/TBAC-UniImage-3B

[2]UniImage Github: https://github.com/DruryXu/TBAC-UniImage

[3]Huging Face 官网: https://huggingface.co/TencentBAC/TBAC-UniImage-3B

[4]镜像: https://hf-mirror.com/TencentBAC/TBAC-UniImage-3B

[5]hfd.sh: https://gist.github.com/padeoe/697678ab8e528b85a2a7bddafea1fa4f

-- 完 --

机智流推荐阅读:

1. TRO2025|基于隐式表面优化的快速精确6D物体位姿精修方法

2. HF今日论文: 阿里WebWatcher登顶,从全景3D世界生成到超长搜索,Agent智能大爆发!

3. 聊聊大模型推理系统之 TaiChi:打破聚合/分离之争,华为云提出统一架构

4. 还在为AI智能体的成本发愁?OPPO AI团队打造低成本高性能智能体,成本降低28.4%!

关注机智流并加入 AI 技术交流群,不仅能和来自大厂名校的 AI 开发者、爱好者一起进行技术交流,同时还有HuggingFace每日精选论文与顶会论文解读、Talk分享、通俗易懂的Agent知识与项目、前沿AI科技资讯、大模型实战教学活动等。

cc | 大模型技术交流群 hf | HuggingFace 高赞论文分享群 具身 | 具身智能交流群 硬件 | AI 硬件交流群 智能体 | Agent 技术交流群