点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:视觉语言导航

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

作者: Yanyuan Qiao, Wenqi Lyu, Hui Wang, Zixu Wang, Zerui Li, Yuan Zhang, Mingkui Tan, Qi Wu 单位:阿德莱德大学澳大利亚机器学习研究所,华南理工大学软件工程学院 论文标题:Open-Nav: Exploring Zero-Shot Vision-and-Language Navigation in Continuous Environment with Open-Source LLMs 论文链接:https://arxiv.org/abs/2409.18794 项目主页:https://sites.google.com/view/opennav 代码链接:https://github.com/YanyuanQiao/Open-Nav

主要贡献

提出Open-Nav方法,探索使用开源大型语言模型(LLMs)进行零样本视觉-语言导航(VLN-CE),解决了依赖昂贵的闭源LLMs(如GPT-4)带来的成本和隐私问题。 采用时空思维链(CoT)方法,通过指令理解、导航进度估计和决策制定三个阶段,增强LLM在导航中的推理能力,并结合RGB和深度数据提升视觉感知和空间推理能力。 在模拟和真实环境中验证性能,通过广泛的实验表明,Open-Nav在性能上与使用闭源LLMs的方法相当,同时具有低成本和保护隐私的优势。

研究背景

视觉语言导航(VLN):要求智能体根据文本指令在3D环境中导航。早期研究主要关注离散配置,将导航简化为在预定义图上的移动,但这种方法在真实世界中的适用性有限。 连续环境中的VLN(VLN-CE):为更贴近真实世界导航条件而提出,不依赖预定义图,允许更灵活和真实的导航。 传统方法的局限性:早期方法依赖于大规模、特定领域的数据集进行监督学习,存在对训练数据的依赖以及从模拟到现实的泛化问题。 LLMs在VLN中的应用:近年来,利用LLMs作为导航器的研究逐渐兴起,但这些方法大多依赖于API调用,成本高昂且存在隐私问题。

问题定义

任务设定

全景RGB视觉:智能体在每个位置获取全景RGB图像 ,包含12个RGB和12个深度快照,这些快照以30度间隔拍摄,覆盖360度全景。 语言指令:智能体在每次试验中获得语言指令,其语言嵌入表示为 ,其中 是每条指令的单词数。 智能体需要根据指令执行低级动作,如移动方向和距离,以到达目标位置。

挑战

连续环境:与离散环境不同,连续环境中的导航需要考虑更多的因素,如目标距离、潜在障碍物和碰撞风险。 数据隐私:在真实世界应用中,用户可能不愿意将室内环境数据传输到外部服务器,因此需要在本地部署模型以保护隐私。 成本问题:依赖闭源LLMs(如GPT-4)的方法需要频繁调用API,成本高昂。

框架设计

航点预测

从全景RGB和深度图像中识别潜在的导航点:

使用两个ResNet50网络分别提取RGB和深度图像的特征。 将RGB和深度特征融合: 使用两层Transformer网络处理融合后的特征向量,模拟视图之间的空间关系: 生成潜在航点的热图,并通过非极大值抑制(NMS)选择最可能的航点: 从热图中选择 个附近的航点,每个航点由角度和距离定义,为导航提供精确的方向和空间信息。

场景感知

识别场景中的对象及其位置,提取空间关系:

使用 SpatialBot 模型处理RGB和深度图像,生成包含空间信息的丰富场景描述: 使用 RAM 模型进行细粒度对象检测和识别,提取对象的类别和空间坐标: 将检测到的对象及其空间关系整合为文本格式的观察结果,供LLM导航器使用。

LLM导航器的时空思维链

通过指令理解、进度估计和决策制定三个阶段,增强LLM的导航推理能力:

指令理解: 将指令分解为动作和地标,以便LLM更好地理解任务要求。 使用特定的提示,例如:"You are an action decomposition expert. Your task is to detect all actions/landmarks in the given navigation instruction. Actions:" 进度估计: 通过分析导航历史,评估已完成的动作和地标。 包括地标和动作验证、方向分析、动作完成估计和顺序评估。 决策制定: 结合当前环境描述、历史轨迹和指令要求,选择最优的导航路径。 LLM根据这些信息生成决策思路,并选择最合适的航点。

实验

实验设置

模拟环境: 使用 R2R-CE 数据集,基于 Matterport3D 场景,通过 Habitat Simulator 将离散路径转换为连续环境。 随机采样约100个任务进行评估。 在单个RTX 3090 GPU上运行模型。 真实环境: 选择三种不同室内场景:办公室、实验室和游戏室。 每种场景标注20条指令,涵盖简单和复杂导航任务。 使用配备GeForce RTX 3080的笔记本运行模型。

评估指标

使用标准VLN指标评估导航性能,包括:

成功率(SR) Oracle成功率(OSR) 归一化动态时间规整(nDTW) 路径长度加权成功率(SPL) 轨迹长度(TL) 导航误差(NE)

模拟环境实验结果

Open-Nav在成功率(SR)和路径长度加权成功率(SPL)等关键指标上优于DiscussNav等基于GPT-4的方法。 使用GPT-4作为导航器时,性能有所提升,但Open-Nav使用开源LLMs仍具有竞争力。

真实环境实验结果

Open-Nav在多种场景下均优于传统的监督学习方法(如CMA、RecBERT和BEVBert),显示出更好的泛化能力。 Open-Nav在真实环境中达到了SOTA(State-of-the-Art)性能,尤其是在办公室和实验室场景中。

消融研究

不同LLM在指令理解上的表现

使用SPICE、BLEU、METEOR和ROUGE等文本评估指标,比较了Llama3.1-70B、Qwen2-72B、Gemma2-27B和Phi3-14B四种开源LLM在指令理解上的能力。 结果显示,Llama3.1-70B在地标提取上表现最佳,而Qwen2-72B在动作提取上得分最高。

不同LLM在导航中的表现

在实际导航任务中,Llama3.1-70B的导航性能优于其他LLM,具有更高的成功率和更好的路径规划能力。

结论与未来工作

结论: Open-Nav通过使用开源LLMs,成功解决了依赖闭源LLMs带来的成本和隐私问题,同时在模拟和真实环境中均取得了与闭源LLMs相当的性能。 该方法通过时空思维链方法和增强的场景感知能力,显著提升了LLM在导航任务中的推理和决策能力。 未来工作: 计划进一步优化开源LLMs的计算效率,以实现在真实世界中的高效导航应用。

3D视觉硬件,官网:www.3dcver.com

3D视觉学习圈子

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

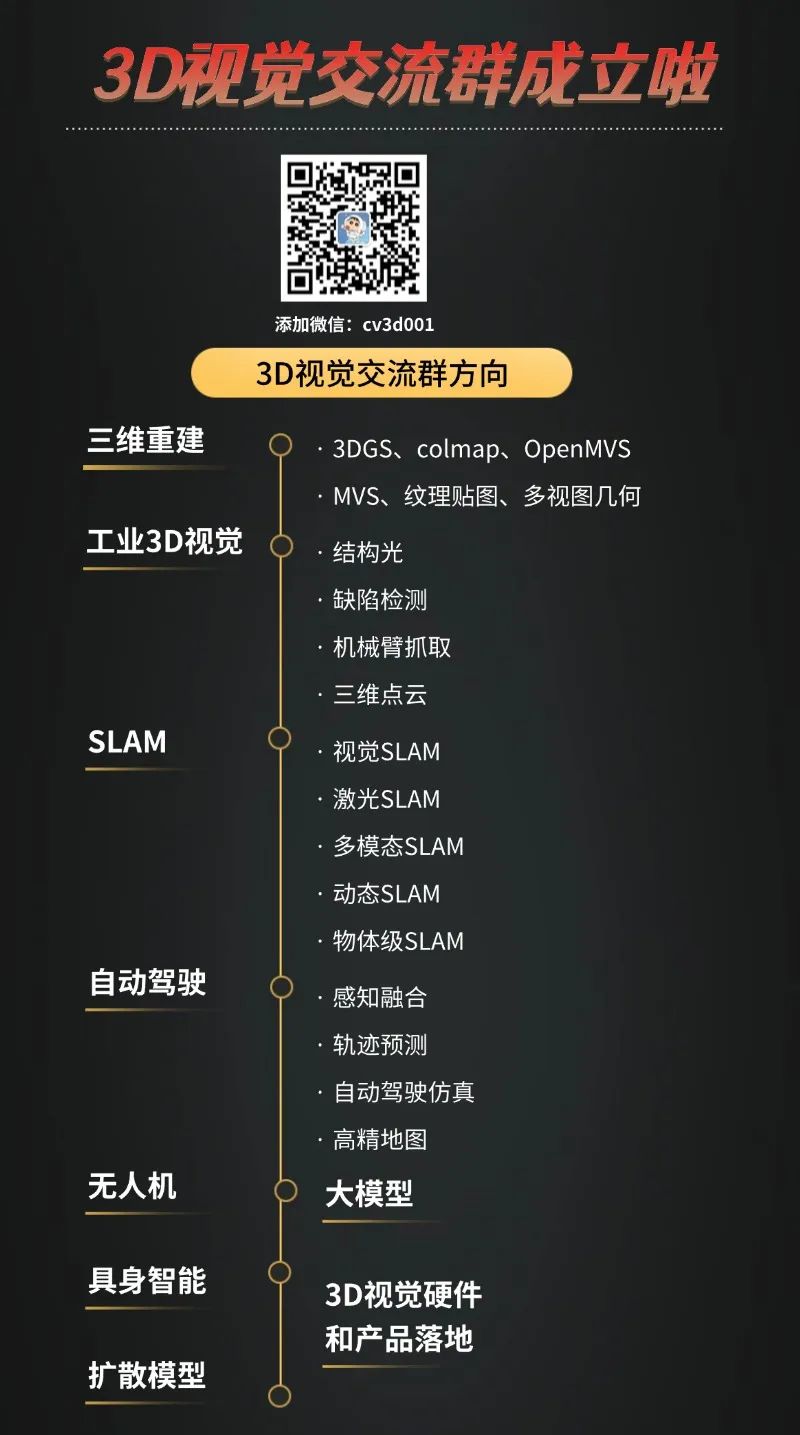

3D视觉交流群成立啦,微信:cv3d001