近日,乐聚与

山东大学、通研院联合实验室

在虚实融合人机交互系统

与具身智能训练测试平台

两大方向取得重要科研进展

提升机器人智能交互与仿真训练能力

相关研究成果分别被

国际顶会ACM SIGGRAPH Asia 2025

顶刊Journal of Field Robotics接收

山东大学-乐聚

虚实融合人机交互系统

论文导读

从科幻电影里温柔的家政机器人,到实验室里能握手、击掌的“伙伴”,人类一直梦想实现真正自然、持续进化的人-机共生。让机器人具备自然高效的智能交互能力,从而无缝融入人类的工作与生活场景,也是实现具身智能愿景的核心目标之一。然而,现有机器人仿真平台仍停留在“键盘-鼠标”或手柄操作阶段,缺乏真实人类在真实场景中与虚拟机器人零距离、带反馈的闭环交互。

本文介绍了山东大学交叉研究中心——乐聚人形机器人联合实验室与上海科技大学有条件录用于ACM SIGGRAPH Asia 2025的论文。

论文题为《SymBridge: A Human-in-the-Loop Cyber-Physical Interactive System for Adaptive Human-Robot Symbiosis》。

文章创新性地提出了人类在环的(human-in-the-loop)虚实融合交互系统。该系统利用增强现实技术,使真人用户能够在物理环境中与虚拟机器人进行沉浸式互动。

系统包含的交互模型融合了多分辨率的人体运动特征与环境可供性信息,基于连续的人体动作实时生成响应精准的机器人动作;同时,系统支持通过收集人类反馈动态调整交互模型,从而实现机器人行为的持续学习与进化。

实验结果、用户研究以及真实机器人测试均表明,SymBridge 在交互真实性、响应精度与持续优化能力等方面为人机共生的研究提供了重要的技术支撑与实践平台。

该论文的共同一作为山东大学博士生陈浩然和上海科技大学博士生许艺腾,指导教师包括山东大学屠长河教授,香港大学窦志扬,山东大学李曼祎,上海科技大学马月昕。本工作由乐聚(深圳)机器人技术有限公司提供赞助与技术支持。此外,上海科技大学任奕名、叶瑶勤,山东大学刘耀泽、吴雨铉也为该项研究做出了积极贡献。

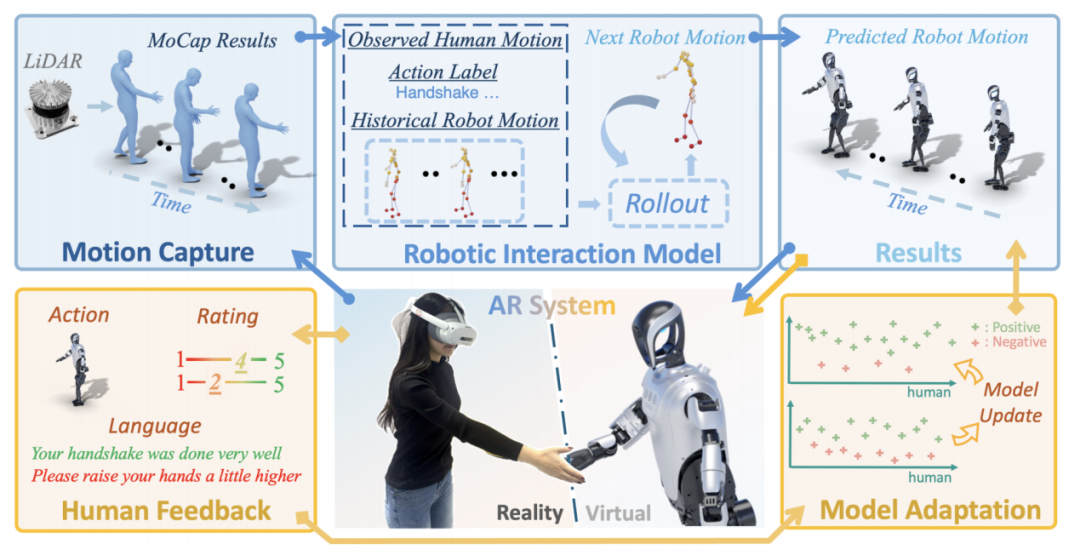

如图2所示,SymBridge 系统整体框架由四个核心模块构成。首先,系统通过 LiDAR 进行人体动作捕捉(Motion Capture),实时获取用户的动态姿态信息。随后,机器人交互模型(Robotic Interaction Model)基于观测到的人体动作、历史机器人运动轨迹以及动作语义标签,预测并生成下一步机器人的交互动作。

生成的结果在虚拟环境中通过 AR眼镜将用户与虚拟机器人紧密连接,使其能够在高度沉浸的三维物理空间中进行自然交互。在此过程中,系统引人类反馈(Human Feedback),包括语言评价、动作评分等信息,用于评估机器人的交互表现。

最后,借助模型自适应(Model Adaptation)机制,系统能够基于正负反馈对模型进行更新,不断优化交互效果,使机器人动作逐渐符合人类的期望与偏好。通过这一循环机制,SymBridge 实现了机器人交互能力的持续提升。

图2丨 SymBridge系统架构:蓝色箭头为“人-机”实时交互;

黄色箭头为“人反馈-机进化”闭环

SymBridge 的模型能够在实时条件下生成符合语境的人形机器人交互动作序列。模型包含三个主要模块:

首先,可供性预测器(Affordance Predictor)捕捉机器人末端执行器与人体之间的精细空间和几何关系,从而指导机器人生成精确且符合社会规范的交互动作。

其次,多分辨率人体特征学习器(MRHF Learner)融合了不同时间尺度的人体行为特征,以提升对人类意图的理解能力。

最后,机器人滚动生成环(Robot Rollout Loop)采用逐帧预测的方式,实现了动作生成的实时性、连贯性和上下文自适应,确保交互过程的响应性与长期稳定性。

在输入输出设计上,模型以用户的文本指令(如“握手”或“击掌”)、历史机器人关节序列以及人体动作观测(骨架与 SMPL 网格顶点)作为输入,并逐步生成未来的机器人关节序列。每次仅执行下一帧结果,保证了在线生成的及时性与交互自然性。

此外,模型还结合了动作语义嵌入与可供性场的引导,使机器人能够在空间上合理对齐人类动作,并在时间上保持流畅连贯。最终,生成的运动通过运动重定向模块(Motion Retargeting Module)转换为机器人可执行的运动参数,实现了既精准又平滑的互动体验。

图3丨交互模型流程:模型结合文本指令、机器人历史动作与人体观测信息,经由可供性预测、多分辨率特征学习、滚动生成和运动重定向四个模块,生成实时、连贯的机器人交互动作。

北京通研院-乐聚

具身智能训练测试平台

论文导读

仿真,虽无法完美复刻现实世界,但已被证实是横跨多学科的高效教学工具,为科研与教育提供了便捷且经济的实现途径。主流机器人仿真器支持高精度物理模拟,但缺乏视觉真实感;传统具身智能平台具备高清渲染能力,却简化了物理交互。为弥补现有机器人模拟器的局限性,填补全尺寸人形机器人教研的需求缺口,通研院主导研发兼具物理与视觉真实感的具身智能训练测试平台TongVerse,旨在促进具身人工智能与机器人学领域的协同研究,推动人形机器人领域的教育发展与人才培养。

TongVerse是具身智能训练测试平台,为用户提供高质量场景渲染与机器人动力学仿真,该平台支持利用多样化数字资产构建多场景,集成先进感知模型或基础模型,并基于环境反馈实现动态人形机器人行为的规划与控制算法。

TongVerse平台为学术界与工业界提供高精度、低成本的研究基础设施,目前已应用于国家级机器人赛事,致力于提升人形机器人的研究和教育水平。研究成果"PR2: A Physics- and Photo-realistic Humanoid Testbed with Pilot Study in Competition"已发表至Journal of Field Robotics。

项目链接:https://pr2-humanoid.github.io/

开源地址:https://github.com/pr2-humanoid/PR2-Platform

第一作者:通研院刘航欣研究员,其他作者包括:通研院谢琦工程师、通研院张泽宇研究员、通研院袁滔研究员、苏州大学王松老师、通研院王在进工程师、哈尔滨工业大学冷晓琨教授、哈尔滨工业大学孙立宁教授。

通讯作者:通研院张精文研究员、哈尔滨工业大学何治成博士、通研院苏垚研究员。

TongVerse平台基于 NVIDIA Isaac Sim 构建,该平台借助 GPU 加速图形技术与集成 Nvidia PhysX 5 的物理仿真能力,使用户能在具备物理仿真和照片级真实感的仿真环境中研究测试机器人技能。通过扩展 NVIDIA Isaac Sim 核心组件,TongVerse平台由三大模块构成:

(1)任务模块:利用丰富的数字资产构建交互式任务环境,并通过多种技术提升场景渲染质量和交互能力;

(2)物理仿真模块:支持各类数字资产导入,以构建多样化任务场景并模拟力场、系统动力学等物理效应;

(3)内置控制器模块:集成模型预测控制器、全身控制器及高级规划器,默认配置适合初学者,高级用户可按需替换为更复杂的控制方案。

2024年,TongVerse平台已应用于“第二十六届中国机器人及人工智能大赛人形机器人创新挑战赛”。其中,仿真选拔赛依托TongVerse具身智能训练测试平台开展,在4个月内吸引了137支队伍、400余名参与者参赛。该竞赛涵盖双足行走等传统任务,以及移动操作和基于语言指令的物体搜索等创新挑战。TongVerse平台不仅通过全国性赛事完成验证,开创了在高校赛事实现跨模态挑战的先河,并进一步推动人形机器人教育的普惠化发展。

今年4至8月,依托TongVerse平台,北京通用人工智能研究院继续支撑“第二十七届中国机器人及人工智能大赛人形机器人专项赛全国决赛”。与去年的家庭场景相比,今年的赛事更加聚焦于工业场景,通研院与乐聚机器人联合团队将TongVerse平台中的人形机器人本体模型更新为乐聚最新款双足人形机器人平台夸父4pro,仿真环境、双足行走控制器等方面也做了全面升级,定制了三个关卡对人形机器人在工业场景下的感知、规划、控制、交互等进行综合能力测试。

图丨赛事整体测试环境

第一关:智越征途

考察机器人的自主导航和避障能力

图丨“智越征途”测试场景

第二关:王者之路

测试机器人在复杂地形上的运动控制能力

图丨“王者之路”测试场景

第三关:智能搬运

验证机器人的物品识别和精确放置能力

图丨“智能搬运”测试场景