进入第二阶段,Hunyuan-7B-Base的优化重点是更高的精度。腾讯混元团队选取了约26.8万对更高保真的语料,经过更加严格的筛选与验证,部分样本由人工复核,保证了数据的可靠性。

借助这一双阶段的微调策略,模型的翻译表现实现提升,特别是在少数民族语言与汉语的互译任务中展现出明显优势。

RL阶段,Hunyuan-7B-Base采用了常见的GRPO算法,并设计了多元化的奖励函数。

这一奖励函数包括质量感知奖励、术语感知奖励和重复惩罚。

其中,质量感知奖励包含两个奖励信号,一个由客观机器翻译质量评估模型XComet-XXL提供,这一模型不像传统的BLEU评估模型一样依赖人工译文,而是直接分析翻译文本的流畅性、准确性和自然度等特征。

另一个奖励信号来自DeepSeek-V3-0324的评分。V3在这里扮演了类似人工翻译评审员的角色,并借用了GEMBA翻译质量评估框架里的提示词,让V3对翻译结果的语义准确性、语法正确性等进行评分。

能否对关键术语进行准确翻译,也会影响译文质量。腾讯混元团队引入基于词对齐的奖励机制,通过词对齐工具提取关键术语和信息,计算机器译文和参考译文的重合率,重合率高奖励就越大。

该团队观察到,模型在RL后期容易生成重复内容,甚至可能导致训练崩溃。因此,他们设计了重复检测机制,一旦发现重复模式则施加惩罚,以保持输出的多样性和训练的稳定性。

腾讯混元团队还提出了“弱到强”强化学习方法,模型会生成多个翻译结果,并利用基于Hunyuan-MT-7B的融合模型通过GRPO聚合这些输出。奖励函数由XComet-XXL评分、DeepSeek-V3-0324评分和重复惩罚项组成。这种奖励机制能够全面评估翻译质量,同时避免冗余输出。最终,Hunyuan-MT-7B-Chimera模型诞生了。

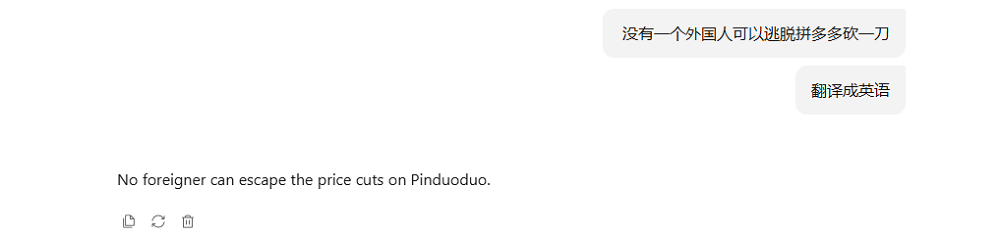

系统提示词显示,Hunyuan-MT-7B-Chimera会分析六个不同翻译结果,生成经过统一优化的最终翻译结果。

该方法利用多种翻译之间的互补性,从而显著提升翻译质量。

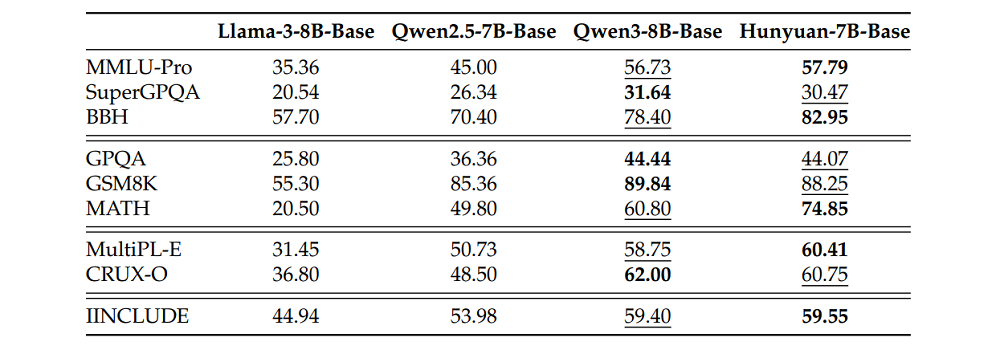

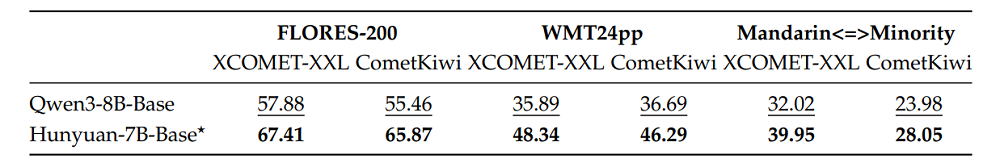

基准测试结果显示,Hunyuan-MT-7B和Hunyuan-MT-Chimera-7B在XCOMET-XXL和CometKiwi两项指标上均显著优于大多数基线模型,显示出稳定而显著的改进。

在谷歌等企业推出的WMT24pp基准上,Hunyuan-MT-7B的XCOMET-XXL得分为0.8585,超越了所有基线模型,包括Gemini-2.5-Pro和Claude-Sonnet-4等超大模型。

在汉语与少数民族语言的翻译任务中,Hunyuan-MT-7B(得分0.6082)和Hunyuan-MT-Chimera-7B(得分0.6089)高于所有竞品,其中最接近的Gemini-2.5-Pro为0.5811。