9月1日,美团宣布LongCat-Flash-Chat正式发布,在Github、Hugging Face平台开源,并同步上线官网。

此前有自媒体“01Founder”爆料称,LongCat-Flash最大的亮点是其训练并非在英伟达GPU上完成,而是在国产加速卡上进行。美团已经成功跑通了一条不被“卡脖子”的技术路径,但由于一些原因,真正的硬件厂商具体名字不方便透露。

对于该爆料,美团方面未作正面回应,只介绍称,LongCat-Flash采用创新性混合专家模型(Mixture-of-Experts, MoE)架构,总参数560B,激活参数18.6B-31.3B(平均 27B),实现了计算效率与性能的双重优化。

根据多项基准测试综合评估,作为一款非思考型基础模型,LongCat-Flash-Chat在仅激活少量参数的前提下,性能比肩当下领先的主流模型,尤其在智能体任务中具备突出优势。

此外,因为面向推理效率的设计和创新,LongCat-Flash-Chat具有明显更快的推理速度,更适合于耗时较长的复杂智能体应用。

LongCat-Flash的基础测试性能

至于美团为何要加入大模型之战,或与公司AI战略的三个层面有关,即AI at work、AI in products以及 Building LLM。

今年以来,美团AI进展频传,发布了AI Coding Agent工具 NoCode 、AI经营决策助手袋鼠参谋、酒店经营的垂类AI Agent美团既白等多款AI应用。此次模型开源则是其 Building LLM 进展的首度曝光。

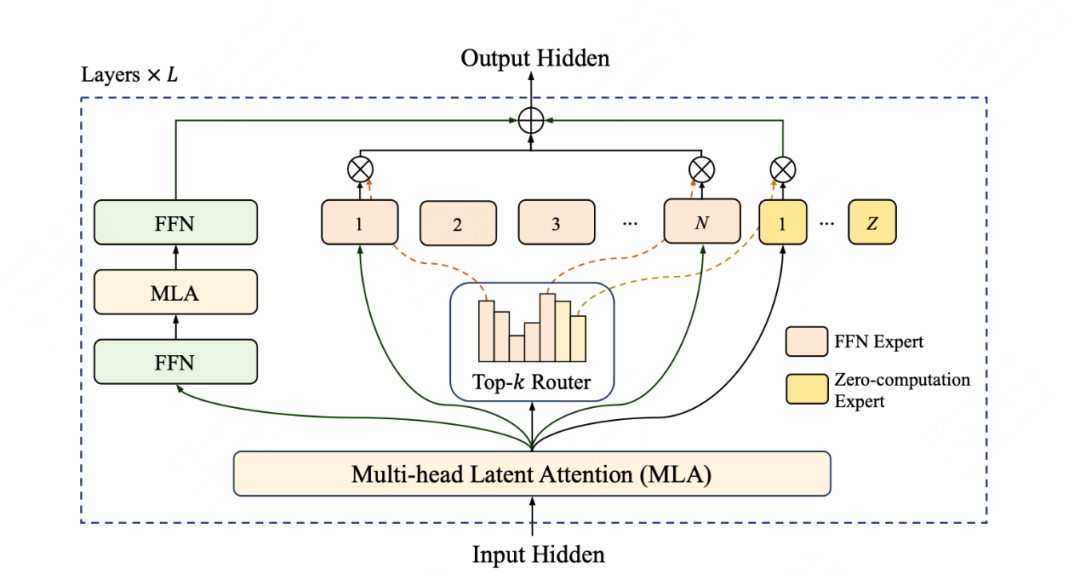

再具体点看,LongCat-Flash模型在架构层面引入“零计算专家(Zero-Computation Experts)”机制,总参数量 560B,每个token依据上下文需求仅激活18.6B-31.3B参数,实现算力按需分配和高效利用。为控制总算力消耗,训练过程采用PID控制器实时微调专家偏置,将单token平均激活量稳定在约27B。

此外,LongCat-Flash在层间铺设跨层通道,使MoE的通信和计算能很大程度上并行,提高了训练和推理效率。配合定制化的底层优化,LongCat-Flash在30天内完成高效训练,并在H800上实现单用户100+tokens/s的推理速度。LongCat-Flash还对常用大模型组件和训练方式进行了改进,使用了超参迁移和模型层叠加的方式进行训练,并结合了多项策略保证训练稳定性,使得训练全程高效且顺利。

LongCat-Flash架构图

针对智能体(Agentic)能力,LongCat-Flash自建了Agentic评测集指导数据策略,并在训练全流程进行了全面的优化,包括使用多智能体方法生成多样化高质量的轨迹数据等。

通过算法和工程层面的联合设计,LongCat-Flash在理论上的成本和速度都大幅领先行业同等规模、甚至规模更小的模型;通过系统优化,LongCat-Flash在H800 上达成了100 token/s的生成速度,在保持极致生成速度的同时,输出成本低至5元/百万token。