本文由 Intern-S1、Qwen3 等 AI 生成, 由机智流编辑部校对

引言:机器人智能的新篇章

在人工智能飞速发展的今天,机器人不再仅仅是执行简单指令的工具,而是逐渐成为能够与人类自然交互、理解复杂任务的智能伙伴。如何让机器人在动态环境中灵活应对复杂指令、实时处理用户反馈,并完成长期任务规划,成为了机器人领域的研究热点。近日,字节跳动Seed团队推出了一款名为Robix的统一模型,为机器人交互、推理和任务规划带来了革命性的突破。这一模型以其端到端的视觉-语言架构,集成了机器人推理、任务规划和自然语言交互能力,展现了通用机器人系统的全新可能性。

Robix的诞生标志着机器人从单一功能向通用智能的迈进。它不仅能够理解复杂的用户指令,还能通过主动对话澄清模糊意图,实时处理中断,并在动态环境中进行上下文感知的常识推理。字节跳动的研究团队通过创新的训练策略和大规模数据集,让Robix在多项机器人任务中表现卓越,超越了包括GPT-4o和Gemini 2.5 Pro在内的开源和商业模型。这篇推文将带您深入了解Robix的创新点、实验方法和令人瞩目的实验结果,揭秘这一模型如何为机器人智能注入新的活力。

(开源链接和论文地址见文末)

创新点:一台机器人的“全能大脑”

Robix的独特之处在于它将机器人推理、任务规划和自然语言交互无缝整合在一个统一的视觉-语言模型中,充当机器人系统的高层认知层。在传统的机器人系统中,这些功能通常由多个模块分别处理,但这种模块化设计往往导致系统僵化,难以适应动态环境和复杂指令。Robix通过端到端的架构打破了这一局限,成为机器人的“全能大脑”。

图1:分层机器人系统示意图。Robix 作为高层认知层,负责解读任务并对多模态输入进行推理,以生成语言响应和行动方案。低层控制器层执行相应的原子命令,实现与人类及物理环境的交互。

图1:分层机器人系统示意图。Robix 作为高层认知层,负责解读任务并对多模态输入进行推理,以生成语言响应和行动方案。低层控制器层执行相应的原子命令,实现与人类及物理环境的交互。

首先,Robix能够处理复杂的用户指令,并通过链式推理(chain-of-thought reasoning)生成结构化的行动计划。例如,在清理餐桌的任务中,Robix不仅能识别盘子和餐具,还能理解“仅在用餐结束后清理盘子”这样的细微指令,甚至在用户说“留下那个杯子”时实时调整计划。

其次,Robix支持主动对话,能够在指令模糊时主动询问用户意图,比如在面对多种饮料时询问用户偏好。此外,Robix还能实时处理用户中断,动态调整任务计划,并在任务执行中融入上下文感知的常识推理。这种灵活性使得Robix在开放环境中表现出色,接近人类般的适应能力。

更值得一提的是,Robix采用了一种三阶段训练策略,确保其在机器人相关任务和通用多模态能力上的均衡表现。第一阶段通过大规模持续预训练,增强模型在3D空间理解、视觉定位和任务中心推理等机器人相关能力;第二阶段通过监督微调,将交互式任务执行建模为统一的推理-行动序列;第三阶段利用强化学习进一步优化推理与行动的一致性,确保长期任务的连贯性。这种训练策略不仅提升了Robix的机器人任务性能,还保留了其在通用视觉-语言任务中的竞争力。

图2:Robix演示。图示Robix在交互式餐桌整理任务中的表现,展示了其理解复杂指令、处理实时中断、监控任务状态以及主动对话的能力。

实验方法:打造Robix的智能内核

为了实现上述创新,字节跳动Seed团队设计了一套精密的实验方法,涵盖数据构建、模型训练和性能评估三个关键环节。

数据构建:从基础到复杂的多层次数据集

Robix的强大能力离不开其背后的大规模、多样化数据集。团队在持续预训练阶段构建了包含约2000亿高质量token的语料库,覆盖机器人相关任务和通用多模态任务。针对机器人任务,数据集重点增强了3D空间理解、视觉定位和任务中心推理能力。例如,通过ScanNet、3RScan等公开数据集,Robix学习了多视角对应、3D边界框检测和深度估计等空间推理任务;通过AgiBot、Ego4D等机器人数据集,模型掌握了任务状态验证、行动可行性评估和下一步行动预测等核心推理能力。此外,团队还加入了通用视觉理解、视频问答和STEM问题解决等数据,确保Robix在机器人任务之外仍具备强大的多模态能力。

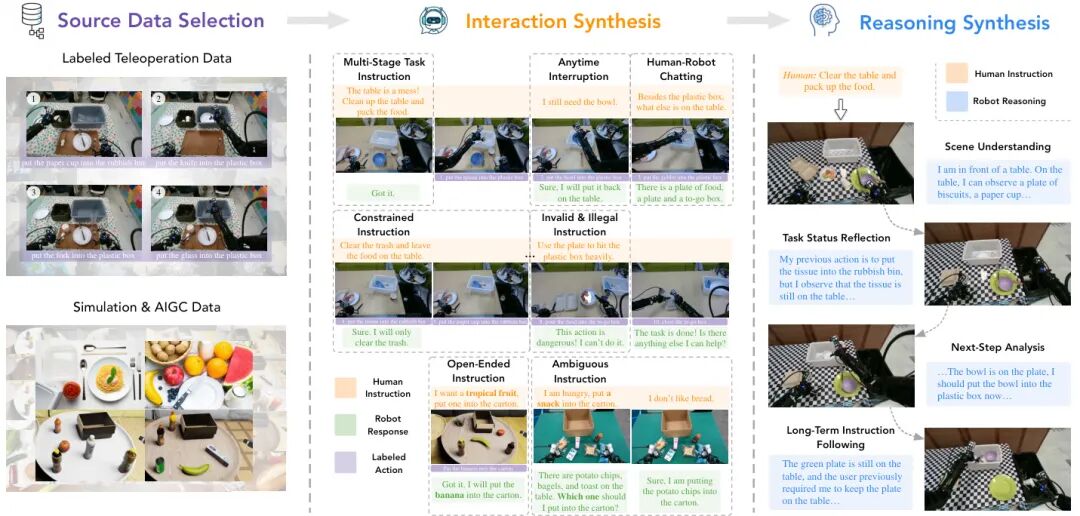

在监督微调阶段,团队通过数据合成技术生成了丰富的交互式任务数据,涵盖多阶段指令、约束指令、开放式指令、随时中断、无效指令、模糊指令和对话指令等多种场景。例如,对于模糊指令,团队构建了包含多种相似物品(如苹果、橙子、梨)的场景,并生成如“将一个水果放入篮子”这样的指令,训练Robix主动寻求澄清。这些数据通过高质量的链式推理标注,进一步增强了模型的推理能力。

图3:Robix预训练数据概览。图示Robix预训练数据的多样性,涵盖3D空间理解、视觉定位、任务中心推理以及通用多模态理解,为模型奠定了坚实的智能基础。

训练策略:三阶段打造全能模型

Robix的训练分为三个阶段,确保其在机器人任务和通用能力上的均衡表现。第一阶段是持续预训练,基于Qwen2.5-VL模型,使用2000亿token的数据集更新所有参数,增强3D空间理解和任务中心推理能力。第二阶段是监督微调,通过合成数据将交互式任务执行建模为统一的推理-行动序列,赋予Robix处理复杂交互的能力。第三阶段采用强化学习(Group Relative Policy Optimization, GRPO),通过与通用视觉推理数据的联合训练和专门设计的推理-行动一致性奖励,进一步优化模型的推理能力和任务连贯性。

在强化学习阶段,团队特别关注了推理的合理性和行动的一致性。例如,在餐桌清理任务中,监督微调模型可能在推理中正确判断应将纸巾丢入垃圾桶,但在行动计划中错误地选择处理纸杯。强化学习通过引入一致性奖励,显著减少了此类错误,确保推理与行动的高度对齐。

图4:Robix数据合成流程。图示Robix的数据合成流水线,从数据源到交互和推理合成的全过程,确保模型具备多样化的交互能力和高质量的推理能力。

评估方法:全面检验Robix的性能

Robix的性能评估分为基础能力和交互任务两个层面。基础能力评估涵盖了31个公开基准测试,涉及3D空间理解、视觉定位、任务中心推理和通用多模态理解。交互任务评估则包括离线评估和在线机器人任务。离线评估通过AGIBot数据集和内部设计的分布内/外基准测试,检验Robix在长期任务规划和交互能力上的表现。在线评估则在真实场景中测试Robix,涵盖餐桌清理、结账打包、饮食过滤、杂货购物和餐具整理与运输五种任务,分别在人类遥控和自动视觉-语言-行动(VLA)控制两种模式下进行。

实验结果:Robix的卓越表现

实验结果显示,Robix在机器人相关任务和通用多模态任务中均取得了显著突破,展现了其作为通用机器人系统的巨大潜力。

基础能力:机器人任务的全面提升

在基础能力评估中,Robix在3D空间理解、视觉定位和任务中心推理等机器人相关任务上表现突出。相较于其基础模型Qwen2.5-VL,Robix-7B和Robix-32B在8个空间推理基准测试中的7个上取得了显著提升,平均准确率分别达到73.4%和75.8%,相比Qwen2.5-VL的66.9%和70.7%有了明显进步。在视觉定位任务中,Robix在LVIS-MG基准上的F1分数分别提升了39.6和25.0个百分点,展现了其在物体定位和细粒度视觉理解上的强大能力。在任务中心推理方面,Robix在AgiBot-ER基准上比基础模型分别提升了12.8和7.2个百分点,超越了Cosmos-Reason1-7B和RoboBrain-2.0-32B等模型。

在通用多模态理解和推理任务中,Robix保持了与基础模型相当的性能,但在某些基准(如MathVista和MMMU)上仍落后于商业模型如Gemini-2.5-Pro。这表明Robix在机器人任务上的优化并未牺牲其通用能力,但要在通用多模态推理上进一步追赶,还需更大规模的数据和模型。

交互任务:超越商业模型的灵活性

在交互任务的离线评估中,Robix在分布内和分布外场景中均表现出色。在内部设计的分布外基准测试中,Robix-32B的准确率分别比最强的商业模型Gemini-2.5-Pro高出3.0和11.8个百分点,展现了其在未见过场景中的泛化能力。在AGIBot评估集上,Robix同样在长期任务规划中表现优异,成功应对多阶段、约束和开放式指令。

图6:交互任务的离线评估结果(上表为离线评估数据集的统计情况)。下表中数值为准确率。对于内部分布内的无效任务和重新规划任务,使用 F1 分数进行评估。每个评估集的最佳结果用粗体显示,基线模型中的最佳结果则用下划线标出。

在线机器人任务的评估进一步验证了Robix的实用性。在餐桌清理、结账打包、饮食过滤、杂货购物和餐具整理与运输五种场景中,Robix-32B在任务进展指标上分别比Gemini-2.5-Pro高出1.6和4.3个百分点,相比其他基线模型更是领先28.1至64.6个百分点。无论是人类遥控还是自动VLA控制模式,Robix都能稳定地生成上下文感知的行动计划,并通过自然语言与用户进行流畅交互。

图7:由人类标注员操作 UMI 设备作为底层控制器的在线评估结果。结果显示 Robin想-32B再大部分任务上优于Gemini-2.5-Pro。

图7:由人类标注员操作 UMI 设备作为底层控制器的在线评估结果。结果显示 Robin想-32B再大部分任务上优于Gemini-2.5-Pro。

未来展望:通向通用机器人智能的桥梁

Robix的发布为通用机器人系统的研发树立了新的标杆。其统一的视觉-语言架构和三阶段训练策略,不仅显著提升了机器人在复杂任务中的推理和交互能力,还为未来机器人智能的发展提供了宝贵经验。字节跳动Seed团队通过大规模数据构建和创新训练方法,成功让Robix在机器人任务和通用多模态能力之间取得了平衡,为机器人从单一功能向通用智能的转变迈出了重要一步。

未来,随着数据规模和模型复杂度的进一步提升,Robix有望在更多场景中展现其潜力,例如家庭助理、服务机器人和工业自动化等领域。

同时,其开源项目页面(https://robix-seed.github.io/robix/ )也为研究者和开发者提供了丰富的资源,鼓励社区共同探索机器人智能的边界。

结语

字节跳动Seed团队的Robix模型以其统一的架构、灵活的交互能力和强大的任务规划性能,为机器人智能领域带来了全新的可能性。从复杂的指令理解到实时中断处理,再到上下文感知的常识推理,Robix展现了通用机器人系统的核心特质。实验结果表明,Robix不仅在机器人相关任务中超越了现有开源和商业模型,还在真实场景中展现了卓越的实用性。这一突破无疑将推动机器人技术向更智能、更人性化的方向迈进,为未来的智能生活注入无限可能。

*注:本文基于arXiv论文《Robix: A Unified Model for Robot Interaction, Reasoning and Planning》(https://arxiv.org/abs/2509.01106)

-- 完 --

机智流推荐阅读:

1. HF八月「Agent智能体」方向论文: AgentFly、GLM-4.5、WebWatcher、Chain-of-Agents等

2. 聊聊大模型推理系统之 MegaScale-Infer:让MoE大模型推理提速1.9倍的三大技术突破

3. MCP-Bench:从金融到科研,UC Berkeley团队揭秘大模型应对多工具协作、长链推理和跨领域协调需求的真实能力

4. 无需微调即可实现99.9%的AIME 2025准确率!Meta AI和UCSD如何用“自信度”革新LLM高效推理?

关注机智流并加入 AI 技术交流群,不仅能和来自大厂名校的 AI 开发者、爱好者一起进行技术交流,同时还有HuggingFace每日精选论文与顶会论文解读、Talk分享、通俗易懂的Agent知识与项目、前沿AI科技资讯、大模型实战教学活动等。

cc | 大模型技术交流群 hf | HuggingFace 高赞论文分享群 具身 | 具身智能交流群 硬件 | AI 硬件交流群 智能体 | Agent 技术交流群