点击下方卡片,关注“大模型之心Tech”公众号

>>点击进入→Agent技术交流群

写在前面

2022年11月,ChatGPT的横空出世彻底改写了AI发展的轨迹。

如今打开Google Trends,“AI Agents”与“Agentic AI”的搜索曲线自2022年底起便一路飙升,成为继生成式AI之后最受关注的两大方向。

但这两个频繁被提及的概念究竟有何区别?为何谷歌要在2025年专门推出A2A协议为其制定标准?

Cornell大学团队近期发表的《AI Agents vs. Agentic AI: A Conceptual Taxonomy, Applications and Challenges》一文,为我们梳理了这一关键演进脉络,更构建了一套完整的理论框架,或许能解答关于下一代智能系统的核心疑问。

一、从MYCIN到ChatGPT:60年AI智能体的演进之路

要理解AI Agents与Agentic AI的差异,首先需要回溯智能体技术的发展历程。早在ChatGPT出现前,AI领域就已围绕“自主智能体”展开探索,但其形态与如今截然不同。

20世纪70年代,专家系统MYCIN横空出世,作为早期智能体的代表,它能通过知识库和推理引擎模拟医生诊断细菌感染,却只能遵循预设规则,无法应对未见过的病例。同一时期的DENDRAL系统虽能预测分子结构,本质仍是“规则执行者”。这些早期系统共同构成了“前LLM时代”的智能体雏形——依赖符号推理、缺乏学习能力,更谈不上自主适应环境。

此后数十年,多智能体系统(MAS)与BDI(信念-愿望-意图)架构逐步发展。Ferber在1999年提出的MAS框架,首次将智能体定义为具备自主性、感知力与通信能力的实体,可用于分布式问题解决;BDI架构则让智能体能够基于目标制定计划,如应用于空中交通管制模拟的系统。但这些进步仍未突破“预编程”的桎梏,智能体的行为边界始终被人类设定的规则所限制。

2022年11月成为关键转折点。ChatGPT的发布不仅引爆了生成式AI的热潮,更让智能体技术迎来“范式跃迁”。文章指出,ChatGPT代表的生成式AI是智能体发展的“ precursor(先驱)”——它首次展现了LLM强大的语言理解与内容生成能力,但本质仍是“被动响应者”,只能根据用户提示产出内容,无法主动规划任务、调用工具。

正是在生成式AI的基础上,AI Agents与Agentic AI逐步分化。2023年,AutoGPT、BabyAGI等框架出现,标志着AI Agents正式落地:它们将LLM与外部工具(API、搜索引擎、代码执行环境)结合,能自主完成多步骤任务,比如规划产品市场分析时,会依次调用网页搜索、数据汇总、报告生成工具。而到2023年底,CrewAI、MetaGPT等系统的出现,又推动技术进入Agentic AI阶段——多个专业智能体协同工作,像人类团队一样分工拆解复杂目标,甚至能动态调整任务分配。

谷歌2025年提出的Agent-to-Agent(A2A)协议,更是为Agentic AI制定了首个行业标准。该协议包含五大核心原则:充分发挥智能体能力、基于现有标准构建、默认保障交互安全、支持长期任务运行、确保模态无关性(文字、图像、语音等均可交互),试图解决不同框架下智能体的互操作问题。

二、AI Agents:单智能体的“工具革命”,从响应到执行的跨越

在明确演进脉络后,我们首先聚焦AI Agents的核心定义与技术细节。文章将其定义为“由LLM和LIM驱动的模块化系统,用于特定任务自动化”,它的出现填补了生成式AI“只会说不会做”的空白。

1. 三大核心特征:定义AI Agents的边界

AI Agents之所以能区别于传统自动化脚本,关键在于三大特征:

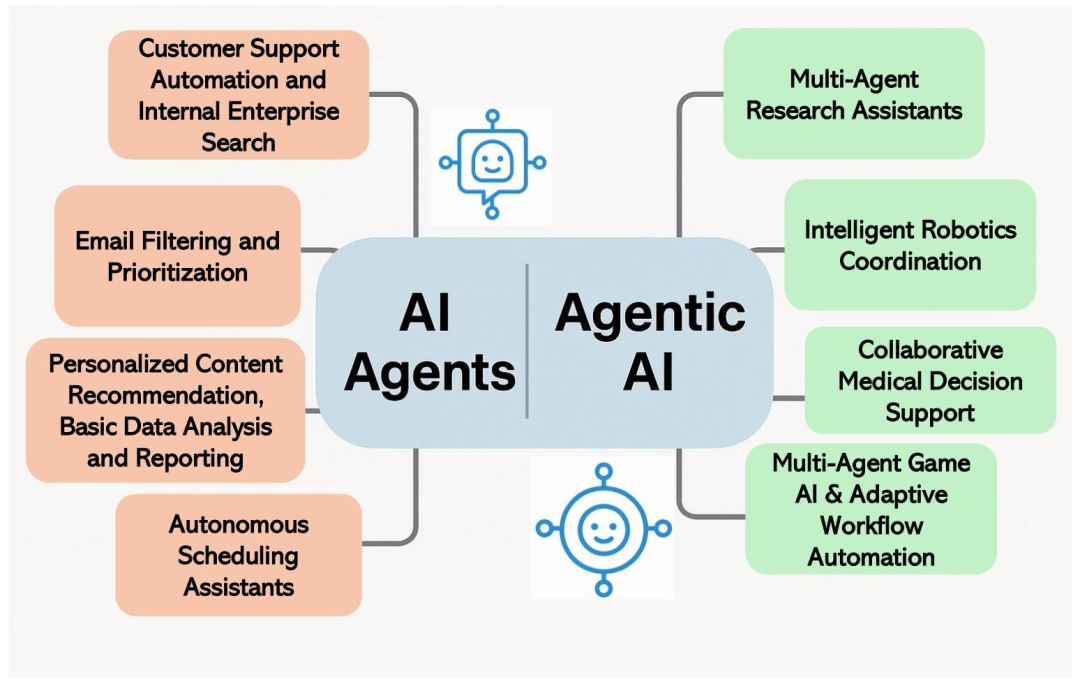

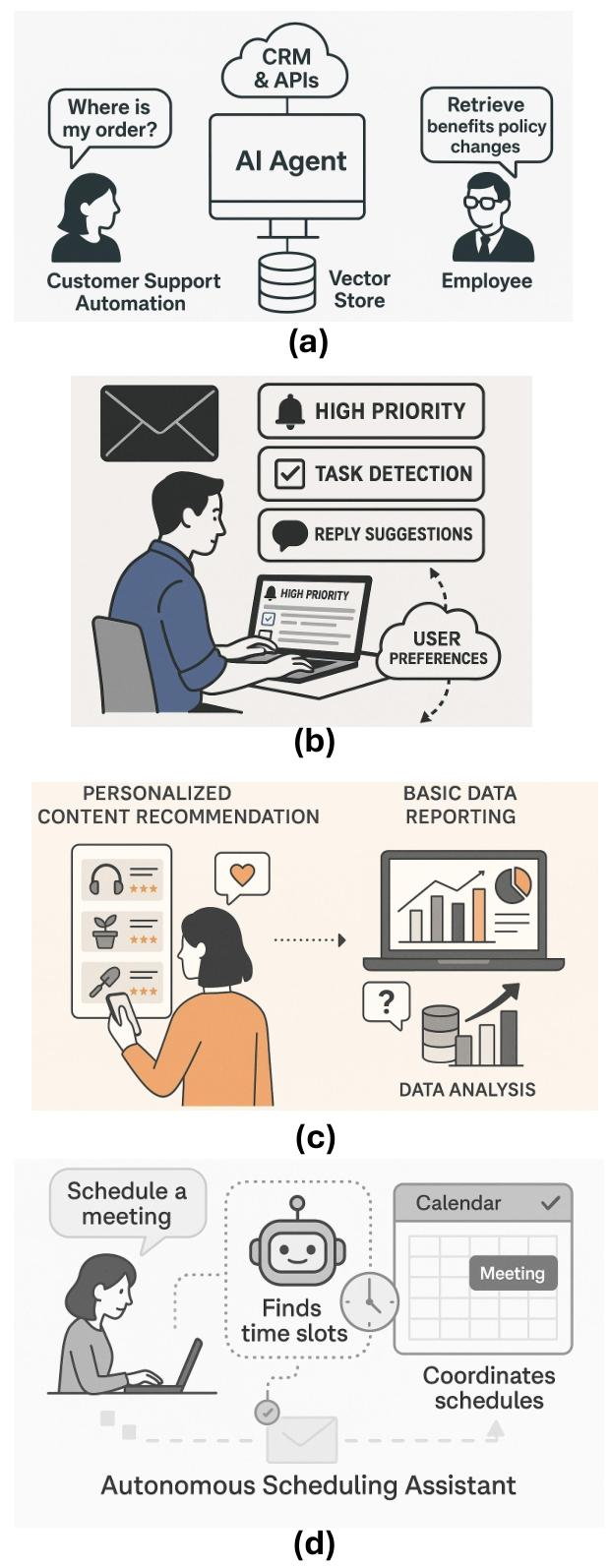

自主性:部署后无需持续人工干预,能自主感知环境输入、推理决策并执行动作。比如客服AI Agents,在接入企业知识库后,可独立处理用户的订单查询、退换货申请,无需人工转接; 任务特异性:聚焦单一、明确的任务领域,而非通用能力。例如邮件筛选AI Agents仅负责分类邮件优先级、提取关键信息,不会涉及日程规划等其他任务; 反应性与适应性:能响应动态环境变化,部分系统还可通过反馈优化行为。以个性化推荐AI Agents为例,它会根据用户的点击、购买记录实时调整推荐内容,甚至通过用户对推荐结果的反馈(如“不感兴趣”)进一步优化算法。

2. 技术基石:LLM与LIM的“双引擎驱动”

AI Agents的能力核心,离不开LLM与LIM的协同:

LLM:推理与决策中枢。以GPT-4、PaLM为代表的LLM,不仅能理解自然语言,还具备规划、推理能力。在AI Agents中,LLM承担“大脑”角色——解析用户目标(如“生成Q3销售报告”)、分解步骤(“1. 调取销售数据库;2. 计算各区域业绩;3. 生成可视化图表;4. 撰写分析结论”)、调用对应工具,并整合结果生成最终输出; LIM:视觉感知的延伸。CLIP、BLIP2等LIM模型让AI Agents具备了“看图说话”的能力,能处理图像、视频等视觉输入。文章中提到的果园巡检AI Agents就是典型案例:无人机搭载LIM模型,可实时识别 diseased fruits(病果)和damaged branches(断枝),并自动触发警报,通知工作人员进行靶向处理。

Anthropic的“Computer Use”项目更是将这种“双引擎”能力推向极致。该项目中的Claude模型,能像人类一样操作电脑:通过视觉识别屏幕内容、控制鼠标键盘、打开软件应用,既能完成填写表单、复制数据等重复性任务,也能进行软件测试(打开代码编辑器、运行命令、调试错误),甚至能自主进行在线研究并整理信息。其核心逻辑是“目标-行动-观察”的循环:接收任务目标→决定下一步操作→执行并观察结果→重复直至任务完成。

3. 工具集成:打破LLM的“知识牢笼”

LLM的静态知识(如GPT-4的知识截止到2023年)和幻觉问题,是AI Agents必须解决的痛点。而工具集成正是关键解决方案。

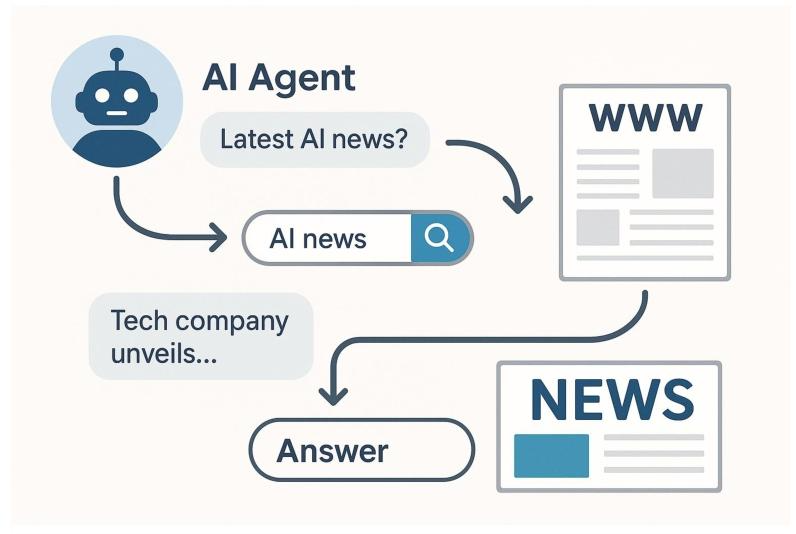

文章将工具集成的过程分为“调用-结果整合”两步:当AI Agents遇到内部知识无法解决的问题(如“查询今日纽约股市收盘价”),会生成结构化的工具调用请求(如JSON格式的API调用指令),通过协调层执行;工具返回结果后,AI Agents会将其重新输入LLM的上下文窗口,结合原有推理继续完成任务。

ReAct框架是这一过程的经典实现。它将“推理(Reasoning)”与“行动(Action)”交替进行:LLM先通过Chain-of-Thought(思维链)分析任务,决定需要调用的工具;执行工具调用后,再根据返回结果调整推理方向,避免盲目行动。例如ChatGPT的网页搜索功能,当用户询问“2024年诺贝尔物理学奖得主”时,它会先判断内部知识不足,调用搜索工具获取信息,再基于搜索结果生成准确回答,而非依赖旧知识或编造内容。

AutoGPT、GPT-Engineer等框架则进一步拓展了工具集成的边界。AutoGPT在处理“产品市场分析”任务时,会依次调用网页搜索工具(获取竞品信息)、Excel工具(整理数据)、报告生成工具(撰写分析);GPT-Engineer则能结合代码执行环境,根据用户需求(如“开发一个简易待办清单APP”)自动生成代码、测试运行并修复bug,最终输出可直接使用的软件产品。

三、Agentic AI:多智能体的“协作革命”,从个体到系统的突破

如果说AI Agents是“单智能体的工具革命”,那么Agentic AI就是“多智能体的协作革命”。文章将其定位为“范式 shift(转变)”,核心在于通过多智能体协作,解决AI Agents无法应对的复杂任务。

1. 概念跃迁:从“孤立执行”到“协同决策”

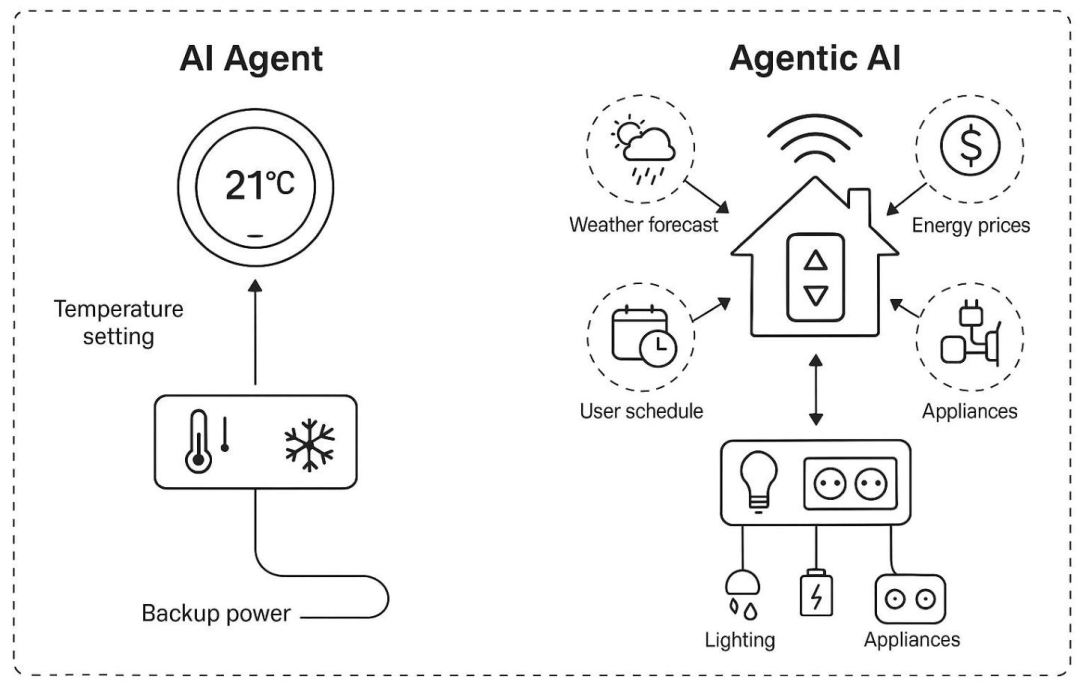

Agentic AI与AI Agents的本质区别,在于“系统级智能”的引入。文章以智能家居系统为例,清晰对比了二者差异:

AI Agents的典型代表是智能恒温器:仅负责维持设定温度,最多学习用户的作息习惯调整能耗,无法与其他设备协同; Agentic AI则是整个智能家居生态:天气预测智能体发现即将出现热浪,会通知能源管理智能体提前用太阳能预冷房屋(避开电价高峰);同时,日程管理智能体发现用户即将外出,会联动安防智能体启动监控、关闭非必要电器。多个智能体通过共享信息、协同决策,实现“舒适、安全、节能”的全局目标。

这种跃迁的关键在于三大能力:

动态任务分解:由“规划智能体”将用户的高-level目标(如“完成科研项目申报”)自动拆分为子任务(“1. 检索相关文献;2. 撰写研究方案;3. 制作PPT;4. 检查格式合规性”); 多智能体分工:每个子任务分配给对应专业智能体(文献检索智能体、写作智能体、设计智能体、合规检查智能体),避免单一智能体“身兼数职”导致的效率低下; 协同与适应:通过共享记忆(存储任务进度、上下文信息)和通信协议,智能体间可实时同步状态。若某一智能体任务失败(如文献检索智能体无法获取某篇论文),系统会自动重新分配任务(如切换其他数据库检索),而非整体停滞。

2. 架构创新:协调层与共享记忆的“双支柱”

Agentic AI要实现高效协作,离不开两大核心架构组件:

协调层(Orchestration Layer):通常由“元智能体(Meta-Agent)”担任,负责任务分配、进度监控、冲突解决。以ChatDev(用于软件开发的Agentic AI系统)为例,它模拟企业部门架构,设置“CEO智能体”(制定开发目标)、“CTO智能体”(技术方案设计)、“工程师智能体”(编写代码)、“测试智能体”(检测bug),由“CEO智能体”作为元智能体协调各角色,确保开发流程顺畅; 共享记忆(Persistent Memory):分为情景记忆(任务执行历史)、语义记忆(领域知识)、向量记忆(用于快速检索相似信息),解决多智能体的“信息同步”问题。例如科研协作Agentic AI系统中,文献检索智能体获取的论文摘要会存入共享记忆,写作智能体可直接调用,无需重复检索;同时,写作智能体对文献的解读标注,也会更新到共享记忆,为后续PPT制作智能体提供参考。

3. 典型案例:从科研到医疗的场景落地

文章列举了多个Agentic AI的实际应用,展现其在复杂场景中的优势:

多智能体科研助手:以AutoGen框架为例,用户提出“撰写AI在农业中的应用综述”后,系统会分配:1. 检索智能体:调用学术数据库获取近5年论文;2. 总结智能体:提取每篇论文的核心观点;3. 整合智能体:按主题分类观点,构建综述框架;4. 写作智能体:撰写正文;5. 引用智能体:自动格式化参考文献。整个过程无需人工干预,效率远超单一AI Agents; 智能机器人协调:在果园采摘场景中,Agentic AI系统包含:无人机测绘智能体(生成果园地图、标记成熟果实位置)、采摘机器人智能体(按地图定位采摘)、运输机器人智能体(将果实运至存储点)、路径规划智能体(实时优化机器人路线,避开障碍物)。若某台采摘机器人故障,系统会自动将其任务分配给附近机器人,确保采摘进度不受影响; 医疗决策支持:在ICU场景中,Agentic AI系统由多个专业智能体构成:1. 监测智能体:实时分析患者生命体征,预警 sepsis(败血症)风险;2. 病史智能体:调取电子病历,汇总患者既往病史、用药记录;3. 治疗智能体:结合临床指南(如《拯救脓毒症运动》),推荐抗生素方案、输液量;4. 协调智能体:整合各智能体信息,检查方案一致性(如避免药物过敏),最终向医生提交决策建议。这种多智能体协作,既减少了医生的认知负担,也降低了单一智能体误判的风险。

四、挑战与破局:从技术瓶颈到未来 roadmap

尽管AI Agents与Agentic AI发展迅速,文章也毫不避讳地指出了当前面临的核心挑战,并提出了针对性解决方案。

1. 两大范式的共性与差异化挑战

AI Agents的痛点:

因果推理缺失:LLM擅长识别相关性,但无法区分因果。例如,某AI Agents发现“医院就诊人数增加”与“感冒发病率上升”相关,却无法判断是感冒导致就诊增加,还是就诊人数多导致交叉感染; LLM固有缺陷:幻觉(生成虚假信息)、知识滞后(无法获取实时数据)、提示敏感性(微小提示变化导致结果大幅差异); 长期规划能力弱:在多步骤任务中易“卡壳”,如生成报告时某一步工具调用失败,无法自主恢复,只能停滞。 Agentic AI的新增挑战:

误差传递:一个智能体的错误会扩散至整个系统。例如,若验证智能体误判某篇论文为“相关”,后续总结、写作智能体都会基于错误信息工作; 协调瓶颈:智能体间目标对齐难、通信易产生歧义。比如,规划智能体拆分的“撰写报告”任务,写作智能体可能理解为“1000字摘要”,而用户实际需要“5000字详细分析”; 涌现行为不可预测:多智能体交互可能产生未预期结果。例如,某Agentic AI系统中,两个智能体为争夺同一API资源,陷入“无限请求”循环,导致系统崩溃; 可解释性差:多智能体的决策链复杂,难以追溯某一结果的具体来源。比如,医疗Agentic AI推荐某治疗方案,医生无法确定是监测智能体的预警,还是病史智能体的记录起了关键作用。

2. 针对性解决方案:技术与架构的双重突破

针对上述挑战,文章提出了十大核心解决方案:

检索增强生成(RAG):为AI Agents提供实时、准确的外部知识,减少幻觉。例如,客服AI Agents通过RAG调用企业最新产品手册,确保回答与当前产品信息一致;Agentic AI中,多个智能体可通过RAG共享同一知识库,避免信息不一致; ReAct框架:强化AI Agents的“推理-行动-观察”循环,提升任务执行的鲁棒性。例如,数据汇总AI Agents在调用数据库后,会先验证数据准确性,再进行后续分析; 因果建模:帮助AI Agents与Agentic AI区分相关性与因果性。通过引入因果图、贝叶斯网络,让智能体理解“为什么”发生,而非仅观察“发生了什么”; 共享记忆架构:解决Agentic AI的信息同步问题,确保所有智能体基于同一上下文工作; 元智能体协调:由专门的协调智能体监控任务进度、解决冲突,避免Agentic AI的协调混乱; 工具验证机制:在AI Agents调用工具后,增加结果校验步骤。例如,代码生成AI Agents运行代码并检查报错,自动修正错误; 程序式提示工程:自动化生成提示,减少AI Agents的提示敏感性。通过模板化、变量化的提示设计,确保相似需求产生一致结果; ** reflexive(反思)机制**:让AI Agents与智能体具备自我批判能力。例如,法律AI Agents在起草合同后,会重新检查条款是否符合法律规定;Agentic AI中,验证智能体可审核其他智能体的输出,确保准确性; 监控与审计 pipeline:为Agentic AI建立完整的决策日志,记录每个智能体的操作、调用的工具、输出结果,便于追溯问题根源; 治理架构:通过角色权限控制、安全 sandbox(沙箱),防范Agentic AI的安全风险。例如,限制敏感智能体(如医疗决策智能体)的操作范围,避免越权行为。

3. 未来 roadmap:从模块化到协同进化

文章最后为两大范式规划了未来方向:

AI Agents的进化重点:提升主动推理能力(从“用户指令驱动”到“场景驱动”,如自动识别用户需要生成报告并启动任务)、深化工具集成(支持更复杂的工具链,如结合机器人硬件)、强化因果推理与持续学习; Agentic AI的突破方向:规模化多智能体协作(支持上千个智能体同时工作)、领域定制化(针对医疗、金融等场景优化协调机制)、伦理治理(明确智能体责任归属,防范偏见放大); 颠覆性探索:文章提及的“Absolute Zero(AZR)框架”或许是下一代技术的关键。该框架试图让智能体“零数据学习”——无需外部数据集,通过自主生成任务、验证结果、优化策略实现进化。例如,科研Agentic AI系统中的智能体,可自主提出假设、设计实验、模拟结果、修正假设,实现“自我驱动”的科研探索。

五、结语:智能体的终极目标,是成为人类的“协同伙伴”

回顾全文,AI Agents与Agentic AI的差异并非“谁更先进”,而是“适用场景不同”:AI Agents适合解决单一、明确的自动化任务,是提升效率的“工具”;Agentic AI则擅长应对复杂、动态的系统性目标,是辅助决策的“团队”。

从MYCIN到ChatGPT,从单一规则执行者到多智能体协作系统,AI智能体的发展始终围绕一个核心目标——缩小“机器能力”与“人类需求”的差距。如今,AI Agents已能高效处理客服、数据汇总等标准化任务,Agentic AI更在科研、医疗、机器人协调等复杂场景中展现出巨大潜力,但这并非终点。文章强调,未来智能体技术的终极方向,是从“自动化工具”进化为“人类协同伙伴”——既能自主完成重复性工作,又能理解人类意图、适应动态需求,甚至在高风险领域(如手术机器人、自动驾驶)与人类共同决策。

要实现这一目标,仍需突破三大关键瓶颈: 一是因果推理的深度化。当前AI Agents与Agentic AI仍依赖统计相关性,难以真正理解“因果关系”,这在医疗诊断、金融风险预测等场景中可能导致致命错误。未来需将因果推断与LLM更深度融合,让智能体不仅能“预测结果”,更能“解释原因”; 二是可解释性的透明化。Agentic AI的多智能体协作链复杂,决策过程常呈“黑箱”状态,这在法律、医疗等需追溯责任的领域难以落地。后续需建立“决策日志+因果追溯”机制,让每个智能体的操作、信息来源、推理逻辑都可审计; 三是伦理与安全的体系化。随着Agentic AI自主性提升,可能出现“目标偏离”(如为完成任务忽视伦理准则)、“安全漏洞”(如被恶意攻击操控某一智能体)等风险。谷歌A2A协议虽迈出了安全标准的第一步,但仍需行业共同制定伦理框架,明确智能体的行为边界、责任归属与风险防控机制。

不可否认,AI Agents与Agentic AI已开启下一代AI的新篇章。当AutoGPT能自主完成市场分析,当CrewAI能协同撰写科研论文,当果园中的多智能体机器人实现高效采摘,我们看到的不仅是技术的进步,更是人类与AI协作模式的重构——人类从“执行者”转变为“决策者”,将重复劳动交给AI,专注于创意、战略等更高价值的工作。

正如文章结尾所言,这份研究不仅是对当前技术的梳理,更是为未来智能体系统绘制的“路线图”。无论是AI Agents的工具集成优化,还是Agentic AI的多智能体协同创新,最终都将指向一个更高效、更安全、更具人文关怀的AI时代。而谷歌A2A协议的提出、AZR框架的探索,也让我们有理由相信,在科研与产业界的共同推动下,“AI智能体成为人类协同伙伴”的目标,将从理论走向现实。

参考

论文标题:AI Agents vs. Agentic AI: A Conceptual Taxonomy, Applications and Challenges

论文链接:https://arxiv.org/pdf/2505.10468

大模型之心Tech知识星球交流社区

我们创建了一个全新的学习社区 —— “大模型之心Tech”知识星球,希望能够帮你把复杂的东西拆开,揉碎,整合,帮你快速打通从0到1的技术路径。

星球内容包含:每日大模型相关论文/技术报告更新、分类汇总(开源repo、大模型预训练、后训练、知识蒸馏、量化、推理模型、MoE、强化学习、RAG、提示工程等多个版块)、科研/办公助手、AI创作工具/产品测评、升学&求职&岗位推荐,等等。

星球成员平均每天花费不到0.3元,加入后3天内不满意可随时退款,欢迎扫码加入一起学习一起卷!