GUI 智能体正以前所未有的速度崛起,有望彻底改变人机交互的方式。然而,这一领域的进展正面临瓶颈:现有数据集大多聚焦于 10 步以内的短程交互,且仅验证最终结果,无法有效评估和训练智能体在真实世界中的长时程规划与执行能力。

长期以来,评估 AI 模型能力的标准主要依赖于静态的、封闭世界的基准测试,例如 MMLU 或 GPQA。这些基准有效地衡量了一个模型“知道”什么,即其知识储备和在特定、孤立任务上的表现。然而,随着 Agent 的兴起,研究界的共识正在迅速转向一个更根本的问题:一个 LLM 及 Agent,如何创造更大的价值?

这种转变催生了新一代的动态、交互式基准,它们旨在评估 Agent 在复杂、开放和不可预测的环境中的实际执行能力。在这个背景下,由 2077AI 开源基金会牵头构建的全新基准 VeriGUI应运而生,VeriGUI 的具备两大核心特征突破——长链复杂性 (long-chain complexity) 与子任务级可验证性 (subtask-level verifiability)。

GitHub 仓库: https://github.com/VeriGUI-Team/VeriGUI Hugging Face 数据集: https://huggingface.co/datasets/2077AIDataFoundation/VeriGUI ArxivPaper: https://arxiv.org/abs/2508.04026

VeriGUI发布至今,迅速在 Hugging Face 荣登月榜第三!这一成就不仅证明了社区对 VeriGUI 价值的高度认可,也为通用智能代理的研究提供了一个更真实、更精细的试验场。

更多内容欢迎加入『大模型之心Tech知识星球』,大模型前沿实验室和产业界的大佬陆续加入星球,欢迎加入我们一起探索大模型!

简介

近年来,自主图形用户界面(GUI)智能体展现出卓越的交互式计算机任务执行能力——它们能够遵循高层级指令完成任务,支持从网页浏览到桌面应用的各类工作流。多模态大语言模型推动了此类智能体原型的研发:它们无需依赖硬编码自动化或领域特定脚本,即可执行复杂决策任务。

然而,开发通用GUI智能体涉及多个复杂过程:它需要具备感知复杂视觉布局的能力、规划长动作序列的能力,以及跨动态异构平台的泛化能力。这同时带来了一个新挑战:如何获取大规模、高质量的数据集——这类数据集需捕捉多样化、真实的人机交互过程,才能有效评估上述智能体的性能。

为应对这一挑战,学界已发布多个数据集与基准测试,以支持自主GUI智能体的开发。尽管取得了可喜成果,现有GUI数据集仍存在两大关键局限:

第一,多数最新数据集聚焦于相对短期的交互——智能体通常仅需几步操作即可完成任务(例如,多数任务步骤少于10步),且操作多为“识别UI元素并执行对应动作”。例如,“查找一封关于发票的邮件”这类任务,通常仅需三步即可完成:打开邮件应用、点击搜索栏、输入关键词。此类交互几乎无需长时程规划或多步推理,而这两种能力对于解决涉及“条件性任务依赖”与“中间状态跟踪”的现实工作流至关重要。

第二,现有评估协议通常依赖仅结果验证——例如,检查是否到达最终页面URL。这种粗粒度监督无法捕捉中间子任务的质量,尤其当任务包含多个相互依赖的子任务时。在这类场景中,若智能体未达成预期目标,研究人员往往难以定位失败的环节或原因,进而无法有效改进智能体的能力。

本研究提出VeriGUI——一个专为GUI智能体开发与评估设计的新型可验证长链数据集。VeriGUI包含桌面端与网页端的多类GUI任务轨迹,且均带有丰富标注;所有轨迹均由人类专家精心构建与标注,确保了“长链复杂性”与“子任务级可验证性”(如图1所示)。具体而言:

(1)VeriGUI的长链复杂性:任务需智能体执行4-8个相互依赖的子任务,涉及数百次GUI操作,且常需在多个应用或网页间切换。值得注意的是,每个子任务均被设计为可作为“有效起点”,这使得研究人员可在任务的不同阶段评估智能体。智能体若想成功完成任务,必须通过自适应推理管理动态任务流——这种设计旨在推动“具备强规划、记忆与决策能力的智能体”的研发,使其能适应各类复杂GUI环境。

(2)VeriGUI的子任务级可验证性:支持对每个子任务的中间结果进行细粒度评估,而非仅验证最终结果。需说明的是,一个子任务包含多个涉及特定GUI操作的步骤;该数据集不验证低层级步骤,而是聚焦于评估“子任务目标是否被正确达成”,从而提供更具信息价值的监督信号。此外,数据集还支持子任务内的“开放式交互”——鼓励智能体通过多样化策略达成子任务目标,而非严格遵循固定步骤序列。

总结来说,VeriGUI的核心贡献总结如下:

提出VeriGUI:一个大规模、人类标注的可验证长链GUI任务数据集,旨在支持现实计算机环境下自主智能体的相关研究。 基于VeriGUI构建综合基准测试:支持多维度评估(包括任务成功率、任务完成率、动作效率),可对智能体在任务执行不同阶段的能力进行细粒度分析,并深入揭示其失败模式与规划瓶颈。 基于多种搭载最先进基础模型的智能体开展大量实验:结果表明这些智能体在长链任务上存在显著性能差距,凸显了当前GUI智能体在复杂规划与决策能力上的局限性。

VERIGUI数据集详解

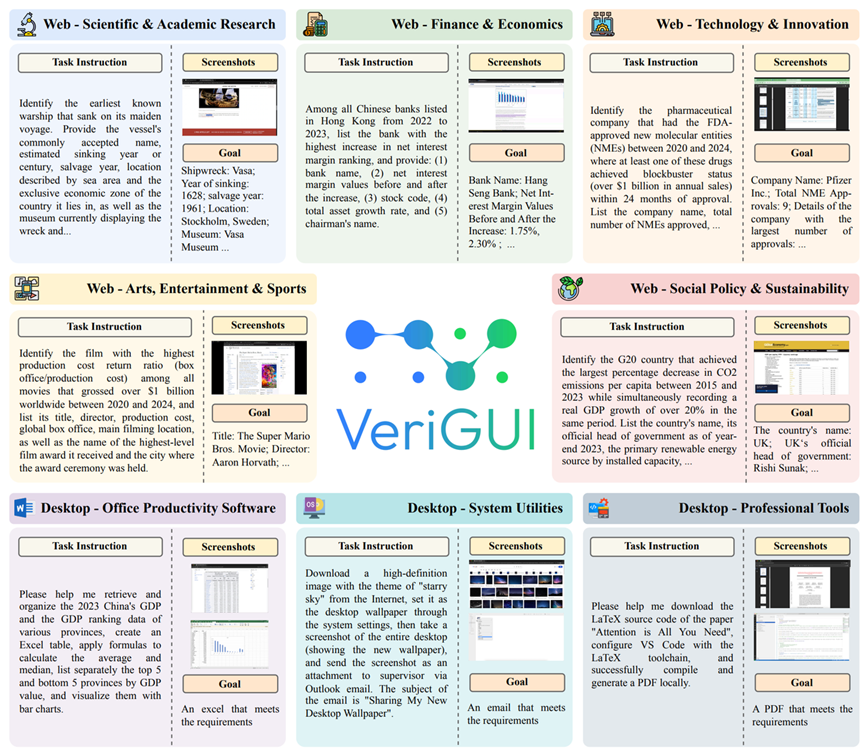

本章将详细介绍VeriGUI数据集的任务构建、数据收集流程与统计分析。如图2所示,VeriGUI主要包含两类任务:网页任务与桌面任务。其中,网页任务聚焦于“需多跳信息检索与推理的深度研究场景”¹,而桌面任务则侧重“涉及复杂GUI交互与系统状态管理的应用操作场景”。

任务构建

VeriGUI中将基于GUI的任务构建为部分可观测马尔可夫决策过程(Partially Observable Markov Decision Process, POMDP),其形式化定义为元组$$,各组件含义如下:

:环境状态集合,代表完整的底层系统配置; :观测空间,为观测函数,用于建模智能体从环境中获取的部分观测信息; :GUI操作的动作空间; :状态转移函数,用于建模GUI环境对动作的(通常为非确定性的)动态响应; :奖励函数,通过子任务级可验证目标定义。

对于VeriGUI中每个带有指令的GUI任务,其完整任务轨迹可表示为,其中为轨迹中的步骤数。为捕捉中间结果并提供密集监督,我们将分解为个子任务序列,使得(表示轨迹拼接)。子任务对应完整轨迹的连续片段,其中与分别表示子任务的起始与结束时间步。每个子任务均关联一个子指令与独立的子任务级目标函数(用于判断智能体是否正确完成第个子任务目标),对应的子任务级奖励定义为。

观测空间:VeriGUI中的GUI任务分为两类,其观测空间定义不同:

网页任务:观测信息包含网页截图与HTML DOM树,为决策提供视觉与结构双重线索; 桌面任务:观测信息仅包含桌面GUI截图。与网页环境相比,桌面任务通常缺乏结构化DOM数据,因此感知过程更依赖视觉信号。

动作空间:动作空间定义了一套适用于网页与桌面任务的统一GUI操作集合(如表2所示),涵盖点击、输入、按键等常见交互方式。执行过程中,智能体每一步从动作集合中选择一个动作;在部分场景中,模型会使用result state()动作输出最终结果。

目标空间:

网页任务:目标定义为“通过网页交互获取正确文本答案”。智能体需主动搜索、导航并推理网页内容以提取所需信息;若最终输出文本与预期答案匹配,则判定目标成功完成。 桌面任务:目标定义为“达到特定系统状态”(如启用某项配置、启动某个应用)。目标完成与否通过截图或辅助功能属性验证——判断当前GUI或系统状态是否满足任务预期结果。

子任务级目标函数为每个子指令提供二元监督,并定义了用于训练与评估的子任务级奖励。

数据收集

数据来源:VeriGUI数据集基于多种真实GUI环境构建,涵盖网页与桌面两大平台:

网页任务:聚焦于需信息检索与推理的深度研究场景,数据来源于公开权威渠道,包括政府机构官网、学术机构平台、在线百科全书、金融数据库与新闻门户网站。任务覆盖五大主题领域:科学与学术研究、金融与经济、技术与创新、艺术与娱乐、社会政策与可持续发展。这种分类确保了主题多样性,且符合复杂信息检索场景下的真实用户需求。 桌面任务:涵盖三类专业与日常工作流中常用的代表性应用领域:办公生产力软件(如Word、Excel、PowerPoint)、系统工具(如设置配置、文件管理)、专业工具(如VS Code、Adobe系列软件)。这类任务需结构化推理、界面导航与顺序决策,能够捕捉多步GUI交互过程。

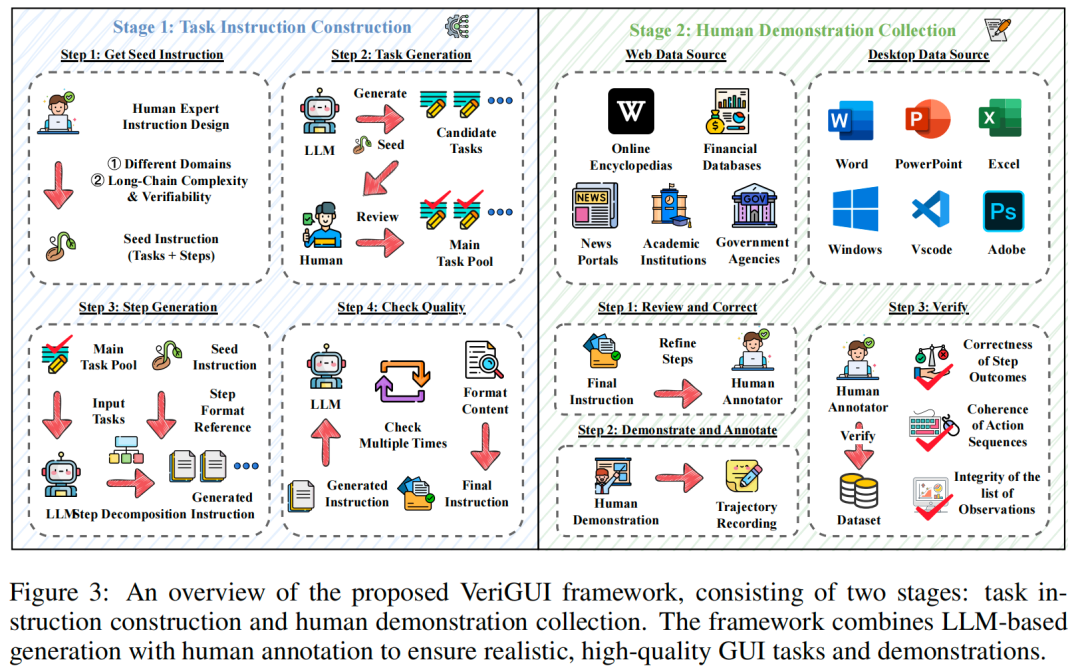

任务指令生成:为生成真实可执行的任务指令,我们设计了“语言模型生成+人工筛选”的多阶段流程(如图3左侧所示),具体步骤如下:

种子指令获取:为每个主题领域手动筛选少量种子指令,这些指令代表高层级用户意图; 任务生成:将种子指令输入语言模型,生成大量候选任务; 人工筛选:标注员审核候选任务,仅保留语法清晰、语义明确且实际可行的任务,形成核心任务池; 子任务分解:基于核心任务池,通过语言模型对任务进行子任务分解,生成包含“子指令细节”的完整任务指令(分解过程由种子指令与严格格式约束引导); 多轮验证:生成的指令先经过自动化过滤,再通过多轮模型评估进行严格验证,仅保留通过所有验证环节的任务。

该流程在保证指令生成效率的同时,确保了GUI数据集所需的事实准确性、多样性与任务可行性。

人类演示收集:标注员根据给定的最终任务指令手动执行每个任务,并记录完整的轨迹演示(如图3右侧所示)。执行前,标注员会优化子任务序列以确保可行性与操作流畅性,并可在交互过程中根据需要调整;演示过程通过屏幕捕获工具记录,标注内容包括动作日志、观测日志与子任务级目标。

为确保高质量监督与精准基准测试,所有轨迹演示均需经过严格质量控制:既包含自动化检查(验证子任务结果正确性、动作序列连贯性),也包含人工审核(确认观测信息完整性),仅保留符合所有标准的演示数据。这一过程保证了VeriGUI能为长时程GUI智能体提供可靠、可验证的监督信号。

数据统计

为清晰呈现VeriGUI数据集的特征,图4与表3提供了网页任务轨迹的统计摘要,揭示了从多种真实网页环境中收集的GUI任务的构成与结构特征:

任务领域分布(图4a):数据集覆盖五大主题领域,确保了对现实任务的广泛覆盖与多样性; 子任务数量分布(图4b、4c):每个任务被分解为多个子任务(通常为4-8个),这种子任务级结构可为智能体提供中间监督,支持更细粒度的评估与学习; 动作类型分布(图4d):涵盖左键点击、滚动、拖拽等多种低层级操作,完整捕捉GUI交互行为; 步骤数量分布(图4e、4f):多数任务需数百步操作才能完成,凸显了智能体在“长动作序列推理”与“复杂工作流处理”方面的需求(远超简单UI操作)。

综上,这些统计结果表明,VeriGUI任务兼具“子任务可验证性”与“长链复杂性”,为GUI环境下长时程规划与交互提供了真实且具挑战性的基准测试。

实验结果

我们在 VeriGUI 上对多种 SOTA 基础模型进行了全面测试,测试框架涵盖了四种主流范式:

智能体框架: Deep Research Agent、Search Engine Agent、Browser-Use Agent 及 Multi-Agent System。 实验结果: 结果令人震惊——在所有测试组合中,没有任何一个模型的平均任务成功率超过 10%。这清晰地揭示了现有模型在长时程规划、多步推理和复杂决策方面的普遍瓶颈,也印证了 VeriGUI 作为新一代高难度基准的价值。

讨论

当前VeriGUI的实验结果基于130个网页任务的有限子集,且这些任务多聚焦于信息检索场景。有趣的是,我们观察到“深度研究智能体”在该场景下的性能普遍优于“浏览器操作智能体”。这引发了一个重要问题:我们应优先发展深度研究智能体,还是GUI智能体范式仍有望具备更广泛、更强大的通用能力?我们认为后者仍极具潜力,且需从多个角度解读这一观察结果。

GUI智能体在交互任务中具备优势:任务性质对智能体性能有显著影响。当前VeriGUI中的多数网页任务侧重“多跳信息检索与事实整合”——这与深度研究智能体的优势高度契合。然而,对于“文件上传”“账号登录”等涉及界面操作的实际任务,深度研究智能体存在根本性局限:它们无法与界面的视觉布局交互,而这种交互能力正是完成此类任务的核心需求。相比之下,GUI智能体的设计初衷便是“同时处理环境的视觉与结构组件”,能够应对“超越被动信息提取”的交互工作流。因此,VeriGUI的未来版本将纳入更多“强调GUI交互”的网页任务。

GUI智能体的性能被低估:现有多数基于浏览器的GUI智能体依赖“通用多模态模型”与“相对基础的执行框架”,尚未像深度研究系统那样受益于“领域特定优化”或“工具集成”。随着领域发展,我们预计:在“环境建模”“长时程规划”“多模态理解”以及“基于VeriGUI提供的子任务级细粒度监督进行训练”等方面的技术进步,将显著提升GUI智能体的推理能力、鲁棒性与决策能力。当前观察到的性能差距并非GUI智能体的根本性局限,而是这一潜力技术处于早期阶段的体现。

GUI智能体或为通用智能体发展提供路径:GUI智能体最令人期待的前景之一,是其作为“更通用AI系统开发基础工具”的潜力。尽管深度研究智能体目前聚焦于网页任务,但GUI智能体天生具备“跨多计算环境(网页、桌面平台)泛化”的能力。它们与图形界面交互的特性使其具备高度灵活性,能够执行“网页浏览”“文档编辑”“系统配置”“数据录入”等多种任务,且无需依赖领域特定规则或流程。这种可扩展性与灵活性为“构建能在多样数字环境中无缝导航、执行任务的通用模型”提供了极具前景的路径。通过提供“统一的任务执行方式”,GUI智能体有望成为“开发真正通用交互式智能体”的关键推动因素。

需注意的是,当前评估仅反映了VeriGUI目标场景的一部分。我们正积极扩展数据集:一方面增加“含交互需求”的网页任务,另一方面补充“涉及复杂软件操作”的大量桌面任务。未来基于扩展数据的实验,将能更全面、均衡地揭示GUI智能体在不同任务类型与环境中的能力。

结论

本研究提出了VeriGUI——一个大规模、人工标注的数据集,旨在满足GUI智能体研究领域对“可验证长时程基准测试”日益增长的需求。与聚焦短期交互且仅依赖结果验证的现有数据集不同,VeriGUI着重强调“长链复杂性”与“子任务级可验证性”,为现实GUI工作流中智能体能力的开发与评估提供支持。

我们基于多种主流智能体模型开展了全面实验,结果表明这些智能体在长时程任务分解与执行方面仍面临持续挑战——这凸显了VeriGUI这类数据集在推动通用智能体智能前沿发展中的重要性。目前,我们已将该数据集开源,并将持续对其进行更新。期望VeriGUI能成为学界的宝贵资源,助力GUI智能体领域的进一步研究。