点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:我爱计算机视觉

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

光流估计是计算机视觉领域的基石任务之一,但其前沿研究长期以来面临着一个严峻的挑战:训练最先进(SOTA)的模型通常需要庞大的硬件集群(例如8块以上的高端GPU),这为许多研究团队和开发者设置了高不可攀的门槛。

为了打破这一“军备竞赛”困局,来自博洛尼亚大学的研究者提出了 FlowSeek,一个全新的、旨在以极简硬件资源实现卓越性能的光流框架。FlowSeek巧妙地将三大技术线的精髓融为一体:最新的光流网络设计、强大的单目深度基础模型以及经典的低维运动参数化。其最终实现了一个紧凑而精确的架构,仅需在单个消费级GPU上训练,其硬件预算比当前主流方法低了约8倍。

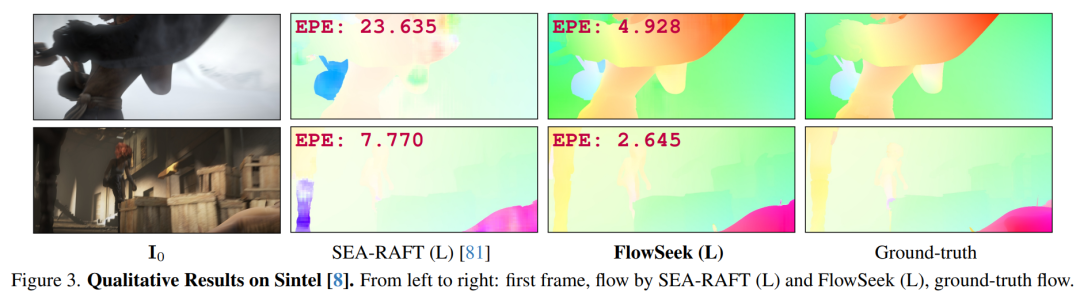

更令人瞩目的是,FlowSeek在大幅降低训练成本的同时,展现出了顶级的跨数据集泛化能力。在Sintel Final和KITTI这两个极具挑战性的基准上,其性能相比之前的SOTA模型SEA-RAFT,分别取得了 10%和15% 的相对提升,证明了其“低成本、高效能”的巨大价值。

论文标题:FlowSeek: Optical Flow Made Easier with Depth Foundation Models and Motion Bases 作者团队:Matteo Poggi, Fabio Tosi 作者机构:博洛尼亚大学(University of Bologna, Italy) 论文地址:https://arxiv.org/abs/2509.05297 项目主页:https://flowseek25.github.io/ 代码地址:https://github.com/mattpoggi/flowseek 会议信息:ICCV 2025

研究背景:打破光流研究的“硬件壁垒”

光流估计旨在计算视频中像素点的逐帧运动。自深度学习彻底改变该领域以来,从FlowNet到PWC-Net,再到以RAFT为代表的循环优化架构,光流模型的精度不断攀升。但这种进步的背后,是对两样东西的巨大依赖:

海量的训练数据:需要带有高质量光流真值的庞大数据集。 强大的硬件算力:需要多GPU并行训练,例如FlowFormer和GMFlow在4块V100上训练,而SEA-RAFT则使用了8块3090。

这种“大力出奇迹”的研究范式,虽然有效,但也使得光流研究变得越来越“昂贵”,阻碍了更广泛的学术探索和技术创新。研究者认为,正如NLP领域的DeepSeek模型用远低于竞争者的预算实现了惊人性能,计算机视觉领域也应探索“循环利用”现有基础模型,而非一味地从零开始“烧钱”训练。FlowSeek正是在这一思想下,对光流估计的“民主化”进行的一次成功探索。

FlowSeek:三大支柱构建的高效架构

FlowSeek的核心思想是“博采众长”,它并非从零设计,而是站在巨人的肩膀上,将三个不同时代、不同领域的先进技术有机地结合起来。其整体架构如下图所示,建立在类RAFT的迭代优化框架之上。

FlowSeek整体架构图。

FlowSeek整体架构图。

支柱一:强大的深度基础模型 (Depth Foundation Models)

这是FlowSeek实现卓越泛化能力的关键。研究者敏锐地洞察到,物体的3D几何结构与它在2D图像上产生的运动(光流)之间存在着强关联。

引入几何先验:FlowSeek直接利用了当前最先进的单目深度估计基础模型(如 Depth Anything v2)。该模型在海量数据上经过预训练,能够为任意单张图片提供高质量的深度图和丰富的几何特征。 特征融合:FlowSeek将深度模型提取的深度图(D)和深度特征(Φ)与光流网络自身提取的图像特征(F)进行拼接,形成“增强特征”(Enriched Features)。这些富含几何先验的特征被用于构建后续的4D相关性金字塔,使得模型在匹配像素时,不仅考虑外观相似性,还考虑了场景的3D结构,从而能更好地处理遮挡、大位移等难题。

支柱二:经典的低维运动基 (Motion Bases)

为了进一步简化学习任务并引入强正则化,FlowSeek借鉴了经典计算机视觉中的思想——用低维参数来表示运动。

运动参数化:对于一个静态场景,任何由相机运动产生的光流场,都可以被分解为六个运动基(B_motion)的线性组合,这六个基分别对应相机在空间中的六个自由度(三维平移、三维旋转)。 提供运动先验:FlowSeek将这组经典的运动基作为先验知识输入到一个小型的“基网络”(Base Network)中,提取出运动特征。这些特征随后被注入到光流的迭代更新过程中,为模型提供了一个关于“可能运动模式”的初始猜测和约束,有效防止了模型在缺乏纹理区域的过拟合,并提升了泛化能力。

支柱三:高效的迭代优化架构

FlowSeek的整体流程沿用了以SEA-RAFT为代表的高效迭代优化框架。一个轻量级的更新网络(UpdNet)在每一次迭代中,综合考虑相关性信息、上一时刻的隐藏状态以及来自深度模型和运动基的上下文信息,逐步地对光流预测进行优化和精炼。

实验结果:低成本实现SOTA泛化

FlowSeek的核心亮点在于其惊人的“性价比”——在极低的训练成本下,实现了顶级的跨数据集泛化性能。

训练成本:8倍的硬件预算削减

所有FlowSeek模型均在单块NVIDIA RTX 3090/4090 GPU上完成训练。相比之下,之前的主流方法通常需要8块同等级或更高级别的GPU。这意味着FlowSeek将训练的硬件门槛降低了约8倍,使得普通实验室甚至个人开发者都有可能复现和跟进这项研究。

跨数据集泛化性能:全面超越SOTA

零样本泛化(Zero-shot Generalization)能力是衡量光流模型鲁棒性的黄金标准。实验将在合成数据集(如TartanAir)上训练好的模型,直接拿到真实的测试集(如Sintel, KITTI)上进行评估。

在Sintel和KITTI 2015上的零样本泛化性能对比。

在Sintel和KITTI 2015上的零样本泛化性能对比。

如上表所示,FlowSeek在所有设置下均稳定超越了之前的SOTA模型SEA-RAFT。

在 Sintel Final 基准上,FlowSeek (L) 取得了 2.18 的EPE(End-Point-Error),相比SEA-RAFT (L) 实现了约 10% 的相对性能提升。 在 KITTI 2015 基准上,FlowSeek (L) 的Fl-all指标达到了 11.2%,相对性能提升更是高达 15% 。

在Spring上的零样本泛化性能对比。

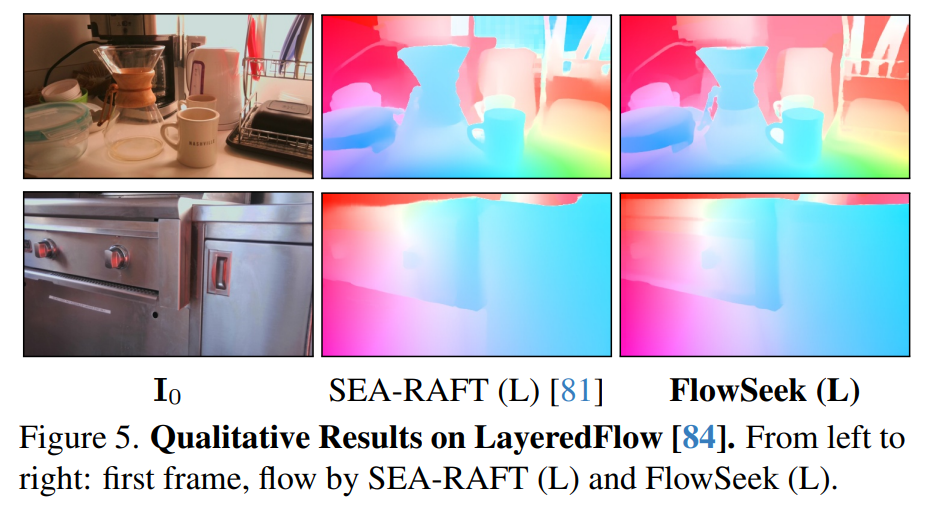

在Spring上的零样本泛化性能对比。 在LayeredFlow (train) first layer evaluation上的零样本泛化性能对比。

在LayeredFlow (train) first layer evaluation上的零样本泛化性能对比。

定性结果对比。

定性结果对比。

此外,在更具挑战性的Spring和LayeredFlow数据集上,FlowSeek同样展现了其优越性,证明了其方法的普适性和强大能力。

总结与贡献

FlowSeek的提出,为光流估计领域乃至整个计算机视觉领域都带来了重要的启示。

提出了首个融合深度基础模型的光流框架:FlowSeek是第一个成功将预训练深度基础模型的强大几何先验知识引入光流估计的模型,并证明了其巨大潜力。 实现了资源高效的SOTA性能:论文最重要的贡献是证明了在无需庞大计算资源的情况下,通过巧妙的架构设计,同样可以实现顶级的模型性能,极大地“民主化”了该领域的研究。 提供了新的研究范式:FlowSeek的成功鼓励研究者们更多地去思考如何“复用”和“适配”现有的基础模型来解决新问题,而不是一味地投入到新模型的“从零训练”中,这对于促进AI领域的可持续发展具有重要意义。

CV君认为,FlowSeek不仅是一个优秀的光流模型,更是一种值得借鉴的、务实而高效的研究哲学。它清晰地指明了一条在“后基础模型时代”,应如何进行算法创新的有效路径。

3D视觉硬件,官网:www.3dcver.com

3D视觉学习圈子

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群成立啦,微信:cv3d001