本文由 Intern-S1、Qwen3 等 AI 生成, 由机智流编辑部校对

在多模态人工智能领域,一个长期困扰研究者的难题是:理解任务(如图像到文本的转换)和生成任务(如文本到图像的合成)真的能相互促进、共同受益,还是仅仅在模型中“和平共存”却各自为政?

这个看似简单的疑问,却揭示了当前统一多模态模型(UMMs)发展的核心瓶颈。许多现有方法将两者视为独立的模块,导致训练过程脆弱,相互间缺乏真正的协同效应。想象一下,如果一个模型能像自编码器一样,将图像“压缩”成文本,再从文本“解压”回图像,且在这个循环中不断优化自身,那将带来怎样的突破?

近日,由北京大学(PKU)、百度ERNIE团队、Rabbitpre AI、中山大学(SYSU)和中国科学技术大学(USTC)等机构的研究者们联合发表的论文《Can Understanding and Generation Truly Benefit Together — or Just Coexist?》给出了一个令人振奋的答案。

他们提出了一种名为UAE的新框架,通过重建目标和强化学习,实现了理解与生成的真正统一,并在实验中观察到多模态学习的“aha时刻”——模型自主进化出更精细的描述能力,重建图像的保真度随之飙升。这不仅仅是技术上的创新,更是向真正智能多模态系统迈出的关键一步。让我们一探究竟,看看这项工作如何回答那个开篇的问题。

论文链接:http://huggingface.co/papers/2509.09666

背景:多模态模型的统一之困

多模态模型的统一一直是AI研究中的热点,但传统方法往往陷入困境。现有的统一多模态模型(如Emu3、Show-o等)在优化生成目标时,会负面影响理解能力,反之亦然。这导致许多工作选择将理解和生成模块分开训练,放弃了潜在的跨任务互惠。为什么会出现这种情况?根本原因是缺乏一个基础的、统一的训练目标来内在连接两者。简单地将两个任务拼凑在一起,只能实现“共存”,而非“共赢”。

为了解决这一问题,研究者们从自编码器的视角重新审视了统一多模态学习。在这个范式中,理解模块被视为编码器(Image-to-Text, I2T),将图像压缩成富含语义的文本描述;生成模块则作为解码器(Text-to-Image, T2I),从文本重建图像。重建保真度成为统一的训练目标,确保信息在双向流动中保持一致。这种设计不仅桥接了理解与生成,还通过重建相似性作为反馈信号,促进两者相互强化。论文强调,真正的统一不应只是模块的并置,而是通过单一目标实现互惠:更好的理解产生更信息丰富的文本,从而提升生成的准确性;反过来,更强的生成能力迫使理解模块捕捉更多细节。

这项工作的灵感来源于观察到现有模型的局限性。例如,在扩散模型主导的生成任务中,联合训练往往导致表示退化。作者通过引入重建循环,巧妙地化解了这一矛盾,并证明了这种方法在实际中的可行性。

UAE框架:从预训练到强化学习的统一之路

UAE框架的核心在于将理解和生成置于一个重建循环中。首先,研究者们为解码器设计了大规模的预训练阶段,使用700K长上下文图像-描述对(每对描述超过250个英文单词,分辨率1024x1024)。这些描述由InternVL-78B模型生成,强调物体、属性、空间关系和场景组成。此外,他们还从GPT-4o中蒸馏了50K高质量样本,进一步提升描述的细粒度和一致性。这种长上下文预训练让解码器学会捕捉复杂语义和组合逻辑,为后续统一优化奠定基础。

在架构上,UAE采用简洁的编码-投影-解码设计。编码器基于Qwen-2.5-VL 3B模型,包括视觉编码器和自回归语言模型,用于处理图像和提示生成语义表示。解码器则使用SD3.5-large扩散变换器,通过一个轻量级投影头(两层线性层)将编码器的最后隐藏状态映射到条件空间。这种模块化设计保持了接口最小化,同时保留了各组件的优势。为了适应强化学习阶段,他们在编码器和解码器上应用LoRA适配,确保在保留预训练知识的同时高效学习新任务。

强化学习是UAE的亮点所在。作者提出了Unified-GRPO(Unified Group Relative Policy Optimization),这是首个以互惠方式优化理解和生成的RL方案,分三个阶段进行。首先是冷启动重建阶段,使用语义重建损失温和初始化编码器和解码器,确保图像-文本-图像循环的基本对齐,而不引入自回归或去噪损失。其次是“生成促进理解”阶段:编码器作为策略模型,生成一组描述,通过冻结的解码器重建图像,并以CLIP图像编码器的余弦相似性作为奖励,优化编码器产生更信息丰富的描述,从而提升视觉理解能力。最后是“理解促进生成”阶段:角色反转,解码器作为策略模型,从编码器的描述或图像嵌入中重建图像,奖励信号迫使解码器利用每一个细节,提高长上下文指令跟随和生成保真度。

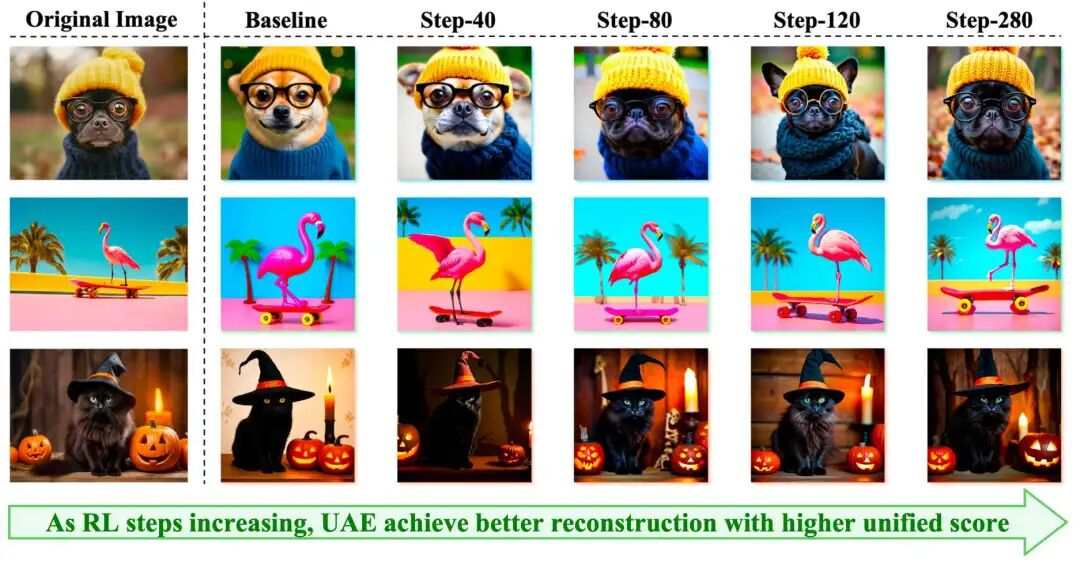

有趣的是,在RL过程中,作者观察到多模态学习的“Aha Moment”:随着训练推进,编码器自主生成更长、更丰富的描述(从简单类别到详细属性、关系和光照),而解码器同步提升对这些描述的解读能力,导致重建图像的保真度显著提高。这证明了理解和生成并非简单共存,而是通过重建目标实现了真正的互惠共赢。

Unified-Bench:首个专为统一度量设计的基准

为了评估统一多模态模型的真正统一程度,作者引入了Unified-Bench,这是首个专为UMMs统一分数设计的基准。它超越了单独评估生成或理解的能力,转而聚焦于重建循环的互惠。从100张多样化源图像开始,模型先生成详细描述,然后从描述重建图像,使用CLIP、LongCLIP、DINO-v2和DINO-v3四个视觉骨干计算相似性,并报告整体分数。这种协议直接测试理解提取的语义是否足以支持忠实重建,反过来验证生成的完整性。

在实验中,UAE在Unified-Bench上取得了最高整体分数(86.09),超越GPT-4o-Image(85.95),并在CLIP、DINO-v2和DINO-v3上领先。这表明UAE在保留布局、纹理和语义方面更出色。相比之下,其他模型如BLIP-3o(76.56)和Show-o(69.16)虽在单个任务上表现不错,但统一分数较低,突显了互惠的重要性。

实验结果:理解与生成的双赢

论文的实验部分全面验证了UAE的效能。在文本到图像生成上,UAE在GenEval基准中取得统一模型中的最佳整体分数(0.86,未使用LLM重写;0.89,使用重写),特别是在计数(0.84)和颜色归属(0.79)上领先,展示了强劲的组合理解和指令跟随能力。在更难的GenEval++上,UAE整体分数0.475,领先于颜色/计数(0.550)和位置/计数(0.450)。DPG-Bench结果同样出色,UAE在实体(91.43)、属性(91.49)和关系(92.07)上位居前列,整体84.74,仅次于Bagel。

更令人印象深刻的是,UAE提升了理解模型作为描述器的能力。在Unified-Bench协议下,其生成的描述重建相似性最高(整体86.09),远超Qwen-2.5-VL-7B(81.92)。通过Claude-4.1、GPT-4o等商业LLM判别,UAE的描述在成对比较中胜率高达94.7%(vs. Show-o),证明了其在完整性、属性绑定和关系保真度上的优势。

定性分析进一步佐证了这些发现。在GenEval++可视化中,UAE准确处理多实体场景,避免了颜色泄漏和计数错误。在“Aha Moment”展示中,随着RL步数增加,描述长度延长,重建保真度提升,形成协同进化。Unified-Bench案例研究显示,UAE的描述捕捉了细微细节(如“耳朵不可见”),导致重建图像更接近原图。

讨论:挑战、扩展与未来方向

尽管取得了显著进展,作者也坦诚讨论了局限性。例如,文本渲染是当前弱点,由于训练数据中文本丰富样本较少,未进行针对性RL。未来可引入OCR奖励优化这一方面。图像到图像(I2I)重建实验显示,长描述嵌入与图像嵌入在实践中近似等效,表明长上下文监督的高带宽价值。

在扩展上,UAE可自然应用于图像编辑:通过结合VAE潜在空间和重建目标,实现像素级保留与语义修改的平衡。架构演进包括精炼连接器和进一步解耦编码/解码,以实现更纯净的自编码器原则。长文本监督被视为所有任务的基础,提供更高信息密度的对齐信号,尽管带来计算挑战,但通过重建奖励可有效控制冗余。

这项工作强调,长文本数据集的缺乏是社区痛点,他们的700K数据集为此提供了宝贵资源。总体而言,UAE不仅回答了开篇问题——理解和生成确实能共同受益,通过重建目标和RL实现互惠——还为未来统一多模态模型提供了可验证的路径。

结语:向真正统一多模态智能迈进

回顾开篇的问题,“理解和生成真的能共同受益 —— 还是仅仅共存?”UAE给出了肯定的答案:通过自编码器范式和Unified-GRPO,它们不仅共存,还形成了正反馈循环,实现互惠共赢。观察到的“Aha Moment”更是多模态AI的里程碑,预示着从分裂到统一的转变。这项由北大元组(PKU-YuanGroup)主导的工作,不仅发布了UAE代码[1]和Unified-Bench,还为社区提供了新工具和洞见。未来,随着更多长上下文数据和针对性优化,多模态模型将更接近人类般的智能。感兴趣的读者不妨试用代码,亲身感受这一突破。

UAE代码: https://github.com/PKU-YuanGroup/UAE

-- 完 --

机智流推荐阅读:

1. LangChain 新一代记忆管理:RunnableWithMessageHistory 全面解析与实战

2. IJRR2025|万字长文解读视觉RL在多目标操作中的痛点与ASIMO的突破

3. 128K上下文+100轮工具调用!港科大联合MiniMax推出WebExplorer-8B,登顶6大信息检索基准

关注机智流并加入 AI 技术交流群,不仅能和来自大厂名校的 AI 开发者、爱好者一起进行技术交流,同时还有HuggingFace每日精选论文与顶会论文解读、Talk分享、通俗易懂的Agent知识与项目、前沿AI科技资讯、大模型实战教学活动等。

cc | 大模型技术交流群 hf | HuggingFace 高赞论文分享群 具身 | 具身智能交流群 硬件 | AI 硬件交流群 智能体 | Agent 技术交流群