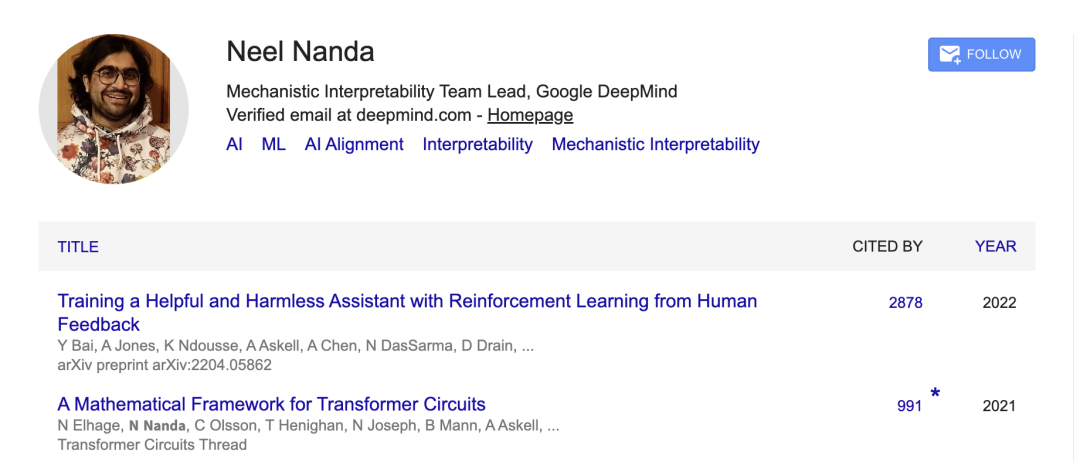

Neel Nanda,今年 26 岁,但已经成为人们口中的“传奇人物”了。

Neel 2020 年本科毕业于剑桥大学纯数学专业,曾在量化金融领域 Jane Street 和 Jump Trading 公司实习,但他觉得这并不适合自己,于是在毕业后花了一年时间探索人工智能安全。尽管涉足机械可解释性研究仅四年左右,Neel 却贡献了多项基础性成果,多篇论文被大量引用。

Neel 曾在 Anthropic 工作,现在又在谷歌 DeepMind 带领团队,过去四年还指导了约 50 人,其中 7 人如今在前沿 AI 公司承担重要工作,还有几位在政府或监管机构担任要职。

他曾发起一个挑战:在一个月内每天写一篇博客,以克服完美主义带来的停滞。这些博客帮助催生了“机制可解释性”领域,顺便也让他遇到了四年来的伴侣。他在自己的 YouTube 频道上传了自己阅读著名论文并分享见解的三小时未剪辑视频,其中一条视频的观看量达 3 万。

Neel 管理了 DeepMind 的机械可解释性团队。他原本加入时只想做个人贡献者,但当团队负责人离职时,他顶上去了,尽管没有管理经验。“我不知道自己能否胜任,但总体还算顺利。”“最糟糕的情况,无非是我没带好团队,换个人接手而已。”

在与主持人 Rob Wiblin 的深入对话中,Neel 分享了各种方面的经验,以及他在 Google DeepMind 四年间的一些其他热门见解。我们对原文进行了删减和整理,以飨读者。

Neel: 如果说这是因为我特别聪明、特别有才华,那当然听起来很棒(笑)。我觉得我还算擅长自己的工作,但主要还是运气,这个答案在类似问题里应该更常见。具体来说,我觉得这是“在正确的时间出现在正确的地方”,以及“善于抓住机会、并且为自己创造合适的机会”的结合。

我进入机械可解释性研究的时机刚刚好。当时这个方向很受关注,但规模还非常小。如果你进入的是一个快速增长的领域,比如一家创业公司或者一个新兴研究方向,你能在很短时间里成为最有经验的人之一,而这跟你本身有多厉害并不一定完全相关。我们后面也会聊到,如何才能为自己创造合适的机会。

另一个很重要的原因是,我真的很喜欢管理和指导别人。很多研究人员可能对这件事不太情愿,但我似乎做得还不错。而且通过让 10 到 20 个研究员变得更优秀,我能产生更大的影响力。时间一长,这种效果就会不断累积。最后一个关键点是,我没有在博士学位上浪费五年的时间(笑)。

Neel:这很复杂。人们常犯的一个错误是“必须读完博士”——这完全是错的。博士应该被视为“学习和获取技能的环境”,如果有更好的机会,休学一年往往很容易,甚至可以退学。如果能在靠谱的机构找到研究工作,且预期比读博好,那读博的目的就达到了,可以提前结束,离开。

我最近聘请的 Josh Engels 就是典型例子,他在做可解释性博士研究,并做出了很棒的工作。我当时已经确信他非常优秀,于是说服他提前几年退学,加入我的团队。我知道我很有偏见,但我觉得这是正确的选择。

Neel:我认为进入研究领域最有用的方法之一是导师指导。你可以从博士导师、实验室其他人那里获得,也可以从加入行业研究团队后的同事和经理那里获得。但不同地方的收获差异很大,经验的价值也不同。

很多人没意识到一个非常重要的技能:管理你的导师或经理。这个技能和成为一个优秀研究者是完全不同的。很多著名的博士导师反而是最糟糕的,因为他们太忙没时间指导你,或者因为他们本身是很好的研究者,但并不擅长耐心指导、关心培养别人、为你腾出时间。在行业岗位上也是一样。

我希望为我的团队创造一个环境,让大家能学习、拥有研究自主权,并成长为研究者。如果团队成员都是优秀研究者,我的工作会轻松很多。激励是非常一致的。但有些团队自主权很少,可能只希望你当工程师,或者只能按既定议程做研究。我确实认为工程也是一项真正的技能,在博士里往往很难学,在行业里容易学,但做研究也是一样。

我要特别强调的是,我们仍然需要能够制定新的研究议程、提出创新想法的人。博士环境往往更适合这个,因为你可以自由做任何事情,没有人能阻止你。导师通常也会支持这种自由,但行业经理可能不会。

有些读完博并推荐读博的人强调:我们需要更多能“引领新研究议程”的人,而“被扔进荒野自己摸索”往往是学习这一点的最佳方式之一。可以这么理解:学术界自主权高、支持少,有人能成功,有人会失败。

我认识很多读博读得很痛苦的人,也认识很多很喜欢读博、不想毕业或很开心读完的人。行业里自主权通常较低,但团队间差异很大,不过能参与大项目、资源更充足,能学到更多工程技能,且技能更贴近前沿模型研究。但团队间的差异往往是最关键的。

一个具体建议是,如果考虑加入某个团队或学术实验室,找该导师的学生或团队成员私下聊聊(确保他们会说实话),多问关于导师 / 经理的问题:花多少时间在你身上?能从他们那里得到什么?想改变他们什么?如果某人名声很好但学生说不话,那就是陷阱,别去。

我觉得很无奈的是,想入行的年轻人和招聘方之间存在严重的信息不对称。我招人时,如果觉得这个岗位不适合对方会直接告诉他们,但信息不对称依然存在。你需要收集合适的信息,这样才能做出更好的决定。

有些权威人士很糟糕,尤其是某些博士导师,会优先考虑自己的利益。我听说过有些导师为了让学生多干活,故意不让他们毕业。这太可怕了,我非常鄙视这样的导师。

Neel: 说实话,这条路走得挺曲折的。早在 2013 年左右,我大概 14 岁时,偶然读到了一篇很棒的《哈利波特》同人小说。这让我接触到了 EA(有效利他主义),又进一步读到一些关于 AI 安全的内容。我的反应是:“嗯,这些人说得挺有道理,我接受这些论点。”但之后我很长一段时间什么也没做。在大学里,我做过一些量化金融的实习,比如在 Jane Street。与很多人的印象不同,量化金融其实挺不错的,如果你不在乎 AI 安全的话我会推荐这条路。我本来很可能就走这条路了。

不过后来我参加了一次 80000 Hours 的职业咨询电话,我才意识到自己其实并不真正理解 AI 安全研究,也不清楚它到底意味着什么。那时候接触到的东西比较偏数学,比如 MIRI 的逻辑归纳,我完全不理解它怎么有用,现在我依然不理解(笑)。

后来我通过社区认识了一些在做有趣工作的研究者,比如有人说:“有了 GPT-3,我们可以做一些以前做不到的有意思的事情。”当时 OpenAI 内部已经有很先进的系统,但还是半遮半掩。

真正让我转变是在本科毕业后。本来我计划读硕士,但全球疫情让这个计划变得不太现实。我也拿到了去 Jane Street 工作的 offer,这本来是个很好的选择。但我突然意识到,人生不一定只有两条路。如果我尝试做 AI 安全研究,结果发现很糟糕,那大不了就不做了。

于是我决定先试试。我休了一年假,在不同实验室做了三次 AI 安全的实习。坦白说,我并没有特别享受这些工作,对研究方向也没什么感觉,而且大部分时间处于疫情期,整体体验一般。但我学到了很多,逐渐确信这是一个真实的问题,这里有有意义的研究工作可以做,而我也能胜任。

后来我很幸运地收到了 Chris Olah 的邀请,成为 Anthropic 早期的员工之一。我是他们可解释性团队的第四个人,现在团队已经扩展到二十多人了。我在这个过程中逐渐爱上了这个领域。

回想起来,我之前一直有个困惑:如果一个选择对世界真的很好,但我自己并不喜欢做,那我也坚持不下去。我没法每天都做一件我不享受的事。转折点在于,我发现世界并不公平,这也意味着有时候会有“免费的红利”:有的研究方向既能带来影响力,又真的很有趣、很有智力刺激性。机械可解释性对我来说就是这样,所以我一直做到了现在。

Neel Nanda: 对。那时候 GPT-3 刚出来,很多问题还不清楚。但现在 AI 正在重塑整个世界,这是当下最重要的事情之一。我几乎无法想象自己会去追求一份与此无关的职业。过去我很多疑惑,比如“安全研究到底长什么样?有没有实证工作可做?”现在已经很清楚了。

现在也有更好的基础设施,比如 MATS 这样的教育项目,也有更多岗位。所以如果有人在听我说的这些,并且觉得共鸣:“我应该做点事让 AI 更好地发展,因为我同意这是个真实问题,但我不知道该怎么做,这看起来很吓人,也不知道什么时候开始合适”,那我的建议是:现在就开始。

我要补充一点。很多人,尤其是数学和计算机背景的人,会觉得自己必须去做技术性的 AI 安全研究。这当然是个不错的选择。但在我看来,AI 正在重塑整个世界。如果我们希望 AGI 的转变顺利,就需要很多领域的人才来理解这些问题并投入其中。我们需要好的政策制定者,需要公务员和政治人物;需要记者和科普工作者;需要研究经济影响的人;需要做预测的人。

除非我完全判断错了,否则在我有生之年,AI 一定会深刻改变世界,即便现在的泡沫破裂。所以我们需要大量人在不同岗位上做出努力,让这个过程变得更好。

Neel Nanda: 说实话,我挂电话时还挺烦的,因为他们一直劝我去做 AI 安全研究(笑)。事实证明他们的建议是对的。最有用的一点是,他们帮我联系了一些更有经验的研究者。和他们交流让我觉得:“啊,原来你们是理智的人,在做清晰、靠谱的研究工作,而且这对我来说也像一条真实的职业道路。”

Neel: 在真正的公司工作后,我确实学到了很多组织运作的知识。首先,我想谈谈大机构的共性(和 DeepMind 无关):人们很容易把大公司想象成一个“整体”,仿佛有一个单一的决策者按某个目标来行动。但现实中,如果一个组织超过 1000 人,这种运行方式根本不可行。

初创公司里大家可以互相认识,信息透明。但在大公司里,需要结构和官僚化,决策权被分散到很多人手里。不同的人维护组织的不同利益,他们各自代表不同的立场。决策者都很忙,往往依赖顾问或次级决策人。有些决定在组织较低层级就会做出,但如果问题够重要或分歧够大,就会逐级上升到更高层,直到有人能拍板。因此,如果你以为一个大型组织是以一个完全一致的整体在行动,那就会做出错误预测。

Neel: 这种情况确实会发生。但让我更惊讶的是,大公司内部并不像一个“高效市场”。

举个例子。在股市,我通常不会主动交易,因为如果有赚钱机会,别人可能已经抓住了。我原本也以为公司内部会类似:如果有能赚钱的机会,一定有人在推动;如果会赔钱,一定没人做。但现在我认为这是大错特错。其实,金融市场也并不总是完全高效,对冲基金有时能赚大钱,因为他们有专家能发现别人忽视的机会。同样地,作为 AGI 安全团队,我们能发现其他团队遗漏的、与 AGI 安全相关的机会。

更重要的是,金融市场有大量专门寻找并修复低效的人,但公司里基本没有这样的人,尤其是在安全增值方面。人们都很忙,要关心很多事。再加上一些文化因素,比如机器学习研究者常见的心态是“解决今天的问题,不去预测未来的问题”。

在很多情况下这是合理的,但安全问题往往更微妙、解决更慢,所以必须提前介入。这意味着,如果安全团队不主动推动,很多机会即使大家并不反对,要么要等很久,要么根本不会发生。

Neel: 大体上是的。但我想强调,这并不是因为人们懒惰或不负责任,而是因为他们视角不同、优先级不同、对职责的理解不同。作为一个关心 AGI 安全的人,我可以在其中发挥作用,往更好的方向推动。

Neel: 这对我来说是一次很有意义的经历,也要特别感谢我们的团队负责人 Arthur Conmy,也是我的 MATS 校友。我总结了四个关键点,涉及前沿模型的实际使用者到底关心安全技术的哪些方面:

有效性, 它是否真正解决了大家关心的问题?(隐含的是,这是我们真的关心的问题吗?)

副作用, 会不会损害模型性能,这是学术界常常忽略的一点。比如,你想加一个监控器来识别恶意请求(如网络犯罪),就必须保证它不会频繁误判正常用户请求。

成本, 运行代价是多少?有些几乎免费,比如增加少量微调数据);有些则非常昂贵,比如每次调用都要额外跑一个大模型。

实现成本:这点常被低估。比如“金门大桥 Claude”实验展示了稀疏自编码器的效果。但如果要在生产模型里加一个类似的“伦理开关”,虽然计算成本很低,但要插入到高度优化的矩阵运算堆栈中会很复杂,还会影响整个代码库。其他团队的人可能因此额外耗时,甚至担心被影响,从而产生阻力。

如果要改变底层架构,比如改造 Transformer,不仅要和推理团队合作,还得和预训练团队乃至所有人沟通。而如果只是加一个外部分类器,就容易得多。

我觉得最重要的经验是:要在当下人们关心的问题和长期安全价值之间找到交集。如果能让别人也对你的方法感兴趣,哪怕他们关注的点与安全无关,也能形成联盟,推动实现。这样还能积累经验、优化成本、建立基础设施,以后再说服别人用更安全的变体会更容易。最终,如果你能直接提交一份 PR,让功能无缝集成,而不是请求别人抽出宝贵时间来实现,会更容易被接受。

Neel Nanda: 这是个很好的问题。我觉得有一点很重要:如果要让 Gemini 采用某种安全技术,我和 Google DeepMind 的 AGI 安全团队比任何外部人更有优势,因为我们了解团队真正关心的指标。比如:我们知道要测试监控器在正常请求下的误触发率;我们知道哪些评测是关键(这些并不总是公开的);我们能直接接触模型,并实际去实现。

这意味着,外部研究者的目标应该是做出足够有说服力的工作,让实验室的安全团队觉得值得花时间去验证和扩展。

Neel Nanda: 其实和刚才提到的差不多。你需要考虑,要让技术落地,需要多少利益相关者同意?我的方法复杂吗?成本高吗?副作用是什么?你要尽量做最好的评测,同时要确保实验室安全团队会注意到你。

很多安全研究人员其实认识实验室的人,向他们请教会很有帮助。有些人以为必须找负责人或资深研究员,但那往往行不通。比如,我的经理 Rohin Shah 非常忙,没什么时间帮忙;但如果有人联系我团队里刚加入一年的同事,他们可能时间更充足,也有足够的背景来判断,必要时还能把有前景的成果上报给我。

Neel: 这是个好问题。我认为,如果能成为关键决策者信任且愿意倾听的人,就能产生很大影响力。这不一定是“玩政治”,更多时候,做一个中立、可信的技术顾问影响力可能很大,要真懂行、懂安全,且不偏激。

安全社区有时会觉得“必须把一切都夸大为危险”才能被重视。但我认为 DeepMind 的安全团队需要分清楚:哪些是危言耸听,哪些是真正值得担忧。只有这样,当真的有严重问题时,大家才会认真听。

人们常常忽视了“成为受尊重的技术顾问”这一角色。这并不意味着你不需要理解和适应大公司内部的官僚体系,但这更多是:识别关键决策者,建立你聪明、可靠、深思熟虑的声誉,成为他们在需要时会主动来请教的人。我的经理 Rohin Shah 就是个很好的例子,他通过这种方式对 DeepMind 的安全方向产生了很大影响。

Neel Nanda:这很复杂,但我觉得确实有一些道理。有人会想:“我关心安全,所以我去前沿 AI 公司工作,这样事情就会变好。”这总体上可能比什么都不做要好,但其实可以做得更好,关键是要有计划。

一种计划就是我刚才提到的,要么非常擅长“在组织里游走”,要么就是成为“广受尊敬的技术专家”。但实际上,在 DeepMind 内部,大多数对安全有影响的人并不是这样发挥作用的。更多的情况是,有少数几位资深人员对接整个组织。而像我团队里的人,影响力更多来自做好研究,支持那些推动安全变革的人。

优秀的工程师和研究人员能做很多事,比如证明某个技术真的有效,发明新的方法、降低成本、为某个技术建立有力的证据基础,确保它没有严重的副作用或额外代价,或者直接把技术实现出来。这样决策者就更容易说:“好的,我们就接受你已经写好的代码。” 这其实比去当那个在组织里游走的人更耗时间,但也很重要。

而且,如果在组织里有被大家尊敬的人存在,我本人就非常尊敬 DeepMind 的一些安全负责人,比如 Rohin Shah 和 Anca Dragan,去赋能他们也很有价值。

我还认为,赋能一个团队也很有影响力。比如最近 AGI 安全团队就新建了一个小型工程团队,专门帮助加速大家的研究。你可能会以为这是一家成熟的科技公司,应该没什么可以提升的空间,但其实一个小团队有很多比较特殊的用例,通过优化还是能大大提高研究迭代的速度。我觉得这个团队的作用非常大。

Neel Nanda:是的,我觉得你总结得很到位。不过我也认为“总是选择更安全的方案”其实过于简化。像前沿模型这样极其复杂的系统,提升安全性的方式非常多,而真正能产生影响的部分就是找到其中的共同点。我并不是说大家只能做与当前模型直接相关的安全研究,而是说这些研究最终必须要能关联到实际模型。

我补充一点。要让某项技术真正用到生产模型里,比安全团队决定研究什么难多了。我们团队在研究方向上有相当大的自主权,如果我们判断某件事在 6 到 12 个月后会变得很重要,大家会看到它的紧迫性,那么现在就可以开始准备。

有一句名言,说推动政策改变的方法之一就是“等到危机发生”。但我更希望的是,在安全问题真正出现之前,我们就已经有完善的解决方案。因为很多安全问题在测试中就会有预警信号和迹象,如果因为要赶上线而急着临时修补,往往做出来的方案既不够深入,也不够有效,提前准备则能做得更好。我们产生影响力的路径之一,就是这种“提前准备”。

Neel Nanda:对。在某种意义上,如果真的出现这种情况,那说明安全团队没有尽到责任。我的目标是:在问题变成真正的危机之前,它们就已经被以某种方式标记出来,并且能在那些大家认可的评估指标上被检测到,这样我们就能提前修复,避免事件发生。

我非常推崇一些风险管理框架,比如 DeepMind 的前沿安全框架(Frontier Safety Framework),以及 Anthropic 的 负责任扩展政策(Responsible Scaling Policy)。我觉得这些框架本质上就是在我们可控的范围内制造“可管理的危机”。

举个例子:Gemini 2.5 Pro 在测试时就触发了一个早期预警信号,表明它可能会帮助人们做一些带有攻击性的网络安全操作。我们能通过测试发现这一点非常重要,因为我们事先就设定了阈值:一旦触发这种信号,就必须有相应的缓解措施到位。于是现在团队就投入大量精力,提前把这些缓解方案做好,以便在风险真的可能变得危险之前就能生效。

Neel Nanda: 成为一个好研究者到底需要哪些具体的技能和心态,总体上,首先,你需要有不错的编程能力,这样你才能真正完成事情、做实验。在学术界或独立研究中,能在 Python notebook 这类交互式环境中写“粗糙但能用的小规模代码”就够了,不用构建复杂基础设施或在复杂库中工作。核心是“能粗糙但准确地完成任务”。

另一个技能就是快速迭代。能否快速完成实验、快速看到结果并据此决定下一步,直接导致研究产出和成功率的差异非常明显。

这也引出了另一个点:优先级排序。研究是极具开放性的领域,比很多其他工作都更需要在不确定性下行动的能力。这是一个心理层面的挑战,有些人对此更擅长。我以前是学数学的,到处都是普适真理,可惜机器学习不是这样,研究者必须知道什么时候该深入问题、什么时候该抽象拉远。很多新人往往在这两种倾向里走得太极端。

另一个关键点,是要有实证科学思维和怀疑精神,特别是在机械可解释性研究里。你要在一个庞大且分支繁多的研究决策树里航行,不断得到实验数据、解读数据,理解它们说明了什么、哪些可能是真的哪些不太可能、证据是否有缺陷等,你还需要经常回顾自己过去几周的研究,还要能回顾过去几周的研究,挑战自己深信的假设,思考其缺陷和验证方法。

最后一个关键技能,我称之为“研究品味”。这是一个复杂且常被误解的能力,指对研究项目中“正确的高层决策”有良好的直觉,包括“选什么问题”(有些项目是好主意,有些不是,选对了就成功了一半)、“项目中哪些方向最有前景”,以及低层面的“能否设计出既能验证假设、又可行易实现且切中核心的实验”。

Neel Nanda:我觉得最重要的一个教训就是:你完全可以直接去做。

这听上去很普通,但其实里面有很多需要学习的点。第一,“去做事情”本身是一种技能。我是个完美主义者,经常不想动手,总觉得“这太冒险了,可能会出错”。我打破这种状态的方法是挑战自己:一个月每天写一篇博客。结果不仅让我养成了输出的习惯,还因此认识了我现在的伴侣。

另一部分是我所谓的“扩大自己的幸运面积”:要尽可能创造机会,让好事有可能发生。比如去认识人,偶尔对一些事情说“好”,让别人愿意把机会带到你面前。去参与一些奇怪的、甚至有点吓人的项目。举个例子,我在 YouTube 上发过一个视频:整整三个小时读一篇著名的论文,边读边随手评论,没有任何剪辑。结果有三万人看,大家居然挺喜欢。

还有一个例子是我怎么变成 DeepMind 的团队负责人。当初我只是想做个普通研究员,没想到团队负责人几个月后就离职了,然后我就顶上了。虽然当时完全没经验,也不知道能不能做好,但结果还不错。这就是所谓“扩大幸运面积”——让自己处于能遇到机会的环境里。然后当机会出现时,即使有点害怕,也要敢于说“好”。就算失败了,代价往往也没那么大。最糟糕的情况,无非是我没带好团队,换个人接手而已。

原文链接:

https://www.youtube.com/watch?v=MfMq4sVJSFc

声明:本文为 AI 前线整理,不代表平台观点,未经许可禁止转载。

10 月 23 - 25 日,QCon 上海站即将召开,95+ 精彩议题已上线!快来锁定参会席位,详情可联系票务经理 18514549229 咨询。

今日荐文

你也「在看」吗?👇