一、跨数据中心传输、光通讯成下一战场!

继 Scale-Up、Scale-Out 后,NVIDIA 新喊出的 Scale-Across 是什么?

在人工智能(AI)、机器学习的推动下,全球数据流量正以倍数增长,当前数据中心服务器与交换机之间的连接正从 200G、400G 快速迈向 800G、1.6T,未来甚至可能达到 3.2T 的时代。

市场调研机构 TrendForce 预计,2023 年全球 400G 及以上光收发模块出货量为 640 万个,2024 年约为 2040 万个,预计到 2025 年将超过 3190 万个,年增长率达 56.5%。其中,AI 服务器的需求持续推动 800G 及 1.6T 光收发模块增长,而传统服务器也随规格升级,带动 400G 光收发模块需求上升。

另据法人调查,2026 年 1.6T 光模块需求将大幅超出预期,总出货量预计高达 1100 万支,主要增长动力来自 NVIDIA 与 Google 的强劲采购,以及 Meta、微软、AWS 的部分需求贡献。

光通讯凭借高频宽、低损耗与长距离的特性,逐渐成为机柜内外互联的主要选择,使得光收发模块成为数据中心互联的关键组件。TrendForce 指出,未来 AI 服务器之间的数据传输,都需要大量高速光收发模块 —— 这些模块负责将电信号转换为光信号,通过光纤传输后,再将接收到的光信号转换回电信号。

(来源:思科)

二、光收发模块、光通讯和硅光子有何关系?

从下图前两个示意图可知,目前市面上的可插拔光收发器传输速率可达 800G;下一阶段的光引擎(Optical Engine,简称 OE)已可安装在 ASIC 芯片封装周边,这种形态被称为载板光学封装(On-Board Optics,简称 OBO),其传输能力可支持至 1.6T。

(来源:日月光)

当前业界正致力于推进 “CPO”(Co-packaged Optics,共封装光学)技术,即让光学元件与 ASIC 共同封装,通过该技术实现超过 3.2T、最高达 12.8T 的传输速度;而最终目标则是实现 “Optical I/O”(光学 I/O),达成类似全光网络的技术效果,推动传输速度突破 12.8T。

若仔细观察上图,会发现作为黄色方块的光通讯模块(此前多为可插拔形态)与 ASIC 的距离越来越近 —— 这一设计的核心目的是缩短电信号的传输路径,从而实现更高的频宽。而硅光子制程技术,正是将光学元件整合到芯片上的关键技术。

(来源:日月光)

三、光通讯需求暴增,业界聚焦三种扩展服务器架构

由于 AI 应用爆发式增长,对高速光通讯的需求急剧提升。目前服务器领域主要聚焦 Scale-Up(垂直扩展)、Scale-Out(水平扩展)两种扩展方向,分别对应不同的传输需求与技术挑战;而近期 NVIDIA 又新提出 “Scale-Across” 概念,为业界增添了一个新的思考维度。

Scale-Up(垂直扩展)

(来源:新思科技)

Scale-Up 主要用于机柜内高速互联(上图黄色部分),传输距离通常在 10 米以内。由于对延迟要求极高,其内部仍以 “铜互联”(Copper Interconnects)为主,以避免光电转换带来的延迟与能耗损耗。当前该领域的解决方案,主要以 NVIDIA 的 NVLink(封闭架构)及 AMD 等企业主导的 UALink(开放架构)为主。

有趣的是,NVIDIA 今年推出 NVLink Fusion,首次向外部芯片厂商开放 NVLink 技术,将 NVLink 的应用范围从单一服务器节点延伸至整个机柜级(Rack-Scale)架构,不排除这一举措是为了应对 UALink 的竞争压力。

另一个值得关注的动向是,原本主要专注于 Scale-Out 领域的博通,正尝试通过 “以太网”(Ethernet)进军 Scale-Up 市场。该公司近期推出多款可用于 Scale-Up、符合 SUE(Scale-Up Ethernet,纵向扩展以太网)标准的芯片,这部分的竞争态势可后续关注 NVIDIA 与博通的博弈。

Scale-Out(水平扩展)

Scale-Out 侧重于跨服务器的大规模并行运算(上图蓝色部分),核心目标是解决数据高吞吐量问题,并实现无限扩充。该领域以 “光通讯” 为主要技术支撑,核心网络互联技术依赖 InfiniBand 或以太网(Ethernet),也将直接带动光通讯模块市场增长。

InfiniBand 和 Ethernet 可分为两大阵营:前者更受 NVIDIA、微软等大厂青睐,后者则以博通、Google、AWS 为主要推动者。

提及 InfiniBand,就不得不提该领域的领军企业 Mellanox—— 该公司于 2019 年被 NVIDIA 收购,是提供端到端 Ethernet 与 InfiniBand 智能互联解决方案的核心厂商。此前中国裁定 NVIDIA 违反反垄断法,正是针对这起收购案。另一个关注点是,尽管 NVIDIA 推出了多款 InfiniBand 产品,但也针对以太网推出了 NVIDIA Spectrum-X 等相关产品,呈现 “两大市场兼顾” 的布局策略。

作为另一大阵营,英特尔、AMD、博通等大厂已于 2023 年 7 月联合成立 “超以太网联盟”(Ultra Ethernet Consortium,简称 UEC),合作研发改进型以太网传输架构,成为挑战 InfiniBand 市场地位的重要力量。

TrendForce 分析师储于超认为,Scale-Out 所带动的光通讯模块市场,将是未来数据传输领域的核心战场。

Scale-Across(跨域扩展)

(来源:NVIDIA)

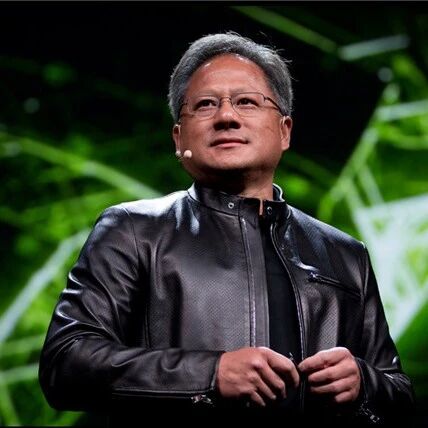

作为新兴解决方案,NVIDIA 近期提出 “Scale-Across” 概念,即跨数据中心的 “远距离连接”,传输距离可超过数公里,并推出以以太网为基础、可串联多座数据中心的 Spectrum-XGS 以太网方案。

Spectrum-XGS 以太网将成为 AI 运算中除 Scale-Up 和 Scale-Out 之外的第三大支柱,核心作用是扩展 Spectrum-X 以太网的极致性能与规模,实现多个分布式数据中心的互联。NVIDIA 介绍,NVIDIA Spectrum-X 以太网不仅能提供 Scale-Out 架构,连接整个服务器集群、实现多座分布式数据中心的互联,将大量数据集快速流式传输至 AI 模型,还可在数据中心内部协调 GPU 与 GPU 之间的通讯。

换句话说,该解决方案融合了 Scale-Out 与跨域扩展的特性,能根据跨域距离灵活调整负载平衡、动态优化算法,因此更贴合 “Scale-Across” 的概念定位。

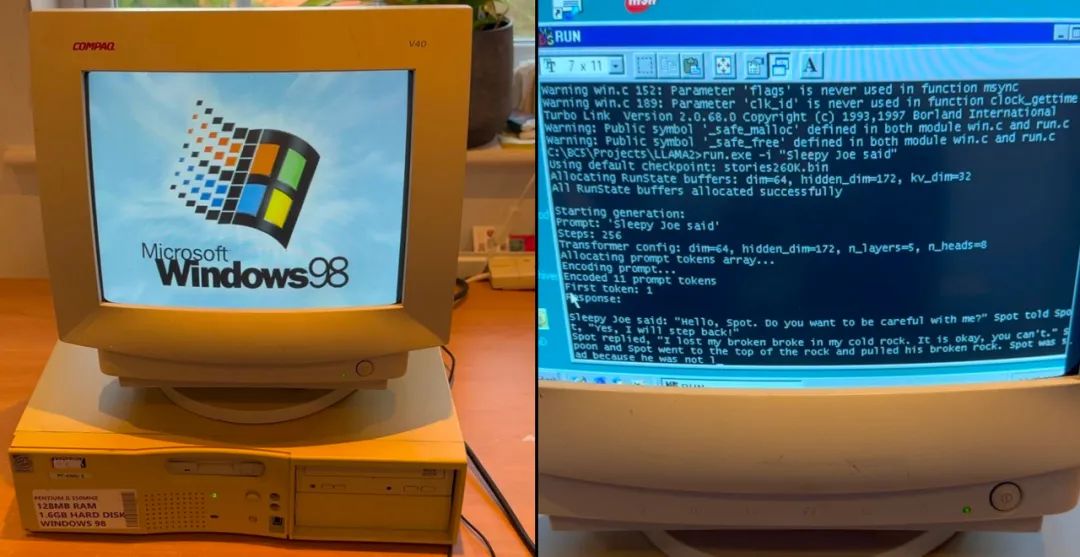

NVIDIA 创始人兼首席执行官黄仁勋表示:“我们在 Scale-Up 与 Scale-Out 能力的基础上,进一步加入 Scale-Across,将跨城市、跨国家乃至跨洲际的数据中心连接起来,打造庞大的超级 AI 工厂。”

从当前产业发展趋势来看,Scale-Up 和 Scale-Out 已是必争之地,可清晰观察到 NVIDIA 与博通如何从对方领域争夺更多市场份额;而 NVIDIA 新提出的 Scale-Across,则聚焦于横跨数公里乃至数千公里的跨数据中心传输 —— 有趣的是,博通也已推出相关解决方案。

四、AI 芯片传输到 CPO 卡位战:NVIDIA、博通到底在竞争什么?

在上一篇了解光通讯与数据中心的三种扩展架构后,就能更清楚,当前市场不仅关注竞争对手 AMD 的动向,更将焦点集中在 AI 芯片龙头 NVIDIA 与全球通讯芯片巨头博通之间的竞争关系上。

事实上,如今 AI 产业的竞争,除了芯片层面的较量,更已延伸到系统级解决方案的比拼。

博通与 NVIDIA 的第一个交集,便是 “定制化 AI 芯片”(ASIC)。由于 NVIDIA GPU 价格高昂,包括 Google、Meta、亚马逊、微软等云服务供应商(CSP)都在自主研发专属 AI 芯片,而博通的 ASIC 研发能力,成为了这些企业的首要合作选择。

除了自研芯片的竞争,另一项更关键的技术领域是 “网络连接技术”,这也是博通与 NVIDIA 的第二个交集。

首先看 Scale-Up(纵向扩展)领域:在 NVLink 和 CUDA 这两大核心技术构筑的 “护城河” 保护下,博通经过长期筹备,终于在今年推出最新的网络交换机芯片 Tomahawk Ultra(战斧),有望切入 Scale-Up 市场,目标挑战 NVIDIA NVLink 的主导地位。

Tomahawk Ultra 是博通一直推进的 “纵向扩展以太网”(Scale-Up Ethernet,简称 SUE)计划的重要组成部分,这款产品也被视为 NVSwitch 的替代方案。博通表示,Tomahawk Ultra 单次可串联的芯片数量,是 NVLink Switch 的四倍,该芯片将交由台积电 5 纳米制程生产。

值得注意的是,尽管博通是 UALink 联盟成员之一,但同时也在积极推广基于以太网的 SUE 架构,因此市场格外关注博通与 UALink 之间的竞争合作关系,以及双方如何联手应对 NVLink 这一共同竞争对手。

为了抵御博通的强势冲击,NVIDIA 今年也推出了 NVFusion 解决方案,开放给联发科、Marvell、Astera Labs 等合作伙伴共同研发,并借助 NVLink 生态系统打造定制化 AI 芯片。外界认为,这是 NVIDIA 为巩固自身生态而采取的半开放式合作策略,也为更多合作伙伴提供了定制化空间与机会。

在 Scale-Out(横向扩展)领域,市场主要由深耕以太网多年的博通垄断,其近期推出的最新产品包括 Tomahawk 6、Jericho4,意在抢占 Scale-Out 及更远传输距离的市场商机。

而 NVIDIA 则推出了多款 Quantum InfiniBand 交换机产品,以及 Spectrum 以太网交换平台,进一步丰富 Scale-Out 领域的产品矩阵。尽管 InfiniBand 属于开放架构,但由于其产品生态主要由 NVIDIA 收购的 Mellanox 掌控,一定程度上限制了客户的选择灵活性。

▲ 根据博通图片,三款产品分别覆盖两种不同的服务器扩展架构 。(来源:科技新报)

针对更长距离的跨数据中心扩展场景(Scale-Across),目前尚无法确定博通与 NVIDIA 谁将占据领先地位,但 NVIDIA 已率先针对这一需求推出 Spectrum-XGS 解决方案。该方案通过全新网络算法,实现站点间更长距离的数据高效传输,同时也可作为现有 Scale-Up 和 Scale-Out 架构的补充方案。

博通的 Jericho4 同样符合 Scale-Across 的应用场景。博通指出,Tomahawk 系列芯片可实现单一数据中心内机柜的串联,连接距离通常不超过 1 公里(约 0.6 英里);而 Jericho4 设备则能支持超过 100 公里的跨机房连接,同时维持无损 RoCE 传输,其数据处理能力约为上一代产品的四倍。

五、那么 NVIDIA 和博通的 CPO 解决方案有何差异?

随着网络传输领域的竞争不断升级,光网络赛道的较量预计将愈发激烈。对此,NVIDIA 与博通均在针对 CPO 光通讯技术探索新方向,而台积电、格罗方德等企业也在积极研发适用于 CPO 的制程与解决方案。

NVIDIA 的策略以系统架构为核心出发点,将光学互联视为系统级芯片(SoC)的一部分,而非外挂式模块。在今年的 GTC 大会上,NVIDIA 正式发布 Quantum-X Photonics InfiniBand 交换机与 Spectrum-X Photonics Ethernet 交换机,其中前者计划于年底推出,后者则预计在 2026 年问世。

这两大平台均采用台积电 COUPE 平台,通过 SoIC-X 封装技术,将 65 纳米的光子集成电路(PIC)与电子集成电路(EIC)进行整合。NVIDIA 这一策略的核心目标,是强调自身平台的整合优势,进而提升整体性能与规模扩展能力。

博通的策略则聚焦于提供全方位解决方案,重点推进供应链的规模化运作,为第三方客户提供完整的模块化方案,助力客户实现技术落地应用。博通方面表示,公司在 CPO 领域的竞争力,源于其在半导体与光学技术整合方面的深厚积累。

目前,博通已推出第三代 200G / 通道 CPO 产品抢占市场。据博通介绍,其 CPO 产品采用 3D 芯片堆叠架构,其中 PIC 同样采用 65 纳米制程,EIC 则采用 7 纳米制程。

从下图可知,光收发模块由激光光源(Laser Diode)、光调制器(Modulator)、光传感器(Photo Detector)等关键元件组成。其中,激光光源负责产生光信号,光调制器负责将电信号 / 数字信号转换为光信号 —— 由于涉及电光转换过程,光调制器也被视为决定单通道传输速度的核心元件。

在关键的光调制器选择上,NVIDIA 采用 MRM(微环调制器,Micro-Ring Modulator)。不过,由于 MRM 尺寸较小,容易受到误差与温度变化的影响,这也成为其规模化应用过程中需要克服的挑战之一。

而博通则选择技术更为成熟的 MZM 调制器(马赫–曾德尔调制器,Mach-Zehnder Modulator),同时也在布局 MRM 技术。目前,博通的 MRM 技术已完成 3 纳米制程试产,并通过芯片堆叠方式,持续保持在 CPO 领域的领先进展。

(来源:Redefine Innovation)

当前,在 AI 推理需求持续扩张的趋势下,市场焦点已逐渐从 “算力竞赛” 转向 “数据传输速度比拼”。无论是博通主打网络与交换技术,还是 NVIDIA 推动端到端解决方案,最终谁能率先突破传输效率与延迟的技术瓶颈,谁就有望在下一轮 AI 竞争中占据先机。

来源:科技新报