点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:我爱计算机视觉

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

最近,具身智能领域又迎来一个非常有意思的工作。我们知道,让机器人像人一样在复杂的环境里持续跟住一个移动目标,其实非常困难,尤其是在目标被遮挡或者周围有长得很像的“路人甲”干扰时,机器人一不留神可能就“跟丢了”。

为了解决这个难题,来自北京大学、中国科学技术大学、北京航空航天大学等机构的研究者们,联合提出了一种名为 TrackVLA++ 的新模型。它给机器人装上了一个“会思考的大脑”和一个“好记性”,让跟踪任务变得既准又稳。

论文标题: TrackVLA++: Unleashing Reasoning and Memory Capabilities in VLA Models for Embodied Visual Tracking 作者: Jiahang Liu, Yunpeng Qi, Jiazhao Zhang, Minghan Li, Shaoan Wang, Kui Wu, Hanjing Ye, Hong Zhang, Zhibo Chen, Fangwei Zhong, Zhizheng Zhang, He Wang 机构: 北京大学, Galbot, 中国科学技术大学, 北京智源人工智能研究院, 北京航空航天大学, 南方科技大学, 北京师范大学 论文地址: https://arxiv.org/abs/2510.07134 项目主页: https://pku-epic.github.io/TrackVLA-plus-plus-Web/ 代码仓库: https://github.com/pku-epic/TrackVLA-plus-plus-Web

“跟不住”的痛点与 TrackVLA++ 的诞生

想象一下,让一个机器人做你的贴身小跟班,无论是在拥挤的商场还是在复杂的办公楼里,它都能紧紧跟着你。这就是“具身视觉跟踪”(Embodied Visual Tracking, EVT)任务。

以前的方法虽然在简单场景下还行,但一遇到目标长时间被挡住,或者旁边出现穿着相似衣服的人,模型就很容易“脸盲”,从而跟丢目标。根本原因在于,这些模型缺少两个关键能力:空间推理和长时记忆。它们无法像人一样去思考“目标大概会往哪个方向走”,也记不住“我要找的人长什么样”。

TrackVLA++ 正是为了解决这一痛点而生。它是一个视觉-语言-动作(Vision-Language-Action, VLA)模型,通过引入两大创新模块,让机器人跟踪能力实现了质的飞跃。

两大“法宝”:会推理、有记忆

TrackVLA++ 的强大之处,主要来自两个精心设计的模块:Polar-CoT 推理机制和目标识别记忆 (TIM) 模块。

Polar-CoT:像人一样“思考”目标方位

这个名字听起来有点复杂,我们拆开看。CoT 指的是“思维链”(Chain-of-Thought),是一种让大模型模拟人类思考过程,一步步进行推理的技术。而 Polar 指的是“极坐标”。

所以,Polar-CoT 的作用就是,不再像以前的方法那样傻傻地去预测目标在图像中的矩形框位置,而是在机器人的自我中心视角下,通过“思考”来推断出目标的相对方位(角度和距离)。这个方位信息被编码成一个非常紧凑的“极坐标 token”,直接告诉模型“目标在你左前方3米处”。

这种方式非常高效,而且天然支持多摄像头输入,避免了不同视角下预测框可能产生的冲突和冗余,让推理变得又快又准。

目标识别记忆 (TIM):只记“对”的,不记“错”的

有了可靠的方位,如何保证在目标消失后还能认出它呢?这就需要 目标识别记忆 (Target Identification Memory, TIM) 模块了。

TIM 模块像一个聪明的守门员,它采用了一种“门控更新”策略。只有当 Polar-CoT 模块非常自信地(高置信度)预测到目标时,TIM 才会用最新的视觉特征来更新自己对目标的“记忆”。如果 Polar-CoT 表示“目标不见了”或“我不确定”,TIM 就会“关上大门”,保持之前的记忆不变,防止被环境中的干扰信息“污染”。

这种机制确保了即使目标被长时间遮挡,机器人心中对目标的样貌记忆依然是清晰、连贯的,一旦目标重新出现,就能立刻认出来。

实验效果:不仅刷新SOTA,还能落地真实世界

研究者们在多个公开基准测试(如 EVT-Bench 和 Gym-UnrealCV)上对 TrackVLA++ 进行了全面评估。

结果非常亮眼。在最具挑战性的 EVT-Bench DT(有干扰物)测试中,TrackVLA++ 的成功率比之前最好的方法提升了高达12个百分点。无论是在单视角还是多视角设置下,都稳居第一。

更重要的是,TrackVLA++ 展现了强大的零样本泛化能力。这意味着它在没有经过专门训练的全新场景中,依然能表现出色。

研究团队还在真实的四足机器人上部署了 TrackVLA++,在充满障碍、路径曲折和有干扰者的真实世界场景中进行了测试。

结果显示,TrackVLA++ 的鲁棒性远超前代模型,成功率提升了7%到17%不等,证明了其在实际应用中的巨大潜力。

消融实验也证明了 Polar-CoT 和 TIM 两个模块的有效性和互补性。去掉任何一个,模型性能都会明显下降。

总结

CV君认为,TrackVLA++ 通过引入类似人类的“推理”和“记忆”机制,为解决具身智能中的长时序、复杂交互问题提供了一个非常优雅且有效的范式。这种设计思路,也许能启发更多关于如何让AI“更懂思考”的研究。

你觉得这种带“思考”的跟踪方法,未来还能用在哪些好玩的机器人应用上?欢迎在评论区聊聊!

3D视觉硬件,官网:www.3dcver.com

3D视觉学习圈子

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

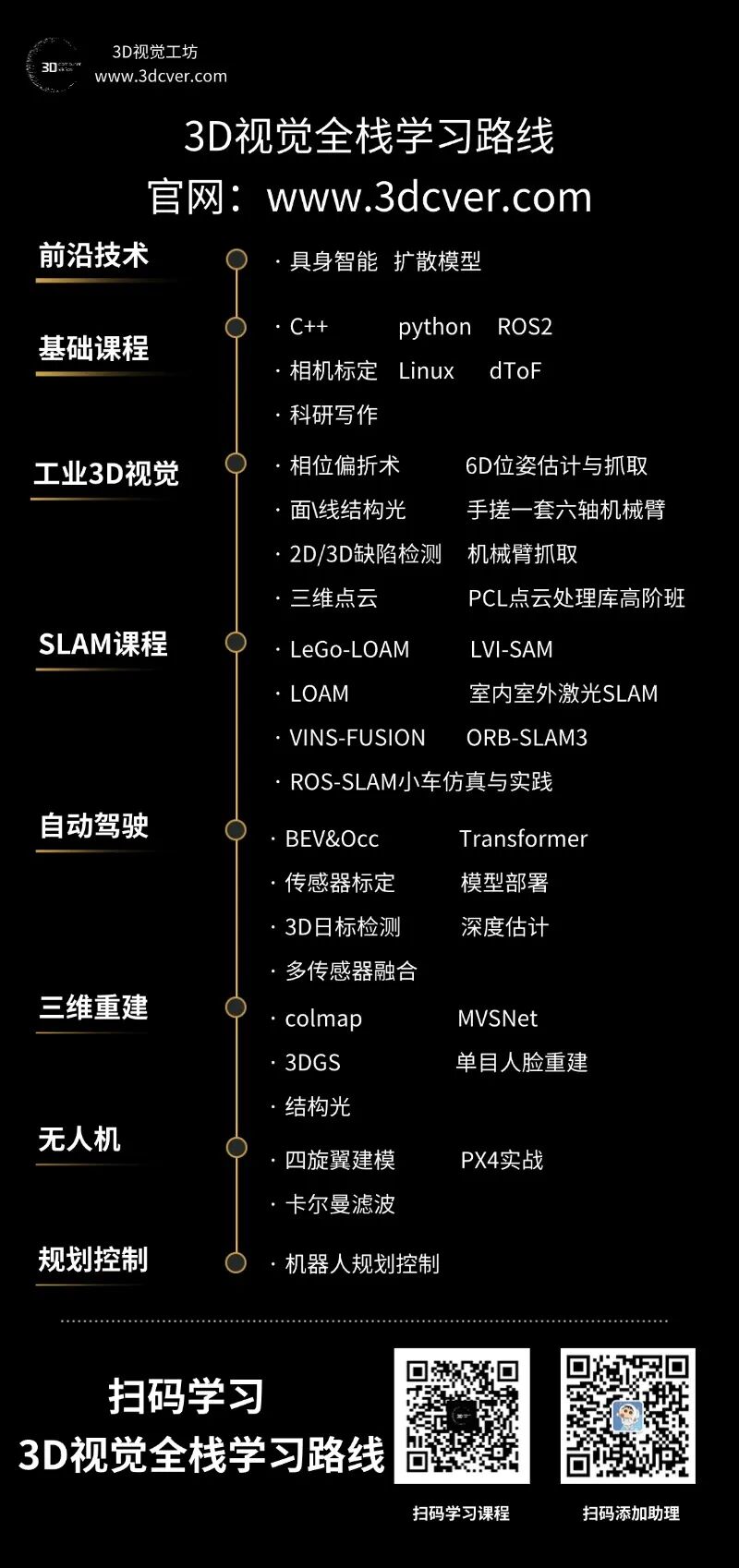

3D视觉全栈学习课程:www.3dcver.com

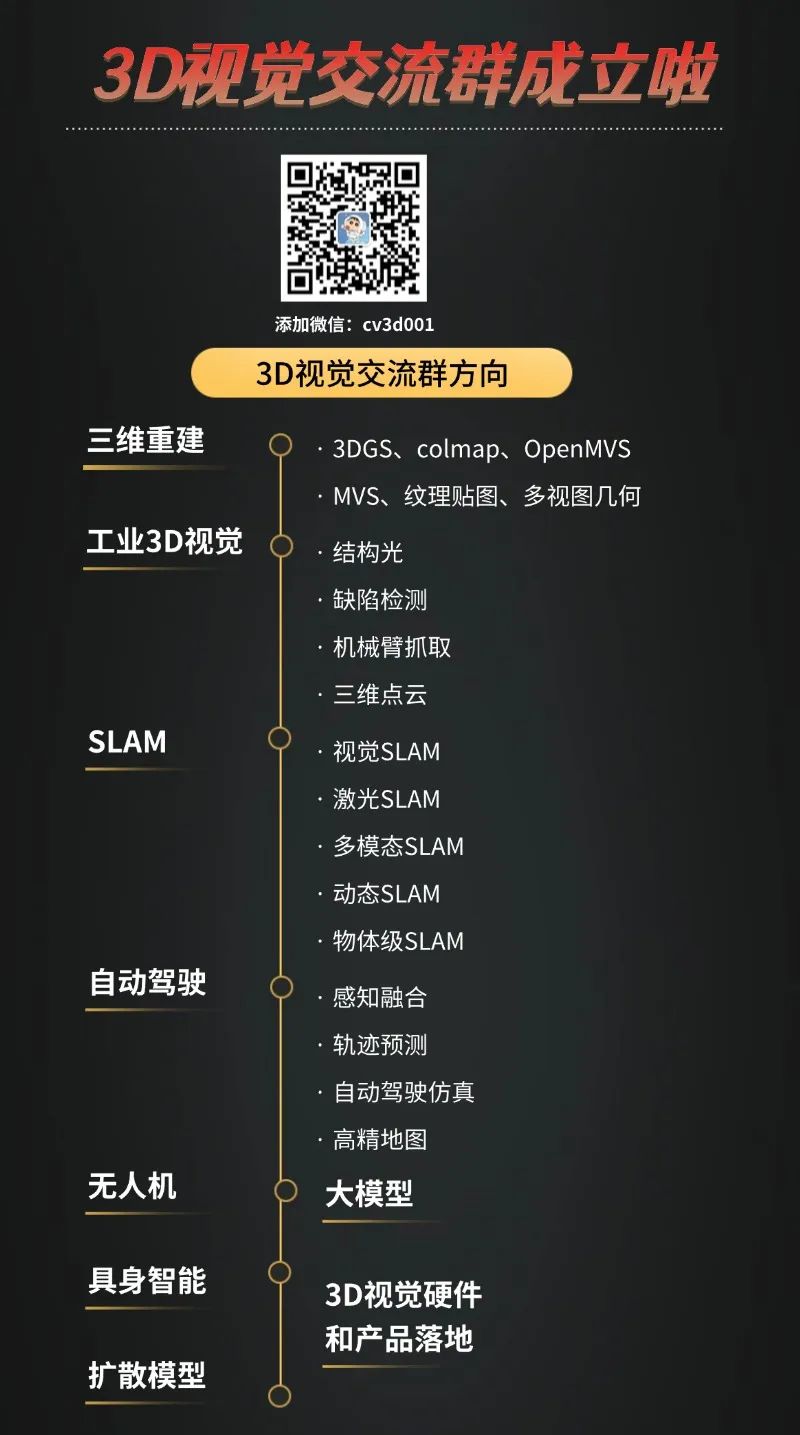

3D视觉交流群成立啦,微信:cv3d001