点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:深蓝AI

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

导读

对于无人机来说,“风”是最难缠的对手。强风不仅会干扰姿态控制,还会让定位系统偏移、导航失准。传统视觉-惯性里程计(VIO)虽然能融合摄像头和IMU信息实现稳定定位,但一旦外界扰动变强,模型假设就会被打破——算法看到的世界与飞行器真实状态产生偏差。

苏黎世大学的 Robotics and Perception Group(RPG) 团队带来了一个新的解决方案:HDVIO2.0(Hybrid Dynamics VIO)。它让无人机在风中“感知”并“理解”外部扰动,实现姿态估计与风力感知的统一。论文近日已被 IEEE Transactions on Robotics(T-RO) 接收发表。研究表明,这套系统能在高达25 km/h的风场中仍保持高精度定位,显著优于现有方法。

论文出处:TRO2025

论文标题:HDVIO2.0: Wind and Disturbance Estimation with Hybrid Dynamics VIO

论文作者:Giovanni Cioffi, Leonard Bauersfeld, Davide Scaramuzza

过去的VIO系统通常只处理视觉和惯性数据,很少引入飞行器动力学模型。而当无人机遇到风或推力误差时,系统无法区分“主动动作”与“外力扰动”,从而导致估计偏差。

HDVIO2.0 的创新在于:让VIO真正理解无人机的运动规律。

研究团队在原版HDVIO的基础上,构建了一个混合动力学模型——一半基于物理方程,一半由神经网络学习残差效应。

● 物理部分使用六自由度刚体方程描述无人机的平移与旋转;

● 学习部分通过两个时间卷积网络(TCN)建模“看不见的力”,例如空气阻力、涡流效应等。

这种混合设计让系统能在不依赖精确模型或状态输入的情况下,实时推断外部扰动力。论文中的图1展示了整体流程:视觉、惯性与动力学模块共同构成一个闭环估计器,实时推算飞行姿态与外部风力。

图1|HDVIO2.0 通过融合视觉、惯性与动力学数据,实时估计无人机的姿态与外部扰动。它的关键在于将物理模型与学习模块结合:前者提供基础运动规律,后者捕捉空气动力和系统误差等复杂效应,让无人机在风中也能保持稳定感知

亮点一:连续时间旋转动力学建模

传统VIO中,旋转运动的积分由离散的陀螺仪数据完成,误差累积严重。HDVIO2.0 引入了连续时间(Continuous-time)建模思想,用 B样条(B-spline) 来表示无人机的角速度曲线。

这种方式能在时间上连续地拟合角速度变化,使系统无需重复使用陀螺仪数据,避免了“旋转约束缺失”的问题。B样条的控制点由优化器根据观测数据动态更新,优化目标是让样条的一阶导数(角加速度)与动力学模型预测值尽量一致。论文指出,这一策略能以非常低的计算成本(单次优化仅数毫秒)实现高精度拟合,从而在实时飞行中稳定更新旋转估计。

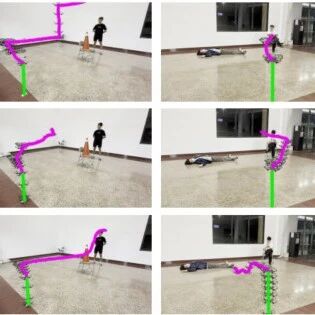

图2|装有阻风板的无人机在由三台工业风机产生的风场中沿圆形轨迹飞行。HDVIO2.0 实时估计无人机的飞行位置(红色轨迹)及外部扰动力(黑色箭头),蓝色轨迹为真实位置。结果显示系统能精准还原风力方向与大小,实现稳态抗风飞行

亮点二:滑动窗口优化与因子图融合

HDVIO2.0 将视觉、惯性和动力学信息统一到一个滑动窗口因子图(Factor Graph)中。

● 优化变量包括:每个关键帧的位姿;

● 每个时刻的无人机状态(位置、姿态、速度、IMU偏差、外力);

● 动力学模型中的控制点与残差项。

系统的目标函数由四类残差组成:

1. 视觉残差(重投影误差);

2. 惯性残差(IMU预积分误差);

3. 动力学残差(基于物理模型的运动约束);

4. 边缘化残差(窗口外历史信息)。

其中最独特的是第三项:动力学残差,它通过预积分理论将动力学方程转化为约束项,与IMU残差并行优化。这一机制让系统能在估计位置的同时,顺带估计“外力大小”与“风向变化”。

图3|该图展示了 HDVIO2.0 的整体优化框架:系统在因子图中同时融合视觉因子、惯性因子与六自由度混合动力学因子,实现对无人机位置、姿态及外部扰动力的联合估计

亮点三:双TCN学习残差动力学

仅靠物理方程仍难覆盖空气动力的复杂性。HDVIO2.0 因此引入了两个独立的 Temporal Convolutional Networks(TCN) 来学习“残差力”。

● 第一个TCN输入推力命令与陀螺仪历史数据,用于预测推力残差;

● 第二个TCN输入力矩命令与陀螺仪数据,用于预测力矩残差。

这两个网络结构对称,均由多层一维卷积组成,输入窗口约为100 ms(10个样本),输出为3维残差向量。

相比RNN或LSTM,TCN计算开销更小,推理速率可达180 Hz(在Jetson TX2上实时运行)。更值得注意的是,这种网络无需真实力标注:训练目标是最小化预测运动与真实运动(位置、速度、姿态变化)的差距,因此可以利用 SLAM 或 SfM 估计的轨迹数据 完成训练,无需昂贵的力传感器。

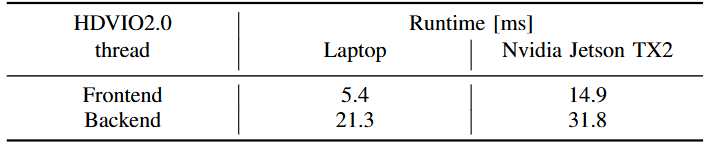

图4|表中给出了 HDVIO2.0 的平均运行时间(单位:毫秒)。其中后端部分包含 B 样条优化 与 神经网络推理。结果显示系统在笔记本和 Jetson TX2 上均可实时运行,能够在每帧图像到来前完成状态估计

HDVIO2.0 在多个公开数据集和真实飞行中都展现出优异表现。

● NeuroBEM数据集中,它在仅使用IMU与控制指令的情况下,估计出的气动力精度接近拥有完整状态信息的NeuroBEM模型。

图5|该表比较了不同方法在 NeuroBEM 测试集上的力(F)与力矩(M)估计误差(RMSE)。其中 Polyfit、NeuroBEM 和 HDVIO2.0 属于数据驱动方法,Quadratic Fit 与 BEM 则基于物理建模。尽管 HDVIO2.0 并未使用任何速度或姿态信息,它的性能仅次于依赖完整状态输入的 NeuroBEM,显著优于所有基于物理模型的基线方法

● 此外,团队还在闭环控制中进行了验证:HDVIO2.0 提供的状态估计比商用RealSense T265更精确,飞行路径与真实轨迹几乎重合。

图6|闭环飞行实验对比在该实验中,HDVIO2.0 提供的状态估计被直接用于无人机飞行控制。图中为俯视轨迹对比:红线为 HDVIO2.0 估计结果,灰线为 RealSense T265 的双目 SLAM 结果,蓝线为动作捕捉系统的真实轨迹。可以看到,HDVIO2.0 的轨迹与真实路径几乎重合,明显优于商用视觉里程计

● 最具代表性的实飞实验,是在25 km/h风场中,带拖曳板的无人机依旧能准确估计风向与扰动力,轨迹误差保持在厘米级。

这些结果表明,HDVIO2.0 不仅是定位系统的升级,更是一套能感知环境动力学的“智能测风”方案

HDVIO2.0 的出现,为无人机的感知与动力学建模带来了新的范式。它不再依赖精确的空气动力学参数,而是以“物理+学习”的混合方式,让系统在复杂气流中也能保持稳定定位。通过将 B 样条连续时间建模、TCN 残差学习 与 滑动窗口优化框架 紧密结合,HDVIO2.0 将原本分离的“状态估计”和“外力感知”合二为一,让VIO真正理解“动力学世界”。

更重要的是,这一框架展示了模型化与数据驱动融合的巨大潜力:物理模型提供可解释性与稳定性,神经网络负责补全复杂气动与非线性扰动,两者相辅相成。实验结果表明,HDVIO2.0 不仅在高风速、高动态场景下稳健运行,还能在低成本硬件(如 Jetson TX2)上实现实时性能。

未来,这种混合动力学VIO思路或将扩展到更多移动机器人平台——从地面车辆到水下机器人——为高动态、不可预测环境下的自主飞行与导航提供新的解决思路。对于无人机研究领域而言,HDVIO2.0 不只是一次算法改进,更是一种设计哲学的转变:让飞行器不再“被动感知”,而是主动理解自身与环境的交互。

审编|阿蓝

3D视觉1V1论文辅导来啦!

3D视觉学习圈子

星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群成立啦,微信:cv3d001