AI 引领者谷歌 DeepMind 的 ICCV 2025 论文合集值得你一读!

论文选自https://paperscope.ai ICCV 论文数据库,解读由Intern-S1等AI 生成!

(1) StochasticSplats: Stochastic Rasterization for Sorting-Free 3D Gaussian Splatting

论文简介:

由Google DeepMind、UBC等机构提出了StochasticSplats,该工作通过结合蒙特卡洛估计器与3D高斯泼溅技术,实现了无需深度排序的实时渲染方法。传统3D高斯泼溅(3DGS)依赖高斯图元的深度排序进行alpha混合,导致渲染伪影、计算开销大且难以平衡渲染质量与速度。StochasticSplats采用无偏蒙特卡洛估计器替代传统排序流程,通过随机采样高斯图元实现透明度混合,消除排序需求的同时支持准确的体积混合。该方法允许通过调整每像素样本数(SPP)动态权衡渲染质量与计算成本,在NVIDIA RTX 4090上以合理画质实现2-4倍于传统方法的渲染速度。研究团队进一步提出可微分蒙特卡洛梯度估计器,支持无需排序的训练流程,并通过线性近似最大密度曲面消除"pop伪影"。OpenGL实现方案确保了跨平台兼容性,实验显示单样本渲染结合时间抗锯齿即可满足语义定位等下游任务需求,为机器人、自动驾驶等低延迟场景提供了高效解决方案。项目代码已开源。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.885

(2) Magic Insert: Style-Aware Drag-and-Drop

论文简介:

由Google DeepMind等机构提出了Magic Insert,该工作提出了一种风格感知的拖放方法,通过将问题分解为风格感知个性化和风格化图像中的真实物体插入两个子任务,实现了跨风格图像中主体的自然融合。针对风格感知个性化,研究者提出结合权重微调与文本嵌入优化,并在推理阶段通过适配器注入目标图像风格特征,使生成主体既保留身份特征又能适配目标风格。对于物体插入问题,创新性提出引导式领域适应(BDA)方法,通过迭代筛选和重训练使基于真实图像训练的插入模型适应艺术风格领域,有效解决阴影缺失、反射不一致等传统方法缺陷。为推动研究,团队还构建了包含700组跨风格主体-背景组合的SubjectPlop数据集。实验表明,该方法在主体保真度(DINO、CLIP-I等指标领先)、风格一致性(CLIP-T、CSD等指标提升)及用户偏好度(85%-95%压倒性优势)等方面显著优于StyleAlign、InstantStyle、AnyDoor等最新方法,尤其在复杂风格迁移和真实感渲染(如阴影、反射、边界和谐化)方面表现突出,为图像编辑领域提供了兼具美学质量与操作灵活性的新范式。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.1818

(3) RoMo: Robust Motion Segmentation Improves Structure from Motion

论文简介:

由Google DeepMind、多伦多大学等机构提出了RoMo,该工作提出了一种结合光流、对极几何和预训练视频分割模型的迭代运动分割方法,通过几何约束与语义特征的协同优化,在动态场景的结构运动(SfM)任务中实现了显著性能提升。RoMo的核心创新在于利用对极几何生成稀疏动态/静态像素标签,并通过SAMv2模型的特征空间训练轻量级分类器,迭代优化运动分割掩码。实验表明,RoMo在FBMS59等基准测试中超越了合成数据监督和无监督方法,在MPI Sintel和新构建的包含真实动态场景的Casual Motion数据集上,与COLMAP等SfM方法结合后,相机姿态估计误差较现有SOTA方法降低40%以上。该方法通过几何引导的语义分割解决了动态物体对SfM刚性假设的破坏问题,同时利用SAMv2的超分辨率能力输出高精度掩码,在8个真实场景测试中成功避免了传统方法因动态物体导致的重建失败问题。研究还揭示了低视差场景下的局限性,并提出未来可结合单应性矩阵优化的改进方向。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.788

(4) TAPNext: Tracking Any Point (TAP) as Next Token Prediction

论文简介:

由Google DeepMind等机构提出了TAPNext,该工作通过将Tracking Any Point(TAP)转化为序列化掩码标记解码任务,实现了一种无需复杂跟踪特定归纳偏置的新型点跟踪方法。TAPNext采用因果循环架构,结合状态空间模型(SSM)和视觉Transformer(ViT),在移除传统跟踪方法中的时间窗口限制和迭代优化后,仍达到当前最佳的在线和离线跟踪性能。实验表明,该方法在DAVIS和Kinetics数据集上均取得领先结果,尤其在长视频处理中展现出显著优势,同时通过可视化分析发现模型在端到端训练中自然学习到了类似成本体积匹配、坐标读取等传统跟踪启发式方法。研究还验证了SSM在时序建模中的有效性,支持并行化处理并保持低延迟特性,为视频理解任务提供了新的范式参考。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.2678

(5) CL-Splats: Continual Learning of Gaussian Splatting with Local Optimization

论文简介:

由ETH Zurich、Stanford University、CTU Prague和Google DeepMind等机构提出了CL-Splats,该工作通过局部优化实现高斯溅射表示的持续学习,能够高效更新动态3D场景。核心贡献在于:1)提出通用框架实现高斯溅射的持续局部更新,支持灵活高效的场景重建;2)设计局部高斯优化策略,通过空间约束避免全局重计算;3)验证了方法在合成与真实场景中的有效性,并支持批量更新和历史恢复等新应用;4)构建了首个用于动态场景重建评测的合成与真实数据集。方法通过DINOv2特征匹配检测2D变化区域,采用多数投票机制将变化提升至3D空间,并利用球体剪枝和动态渲染掩码实现局部优化。实验表明,在合成数据上PSNR达40.125dB(较CL-NeRF提升10dB),真实场景PSNR达28.249dB(提升4.7dB),优化速度达223FPS(较CLNeRF快200倍)。该方法支持并发更新非重叠区域变化,并通过存储局部变化实现历史场景恢复,存储开销仅为传统方法的3%。研究为机器人、混合现实等需要持续更新3D表示的场景提供了高效解决方案。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.2530

(6) MINERVA: Evaluating Complex Video Reasoning

论文简介:

由 Google DeepMind 和 Columbia University 等机构提出了 MINERVA,该工作针对当前视频理解模型仅评估最终答案而缺乏推理过程分析的问题,构建了一个包含详细推理轨迹的复杂视频问答数据集。MINERVA 包含 1,515 个手工设计的多步骤问题,每个问题均配备 5 个选项和详细标注的推理步骤(平均 92 词),覆盖体育、短片、教育视频等多领域(视频时长 2 分钟至 1.5 小时)。数据集通过时间戳标注关键帧、动作描述和逻辑推理链,支持对模型推理过程的细粒度分析。研究发现,即使最强的 Gemini 2.5 Pro Thinking 模型在该数据集的准确率也仅为 66.2%(人类达 92.5%),且模型表现随视频时长增加显著下降。通过构建包含视觉感知、时间定位、逻辑推理和完整性四个维度的错误分类体系,发现模型主要缺陷集中在时间定位(如错误截取关键帧)和视觉感知(如漏检动作对象),而逻辑推理能力相对较好。研究还探索了 LLM 作为评判者的可行性,发现其评分与人类评估在时间定位和感知维度存在较高相关性(Pearson r>0.3),但对完整性评估仍存在偏差。该工作为视频理解模型的可解释性研究提供了基准工具,并揭示了当前模型在时空联合推理上的核心短板。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.1269

(7) Orchid: Image Latent Diffusion for Joint Appearance and Geometry Generation

论文简介:

由Google DeepMind和乔治亚理工学院提出的Orchid,是一种统一的潜在扩散模型,能够通过单个扩散过程联合生成颜色、深度和表面法线图像。该工作通过联合外观与几何先验,解决了传统分离模型在一致性、效率及多任务适配上的局限性。其核心创新包括:1)设计新型变分自编码器(VAE),将RGB、相对深度和表面法线编码至共享潜在空间,并通过颜色预训练和深度/法线重建损失优化;2)构建文本条件潜在扩散模型(LDM),在联合潜在空间中同时建模颜色-深度-法线的生成过程;3)提出颜色条件化微调策略,使模型可从单目图像联合预测几何信息。实验表明,Orchid在零样本深度估计中达到与SOTA方法相当的精度(NYUv2 AbsRel 5.7),法线预测精度提升显著(NYUv2 Mean Error 15.2°),且深度-法线一致性误差降低50%以上。其联合修复能力可直接从部分观测中采样生成一致的3D场景,视觉效果优于多阶段修复方法。该模型为文本到3D生成、单目几何估计及3D修复等任务提供了统一框架,在虚拟现实、机器人导航等领域具有广泛应用潜力。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.992

(8) MA-CIR: A Multimodal Arithmetic Benchmark for Composed Image Retrieval

论文简介:

由首尔国立大学、谷歌DeepMind和韩国大学等机构提出了MA-CIR,该工作针对现有组合图像检索(CIR)基准在算术推理和语义多样性上的不足,构建了一个包含1900个三元组的多模态算术基准。MA-CIR通过引入否定、替换、加法三种算术类型和左-右、空间推理、物体推理等七种复杂语义类别,结合精心设计的困难负样本,系统评估CIR模型的组成理解能力。研究发现当前模型在否定/替换类型和复杂语义任务中表现显著下降,暴露其对物体信息的依赖而非真正的语义理解。为解决此问题,研究者提出利用大语言模型(LLM)作为文本编码器,并通过设计包含困难负样本的文本三元组进行适应性训练,该方法在MA-CIR上实现16%的性能提升,同时在CIRR和CIRCO基准上分别获得6%和9%的改进。实验表明,单纯扩大视觉主干网络或应用微调策略难以有效提升复杂语义理解能力,而基于LLM的文本编码器通过对比学习能显著增强模型对算术操作和语义组合的建模能力。该工作为评估多模态模型的组成推理能力提供了新视角,揭示了当前方法在否定推理和复杂语义建模上的局限性,并验证了大语言模型在提升视觉-语言任务组成理解上的潜力。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.2532

(9) From Prompt to Progression: Taming Video Diffusion Models for Seamless Attribute Transition

论文简介:

由National Yang Ming Chiao Tung University、Google DeepMind、National Taiwan University和UC Merced等机构提出了基于视频扩散模型的平滑属性过渡方法,该工作通过引入逐帧引导机制实现无需训练的渐进属性变化控制。针对现有方法在处理视频属性过渡时存在的不一致问题,研究者提出构建数据特定的过渡方向,在去噪过程中引导视频帧从初始属性逐步过渡到目标属性,同时保留运动动态特性。核心创新包括:1)通过中性提示锚定技术稳定生成过程,避免提示插值导致的突变;2)构建包含运动动态的受控属性过渡基准(CAT-Bench),涵盖人类、物体和背景等8类属性变化;3)提出整体过渡评分和逐帧过渡评分两个评估指标,分别量化属性变化的准确性和平滑性。实验表明,该方法在保持视频质量的同时,显著提升属性过渡的连续性,在CAT-Bench基准测试中整体评分较现有方法提升约28%,帧间平滑度指标提升45%。用户研究显示其结果在转换正确性、平滑性等维度获得49.12%的最高认可度,验证了方法的有效性。该框架为视频生成中的动态属性控制提供了新思路,具有广泛的应用潜力。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.117

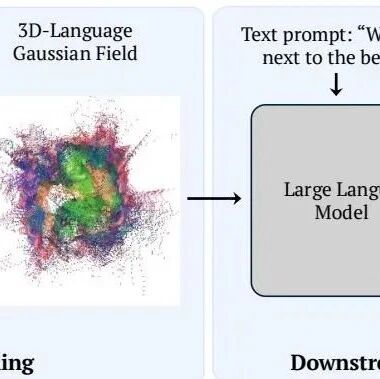

(10) SplatTalk: 3D VQA with Gaussian Splatting

论文简介:

由 Georgia Institute of Technology 和 Google DeepMind 等机构提出了 SplatTalk,该工作提出了一种基于高斯泼溅(3D Gaussian Splatting)的自监督3D视觉问答(3D VQA)方法。该方法仅需多视角RGB图像作为输入,无需深度信息、点云或3D语言标注监督,通过将2D视觉语言模型(如LLaVA-OV)的特征投影到3D高斯场中,构建可直接输入大型语言模型(LLM)的3D语言表示。核心创新包括:1)设计自监督训练框架,将高维语言特征压缩为低维超球面表示,并与RGB特征联合优化;2)提出基于特征熵的自适应采样策略,从3D高斯场中提取关键语义token;3)通过理论推导证明高斯均值特征可有效编码场景语义,支持LLM直接推理。实验表明,该方法在ScanQA、SQA3D等基准上超越了仅使用图像的2D模型,并与使用点云的3D模型性能相当,尤其在空间推理和零样本迁移任务中表现突出。其优势在于无需显式3D结构输入即可实现3D场景理解,同时保留了LLM的强大学习能力,为多模态3D场景理解提供了新范式。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.2061

(11) Visual Chronicles: Using Multimodal LLMs to Analyze Massive Collections of Images

论文简介:

由Stanford University和Google DeepMind的研究者提出了Visual Chronicles,该工作利用多模态大语言模型(MLLMs)分析超大规模图像集合中的时间变化趋势。研究者针对传统视觉分析方法在开放性查询和无标签大规模数据上的局限性,设计了一套分层处理系统:首先通过MLLMs对局部时空图像序列进行变化检测,生成带证据支持的文本描述;再通过文本嵌入与MLLM验证相结合的混合算法,在数百万级变化描述中发现高频语义趋势。实验表明,该方法在纽约和旧金山的2000万街景图像中成功挖掘出户外用餐区扩张、高架桥涂装等城市演变趋势,其精度显著优于传统视觉特征方法和纯嵌入匹配方案。系统通过将复杂问题分解为可并行的子任务,突破了MLLMs上下文窗口限制,实现了首个千万级图像数据库的语义趋势挖掘,为无监督城市视觉分析提供了新范式。研究同时展示了在零售业态变迁、公共设施改造等多场景下的应用潜力,验证了大模型在开放域视觉洞察中的实用价值。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.2614

(12) Radiant Foam: Real-Time Differentiable Ray Tracing

论文简介:

由Simon Fraser University、University of British Columbia、University of Toronto和Google DeepMind等机构提出了Radiant Foam,该工作提出了一种基于泡沫结构的实时可微分光线追踪方法。通过将场景表示为三维Voronoi图的多面体泡沫单元,每个单元存储可微分的密度和辐射场参数,实现了类似3D高斯溅射(3DGS)的渲染速度与质量,同时保留光线追踪对反射、折射等复杂光照效果的天然支持。核心创新在于利用Voronoi图的连续可微特性进行梯度优化,并改进传统体素网格光线追踪算法,无需依赖专用硬件即可实现每秒200帧以上的实时渲染。实验表明,该方法在Mip-NeRF 360和Deep Blending数据集上的PSNR和LPIPS指标接近3DGS,但渲染速度是硬件加速光线追踪方法(3DGRT)的2倍以上,特别在处理非线性相机模型和复杂光照时展现出更强的灵活性。通过自适应密度调整、剪枝策略和量化损失函数,有效解决了泡沫单元拓扑连续性与场景细节表达的平衡问题,为实时神经渲染提供了兼顾效率与效果的新范式。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.2450

(13) TAB: Transformer Attention Bottlenecks enable User Intervention and Debugging in Vision-Language Models

论文简介:

由Auburn University、Google DeepMind、ML Collective和Adobe Research等机构提出了TAB(Transformer Attention Bottleneck),该工作通过在传统多头自注意力架构后插入1头共注意力层作为瓶颈,实现了视觉语言模型(VLM)的可解释性与用户干预能力。TAB通过约束注意力总和在[0,1]区间,使模型在无视觉信息传递时默认生成通用响应,为用户提供了编辑注意力以调试模型决策的接口。实验表明,TAB在图像差异描述任务中保持与基线模型相当的生成性能,同时显著提升了变化定位的准确性(在OpenImages-I数据集上平均定位精度提升46.21%),并首次实现了通过编辑注意力直接干预模型输出的能力——例如将注意力置零可强制模型输出"无变化",而修正注意力则能提升88.92%的物体名称预测正确率。该方法在三个差异描述数据集(CLEVR-Change、OpenImages-I、Spot-the-Diff)中均展现出优势,验证了其作为可解释瓶颈在定位、干预和零样本迁移(在Spot-the-Diff上表现接近SOTA检测器)方面的有效性,为视觉语言模型的可信性与人机协作提供了新范式。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.2024

(14) MoMaps: Semantics-Aware Scene Motion Generation with Motion Maps

论文简介:

由Google DeepMind、宾夕法尼亚大学及Google的研究团队提出了MoMaps,该工作提出了一种名为Motion Map(MoMap)的3D场景运动表示方法,通过真实世界视频数据学习语义与功能相关的运动先验,实现未来3D场景运动的预测。MoMap将动态3D场景表示为像素对齐的轨迹图像,利用扩散模型生成长时序、语义一致的运动轨迹,并通过解耦相机运动与物体运动降低问题复杂度。研究团队构建了包含5万+真实视频的MoMap数据库,验证了该方法在3D运动生成和2D视频合成中的有效性,尤其在运动方向精度和轨迹一致性指标上表现突出。其创新点在于将图像扩散模型迁移至4D运动生成任务,并通过视觉语言模型实现细粒度运动控制,为视频生成提供了嵌入3D动态先验的新范式。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.1575

(15) SciVid: Cross-Domain Evaluation of Video Models in Scientific Applications

论文简介:

由Google DeepMind等机构提出了SciVid,该工作构建了一个跨领域科学视频任务基准,系统评估视频基础模型(ViFM)在医学、动物行为和天气预报等科学应用中的迁移能力。研究团队通过引入包含五个科学视频任务的基准套件,涵盖行为分类、组织追踪、天气预测等场景,对比了VideoPrism、VideoMAE、V-JEPA等六种主流ViFM的性能。实验表明,通过添加简单可训练读出模块,ViFM在多个科学任务中达到甚至超越领域专用模型的SOTA表现,例如在CalMS21行为分类任务中,V-JEPA模型以92.4% mAP刷新纪录,数字台风压力预测任务中4DS-L模型将RMSE降至5.23。研究同时揭示了ViFM的局限性:在组织追踪(STIR)和气象预测(WeatherBench2)任务中,尽管ViFM显著优于随机基线,但仍落后于领域专用模型,如STIR任务中最佳ViFM(4DS-e)的69.2%准确率与领域专用MFT的77.6%存在差距。通过冻结主干网络的高效评估框架,研究验证了通用视频表示在科学任务中的潜力,同时指出模型规模与任务性能的非线性关系,例如4DS模型在行为分类任务中参数量提升40倍带来40%性能增长,但在气象预测中模型规模影响微弱。该工作为视频基础模型在科学领域的应用提供了系统性评估框架,揭示了跨领域迁移的有效性与挑战,为开发更具泛化能力的科学智能模型指明方向。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.1534

(16) Towards Cross-modal Backward-compatible Representation Learning for Vision-Language Models

论文简介:

由 Google DeepMind 等机构提出了跨模态向后兼容表示学习(XBT),该工作首次将视觉-语言预训练(VLP)模型的向后兼容概念扩展到跨模态检索领域。针对模型升级时因嵌入空间不兼容导致的海量数据重计算(backfilling)问题,研究者提出通过文本数据预训练的投影模块φ,将新模型的图像与文本嵌入对齐到旧模型空间。该方法仅需文本数据预训练φ模块,即可生成与旧模型兼容的合成嵌入,避免训练时依赖旧模型参数,同时通过参数高效微调策略(LoRA/软提示)保持新模型原始能力。实验表明,XBT在nocaps、Flickr、COCO等跨模态检索基准上,用仅1%CLIP训练数据量即可实现新旧模型兼容,且在文本查图和图像查文任务中均超越旧模型性能。该方法在保持新模型零样本能力的同时,为视觉-语言模型的环保升级提供了新范式,有效解决了跨模态检索系统升级中的核心兼容性难题。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.1427

(17) Bolt3D: Generating 3D Scenes in Seconds

论文简介:

由 Google、牛津大学和 Google DeepMind 提出的 Bolt3D,该工作通过潜在扩散模型实现快速前馈式 3D 场景生成。Bolt3D 能够在 7 秒内从单张或多张输入图像直接生成可交互渲染的 360° 3D 场景,其核心创新在于将强大的 2D 扩散模型架构扩展到 3D 几何生成领域。研究团队提出了一种基于 3D 高斯的场景表示方法(Splatter Images),通过解耦颜色/位置与透明度/形状的生成流程,结合几何感知的变分自编码器(VAE)和多视角扩散模型,实现了高分辨率场景的高效生成。为解决真实 3D 数据稀缺问题,团队利用 MASt3R 重建框架对 CO3D、MVImgNet 等数据集进行多视角几何对齐,构建了包含 30 万场景的训练集。实验表明,Bolt3D 在单图重建任务中相比 Flash3D 将 PSNR 提升 3.63 dB,在多视图任务中超越 DepthSplat 等回归方法,同时比优化-based 方法(如 CAT3D)减少 300 倍推理时间(单 GPU 6.25 秒 vs 5 分钟)。该方法在质量与速度间取得平衡,为大规模 3D 内容创作提供了新范式。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.933

(18) LayerLock: Non-collapsing Representation Learning with Progressive Freezing

论文简介:

由Google DeepMind、牛津大学等机构提出了LayerLock,该工作提出了一种渐进式冻结网络层的自监督视频表征学习方法,通过动态调整预测目标从像素级特征逐步过渡到深层语义特征,有效解决了传统方法中计算效率低和表示崩溃的问题。研究发现视觉Transformer(ViT)模型中浅层特征收敛速度显著快于深层特征,基于此设计了分阶段冻结策略:初期保持全网络可训练并以像素重建为监督信号,随后按预设时间表逐层冻结浅层参数,同时将预测目标迁移至被冻结层的深层特征激活值。该方法在视频掩码自编码(MAE)框架下验证时,通过冻结3/4网络参数节省了19%计算量和16%显存占用,同时在Something-Something V2动作分类(Top-1准确率提升3.0%)和ScanNet深度估计(相对误差降低0.02)任务中保持竞争力。进一步将该策略扩展至潜在空间预测模型V-JEPA时,通过渐进式冻结教师网络层激活值作为预测目标,在Kinetics700-2020数据集上动作识别准确率提升4.9%,同时深度估计误差降低0.06。实验表明该方法在40亿参数规模下仍保持训练稳定性,提出的3D旋转位置嵌入使基线模型在动作分类任务上提升2.5%。该工作为大规模视频表征学习提供了兼顾效率与性能的通用框架,为后续研究提供了重要的工程实践参考。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.790

(19) AlignDiff: Learning Physically-Grounded Camera Alignment via Diffusion

论文简介:

由卡内基梅隆大学、谷歌和Google DeepMind的研究人员提出了AlignDiff,该工作提出了一种基于扩散模型的相机校准框架,通过联合建模相机内外参数并利用几何特征和真实镜头数据,有效提升了复杂畸变下的校准精度。现有方法常依赖预校正图像或固定畸变模型,难以处理真实场景中的复杂光学畸变。AlignDiff创新性地采用通用光线相机模型,将相机内外参数联合优化,通过线特征嵌入和边缘感知注意力机制,使模型聚焦于几何特征而非语义内容,从而更精准地捕捉局部畸变。研究团队构建了包含3000余个真实镜头样本的数据库,通过光线追踪技术提取畸变特征,显著增强了模型对真实光学畸变的泛化能力。实验表明,该方法在复杂畸变场景下将光线束角度误差降低约8.2度,校准精度在CO3D和Aria Digital Twins等真实数据集上显著优于现有方法。其核心贡献包括:首次将扩散模型用于联合内外参数校准,通过几何特征解耦提升畸变建模能力,以及引入真实镜头数据增强模型鲁棒性,为野外环境下的高精度相机校准提供了新范式。

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.461

(20) Visual Intention Grounding for Egocentric Assistants

论文简介:

由新加坡国立大学和Google DeepMind等机构提出了EgoIntention数据集和Reason-to-Ground(RoG)方法,该工作聚焦于解决第一人称视角下隐含意图的视觉对象定位难题。传统视觉定位方法依赖明确对象查询和第三人称视角,而实际场景中AI助手需通过用户意图(如"需要坐下"而非直接说"椅子")在复杂的第一人称场景中定位目标对象。EgoIntention作为首个针对此任务的数据集,基于Ego4D和PACO-Ego4D构建,包含26,384张图像、52,768条意图描述及89,841个标注框,通过上下文意图(如工作坊场景中的工具使用)和非常规意图(如用背包挡雨)双维度标注,并为每个意图提供替代对象的多框标注。实验表明,当前多模态大模型在该任务上表现显著不足:GPT-4+GroundingDINO组合在上下文意图任务中仅46.6%准确率,而MiniGPT-v2等模型因过度依赖显式对象词产生误判。针对此,RoG通过解耦意图推理与对象定位两个阶段——先用

论文来源:iccv2025

PaperScope.ai 解读:

https://paperscope.ai/hf/iccv2025.63