上周,智猩猩Robot针对获得CoRL 2025杰出论文奖的进行了论文解读,受到了广泛关注。

论文通讯作者、北京通用人工智能研究院具身机器人中心主任黄思远博士在实验现场接受央视新闻的采访中谈到,未来希望把UniFP算法的单个接触点扩展到机器人全身,通过全身和环境的力位交互感知让机器人更好的与人类接触。同时,他进一步表示,在康养和医疗领域等领域的机器人服务中,UniFP算法也能提供帮助。

做个预告,黄思远博士也已确认出席11月19日智猩猩联合智东西、机器人前瞻在深圳举办的2025中国具身智能机器人大会(EAIRCon 2025),并将在上午的主论坛带来主题报告。

1

CoRL 2025杰出论文奖UniFP解读

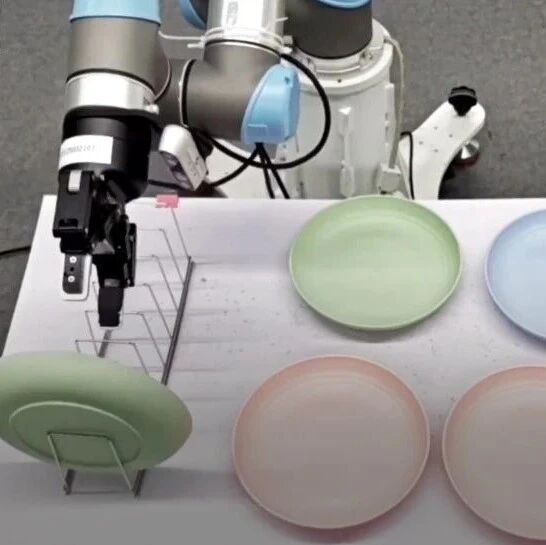

全球首个力位混合控制算法UniFP由北京通用人工智能研究院联合BIGAI&宇树联合实验室、北京邮电大学提出,能够让足式机器人在单一框架下统一处理力与位置,且无需依赖力传感器。

UniFP算法把机器人末端执行器与环境之间的交互视作一个弹簧–阻尼–质量系统,通过控制偏差来同时调节位置与力。UniFP核心问题框架是给定相对于机器人本体坐标系的位置指令和力指令,目标是学习一个强化学习策略,确保机器人在净力的作用下,能够遵循这些指令。

在UniFP中,只考虑末端执行器低速移动的问题,忽略速度和加速度项,把期望的位置、位置指令和力指令、外部的接触力统一写进了一个公式,让策略既能完成轨迹跟随,又能根据接触情况自动调节。同时通过一个力估计器,利用机器人历史状态信息和动作信息估计出受到的合外力。这样一来,机器人不再是“机械地走完路径”,而是能够感知并主动对环境施加力,回应环境。

在仿真环境Isaac Gym中,通过强化学习进行训练。训练过程中,通过不断施加随机外力、随机命令,让算法学会在各种组合情况下的应有表现,并通过tracking reward function进行优化。并加入了各种域随机化操作,能够很好的实现在真实机器人上的迁移。

2

论文作者谈UniFP优势、扩展与应用

在央视新闻的专题报道中,这一杰出论文奖的获得者黄思远博士及其团队的通研院研究员贾宝熊博士、通研院研究员智佩渊都分别接受了采访。

我们现在主要是靠接触点来去做力位混合控制,未来我们希望把单个接触点去扩展到机器人全身,通过全身和环境的力位交互的感知,来更好的和人类亲密接触。比如,在康养领域扶起或者抱起老人,这时候机器人全身都需要对力的接触和对人的交互感知非常到位。在医疗领域,如按摩等,这种涉及到近距离和我们肌肤接触的应用里,我们的算法也能够提供帮助。

先前主流的视觉语言动作模型,往往都是将照片作为输入,然后去做轨迹的预测,但这种轨迹就会使得机器人在擦黑板的过程中,无法严丝合缝的贴合白板,导致出现擦不到的情况。而力传感器其实都是加在固定的机械臂上,安装起来繁琐且昂贵。

力位混合控制模型UniFP中,我们尽可能的把力这一维度补齐,能做到在白板位置精确的基础上,还能在白板上施加压力,所以能较为紧密地贴合白版,擦掉上面的字迹。因此,我们不仅在原有的视觉语言动作模型上补齐了力这一维度,也达到了同时能做力和位置的混合控制的效果,相比纯位置控制方法,成功率高出了约39.5%。

力位混合控制算法不仅能大幅提高足式机器人的任务成功率,还在人机协作的安全性上取得了重要突破,通研院研究员智佩渊进行了举例说明。

机器人在移动的时候,我是可以伸手把它挡住的。我去推它,它也可以顺应我的力去停在某一个位置;当我手撤开,它可以接着去执行之前的轨迹。这样,机器人是有一定柔顺性的,和人一起去做任务时,有一定安全性。比如,人碰到它,它不会用很大的力去伤害人、破坏物体,在工业场景下可以赋予工作人员一定的安全性。

除了提升安全性,UniFP算法还能显著增强了人机协作的协调性。在共同搬箱子推车等场景中,机器人能与人类保持动作同步,人类加速时它随之加速,人类停下时它迅速停下,过程中可根据人的不同运动状态进行及时调整。同时,该算法还具备良好的泛化能力,在不同的机器人本体上都能稳定应用。

3

论文作者介绍

论文有两位通讯作者,分别是黄思远博士与贾宝雄博士;论文一作是通研院研究员智佩渊,共同一作是通研院-北京邮电大学“通计划”24级联培博士生李佩洋。

北京通用人工智能研究院研究科学家、具身机器人中心主任黄思远。他在加州大学洛杉矶分校(UCLA)统计系获得博士学位。他的研究旨在构建一个能够理解和与三维环境交互的类人通用机器人。为实现这一目标,他在以下方向做出了贡献:(1)开发可泛化的视觉表征以用于三维重建和语义落地,(2)建模并模仿人类与三维世界的复杂交互,(3)构建擅长与三维世界和人类交互的具身机器人。他的研究发表于六十余篇CVPR/ICCV/NeurIPS/ICML等会议及期刊论文,并曾获得CoRL以及ICML Workshop最佳论文。

个人主页:https://pku.ai/author/siyuan-huang/。

北京通用人工智能研究院具身机器人中心研究员贾宝雄。本科毕业于北京大学,博士毕业于美国加州大学洛杉矶分校(UCLA),师从朱松纯教授。主要研究方向为场景理解、行为理解与具身智能等。已在CVPR、ICCV、ECCV、NeurIPS、ICLR、ICML、IROS等国际顶级会议发表论文三十余篇。曾获CoRL 2025最佳论文奖,并被评为CVPR及ICLR优秀审稿人。长期担任国际顶级会议与期刊的审稿人,并多次组织国际学术研讨会。

个人主页:https://buzz-beater.github.io/。

北京通用人工智能研究院通用人工智能国家重点实验室研究员智佩渊。2023年硕士毕业于清华大学电子工程系,研究方向为三维视觉、场景理解、机器人等。

个人主页:https://openreview.net/profile?id=~Peiyuan_Zhi1。

通研院-北京邮电大学“通计划”24级联培博士生李佩洋。本科于北京邮电大学,现为通研院-北京邮电大学“通计划”24级联培博士生,师从北京邮电大学尹建芹教授。

个人主页:https://openreview.net/profile?id=~Peiyang_Li4。

END

2025中国具身智能机器人大会预告

点击下方名片 即刻关注我们