在机器人操作领域,如何让AI既能理解语言指令,又能精准感知3D空间,一直是个难题。

近日,清华大学&星海图研究团队提出的DepthVLA,通过融合深度预测专家模块,让视觉-语言-动作模型具备了更强的空间推理能力。

VLA模型的"空间盲区"

视觉-语言-动作(Vision-Language-Action, VLA)模型继承了大规模预训练视觉-语言模型(VLM)的强大能力,能够理解自然语言指令并执行相应的操作任务。

然而,这类模型在空间感知方面存在根本性缺陷——

抓取小物体时经常失败、执行精确操作时定位不准、避障能力较弱。

这些问题的根源在于,VLM主要通过2D图像学习语义信息,缺乏对3D空间关系的显式建模。

▲图1|作者团队提出了 DepthVLA,这是一个视觉-语言-动作(VLA)模型,通过预训练的深度专家显式地整合了空间推理能力。在 Simpler、LIBERO 和真实世界基准测试上的定量比较表明,DepthVLA 持续优于基线模型,特别是在需要精细 3D 感知的任务中表现突出。©️【深蓝具身智能】编译

DepthVLA的核心思路是显式整合空间感知能力——不是通过更多的2D训练数据,而是引入专门的深度预测模块。

技术架构

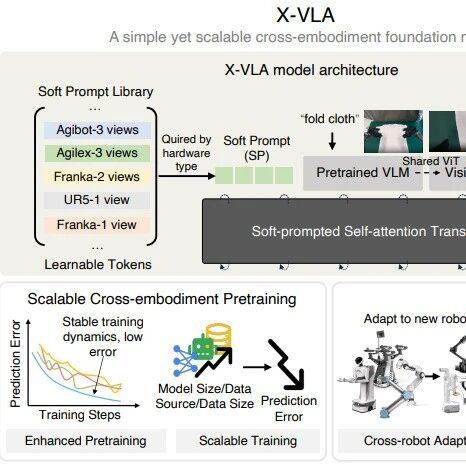

混合Transformer架构

DepthVLA采用混合Transformer(Mixture-of-Transformers, MoT)架构,将三个专家模块有机整合:

视觉-语言模型(VLM)负责语义理解和开放词汇视觉感知,继承了大规模网络数据的泛化能力;

深度预测专家(Depth Expert)专门负责几何推理和空间感知,在多样化3D数据集上预训练,提供细粒度的几何线索;

动作专家(Action Expert)基于前两个模块的特征生成连续动作,采用flow-matching方法进行动作预测。

▲图2|混合变换器(MoT)框架整合了三个专家:用于语义和语言理解的视觉-语言模型(VLM)、用于几何推理的深度专家,以及用于连续控制的动作专家。注意力层在各专家之间共享,同时块级掩码确保预训练模块保留其学习到的能力。动作专家在每一层都关注来自 VLM 和深度专家的特征,以生成基于语言、视觉和空间线索的动作。©️【深蓝具身智能】编译

关键设计:注意力共享与模块独立

DepthVLA的架构设计体现了两个看似矛盾但实则互补的原则——

特征融合、模块独立性。

三个专家共享相同的注意力层,实现特征级别的信息交换。

通过块级掩码机制,VLM和深度专家的token只能关注自身模块内的信息,而动作token可以关注所有信息流。

这种设计的精妙之处在于:既保护了预训练模型的原有知识不被破坏,又允许动作专家综合利用语义和空间信息做出决策。

深度专家的设计

深度专家采用编码器-解码器架构。

编码器基于DINOv2,初始化自Depth Anything V2的预训练权重,能够捕获细粒度几何特征;

解码器镜像VLM的Transformer结构,通过线性头输出深度预测。

深度专家的预训练是成功的关键。

研究团队在包括WildRGB-D、Scannet/Scannet++和HyperSim在内的大规模3D数据集上进行训练,使用尺度不变对数损失确保学习到鲁棒的空间推理能力。

这种分专家预训练策略允许在更多样化的数据集上训练,而不受限于有限的机器人操作数据。

实验验证

模拟环境测试

在Simpler基准测试中,DepthVLA达到74.8%的平均成功率,相比基线方法(π0)的58.8%提升了16个百分点。

在需要精确空间推理的任务(如积木堆叠)上,性能提升尤为明显。

▲表1|在 Simpler WidowX 基准测试上的成功率。模型在 BridgeData V2 上训练并在模拟环境中进行零样本评估。"预训练"列表示该模型是否使用额外的机器人动作数据进行了预训练。DepthVLA 达到了最高的平均性能。©️【深蓝具身智能】编译

在LIBERO基准测试中,DepthVLA在所有四个任务套件中均取得最佳性能,平均成功率达到94.9%,超越基线方法的93.6%。虽然提升幅度较小,但在高基准线上的持续改进证明了方法的有效性。

▲表2|在 LIBERO 基准测试四个任务套件上的成功率。"预训练"列表示该模型是否使用额外的机器人动作数据进行了预训练。DepthVLA 优于所有基线模型,表明显式深度推理提高了在不同操作任务中的泛化能力。©️【深蓝具身智能】编译

真实世界测试

在Galaxea R1 Lite双臂移动平台上,标准微调设置下,DepthVLA进度分数达到79%,而基线方法仅为65%。

在少样本设置(仅20个演示)下,性能差距进一步扩大:DepthVLA达到63%,基线方法仅45%。

▲图3|DepthVLA 和基线模型在三个双臂任务上使用标准微调和少样本适应的性能表现。DepthVLA 在需要精确空间推理和避碰的任务中显示出改进,同时在较简单的小物体操作任务上保持了相当的性能。©️【深蓝具身智能】编译

测试任务涵盖了机器人操作的关键能力:桌面整理测试小物体抓取和精确位置估计;微波炉操作测试每个步骤的避障能力;积木堆叠测试精确的拾放技能。

深度感知的直观展示

从深度图可视化结果可以看出,DepthVLA准确捕获了物体边界和距离信息,在杂乱环境中精确估计物体相对位置,为精确操作提供了细粒度几何线索。

▲图5|DepthVLA 在真实世界和模拟环境中预测深度图的定性结果。预测的深度提供了精细的几何线索,引导准确的操作、避碰和精确的物体抓取。即使在杂乱或具有挑战性的场景中,DepthVLA 也能稳健地捕获 3D 布局,突出了预训练深度专家在提供空间感知方面的有效性。©️【深蓝具身智能】编译

消融实验

通过系统的消融实验,研究团队验证了各个设计选择的必要性:

深度专家预训练是性能的基石。随机初始化的深度专家使性能大幅下降至51.0%,说明预训练的空间知识至关重要;

深度损失在VLA训练中不可或缺。移除后性能降至56.9%,表明持续的深度预测有助于维持空间推理能力;

块级掩码机制保护了模块独立性。允许深度和VLM token相互关注会导致性能下降至55.6%,验证了保持预训练特征完整性的重要性。

预测深度优于直接输入真实深度。这可能是由于模态竞争现象:当多个模态同时提供时,一个模态可能主导其他模态,反而降低了整体性能。

总结

DepthVLA通过混合Transformer架构,成功地将显式空间推理能力整合到VLA模型中。

这种设计的核心贡献在于解决了语义理解和空间感知之间的权衡问题——通过模块化设计和巧妙的注意力机制,既保持了预训练模型的语言理解能力,又显著提升了精确操作任务的表现。

部署灵活性是另一个优势,深度专家可以冻结使用,无需真实深度标注,支持在仅有RGB相机的平台上部署。在真实数据上训练的模型能够零样本迁移到模拟环境,展现了良好的泛化能力。

尽管取得了显著进展,单目深度预测仍然面临挑战。未来的研究可以探索多视角深度预测、点云预测,以及处理反光/透明物体等困难场景的方法。DepthVLA为提升机器人的空间感知能力提供了一个优雅而有效的解决方案,将推动整个领域向着更精确、更智能的方向发展。

编辑|Jeffrey J

审编|具身君

Ref:

论文标题:DepthVLA: Enhancing Vision-Language-Action Models with Depth-Aware Spatial Reasoning

论文作者:Tianyuan Yuan, Yicheng Liu, Chenhao Lu, Zhuoguang Chen, Tao Jiang, Hang Zhao

论文链接:https://arxiv.org/pdf/2510.13375

>>>现在成为星友,特享99元/年<<<

【具身宝典】||||

【技术深度】|||||||

【先锋观点】|||

【非开源代码复现】||

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

投稿|商务合作|转载:SL13126828869(微信)

点击❤收藏并推荐本文