一、什么是"端侧"大模型?

在聊具体内容之前,先解释一下这个名字的由来。在计算机和通信领域,我们通常把整个系统分为几个层次:

-

云端(Cloud):远程的数据中心和服务器 -

边缘(Edge):靠近用户的边缘服务器和基站 -

端侧(Device):用户直接使用的终端设备

所以"端侧大模型"这个名字,直接点出了它的核心特征:运行在终端设备上的大语言模型。在英文里,通常叫做"On-Device LLM"。

跟云端AI有什么不同?

我们现在用的ChatGPT、文心一言这些AI,工作方式是这样的:

-

你的手机 → 把问题发到服务器 → 云端大模型计算 → 把答案传回来

就像去餐厅吃饭,你(手机)告诉服务员(网络)想吃什么,后厨(云端服务器)做好菜,服务员再把菜端上来。

而端侧大模型是:

-

你的手机 → 本地模型直接计算 → 立即得到答案

相当于在家里做饭,想吃就吃,不用等外卖。

一个真实例子

Google的Gboard输入法就是个典型案例。你在微信聊天时:

-

朋友问:"明天一起吃饭?" -

Gboard自动弹出回复建议:"好啊!几点?"、"不好意思,明天有事" -

响应时间不到100毫秒 -

完全不需要联网

这背后就是端侧AI在工作——一个18亿参数的模型完全跑在你手机里。

二、为什么要把AI塞进手机?

你可能会问:云端AI用得好好的,为什么要费劲把它塞进手机?原因很现实。

1. 云端AI的第一个痛点:慢

你肯定遇到过这种情况:

打开ChatGPT问个问题,盯着那个转圈的加载图标,1秒、2秒、3秒......等答案出来的时候,思路早就断了。

我测试过,云端GPT-4每生成一个词平均要200毫秒。写一句20个词的话就是4秒。想象一下,你跟朋友聊天,每说一句话对方愣4秒再回你,这对话还能聊下去吗?

端侧AI的响应速度是50-100毫秒,基本达到了人类的反应速度。这不是量变,是质变——就像从拨号上网跳到光纤,体验完全不一样。

2. 第二个痛点:隐私风险

去年有个真实案例:某科技公司的工程师为了调试代码,把内部代码片段喂给了ChatGPT。结果几周后,类似的代码逻辑出现在了其他用户的对话里。这位工程师丢了工作,公司损失惨重。

每次你用云端AI处理敏感信息——写私密邮件、处理财务数据、分析商业文档——这些内容都要经过远程服务器。虽然大公司都承诺保护隐私,但数据一旦离开你的设备,就不在你的控制范围内了。

医疗行业对此尤其敏感。医生不可能把病人病历上传到云端让AI分析,这不仅违反隐私法规,也是对患者的不负责。

端侧AI的数据完全在本地处理,就像在家里的保险柜数钱,外人根本不知道。

3. 第三个痛点:必须联网

飞机上、地铁里、山区徒步、工厂车间、医院手术室......这些场景要么没网络,要么禁止联网设备。而这些场景恰恰是AI最该发挥作用的地方。

我一个做工业自动化的朋友吐槽,他们工厂生产线需要实时AI决策,但车间是内网环境,根本连不上外网。云端AI在那儿就是摆设。

市场也在用脚投票。边缘AI市场规模从2022年的152亿美元,预计到2032年会涨到1436亿美元,年增长率超过25%——比云计算的增速还要快。

三、技术难题:怎么把大象装进冰箱?

道理都懂,但实现起来难度大得离谱。我给你看几个数字:

-

云端GPT-4:1.76万亿参数,需要几百GB内存,数千块GPU -

iPhone 15 Pro:8GB内存,一块手机芯片 -

差距:100倍以上

这相当于要把一头成年大象塞进家用冰箱,还得让它活蹦乱跳。

更要命的是功耗。研究显示,一个70亿参数的模型每生成一个词消耗0.7焦耳能量。iPhone 15的电池总共才50千焦。连续对话两小时,电池就快耗光了——这还没算屏幕、网络等其他耗电。

这就是工程师面临的"不可能三角":

-

性能好(回答质量高) -

体积小(能装进手机) -

功耗低(不会瞬间耗光电池)

三个只能选两个。

四、破局之道:四个核心技术突破

过去两年,学术界和工业界想出了一些巧妙办法,逐渐把这个"不可能三角"破解了。

突破1:模型压缩——瘦身但不失能

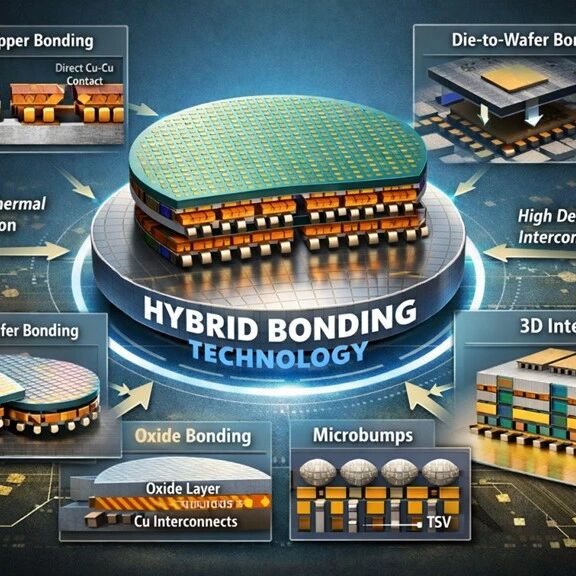

量化技术最容易理解。原始模型每个参数用32位浮点数表示,就像10MB的高清照片。量化后每个参数只用8位整数,变成1MB的标清版本,但肉眼看起来几乎一样。

更绝的是AWQ技术——它发现模型里只有0.1%-1%的参数真正重要,就像电影里只有关键剧情需要高清,其他过场镜头用标清就行。用这个方法能把模型体积砍掉75%,性能只降不到5%。

剪枝技术是把不干活的神经元砍掉。想象一个1000人的公司,有人天天摸鱼,工作量很少。裁掉50%冗余员工,效率反而提高了。LLM-Pruner就是这么干的,模型体积减半,关键任务性能只降10%。

知识蒸馏最有意思。你考研时肯定干过这事——看十本砖头厚的教材,最后浓缩成三页A4纸的知识点,考试照样拿高分。

MiniCPM就是典型案例。它只有28亿参数,通过模仿700亿参数的大模型,在11项测试里平均得分65.1,甚至超过了某些版本的GPT-4。就像本科生通过拼命学习,考试成绩超过博士生。

突破2:架构创新——不走寻常路

传统观念认为模型要"宽"才好——每层神经元越多越强。但MIT团队开发的MobileLLM反其道而行:层数多(深)但每层神经元少(窄)。

就像盖楼,传统是5层楼每层100间房,MobileLLM是20层楼每层20间房。总面积一样,但更深的楼能捕捉更复杂的模式。实测同样参数量下,准确率能提升2.7%-4.3%。

MoE(混合专家)架构也很巧妙。想象一个医院,你腿疼不会找心理医生,牙疼不会找骨科。MoE模型也是这个道理——它有8个"专家"模型,每次只激活1-2个处理任务。

JetMoE总共80亿参数,每次推理只用20亿,计算量比同类模型少70%,性能反而更好。就像8车道高速公路,你只占1车道,剩下7车道的资源都省下了。

突破3:硬件加速——配台专用跑车

手机厂商也在硬件上发力。现在高端手机都配了专门的AI芯片——NPU(神经处理单元)。

-

苹果Neural Engine:一秒35万亿次运算,专门优化8位量化模型 -

高通骁龙8 Gen3:支持4位量化,功耗比GPU低60%

更激进的是PIM(存内计算)。传统计算的瓶颈是数据要在内存和处理器间来回搬运,就像你在客厅干活但工具在储藏室,得不停地跑。PIM直接把计算单元塞进内存,工具就在手边。

三星HBM-PIM实测性能提升4.5倍,能耗降低71%。

突破4:边云协同——最聪明的方案

说实话,手机再怎么优化也干不过云端超级计算机。所以最聪明的办法是:简单任务留本地,复杂任务交云端。

你做饭也是这么干的——炒青菜自己在家做,想吃北京烤鸭就去餐厅点。

EdgeShard框架把一个700亿参数的大模型切成10片:

-

前3片 → 手机本地 -

中4片 → 小区机房的边缘服务器 -

后3片 → 云端数据中心

实测效果惊人:延迟降低50%,吞吐量翻倍,手机只需存30%的模型。

有个调研数据很有意思——88%用户选择边云协同方案,只有18%愿意纯云端。原因简单:云端延迟高、隐私风险大、还要付费。

五、你的手机里已经有了这些AI

说了这么多技术,你可能觉得离我们还很远。其实早就在身边了。

Google Gboard:打字助手

你在微信群聊,朋友问"明天一起吃饭?",Gboard自动弹出三个回复建议,响应不到100毫秒,完全离线。这背后是18亿参数的Gemini Nano模型。

苹果Live Text:拍照翻译

在国外看到路牌不认识,拿手机拍一下就能实时翻译,全程不联网。这是11亿参数的OpenELM模型在A17芯片里跑的结果。

微软Phi-3:移动办公助手

38亿参数的模型,训练了3.3万亿个词,测试接近GPT-3.5水平。关键是能完全离线跑在手机上,写邮件、做总结毫无压力。

国产手机AI

-

小米MiLM:60亿参数,能识别菜市场蔬菜,告诉你怎么做好吃、营养价值多少 -

OPPO小布、vivo Jovi、华为小艺:各家都有类似产品

医疗领域应用

HuatuoGPT是个70亿参数的医疗专用模型,能在医院服务器本地运行,给出初步诊断建议、分析病历、推荐用药。患者隐私100%保护,偏远地区也能用。

六、未来会怎样?

技术发展到这一步,我们能看到一些清晰的趋势。

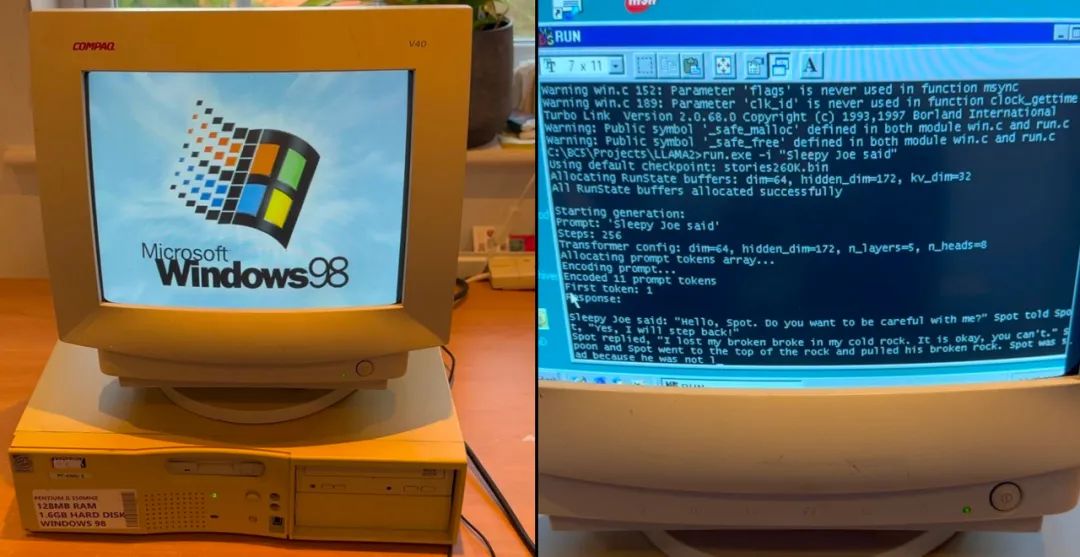

模型越来越小,但越来越聪明

现在7GB的模型能跑在手机上已经很不错了。但三年后,5亿参数的模型可能就能达到现在70亿参数的水平。

BitNet技术把每个参数压缩到只需1.58位(只用-1、0、1三个值),相比现在的8位再压缩5倍。

多模态成为标配

未来手机AI不只会聊天,还能看图、听声音、控制设备。你对手机说"帮我找昨天拍的那张黄色猫咪的照片",它能理解时间、内容、特征,瞬间找到。

MiniCPM-V 2.5这种85亿参数的多模态模型已经能在手机上跑了。

AI学习你的习惯

现在的AI对所有人都一样。未来你的AI助手会知道你喜欢什么风格的邮件、常用什么词汇、怎么思考问题。这种个性化学习完全在本地进行,数据不上传,隐私完全保护。

芯片专门为AI设计

现在手机芯片AI只是附加功能,未来会有专门的AI核心。苹果A18的Neural Engine已经占芯片30%面积,高通骁龙X Elite有专门AI协处理器。

预计2027年,手机能轻松跑500亿参数的模型。

边云协同成为标配

90%日常任务本地处理,10%复杂任务云端处理,用户无感知切换。系统会自动判断:任务简单就本地,任务复杂就云端,网络不好就强制本地,电量不足就推迟或简化。

七、这会改变什么?

端侧AI带来的最大改变不是技术本身,而是它会重新定义人和AI的关系。

云端AI像个公共图书馆——资源丰富,但你得去那儿才能用,而且所有人看的都是同一批书。

端侧AI像你的私人藏书室——虽然书少点,但随时能用,而且都是你爱看的类型,还会根据你的阅读习惯推荐新书。

想象2030年的场景:一个10岁的孩子,他的AI助手从3岁开始陪伴他长大。这个AI知道他所有的学习记录、兴趣爱好、说话方式,能预测他的需求。而且这个AI完全离线运行,数据绝不上传,能力越来越强,就像真正的朋友。

这不是科幻。从技术发展轨迹看,这种"AI原住民"在10年内就会出现。

从投资角度看,这也是个千亿级市场。芯片设计、算法优化、应用开发,整个产业链都在爆发。垂直领域小模型(医疗诊断、法律咨询、教育辅导)、端侧AI工具链(模型压缩、性能测试、部署优化)、隐私计算方案,都是高价值赛道。

写在最后

人类历史上的重大技术变革往往遵循同一个规律:从集中式走向分布式。

-

电力时代:1880年爱迪生建集中式发电厂 → 1920年家家户户通电 -

互联网时代:1990年大型机房 → 2010年人手一部智能手机 -

AI时代:2020年依赖云端大模型 → 2025年端侧AI开始普及

这个变化会像电力和互联网一样,彻底改变人机交互的方式。

你的手机正在变成一个不需要网络的超级大脑。这不是未来,这是2025年的现实。

未来已来,只是分布还不均匀。