点击下方卡片,关注“具身智能之心”公众号

作者丨Wenxuan Song等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

标题:ReconVLA: Reconstructive Vision-Language-Action Model as Effective Robot Perceiver

作者:Wenxuan Song, Ziyang Zhou, Han Zhao, Jiayi Chen, Pengxiang Ding, Haodong Yan, Yuxin Huang, Feilong Tang, Donglin Wang, Haoang Li

机构:The Hong Kong University of Science and Technology (Guangzhou), Westlake University, Zhejiang University, Monash University

原文链接:https://arxiv.org/abs/2508.10333

代码链接:https://github.com/Chowzy069/Reconvla

导读:

视觉-语言模型发展极为迅速,视觉-语言-动作(VLA)模型更是乘势而起,正在引领机器人技术走向一个更通用、更智能的新时代。然而,在这些强大模型的背后,一个根本性的问题正逐渐浮出水面:机器人真的“看准”了吗?

当我们给机器人一个待执行的指令,例如指令“把蓝色积木放到粉色积木上”,模型必须把视觉焦点锁定在“蓝色积木”本身。然而大量实证结果显示,现有 VLA 往往难以做到:它们的注意力像一层“雾气”平均铺在整张图上,而非像一束“聚光灯”精准打在目标物体。尤其在背景凌乱、干扰物多的场景里,这种注意力发散很容易让机器人抓错物体,从而导致任务失败。

因此我们提出了一种全新的重建式视觉-语言-动作模型 ReconVLA。ReconVLA 不再满足于只让模型“动手做题”,而是先要它“现场速写”——把正在注视的目标区域描摹出来。 这道额外的“速写考核”变成了隐形的视觉监督,逼着 VLA 把注意力像聚光灯一样打在关键物体上,于是操控动作变得更精准,也更抗干扰。ReconVLA以当前图像、自然语言指令及机器人本体状态为输入。在训练阶段,我们首先借助冻结的视觉tokenizer,将输入图像中的凝视区域编码为高保真潜在 token,完整保留细粒度视觉信息;随后使用扩散变换器(diffusion transformer)在重建token 的引导下进行去噪复原,从而高效建模视觉观测的条件分布,并显式提升对目标区域的关注与理解。大规模仿真实验表明,这种隐式视觉定位范式在长时序任务中显著优于现有 grounding 方法;注意力可视化进一步验证了 ReconVLA 能够主动聚焦关键区域并输出高精度动作。

效果展示:

如下图所示,ReconVLA 的可视化结果显示了原始观测图像、动态调整的目标区域以及随时间变化的注意力热图。即便场景中存在多种干扰物体,模型依旧能够自适应地锁定任务相关的蓝色与粉色积木,对关键区域分配集中的视觉注意力,并依托精准的隐式视觉定位,先抬起蓝色积木再精准放置于粉色积木之上,最终顺利完成整个操作序列。

引言:

现有的 VLA 模型虽借助海量参数与机器人数据实现了跨模态理解,但在复杂场景与长时序任务中,视觉注意力往往分散,难以稳健地聚焦目标物体,导致抓取或操作错误。过去通过显式输入裁剪图像或预测边框的方式来改进视觉定位,却并未从根本上提升注意力分配,对性能增益有限。如何在不增加显式推理负担的前提下,引导模型将视觉注意力精准锁定于目标区域,成为突破瓶颈的关键。

受到人眼凝视机制启发,我们提出ReconVLA,一种重建式的隐式视觉定位范式。核心思想是在动作预测前,利用模型自身的图像token作为条件,对当前帧的“凝视区域”进行高保真重建。该重建过程由轻量级扩散变换器完成,并通过冻结的视觉tokenizer保留细粒度信息,促使主模型在生成动作表征时自发地携带目标区域特征,从而在注意力层面对正确物体聚焦,实现精准操控。

为了提升模型的视觉重建与泛化能力,我们构建了包含10万条轨迹、200 万样本的大规模机器人数据集,并设计自动化流程以 GroundingDINO生成整图-局部图对。这一无需动作标签的预训练策略不仅显著增强了 ReconVLA 的视觉生成能力,也为后续大规模扩展到互联网视频奠定了基础,验证了数据规模化对隐式视觉定位性能的正向作用。

在 CALVIN 等仿真环境的任务中,ReconVLA的隐式视觉定位明显优于显式或 CoT方案,首任务成功率接近 95%。可视化结果进一步证实,模型能动态调整凝视区域,准确关注并依次操控多目标物体。消融实验表明大规模预训练对性能与泛化均至关重要;真实机器人测试亦展示了对未见物体的强大迁移性。综上,ReconVLA为VLA模型在现实世界的落地提供了更精确、更高效的视觉感知与操控范式。

主要贡献:

我们的贡献可以总结如下:

我们提出 ReconVLA:首个基于目标区域重建的隐式视觉定位范式,通过扩散去噪重建过程,引导 VLA 模型自发聚焦目标区域,实现精确动作预测。 我们通过大规模机器人数据集进行预训练,大幅强化模型在视觉泛化、隐式 Grounding 以及高保真图像重建方面的能力。 在 CALVIN abc-d 长程任务中仅凭朴素模型结构取得近 95 % 首任务成功率,并在真实机器人实验中成功泛化至未见物体,验证了方法的实用性与可迁移性。

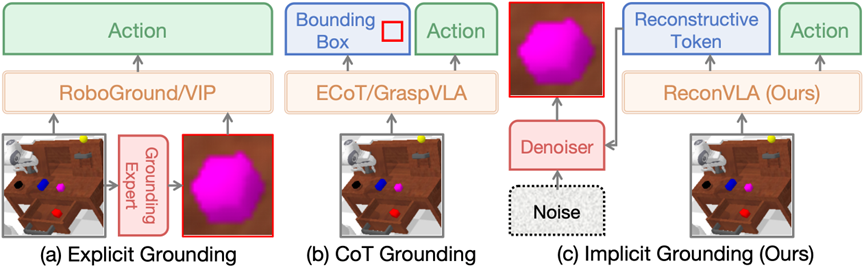

范式对比(三大主流)

(a) 显式定位 (Explicit Grounding):这是最直观的方法。额外引入一个“定位专家”模型(如Grounding DINO,YOLO等),先从图像中把目标物体精确定位出来并“抠出”,然后将原始图像和“抠图”一起送给VLA。这种方法虽然有效,但严重依赖外部专家模型的精确度,且没有从根本上提升VLA自身的定位能力。

(b) 思维链定位 (CoT Grounding) :让VLA模型像写“思维链(Chain-of-Thought)”一样,在输出动作之前,先输出目标物体的边界框(Bounding Box)坐标。即执行一个动作之前,先大概知道目标物体在哪个位置。这种方法能端到端地训练定位能力,但让模型直接回归精确的坐标值非常困难,常常导致性能不佳。

(c) 隐式定位 (Implicit Grounding) :这是ReconVLA采用的创新范式。它不要求模型输出任何额外的坐标或图像,而是设计了一个辅助的局部重建任务。模型在输出动作的同时,其内部的视觉特征必须能够“还原”出目标物体的图像。这种专注于重建“凝视区域”的隐式监督,巧妙地迫使模型将注意力聚焦到正确的区域。

方法详解:

我们的整体框架由视觉重建分支与动作预测分支两部分协同组成。(1)输入阶段:机器人从多个相机视角获取当前帧图像,并接收一条自然语言指令;两者被编码后汇聚成统一的多模态表征。(2)动作预测分支:在此表征基础上,模型自回归地产生离散动作token(如抓取、移动、旋转等),直接驱动机械臂执行。(3)视觉重建分支:首先利用冻结的视觉tokenizer,将指令关注的“凝视区域”编码为潜在场景 token;随后,主干网络额外输出同维度的重建token,将其作为扩散去噪过程的条件,引导噪声表示zt逐步复原为清晰场景表示z0。这一重建任务在像素级别为模型提供了隐式监督,强迫主干网络对目标区域进行更细粒度的对齐与语义理解,从而在动作预测阶段显著提升视觉注意力的集中度与操控精度。(4)预训练:为赋予模型通用且精确的视觉重建能力,我们以 BridgeData V2、LIBERO 和 CALVIN 等大规模机器人数据集为基础构建预训练数据,利用经微调的 Grounding DINO 自动分割出指令关注的目标区域,累计得到包含 10 万余条交互轨迹、约 200 万张图像的高质量数据集。在训练阶段,模型同时优化重建损失与动作预测损失:前者推动视觉分支在潜在空间内复原局部场景,后者保持动作 token 的生成能力。联合梯度回传使主干网络在学习视觉重建的同时巩固对指令-动作映射的理解,显著增强视觉表示的可迁移性与鲁棒性。

ReconVLA的重点在于视觉重建相关的损失函数,它将动作模型的视觉输出与真实的物体图像紧密相连。为了最小化这个局部重建图像的损失,LLM必须学会从原始输入图像中提取出关于目标物体的、最精细、最准确的视觉信息,并将其编码到动作模型的视觉输出中。如此一来,模型的视觉注意力就可以如同人眼一样精准锁定“目标区域”了。

预训练:

为了让ReconVLA具备强大的泛化能力,我们构建了一个包含超过10万条轨迹、200万个样本的大规模预训练数据集。

数据集来源:聚合了BridgeData V2、LIBERO、CALVIN等多个开源机器人数据集。

自动化标注:利用微调过后的Grounding DINO模型,自动地从原始图像中分割出与文本指令对应的“Gaze Region”图像,形成用于重构任务的监督信号。

通过在这个大规模数据集上的预训练,ReconVLA的VLM主干学会了通用的视觉重构能力,为其在下游任务上的优异表现奠定了坚实基础,并且经过消融实验的验证,经过大规模预训练以后的ReconVLA在CALVIN上具有更高的成功率。

实验结果:

ABC→D任务(表3):在需要泛化到新背景的任务上,ReconVLA的性能全面领先,其平均任务完成长度(Avg. Len)达到了3.95,远超其他方法。

ABCD→D任务(表4):在更具挑战性的域内长时程任务中,ReconVLA的性能同样是SOTA,平均完成了4.23个子任务,并最终以70.5%的成功率完成了全部5个子任务,展现了其卓越的规划和执行能力。

我们采用六自由度 AgileX PiPer 机械臂,配备一自由度并联夹爪,视觉系统由两台深度相机构成:底座视角的 RealSense D515(Eye-on-Base)与末端执行器视角的 ORBBEC Dabai(Eye-on-Hand)。基于该硬件平台,我们选取了四项具有代表性且贴近实际应用的操作任务:① 叠放碗具,② 将水果放入碗中,③ 翻转杯子,④ 清理餐桌。由结果可知,ReconVLA 在所有任务上全面超越 OpenVLA 与 PD-VLA:在“放水果进碗”和“叠碗”两个任务中,成功率高达90%;

对于更精细的“翻杯”与“收拾餐桌”任务,同样取得显著领先。

当目标物体换成从未见过的新物品时,OpenVLA 和 PD-VLA 的成功率几乎降至0%,而 ReconVLA 仍能保持40%以上的成功率。这一强悍的视觉泛化能力,得益于 ReconVLA 的大规模数据上进行的预训练。

总结:

本研究首先系统性地剖析了现有 VLA 在视觉聚焦上的顽症——注意力受冗余信息干扰,难以支撑毫厘不差的操控。为破解这一难题,我们提出重建式视觉-语言-动作框架 ReconVLA:在“隐式定位”范式下,引入对目标凝视区域的重建任务,让模型在生成动作的同时,被迫学会把视觉注意力像聚光灯般投向关键物体,从而显著提升操控精准度与鲁棒性。为赋予 ReconVLA 更强的泛化气质,我们编制了涵盖多样场景与未见物体的超大规模预训练数据集,使其在视觉重建与目标归纳上兼具广度与深度。大量仿真与真实机器人实验表明,ReconVLA 在各类复杂、长时程任务中稳定刷榜,全面超越显式定位与思维链定位等主流方案。简言之,ReconVLA 以一种优雅而高效的隐式监督方式,重新校准了 VLA 的“目光”,让机器人真正做到了“看得准,动得稳”,为未来多模态操控研究开辟了一条更清晰、更可靠的道路。