这份名为《GUIDE: Graphical User Interface Data for Execution》的论文,介绍了一个专为多模态大语言模型(MLLM)在机器人流程自动化(RPA)领域应用而设计的全新数据集——GUIDE。该数据集通过涵盖多个网站(如Apollo、Gmail、Calendar、Canva等)的真实交互数据,旨在提升AI系统在图形用户界面(GUI)上的理解与操作能力,从而推动RPA从传统脚本驱动向智能认知驱动转型。

一、研究背景与动机

传统RPA系统依赖预设脚本,缺乏对动态界面的适应能力。随着AI的发展,尤其是多模态大模型的兴起,赋予RPA系统以“理解”和“决策”的能力成为可能。然而,现有数据集多聚焦于图像识别或任务预测,缺乏对GUI中“动作定位”(即动作应在界面哪个位置执行)的细粒度支持。GUIDE的出现,正是为了填补这一空白。

二、数据集构成

GUIDE数据集的每条记录包括:

界面截图(图像)

任务描述

上一个执行的动作

思维链(CoT)

下一步动作及其在界面上的空间定位(grounding)

这些数据通过SuperAGI团队自研的标注工具NEXTAG采集,支持跨操作系统、浏览器和显示类型的多样化环境,并由多位标注员参与,确保涵盖不同用户习惯与界面设计风格。

三、数据收集流程(四阶段)

预收集阶段:

从真实用户、企业需求中收集任务;

过滤掉不可行、不合法或模糊的任务;

按复杂度将任务分为三级:简单(Level 1)、中等(Level 2)、复杂(Level 3)。

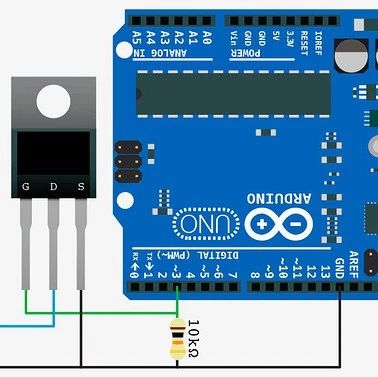

NEXTAG工具标注:

自动追踪用户在浏览器中的操作(点击、滚动、输入等);

精准记录操作发生的空间坐标;

提供直观界面,提升标注效率。

质量检查:

由专业QC团队逐条审核数据,确保图像清晰、动作准确、定位无误;

建立反馈机制,持续优化工具与流程。

后处理与增强:

为每条任务添加思维链(CoT),模拟人类推理过程;

引入动作历史,帮助模型理解任务上下文;

通过图像增强技术(如边框、裁剪、移动元素、模拟不同主题/浏览器/OS)提升模型泛化能力;

引入不同设计风格的界面,增强模型对界面变化的鲁棒性。

四、任务复杂度分级

GUIDE将任务按以下维度进行复杂度分级:

动作数量(单步 vs 多步)

认知负荷(是否需要推理、判断)

信息整合程度(是否需跨系统、跨时间)

界面动态性(是否存在弹窗、下拉菜单等)

异常处理能力

五、数据增强策略

为了提升模型在实际应用中的鲁棒性,GUIDE采用了多种数据增强方式:

模拟不同浏览器(Chrome、Firefox、Safari);

模拟不同操作系统(Windows、macOS、Linux);

模拟不同主题(暗色/亮色模式);

模拟界面元素的相对位置变化;

引入视觉干扰(如边框、裁剪、噪声)以防止模型“死记坐标”。

六、实验与模型验证

研究团队基于GUIDE训练了一个名为V-Zen的RPA模型,并进行了以下验证:

任务预测准确率:V-Zen达93.2%,接近GPT-4V的94%;

动作定位准确率:V-Zen达89.7%,远超GPT-4V(28%)和Gemini Pro(21%);

实验表明,思维链(CoT)、动作历史、数据增强和跨平台信息对模型性能提升均有显著贡献。

七、局限与未来方向

尽管GUIDE在RPA领域具有开创性意义,但仍存在以下局限:

当前覆盖的网站类型有限,尚未涵盖所有行业;

标注过程可能引入人为偏差;

静态数据难以应对网页频繁更新;

无法完全模拟真实用户的复杂交互(如快捷键、右键菜单);

异常处理案例不足;

数据扩展仍依赖人工参与,存在可扩展性瓶颈。

八、结论

GUIDE为RPA领域提供了一个高质量、跨平台、任务多样、结构丰富的训练资源,显著提升了AI系统在GUI环境中的理解和执行能力。它不仅推动了RPA从“规则驱动”向“认知驱动”的转型,也为未来智能自动化系统的研究奠定了坚实基础。随着社区对GUIDE的进一步使用与扩展,AI驱动的自动化将更接近人类在数字世界中的自然交互方式。

本书免费下载地址

关注微信公众号“人工智能产业链union”回复关键字“流程自动化06”获取下载地址。

![2025年中国转移胶带行业产业链、发展现状及未来前景分析:电子信息行业持续恢复,驱动行业市场规模增长至383亿元[图]](https://xtechcon-static.oss-cn-chengdu.aliyuncs.com/xtimes/xtimes/images/2025-08-23/68a913c97df1b.jpeg)