点击蓝字 关注我们

欢迎各位专家学者在公众号平台报道最新研究工作,荐稿请联系小编Robert(微信ID:BrainX007); 或将稿件发送至lgl010@vip.163.com。

近期,中山大学计算机学院王昌栋教授团队在IEEE Journal of Biomedical and Health Informatics (IEEE JBHI,Q1/1区)在线发表题为"Pre-Train, Prompt" Framework to Boost Graph Neural Networks Performance in EEG Analysis的研究成果。中山大学计算机学院CanMing-Cui为第一作者,王昌栋教授为通讯作者。

成果简介

脑电图(EEG)是神经科学研究和临床诊断中广泛使用的一种重要的无创脑成像技术。然而,EEG数据具有复杂的非欧氏结构,这使得训练有效的图神经网络(GNN)模型变得困难。

本文提出了一种用于EEG分析的图神经网络中的“Pre-Train, Prompt”框架,称为基于GNN的EEG提示学习(GEPL)。该框架首先使用无监督对比学习在大规模 EEG 数据集上进行预训练。然后,它通过图提示学习将模型学习的通用EEG知识转移到目标EEG数据集,从而在目标域数量有限的EEG数据中增强模型的性能。

本文在五个 EEG 数据集上测试了该框架,结果表明 GEPL 在 ROC 曲线下面积 (AUC) 方面优于传统的微调方法。GEPL 表现出先进的泛化性、鲁棒性和计算效率,从而显著减少了与有限的 EEG 数据相关的过拟合风险。此外,该模型提供了可解释的结果,突出了分类任务中的相关大脑区域。这项研究表明,“Pre-Train, Prompt”范式非常适合 EEG 分析,并给其他领域在有限数据情况下提供了潜在的解决方法。

主要贡献

本研究在GNN中引入了用于EEG分析的“Pre-Train, Prompt”框架,实现了高效的迁移学习,减轻了EEG数据稀缺对GNN的影响。它采用对比学习和图提示学习来实现跨EEG域的知识转移,提高GNN模型的性能和下游任务的调优效率。

在不同的EEG数据集上进行了对比实验和可视化研究,以证明该框架优于传统的微调方法。模型关键参数的可视化反映了框架的可解释性和临床意义。该框架的模型无关性使其广泛适用于其他领域,推动了医学研究的潜在进展。

本研究在中山大学孙逸仙纪念医院耳鼻喉科收集了425例慢性耳鸣患者、63例突发性听力损失患者和33例健康对照者的静息状态EEG数据。创建了两个数据集:一个用于耳鸣患者,另一个用于突发性听力损失和控制,可在https://zenodo.org/records/ 13219018上获得。这些数据集为研究耳鸣和听力损失的神经机制提供了宝贵的资源,为未来的分类和预测模型提供了支持。

方法

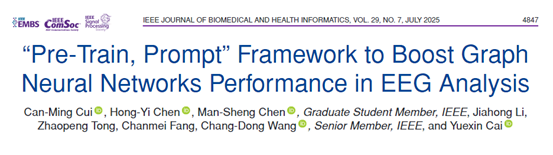

如图1所示,概述了用于EEG分析的图神经网络中的“Pre-Train, Prompt”框架。本研究将EEG表示为图结构数据,称为EEG图。图中的节点对应电极,边表示电极之间的功能连接。GNN是框架的支柱。为了使GNN能够从不同领域的EEG数据中学习通用知识,本研究采用无监督对比学习对GNN模型进行预训练。合并多个EEG数据集进行预训练,使GNN获得更稳定的初始化。然后,本框架使用图提示学习来提高模型在下游任务中的性能。在此阶段,预训练的GNN参数被冻结以保持其泛化能力。可学习图提示用于修改目标脑电数据集中脑电图的特征和结构,形成提示图。通过GNN对提示图进行编码后,我们得到了提示图的表示形式hG。最后,hG被送入线性分类器,用于下游任务。在预训练阶段,更新GNN模型的所有参数,而在提示调整阶段,只更新图提示和线性分类器的参数。总结上述过程,这种方法被称为GEPL。

图 1:工作流和GEPL概述。(a)利用固定长度的窗口对EEG信号进行重采样和裁剪,然后使用快速傅立叶变换创建一个图结构,其中电极作为节点,相关系数形成邻接矩阵。在预训练数据集中,受试者的脑电信号被尽可能广泛地分割,而在下游任务数据集中,每个受试者的脑电信号被分割成一个单独的片段。(b)在预训练阶段,使用对比学习生成增强图,提高对比损失优化模型泛化到EEG数据的能力。在此过程中,模型的所有参数都会更新。(c)在目标数据集中,图提示调优使用可学习的提示修改节点特征和图连接,以增强特定任务的性能。在此阶段,只更新可学习图提示符和线性分类层的参数,而预训练模型的参数保持不变。

数据库

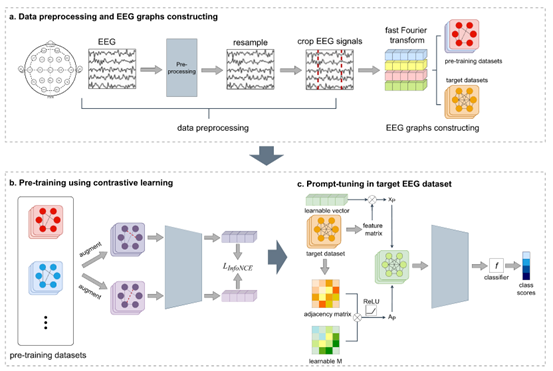

表1:数据集的统计

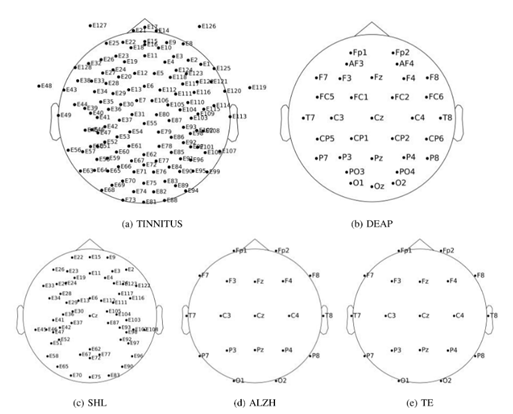

TINNITUS数据集是由中山大学孙逸仙纪念医院提供的专有数据集, 包括425名慢性耳鸣患者的脑电图记录。TINNITUS数据集包括来自127个EEG通道的信号,如图2(a)所示,乳突上放置了2个参考电极。

DEAP是用于情感分析的多模态生理信号数据集,由32名参与者的EEG和外周生理信号组成, 脑电数据包括32个脑电通道信号,如图2(b)所示.

SHL数据集同样来自中山大学孙逸仙纪念医院,包括96名参与者的脑电图记录,其中包括63名突发性听力损失患者和33名健康对照者。该数据集中的EEG记录包括来自57个EEG通道的信号,如图2(c)所示。

ALZH数据集由88名受试者闭的眼睛静息状态脑电图记录组成,包括36名阿尔茨海默病患者、23名额颞叶痴呆患者和29名健康对照组。电极的分布如图2(d)所示。

图2:数据集的电极分布。

结果

表2:三个数据集的性能比较

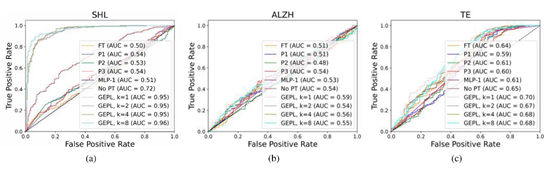

图3:三个数据集的受试者的ROC曲线。评估的方法包括Fine-Tune (FT)、PARTIAL-L(其中L的范围为1到3)、MLP-1、No Pre-training(No PT)和不同数量的提示向量的GEPL(k = 1到k = 8)。

表3:不同调优策略下参数个数的比较

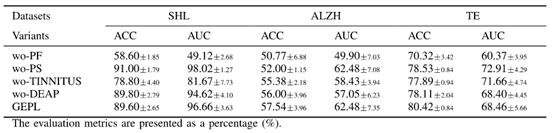

表4:三个目标数据集的消融研究结果

表5:本文的框架与其他主要编码器的性能比较

图4:三个目标数据集的所有参与者的显著性图。其中:(a) SHL;(b) ALZH和(c) TE。

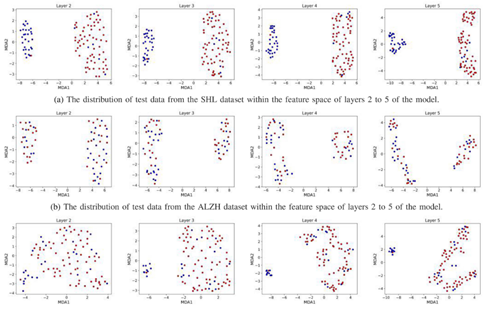

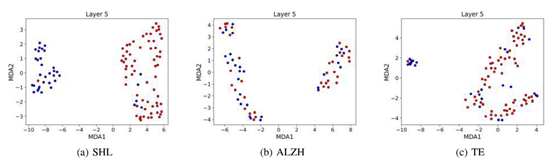

图5:特征空间中测试数据跨不同层的分布。蓝色数据点表示阴性样本(健康受试者),而红色数据点表示阳性样本(突发性听力损失、阿尔茨海默病或癫痫患者)。

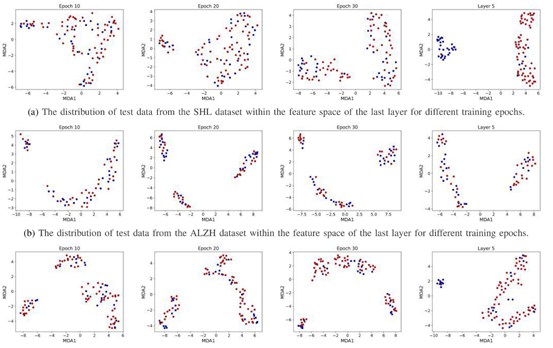

图6:不同训练轮次的测试数据在最后一层特征空间内的分布。蓝色数据点表示阴性样本(健康受试者),而红色数据点表示阳性样本(突发性听力损失、阿尔茨海默病或癫痫患者)。最右边的是训练模型的分布。

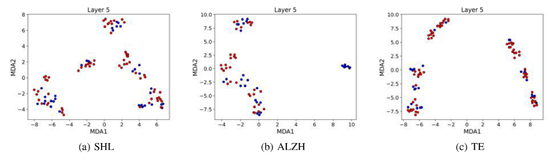

图7:带高斯噪声的测试数据在最后一层特征空间内的分布。蓝色数据点表示阴性样本(健康受试者),而红色数据点表示阳性样本(突发性听力损失、阿尔茨海默病或癫痫患者)。最右边的是训练模型的分布。

图8:最后一层特征空间内的没有图提示的特征分布。蓝色数据点表示阴性样本(健康受试者),而红色数据点表示阳性样本(突发性听力损失、阿尔茨海默病或癫痫患者)。最右边的是训练模型的分布。

研究结论

本研究提出了一种 “pre-train, prompt” 的图神经网络(GNNs)框架,称为GEPL。这是一种迁移学习方法,旨在提高EEG数据稀缺时GNN的性能。该框架使用对比学习进行无监督预训练,不依赖于标记数据,有效地利用来自其他领域的EEG数据来预训练模型。然后,GEPL利用图提示学习对目标EEG数据集进行高效微调,提高模型的性能。实验验证了该框架在多种EEG数据集上的有效性和较低的计算复杂度,并在突发性听力损失、阿尔茨海默病和癫痫的检测任务中表现良好。此外,GEPL在临床上也是可解释的。

免责声明:原创仅代表原创编译,水平有限,仅供学术交流,如有侵权,请联系删除,文献解读如有疏漏之处,我们深表歉意。

公众号丨智能传感与脑机接口