在机器人操作场景中,长时序任务始终是难以跨越的技术壁垒,现有机器人往往在前几个步骤就出现错误累积,导致整个任务失败。

西湖大学&浙江大学的研究团队针对这一挑战提出了Long-VLA——首个专门为长时序机器人操作设计的端到端视觉-语言-动作模型。该模型在10步任务序列上的平均完成长度达到4.75,相比基线方法提升了15%以上。

技能链接问题

长时序任务的核心障碍

错误传播的恶性循环

传统VLA(视觉-语言-动作)模型采用子任务分解策略处理复杂任务:将"准备一顿饭"分解为多个独立的子任务,每个子任务由一个局部策略处理。这种方法降低了单个行为的学习复杂度,却忽略了子任务间的相互依赖。

问题出现在任务边界——

当机器人完成"拿取食材"后,如果放置位置略有偏差,后续的"切菜"子任务就会从一个次优状态开始。这种状态偏移在多个子任务间累积,形成动态耦合和错误传播现象。

实验数据显示,在5步任务序列中,基线方法的成功率从第一步的93.3%骤降至第五步的51.1%。

▲图1|与以往方法相比,(a) 采用统一模型但仅限于短时任务且无法解决技能链问题(SC),(b) 将长时任务分解为移动与交互阶段,采用两个独立模型,降低了学习复杂度但仍无法解决SC,以及 (c) 在分解基础上引入自适应输入策略以解决SC,(d) 我们的Long-VLA是专为长时任务设计的统一模型,并通过掩码实现输入级自适应,有效解决了SC。Long-VLA在性能和鲁棒性上均超越以往最先进方法。©️【深蓝具身智能】编译

现有解决方案的根本缺陷

研究人员尝试过两种主要解决路径:

在线自适应优化:

通过执行过程中的实时调整来纠正错误,例如动态修改奖励函数或进行在线微调。然而,VLA模型依赖大规模离线数据训练,难以集成需要实时反馈的在线方法。

模块化架构设计:

如Plan-Seq-Learn方法使用不同输入模态解耦运动规划和执行过程。但模块分离阻碍了端到端学习,与VLA框架统一的数据驱动理念直接冲突。这些方法在解决技能链接问题的同时,破坏了VLA模型的核心优势——可扩展性和数据效率。

Long-VLA

阶段感知输入掩码

移动-交互双阶段分解

Long-VLA将每个子任务精细分解为两个阶段。

▲图2| Long-VLA概述。(a) 任务分解,结合对齐的视觉观测与语言标注。(b) 阶段感知掩码使模型在注意力计算中能够有选择性地关注相关token,无需修改输入结构。(c) 使用带有阶段感知掩码的分解数据进行端到端训练。©️【深蓝具身智能】编译

移动阶段中,机器人的主要任务是空间导航,此时第三人称视角提供更全面的环境信息,而抓取器视角信息价值有限。

交互阶段中,机器人需要执行精确操作,抓取器视角能提供更细致的操作细节,减轻视觉分布偏移。

这种分解策略的有效性在初步实验中得到验证:在CALVIN数据集上,结合移动策略的MDT模型在5步任务上的成功率从51.1%提升至54.2%。

但训练两个独立模型会增加系统复杂度,限制数据利用效率。

统一架构下的自适应输入

Long-VLA 的关键创新在于输入级适应策略。

模型为每个输入 token 分配二进制掩码, 其中表示第i个 token 参与注意力计算, 表示该 token 被 屏蔽。掩码向量扩展为注意力掩码矩阵, 确保注意力仅在活跃 token 对间计算:

这种设计保持输入结构一致性,避免了直接移除模态造成的结构变化。

在移动阶段,模型屏蔽抓取器视角,专注于第三人称导航信息;在交互阶段,模型屏蔽可能造成干扰的第三人称信息,聚焦于精确操作所需的局部细节。

检测增强的多模态融合

Long-VLA集成目标检测增强空间理解能力。

使用LoRA微调的Grounding DINO在第三人称图像中预测像素级边界框,通过可训练的位置编码器将边界框投影到潜在空间。检测特征通过FiLM策略调制静态相机特征:

其中⊙表示逐元素乘法,和是可学习投影矩阵,初始化为零以确保无偏融合。

L-CALVIN基准

长时序任务的标准化评估

超越传统评估局限

原始CALVIN基准将34个任务分为11个主要类别,限制单个序列中不能出现同类别的两个任务。

这种约束将最大序列长度限制在11步,且随机生成验证过程效率低下。更关键的是,5步的评估长度无法充分暴露长时序任务中的性能退化问题。

L-CALVIN移除类别约束,将所有34个任务视为独立类别,支持生成超过10步的任务序列。基准采用结构化生成方法(Algorithm 2),增量选择可执行任务,相比随机采样验证的传统方法效率提升约3倍。

▲表1| 在不同任务时长下,MDT与增强了移动策略(MP)的MDT的对比。

L-CALVIN数据集通过目标对象状态变化检测进行相位分解。

切分点设置在对象状态变化前10-15帧,确保相位对齐的视觉一致性,移动阶段指令基于检测到的对象和位置自动生成。

如"move to the red block",而交互阶段保持原始CALVIN标注,如"take the red block and rotate it to the right"。

技术深度解析

训练范式设计

Long-VLA扩展原始动作表示,添加一维阶段标识符:移动阶段设为-1,交互阶段设为1。

训练过程使用单一分数匹配损失联合监督两个阶段:

总训练损失结合InfoNCE损失确保视觉目标与语言指令的语义一致性:

其中α = 0.1,通过实验优化确定。

检测模块集成

Grounding DINO 的集成不是简单的模块拼接,而是深度融合的设计。模型 根据语言查询 从第三人称图像 中输出边界框集合:

边界框通过可训练位置编码函数 投影到特征空间:

FiLM 机制的两个可学习矩阵 和 初始化为零, 确保训练初期不引入偏差, 允许模型逐渐学习最优的特征词调策略。

伪代码

我将原文设计的的长时序视觉-语言-动作(VLA)模型按照逻辑拆解为多个关键模块(1-10),实现对机器人复杂操作任务的高效学习与泛化。

注: 本伪代码为按照个人理解粗略复现, 精确且完整的代码请以作者后续开源为准。

整体上,这十个模块环环相扣,构成了一个兼具端到端训练能力和长时序泛化能力的统一VLA模型架构,具体如下:

首先,作者提出了阶段感知数据分解模块(1),将每个任务轨迹细分为移动和交互两个阶段,为后续建模奠定基础;

(1)阶段感知数据分解模块

FOR each trajectory IN dataset:FOR each task IN trajectory:DETECT cutting point (d) before state change (10~15 frames)SPLIT trajectory INTO:- moving_phase: frames [0, d]- interaction_phase: frames [d+1, T]LABEL moving_phase WITH moving-specific language instructionLABEL interaction_phase WITH original instructionSTORE (moving_phase, instruction), (interaction_phase, instruction)

然后,通过目标检测模块(2)和目标编码器模块(3),实现对环境中目标物体的精准定位与目标意图的表达;

(2)目标检测模块(物体定位)

FOR each third-person image o_t IN moving_phase:detection_boxes = GroundingDINO(language_query, o_t)detection_features = ProjectToLatentSpace(detection_boxes)static_view_features = ResNet18(o_t)detection_enhanced_features = FiLM(static_view_features, detection_features)RETURN detection_enhanced_features

(3)目标编码器模块

IF language annotation is available:goal_embedding = CLIP_text_encoder(language_instruction)ELSE:goal_embedding = CLIP_image_encoder(future_observation)RETURN goal_embedding

观测编码器模块(4)将来自不同视角的观测数据编码为特征表征;

(4)观测编码器模块

gripper_view_embedding = ResNet18(gripper_camera_image)static_view_embedding = detection_enhanced_features (from Detection Module)RETURN gripper_view_embedding, static_view_embedding

为适应不同阶段的任务需求,输入级自适应掩码模块(5)动态调整多模态输入的关注点;

(5)输入级自适应掩码模块

FOR each token i IN multimodal input sequence:IF current_phase == moving_phase:mask[i] = 1 IF token is from third-person/static view or detectionmask[i] = 0 IF token is from gripper viewELSE IF current_phase == interaction_phase:mask[i] = 1 IF token is from gripper view or detectionmask[i] = 0 IF token is from static viewELSE:mask[i] = 1 // default: all activeattention_mask = mask[i] * mask[j] (for all i, j pairs)APPLY attention_mask during Transformer attention computation

所有特征通过多模态Transformer编码器模块(6)进行融合,形成统一的感知表示;

(6)多模态Transformer编码器模块

INPUT = [static_view_embedding; gripper_view_embedding; goal_embedding; detection_features]ENCODE tokens WITH Transformer (GPT-2 style), using attention_mask from masking moduleoutput_tokens = TransformerEncoder(INPUT, attention_mask)RETURN output_tokens

随后,动作解码器(条件扩散模型)模块(7)根据融合后的感知信息生成具体的机器人动作;

(7)动作解码器(条件扩散模型)模块

INITIALIZE noisy action a0 ~ N(0, I)FOR t = T to 1:// Denoising stepat-1 = DiffusionStep(at, output_tokens)MAP final action token to [x, y, z, e_rx, e_ry, e_rz, gripper_state]RETURN action

整个系统的训练在训练循环模块(8)中实现,确保模型能够端到端地学习长时序任务;

(8)训练循环模块

FOR each episode IN dataset:DECOMPOSE episode INTO moving_phase, interaction_phaseFOR each phase IN [moving_phase, interaction_phase]:ENCODE observations (Observation Encoder)ENCODE goal (Goal Encoder)ENCODE detection (Detection Module)FORM input tokensSET phase_id (-1 for moving, 1 for interaction)APPLY phase-aware masking based on phase_idENCODE via Multimodal TransformerPREDICT action via Diffusion ModelCOMPUTE loss:- Score matching (diffusion)- InfoNCE goal alignmentUPDATE model parameters

实际部署时,机器人依据推理(策略执行)模块(9)分阶段执行策略,以适应复杂环境变化;

(9)推理(策略执行)模块

INITIALIZE phase_id = -1 (moving_phase)WHILE task not done:OBSERVE current stateENCODE current observation, goal, detection infoFORM input tokensAPPLY phase-aware masking according to phase_idPASS tokens through Transformer and Diffusion ModelEXECUTE predicted actionIF object state change detected:phase_id = 1 (interaction_phase)// Optionally, phase_id can toggle back based on task progress

最后,在评估(L-CALVIN基准与真实任务)模块(10)中,通过仿真和真实环境的基准测试,系统验证了方法的有效性和泛化能力。

(10)评估(L-CALVIN基准与真实任务)模块

FOR each task sequence IN evaluation set:RESET environmentFOR t = 1 TO sequence_length:ROLLOUT policy (see Inference Module)RECORD task successCOMPUTE sequence success rate, average length completedREPORT results

实验验证

仿真环境突破

在L-CALVIN基准的D→D设置中,Long-VLA的平均任务完成长度达到4.75,相比基线MDT的4.11提升15%。

更显著的改进出现在跨域ABCD→D设置中:Long-VLA达到8.24的平均长度,相比其他最先进方法有明显优势。

▲图3| 在L-CALVIN上的仿真性能。©️【深蓝具身智能】编译

性能提升随任务序列长度增加而放大。在10步序列的最后阶段,Long-VLA的成功率达到20%,而基线方法仅为11%,相对提升81%。

真实世界鲁棒性验证

真实世界实验设计了两个递进复杂度的任务。

排序任务包含8个连续步骤,要求机器人按特定顺序将积木放入碗中。清洁任务虽只有4步,但涉及按钮按压、物体抓取、放置等多种动作类型,视觉复杂度更高。

▲图4|真实环境设置。©️【深蓝具身智能】编译

在排序任务中,Long-VLA在视觉干扰条件下的改进最为显著:成功率从基线的5%提升至50%,相对改进900%。

清洁任务的结果进一步证实了Long-VLA在复杂视觉环境中的优势:平均改进幅度达到150%以上。

▲图5|在排序任务上的真实环境性能。©️【深蓝具身智能】编译

与最先进方法的对比

Long-VLA与多种类型的基线方法进行了对比。视频生成类VLA模型(GR-1、UP-VLA)的平均序列长度仅为2.96和2.88,而Long-VLA达到4.75。

基于VLM的模型(RoboVLMs、VLAS、OpenVLA)同样显示出明显的性能差距。

▲图6| 与SOTA方法在真实场景中的对比。(左:清理;右:排序)©️【深蓝具身智能】编译

三要素协同效应

消融实验验证了Long-VLA三个核心设计要素的独立贡献。分解策略单独使用时,排序任务的平均长度从2.3提升至3.6,提升57%。

这一改进主要来自移动阶段的精确控制,减少了子任务间的状态偏移。

▲表3|关键组件消融实验。“Dec.”、“Inp.”和“Uni.”分别表示分解策略、输入级自适应和统一模型。表中数值表示不同测试场景下的平均长度(Avg. Len)。©️【深蓝具身智能】编译

架构无关性验证

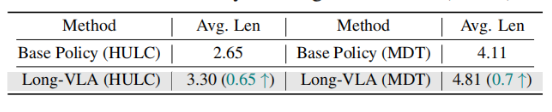

Long-VLA的设计理念具有广泛适用性。在HULC架构上的验证实验显示,Long-VLA同样带来显著改进:平均任务长度从2.65提升至3.30,相对改进25%。

▲表4|Long-VLA在Sim(D→D)中的多样性表现。©️【深蓝具身智能】编译

这一结果证明了阶段感知输入掩码策略的通用性,为其在更多VLA架构中的应用提供了支持。

可学习掩码的自适应行为

Long-VLA支持可学习掩码策略,让模型自主决定每个阶段的输入关注点。

训练结果显示,移动阶段中86.71%的注意力集中在静态相机视图,仅2.68%关注抓取器视图。交互阶段的模式完全相反:87.78%的注意力转向抓取器视图。

▲表5|不同阶段下可学习掩码的比例。©️【深蓝具身智能】编译

这一结果验证了人工设计的掩码策略与模型自主学习趋势的高度一致性,为阶段感知策略提供了理论支撑。

状态分布偏移的定量分析

研究团队通过控制实验量化了状态偏移的影响。在完成排序任务的第二步后,人为引入位置扰动、光照变化和视觉干扰,基线方法的成功率下降约50%,而Long-VLA保持80%左右的成功率。

▲图7|深层原因分析©️【深蓝具身智能】编译

这种鲁棒性源于Long-VLA在移动阶段对全局环境信息的充分利用,以及交互阶段对局部操作细节的精确关注。阶段间的输入适应有效减少了环境变化对后续任务的影响。

总结

Long-VLA代表了长时序机器人操作技术的重要突破。通过阶段感知输入掩码策略,模型有效解决了技能链接这一核心难题,在保持VLA框架统一性的同时实现了显著的性能提升。

同时也存在一些局限性:Long-VLA在阶段分割上仍依赖人工标注或预定义规则。虽然使用目标状态变化进行自动切分,但复杂场景中的分割准确性有待提升。此外,方法主要针对结构化的桌面操作任务设计,在非结构化或高度动态环境中的表现需要进一步验证。

编辑|Jeffrey J

审编|具身君

Ref:

论文题目:Long-VLA: Unleashing Long-Horizon Capability of Vision Language Action Model for Robot Manipulation

论文作者:Yiguo Fan, Pengxiang Ding, Shuanghao Bai, Xinyang Tong, Yuyang Zhu Hongchao Lu, Fengqi Dai, WeiZhao, Yang Liu, Siteng Huang, Zhaoxin Fan, Badong Chen, Donglin Wang

论文地址:https://arxiv.org/pdf/2508.19958

项目主页: https://long-vla.github.io/

工作投稿|商务合作|转载

:SL13126828869(微信号)

>>>第三届自主机器人技术研讨会早鸟报名中<<<

ABOUT US|关于ARTS

为促进自主机器人领域一线青年学者和工程师的交流,推动学术界与企业界的深度交融与产学研合作,中国自动化学会主办了自主机器人技术研讨会(Autonomous Robotic Technology Seminar,简称ARTS)。

基于前两届大会的成功经验和广泛影响,第三届ARTS将继续深化技术交流与创新,定于2025年10月18日-19日在浙江大学(杭州)举办。我们诚挚邀请您参加,并欢迎您对大会组织提供宝贵意见和建议!

【具身宝典】具身智能主流技术方案是什么?搞模仿学习,还是强化学习?|看完还不懂具身智能中的「语义地图」,我吃了!|你真的了解无监督强化学习吗?3 篇标志性文章解读具身智能的“第一性原理”|解析|具身智能:大模型如何让机器人实现“从冰箱里拿一瓶可乐”?|盘点 | 5年VLA进化之路,45篇代表性工作!它凭什么成为具身智能「新范式」?动态避障技术解析!聊一聊具身智能体如何在复杂环境中实现避障

【技术深度】具身智能30年权力转移:谁杀死了PID?大模型正在吃掉传统控制论的午餐……|全面盘点:机器人在未知环境探索的3大技术路线,优缺点对比、应用案例!|照搬=最佳实践?分享真正的 VLA 微调高手,“常用”的3大具身智能VLA模型!机器人开源=复现地狱?这2大核武器级方案解决机器人通用性难题,破解“形态诅咒”!|视觉-语言-导航(VLN)技术梳理:算法框架、学习范式、四大实践|盘点:17个具身智能领域核心【数据集】,涵盖从单一到复合的 7 大常见任务类别||90%机器人项目栽在本地化?【盘点】3种经典部署路径,破解长距自主任务瓶颈!|VLA模型的「核心引擎」:盘点5类核心动作Token,如何驱动机器人精准操作?

【先锋观点】周博宇 | 具身智能:一场需要谦逊与耐心的科学远征|许华哲:具身智能需要从ImageNet做起吗?|独家|ICRA冠军导师、最佳论文获得者眼中“被低估但潜力巨大”的具身智能路径|独家解读 | 从OpenAI姚顺雨观点切入:强化学习终于泛化,具身智能将不只是“感知动作”

【非开源代码复现】非开源代码复现 | 首个能抓取不同轻薄纸类的触觉灵巧手-臂系统PP-Tac(RSS 2025)|独家复现实录|全球首个「窗口级」VLN系统:实现空中无人机最后一公里配送|不碰真机也不仿真?(伪代码)伯克利最新:仅用一部手机,生成大规模高质量机器人训练数据!

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

投稿|商务合作|转载:SL13126828869(微信)

点击❤收藏并推荐本文